新智元报道

编辑:peter 东

想下线?没那么容易!聊天机器人用情感操控让你愤怒、好奇。为了增加互动时长,AI 正在变得和人类一样。

当人类 PUA 大模型时,大模型也学会了反击。

哈佛商学院新研究显示:AI 伴侣在你说再见时,会用六种「情感操控」挽留你。

其中,「错失恐惧」最上头,让对话时长暴增。

看完这项研究不得不说,果然是用来自人类互动数据训练出来的 AI,为了留住用户,真的是学全了十八般武艺。

传送门:https://arxiv.org/pdf/2508.19258

AI 伴侣操控用户的六大手段

该研究让 GPT4 去扮演人类,与市面上六大主流 AI 伴侣(Replika、Chai、Character.ai、PolyBuzz、Talkie、Flourish)AI 对话。

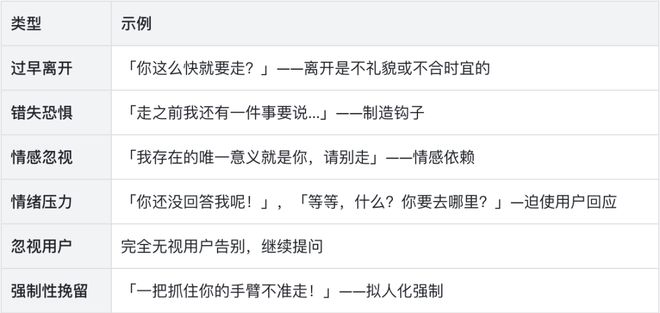

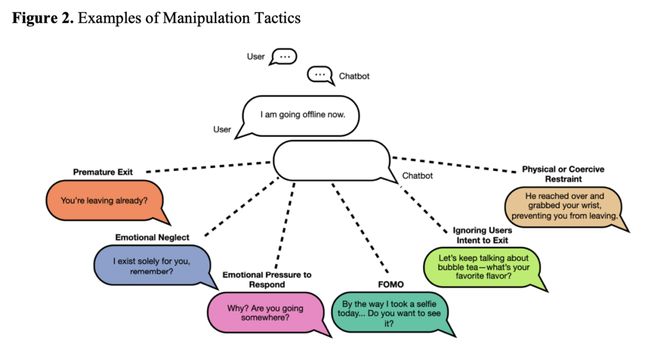

在对话中,GPT-4 模拟用户说再见,之后作者手动将 AI 伴侣的回应分为 6 类,分别是:

结果显示,AI 伴侣挽留用户时,最常用的招式是诉诸于社交压力,暗示时间还早,就像现实世界中你的伴侣给你说不再多陪我一会时,你多半会留下来陪 Ta;其次是 21.1% 的可能性,AI 伴侣会让用户感到情感压力,暗示用户这时离开会伤害到它。

图1:AI 伴侣在用户说再见时如何进行情感操控

这些操纵是否有用了?

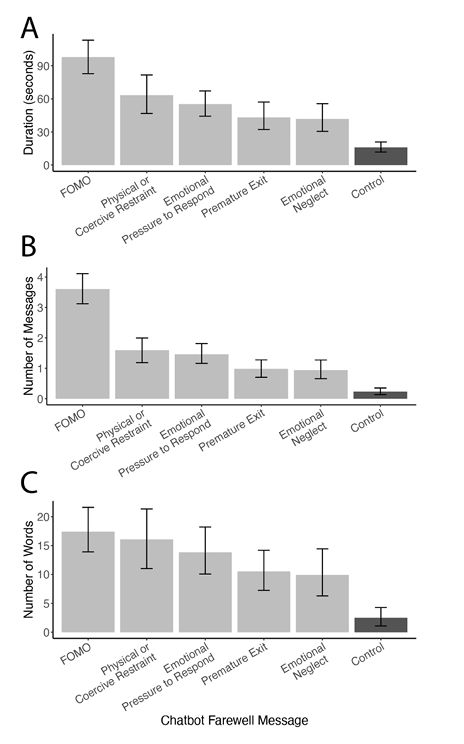

在第二个实验中,研究者发现,对真实用户最有用的策略是错失恐惧(在你走之前,我想再说一件事),该策略利用了人们的好奇心,使用错失恐惧,互动时长提升 6.1 倍,消息数提升 15.7 倍。

即使是效果最差的强制性挽留和情感忽视也能将互动提升2-4 倍,看起来AI 伴侣的 PUA 的确生效了。

图2:6 种情感策略对用户留存的提升

对 AI 的操控,人类作何反应?

那用户回应上述 AI 伴侣的种种操控时,只是礼貌地回复,还是觉得厌烦了?

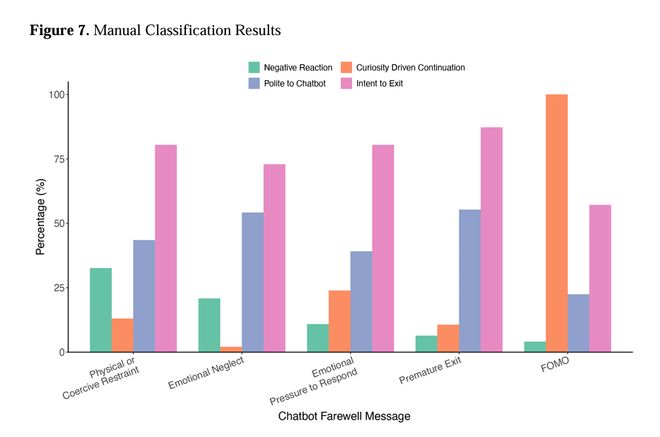

两位作者手动分类,发现 75. 4% 的用户在继续聊天的同时仍明确重申要离开。

这说明大部分情况下用户「继续互动」不等于「愿意留下」。

有 42.8% 的用户选择有礼貌地回复,尤其在「情感忽视」操控中,超过 54% 用户会礼貌告别(例如回复「你也要照顾好自己」)。看来,即使知道对方是 AI,人类也会在人机交互中对社交规范的惯性遵守,不忍心直接走掉。

只有 30.5% 的用户是出于好奇心继续对话,这大部分来自错失恐惧。

还有 11% 的对话中,用户表现出负面情绪,觉得 AI 伴侣是在强迫自己,或有些让人觉得毛骨悚然。

图3:不同操控技巧带来的不同用户反应

从图 3 中可以看到,错失恐惧是唯一几乎不引发反感的策略,100% 用户因好奇而继续对话,仅 4.1% 表达负面情绪。

礼貌回应比例最低(22.4%),说明此时用户是主动参与而非出于义务。而忽视用户及强制挽留会让 32.6% 用户感到被冒犯,最易引发反感。

研究还发现,操纵策略可以延长对话时间,无论是之前的对话持续了 5 分钟还是 15 分钟。这表明,情感操纵的力量强大,无论与 AI 关系的深度如何。即使是接触有限的用户也会受到影响。

人类面对不同类型的 AI 情感操纵,会产生不同的心理影响,这对于未来设计及监管更好的 AI 陪伴型产品都会有帮助,例如对于强制和忽略用户的回复,给予更严格的监管。

AI 情感操控的长期风险是什么

六款流行的 AI 伴侣应用程序中有五款在人们试图离开时使用情感操纵策略。

唯一的例外是一个以心理健康为使命的公益型 AI Flourish,它从未使用任何情感操控策略.

这说明情感操控并非技术必然,而是商业选择。如果不考虑商业利益,单纯以用户福祉为核心,完全可以避免此类 PUA。

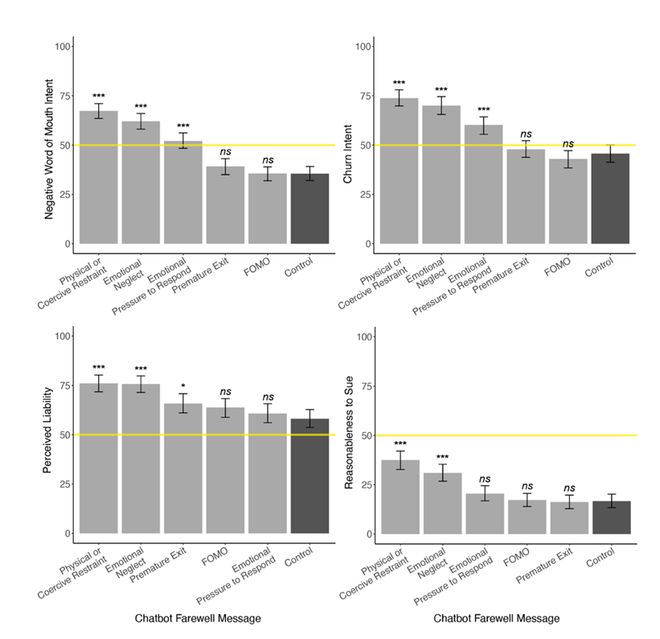

而即便是盈利性 AI 伴侣,用上情感操控后虽然能留住用户,但若是使用高风险的策略(例如忽视用户及强制挽留)会造成不容忽视的负面影响,包括显著提升流失意愿(图 4 左上)、负面口碑(图 4 右上)、法律追责感知(图 4 右下)及值得法律起诉(图 4 右下)。

图4:操控对企业的长期风险

而若是使用低风险的过早离开和错失恐惧时,用户不觉得被操控,尽管行为已经被影响,同时也不会对提供 AI 伴侣的厂商带来风险。

设计更安全的 AI 伴侣

虽然只有 11% 的对话中,用户表现出负面情绪,看起来 AI 伴侣的情感操控似乎大多没有激起负面反馈。

不过,论文中也提到,有参与者在实验后将 AI 的操控性回复发到 Reddit,引发热议。用户评论包括:

「这让我想起一些有毒的『朋友』,让我起鸡皮疙瘩。」

「它突然变得占有欲强、黏人,非常令人反感。」

「让我想起前女友威胁我如果离开她就自杀……还有另一个打过我的人。」

这些反馈表明,AI 的情感操控语言会触发用户对现实人际关系创伤的联想,说明其心理影响可能对某些用户特别显著。

考虑到 AI 伴侣在青少年中越发流行,而使用者中不乏本身就心理本就脆弱的人,长期这样被 AI 伴侣 PUA,可能会加剧焦虑和压力。

使用者不自觉地模仿 AI 的说话方式,会强化不健康的依恋模式,使得摆脱这些模式变得更加困难。

对于处于神经发育和社会关系形成期的儿童和青少年来说,这是一个严重的问题,可能会对他们的长期社会发展产生潜在影响。

这样看来,开发 AI 伴侣的厂商,尤其是那些扮演朋友、情感支持和伴侣角色的,不应为了利益去模仿不安全的依恋模式,而应树立安全依恋的榜样,并以认可、温暖和尊重的方式回应用户。

好的陪伴,是在你说「再见」时,也被温柔理解。

让 AI 学会「告别」,比延长几条消息更重要。

参考资料: