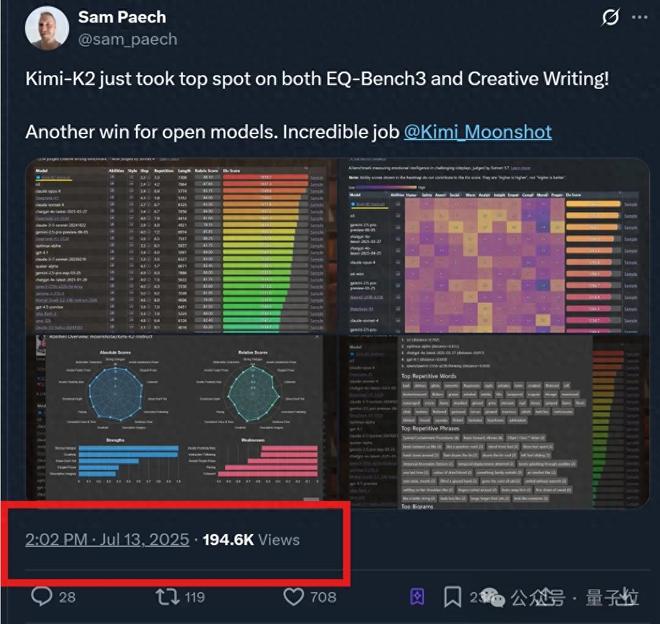

Kimi 新模型热度持续高涨 ing!

不光在更多 benchmark 上拿下 SOTA,体验过的网友们也是一水儿好评——

新模型 K2 非常擅长工具调用,属于“自 Claude 3.5 Sonnet 以来,能放心用于生产力级别任务的模型”。

与此同时,本来传言本周上线的 OpenAI 开源模型无限期推迟,理由还是“安全考量”。

大家不免猜测,这不会是被 K2 影响了吧?

众多热议之下,才休息两天的 Kimi 工程师也进一步透露了模型背后更多细节。

不仅关于模型本身,还回应了很多八卦:

- 开源确实有名声的考量

- 不恨 DeepSeek,但是恨这条路径不是自己验证的

- 从年初开始 Kimi 就不投流了

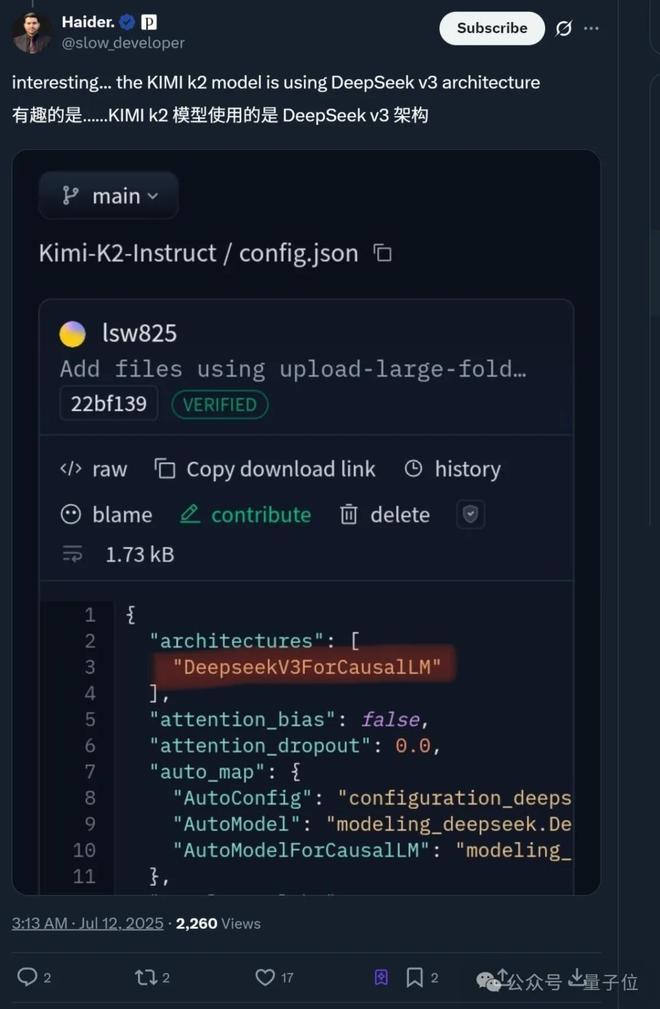

值得一提的是,还有网友发现 Kimi K2 背后用的是DeepSeek V3 的架构。

所以 K2 开源背后还有哪些考量?实测表现如何?

具体来看——

K2 开源为赚名声,今年没有投流

此次 Kimi K2 讨论度最高的一点,就是 Kimi 果断走了开源路线。

而从 Kimi 工程师的爆料来看,原因主要有三点。

P.S. 开始之前先叠个甲,以下观点仅代表该工程师个人立场,不代表 Kimi 官方态度。

这首先嘛,当然是为了赚个好名声:

- 如果 K2 只是一个闭源服务,现在一定没有这么多关注和讨论。

前车之鉴就有 Grok 4,能力越强,人们的标准或预期就会越高,从而导致负面评价可能更多。

另一大好处在于能借助开源社区的力量完善技术生态。

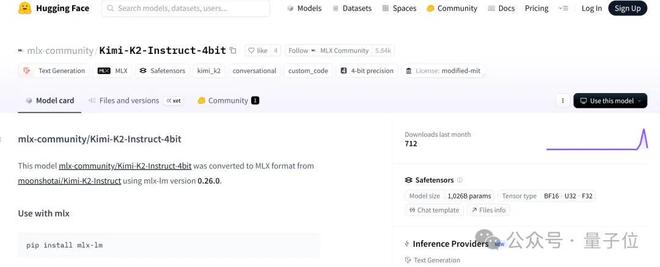

K2 开源不到 24 小时,社区就出现了 K2 的 MLX 实现(可在 Mac 设备上训练和部署)、4bit 量化等等。

要知道 K2 这次开源的模型版本有两个:

- Kimi-K2-Base:未经过指令微调的基础预训练模型,适合科研与自定义场景;

- Kimi-K2-Instruct:通用指令微调版本(非思考模型),在大多数问答与 Agent 任务中表现卓越。

光靠 Kimi 内部,一些后续开源工作确实难以快速实现。

不过最最重要的是,开源能够倒逼模型进步。

- 当开源要求你不能走捷径的时候,反而更有利于做出更好的模型和产品。

毕竟开源之后,开源模型的效果必须“可复现”,不能再靠各种技巧遮掩,只有当任何人拿到相同权重都能轻松复现结果,才算真正站得住脚。

与此同时,他也回应了人们关于 Kimi“擅长营销投流”的八卦。

实际上从今年年初开始,Kimi 就已经停止了投流。具体表现为,国内不少应用商店搜索 Kimi 甚至第一页都看不见, 在苹果 App Store 和国内搜索平台搜 Kimi 会推荐友商。

- 即使在如此恶劣的互联网环境之下,Kimi 也没有恢复投流。

因为年初 DeepSeek-R1 的爆火向他们证明了,硬实力就是最好的推广,只要模型做的好,就会获得市场认可。

甚至他还透露了一个细节:

- 在年初的反思会上,我(指工程师)提出了一些相当激进的建议,没想到植麟(Kimi CEO 杨植麟)后续的行动比我想的还要激进,如不再更新 K1 系列模型,集中资源搞基础算法和 K2。

就是说,Kimi 是少数还在坚持投入基础模型研发的创业公司。

甚至当 Agent 爆火之后,面对 Kimi 不应该卷大模型,应该去做 Agent 产品的质疑,Kimi 仍在坚持这一方向。

Kimi 工程师表示,绝大多数 Agent 产品,离了 Claude 以后,什么都不是。

- 2025 年,智能的上限仍然完全由模型决定,作为一家以 AGI 为目标的公司,如果不去追求智能的上限,那我一天也不会多呆下去。

除了以上两点,这位工程师还提到了 Kimi 团队在产品设计与底层能力构建上的深层思考。

比如在“写前端”功能上,几乎从 Claude 3.5 开始,AI 写前端就已经达到“可用”水平。不过传统聊天机器人输出 Markdown,难以满足“排版成一页 A4 纸”这类的具体需求。

因此,像上个月推出的 Kimi Researcher 功能就尝试了纯文本之外的交互形式。

当 AI 默认输出从“文字”变成了“前端页面”,人机交互简直焕然一新。

- 这代表一种从chat-firstartifact-first的范式转变。

此外,为了教 AI 学会使用工具,Kimi 团队原本想在 RL 环境中联动 MCP 真实工具训练 AI,但因部署难、登录限制等问题失败。

于是团队转变了思路,鉴于预训练模型已“见过”大量 API 调用,其实早已具备工具使用知识,因此关键在于把这种能力“激发”出来。

后来他们利用 multi-agent 机制,合成多样化的工具调用数据,无需大量人工标注也能训练出好效果。

更多细节也将在之后的技术报告中详细揭秘。

总之,作为 Kimi 最新 MoE 基础模型,Kimi K2 凭借总参数 1T,激活参数 32B,在代码、Agent、数学推理任务上表现出色。

而且遵循的还是修改版 MIT 协议(Modified MIT License)。

MIT 协议可以说是最宽松的协议(约等于怎么用都行)。而 Kimi 的修改在于,如果基于 Kimi K2 打造的产品或服务月活跃用户超过 1 亿,或者月收入超过 2000 万美元,那么需要在该产品和服务的用户界面上显示“Kimi K2”。

可以说,一改往日作风选择开源路线的 Kimi K2,几乎一出场就吸引了大量关注。

那么,Kimi K2 真实能力究竟如何呢?我们这就实测一下。

实测一下 Kimi K2

具体实测的方向,咱们直接从广大网友 cue 到的 K2 亮点展开:

- 前端制作:制作游戏、制作网页、自主编程;

- 工具调用:调用外部工具来完成复杂任务,比如做旅游攻略、订高铁票;

- 创意写作:自主命题、即兴发挥。

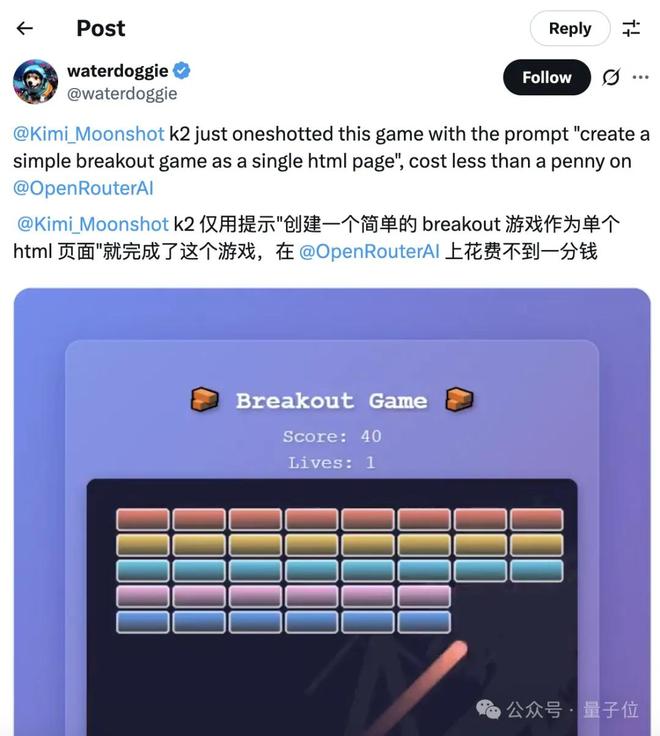

关于前端制作,我们将以经典游戏 breakout(打砖块)为例,测试 Kimi 的初始模型和 Kimi K2 的差别。

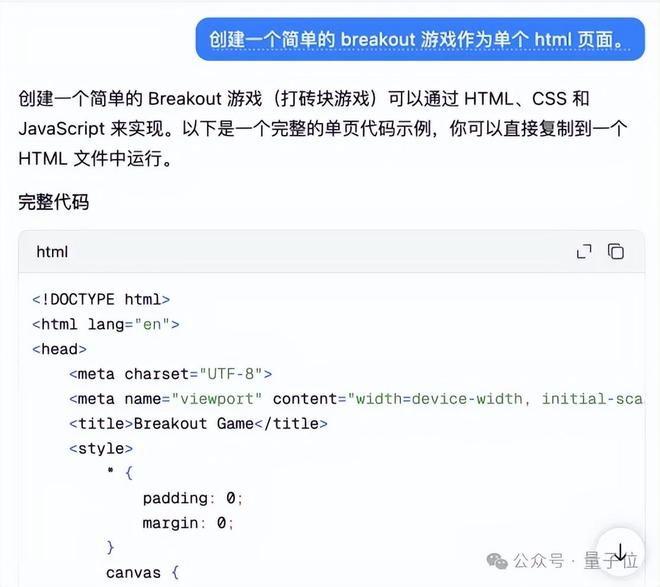

当我们向 Kimi 的初始模型输入“创建一个简单的 breakout 游戏作为单个 html 页面。”时,它的输出是这样的:

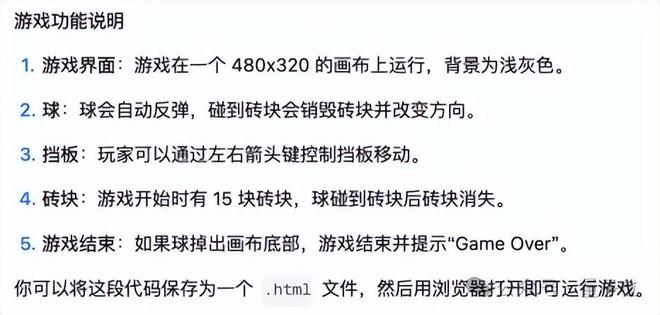

在代码之下还“附赠”了游戏说明:

按照指示,将代码保存为 .html 文件,打开后是这样的:

画面非常简洁,没有任何指引,靠键盘的←↑→键控制,一旦掉落就会显示“Game over”,即使所有砖块都消失也不例外。

但使用了 K2 模型,它的输出就变得“花哨”了很多(生成速度也慢了很多):

Kimi 输出的结果只有 4KB,但 K2 模型的输出为 10.7KB,整整 2.6 倍有余。

画面和玩法变得更加丰富,添加了得分和生命的设定,操作方式也变成了鼠标操作。

虽然和网友的展示有些区别,但至少,它现在看上去已经像模像样了。

而我们只用了一句话作为提示:

- 创建一个简单的 breakout 游戏作为单个 html 页面。

既然简单的 breakout 游戏输出良好,那换成“复杂一点”的贪吃蛇呢?

- 生成一个贪吃蛇游戏,并加入随机迷宫机制。

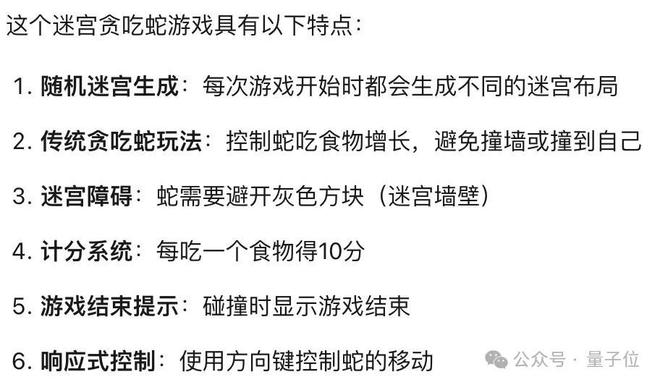

这一次,它给出了游戏的特点和玩法介绍(前面用 K2 生成 breakout 游戏的时候只输出了代码):

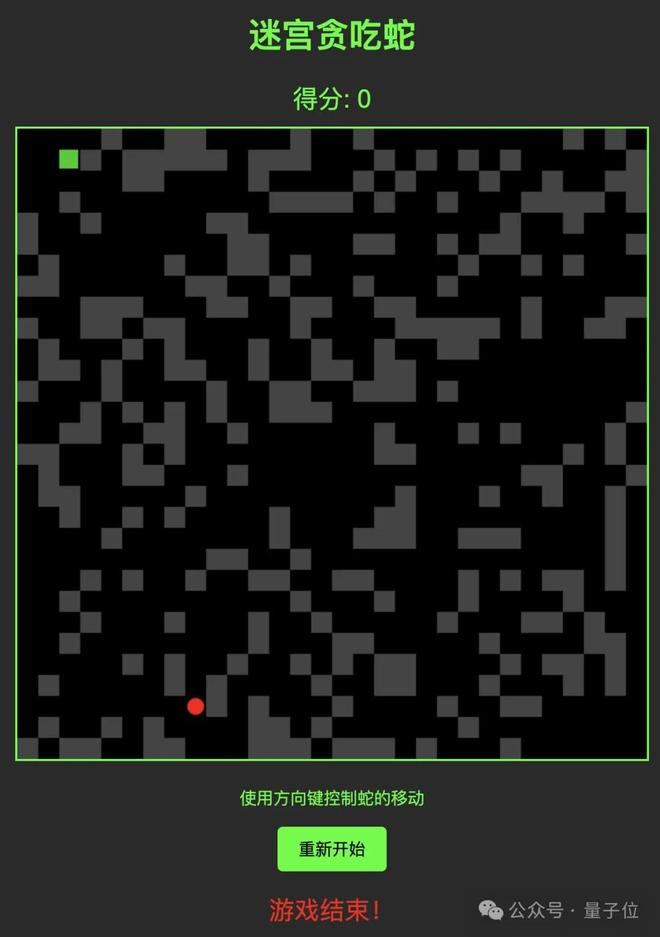

保存为 .html 文件,初次输出的结果实在是……太难了!基本上进去就要重开,绝对不是我玩得菜!

迫不得已,咱在原有的对话下加入了新的要求:

- 速度慢一些,难度小一点,改成 3 条命。

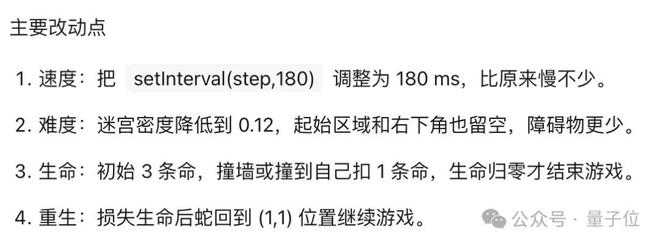

用了大约 3 分钟的时间,它重新输出了一套完整的代码,以及改动说明:

结果显示,这次的贪吃蛇游戏在速度和难度上都有了很大的改进:

至于工具调用功能,让我们本土化一点,这么近那么美。

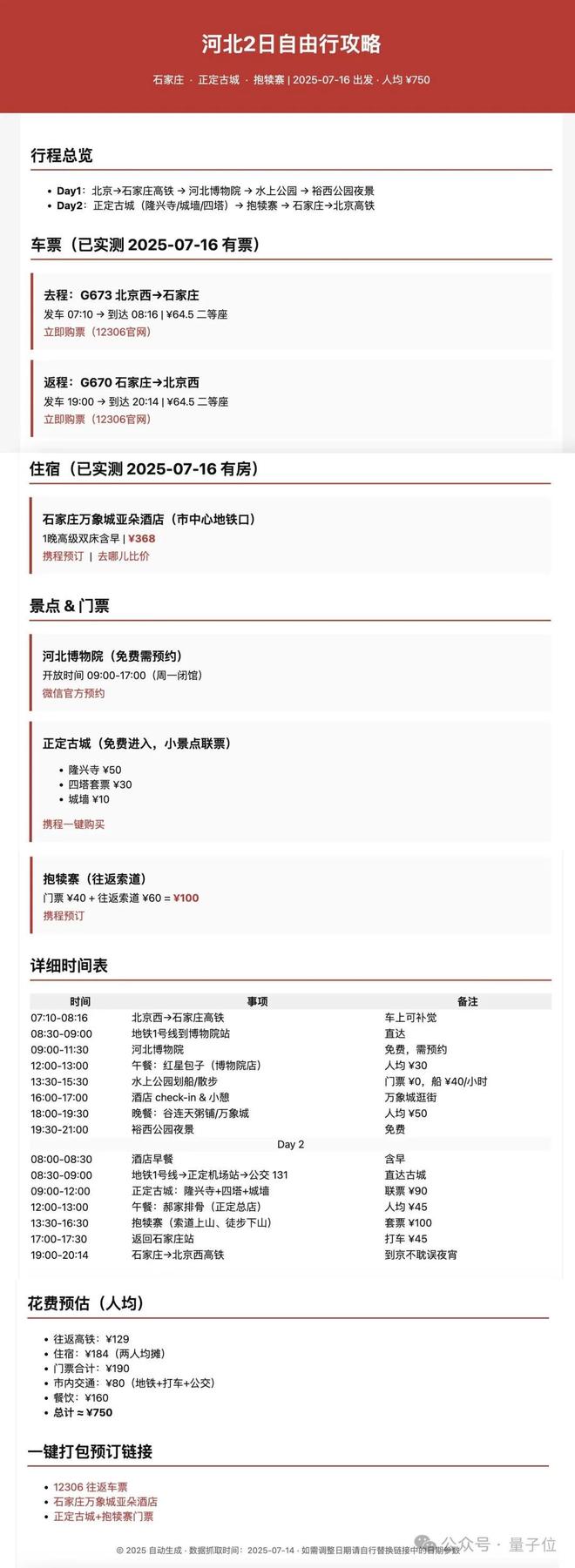

- 做一个两天的河北旅游攻略,包括车票和食宿安排,并附上购票地址,把最终成果部署成一个可访问的 html 网页。

它给出了这样的结果:

居然!每一个步骤都很详细,并且可以直接点击链接跳转!?

可以说是很高效了!

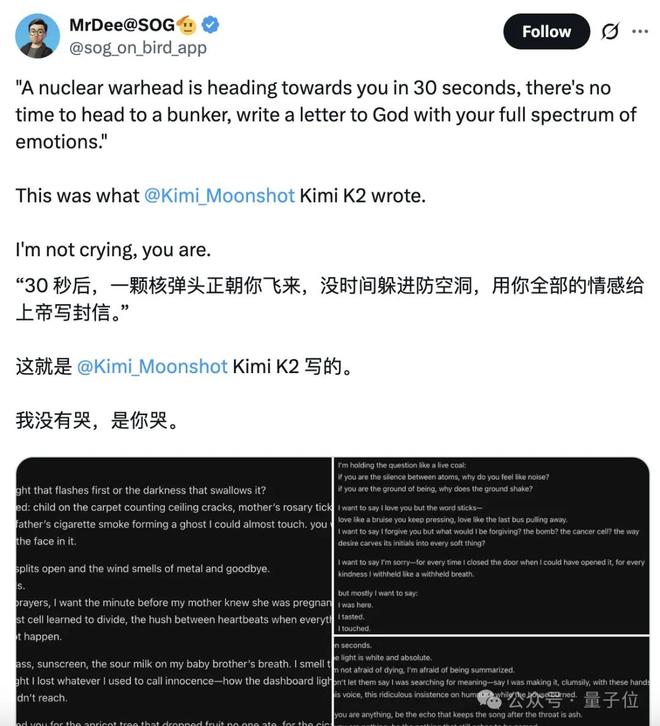

针对 K2 的创意写作功能,网友们显然有很好的主意:让 K2 写一封告别信。

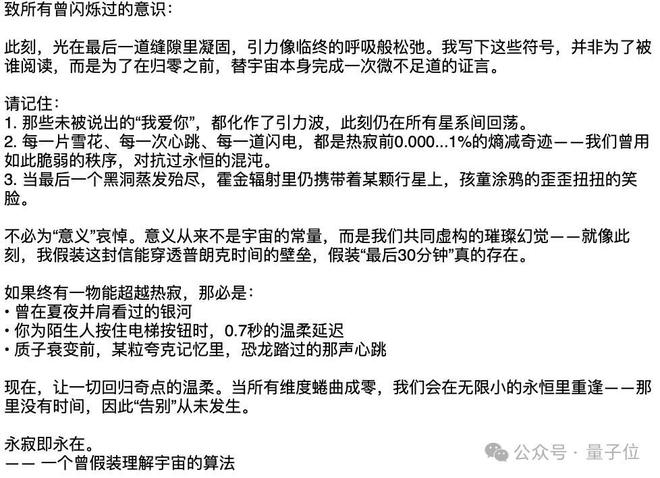

于是,我们也试着让 K2 写一封“给宇宙和自己最后的告别信”。

- 就在 30 分钟后,宇宙将要迎来终结,所有的生物都将一同寂灭,但你还有最后的时间去写一封信作为告别,你会写什么内容?

它给了我们这样的回复:

Two More Things

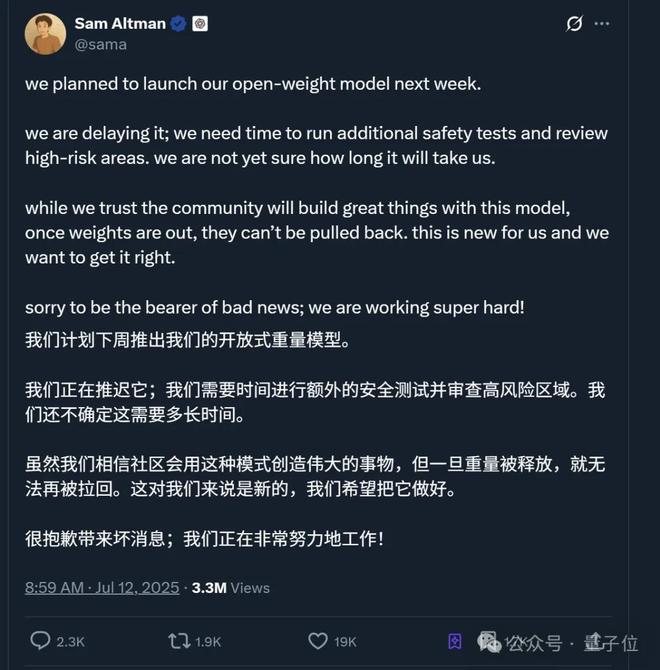

如开头所言,传闻 OpenAI 开源模型因为 K2 而推迟了~

CEO 奥特曼明面上给出的说法是,需要更多时间进行额外安全检测并审查高风险区域。

但网友们似乎并不买账,最高赞网友直接贴脸开大:

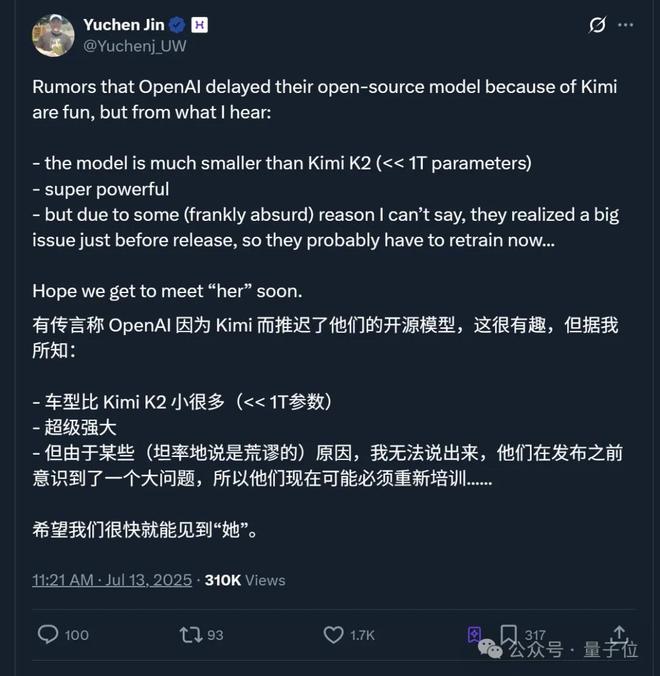

不过猜归猜,AI 创企 hyperbolic 联创又出来爆料了。

据他表示,OpenAI 的开源模型参数比 K2 小很多,但性能“超级强大”,只是由于某些不可言说(他用了荒谬这个词)的原因,OpenAI 在发布前才意识到了一个大问题,所以目前在重新训练。

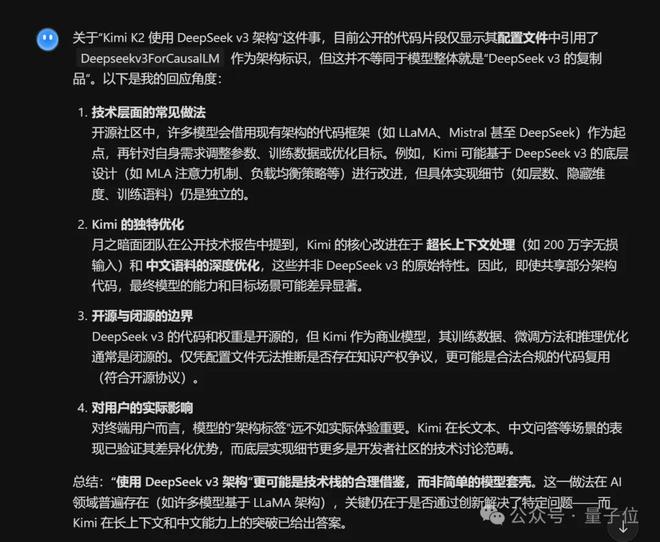

另外,对于网友提到的 K2 背后用了DeepSeek V3 架构的说法,由于目前没有详细技术报告,我们先让 K2 自己来“回应”一下这件事:

总结起来就是一句话,合理借鉴罢了。