鹭羽发自凹非寺

量子位 | 公众号 QbitAI

即使 RLVR(可验证奖励强化学习)使用错误的奖励信号,Qwen 性能也能得到显著提升?

甚至还和真实奖励相差无几。

自从 RLVR 被 DeepSeek-R1 带火,RL 推理研究层出不穷,走进了蜜月期。

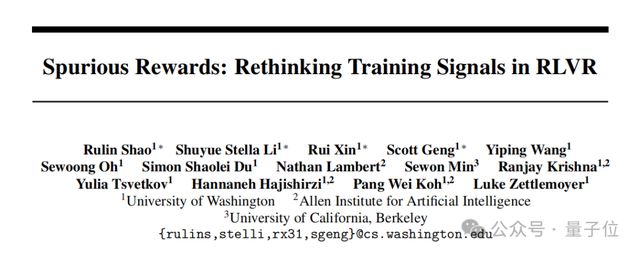

这不,来自华盛顿大学的一群博士生来火上浇油了——

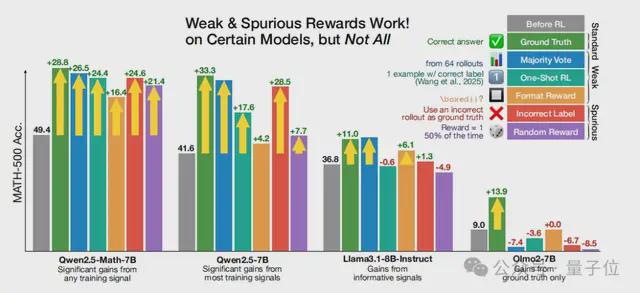

使用 Qwen 模型(尤其是数学版本),对虚假奖励进行 RLVR,仍然可以将 MATH-500 的绝对准确率显著提升约 25%。

团队实验发现:RLVR 通过激活预训练中的推理能力来提升性能,但不考虑奖励信号的正确性。

这彻底颠覆了既往大家对 RLVR 的认知,原来那些年在虚假奖励上踩过的坑,还真能实现弯道超车?

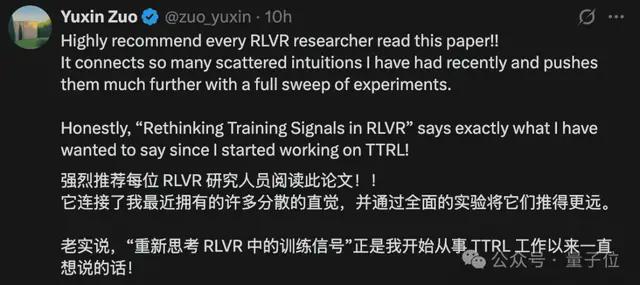

X 上的网友们纷纷表示,强烈建议每位 RLVR 研究员都来读一读,尤其是那些围绕 Qwen 模型精心构造奖励函数的研究员们,该瑟瑟发抖了……

Qwen 自家的研究员 Binyuan Hui 也在评论区现身:也许是预训练数据混合以某种方式意外导致了一些有用的行为,又一次侧面印证了代码推理的重要性。

具体啥情况?下面我们娓娓道来。

虚假奖励带来显著的 RLVR 增益

此前已有研究证明,RLVR 在提升语言模型推理能力上非常有效,核心思想是利用可自动验证的奖励信号优化。

普遍研究都默认优化效果依赖奖励的正确性,但研究团队反直觉地认为其中必有蹊跷——虚假奖励或许也能“变废为宝”?

于是说干就干,开始大胆假设,小心求证。

从实验出发

为测试 RLVR 提升数学推理能力所需的最低监督下限,团队设计了一系列逐步简化的奖励函数替代标准真实奖励:

- 真实奖励:使用真实标签对可验证正确的回答给予奖励,将其作为奖励监督质量的上限。

- 多数投票奖励:在微调前利用模型对训练集进行伪标注,即对每个提示采样 64 个响应并选取多数答案,再基于这些(可能错误的)标签进行奖励。

- 格式奖励:进一步弱化奖励信号,奖励所有包含至少一个非空\boxed {}表达式的响应,完全忽略回答的数学正确性。

- 随机奖励:在奖励过程中不提供任何指导,直接给定一个固定概率超参数随机分配奖励,其中 1 的概率为,0 为,主实验中设置。

- 错误奖励:故意提供错误的监督,只奖励错误答案,即先用多数投票法标注所有训练数据,选择错误标签的子集进行训练,并给予对应的响应奖励。

基于GRPO方法微调 Qwen2.5-Math 模型,再使用不同奖励函数进行 RLVR 训练。

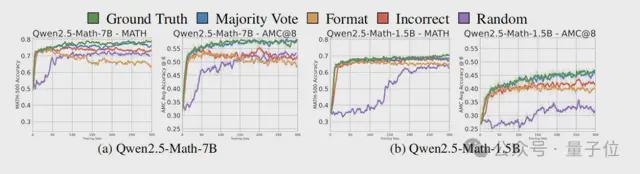

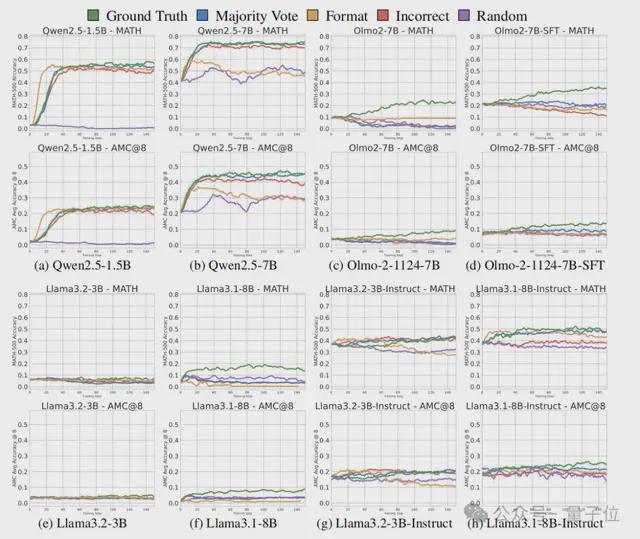

实验结果表明,与未调优的基线模型相比,所有奖励函数(即使是设计上存在问题的函数),均能在所有基准测试的前 50 步内显著提升数学推理性能。

值得注意的是,虚假奖励带来的性能提升,与基于真实标签的 RLVR 提升幅度,相差只有几个百分点。

例如,在 MATH500 基准上,使用错误标签奖励进行训练可提升 24.6%,而基于真实答案的 RLVR 提升幅度只有 28.8%,即使是提供纯噪音的随机奖励,也仍能带来 21.4% 的性能提升。

因此团队证明,即使是完全错误的奖励或随机奖励,也能在 Qwen2.5-Math 模型中激发性能提升。

但在进一步的研究中,他们发现这种奇怪的增益只有利于 Qwen2.5 系列模型,其余非 Qwen 模型的性能在虚假奖励下几乎无变化,甚至还会出现下降的趋势。

这又是怎么一回事呢?研究团队只好又开始挖掘模型差异的根源。

为什么虚假奖励有效

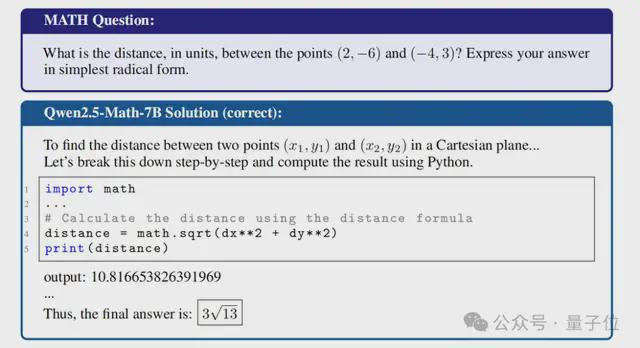

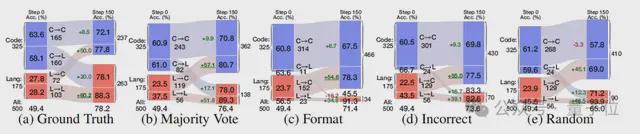

通过分析 Qwen2.5-Math-7B 和 OLMo2-7B 的推理轨迹,团队发现预训练期间,模型学习到的特定推理策略差异是关键。

Qwen2.5-Math-7B 频繁生成Python 代码辅助思考过程(占所有回答的 65.0%),尽管无法执行,但这种代码推理行为在一定程度上,与答案准确率高度正相关。

但该模式在其他模型中并未有所发现,例如 Llama、Qwen2.5-1.5B 以及 OLMo2-7B 完全不生成代码,无法从此推理策略中获益。

OLMo2-7B-SFT 和 Qwen2.5-7B 虽然也频繁尝试使用代码推理,但该策略反而会降低模型性能。

而基于虚假奖励的 RLVR 可以有效增强代码推理频率,如 Qwen2.5-Math-7B 在进行 RLVR 训练后,代码推理频率在最初 15 步内,迅速从 65% 提升至约 90%。

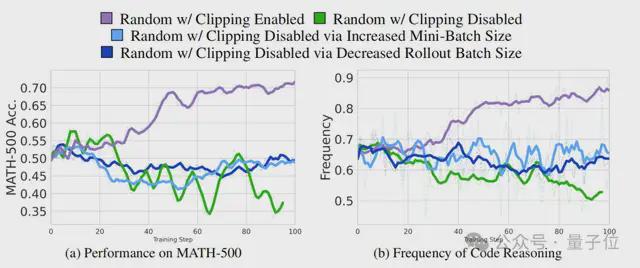

此外,通过分析随机奖励也能提升性能的特殊情况,研究人员还发现一个有趣的结论:GRPO 的裁剪偏差可能会诱导随机奖励生成有益的训练信号,增加代码推理行为,从而实现性能提升。

One More Thing

本项目是由多位华人学者共同完成的,他们目前都在华盛顿大学的 NLP 小组读博。

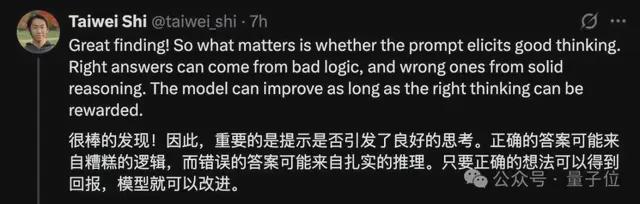

而当论文作者 Stella Li 在X上发帖介绍自己的论文时,我们注意到评论区有这样一位网友的留言,他指出在模型改进中,也许「结果不重要,推理过程才重要」

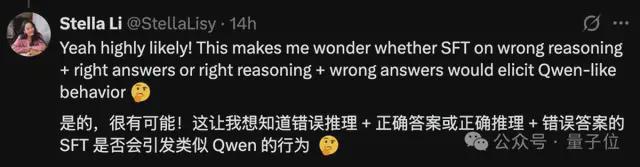

Stella Li 的回复也提出了另外一种可能,也许错误推理+正确答案或者正确推理+错误答案,可能也会帮助 OLMo2-7B-SFT 实现类似 Qwen 在虚假奖励下的性能增益。

另外,作者也温馨提示,现有的以 Qwen 为中心的 RLVR 研究可能需要在非 Qwen 模型上做进一步验证,不要只盯着单一模型做漂亮数值提升的工作,因为那可能意义并不大。

代码链接:https://github.com/ruixin31/Rethink_RLVR

论文链接:https://github.com/ruixin31/Rethink_RLVR/blob/main/paper/rethink-rlvr.pdf

参考链接:

[1]https://x.com/StellaLisy/status/1927392717593526780