新智元报道

编辑:桃子

人类离 AGI 究竟还有多远?最新一期 Nature 文章,从以往研究分析、多位大佬言论深入探讨了 LLM 在智能化道路上突破与局限。

AI 究竟距离人类级水平的智能还有多远?

Nature 最新一篇长文,从人类一直在思考的 AGI 问题入手,探究了 o1 掀起的新范式。

不过,这条新路终究无法到达 AGI 那天。

Bengio 预言:o1 无法抵达 AGI

3 个月前,OpenAI 重磅推出推理模型 o1,代表着 AGI 路线二级能力的实现。

相较于之前的大模型,凭借着强化学习 +CoT,o1 得以以人类的思维方式去解决问题。

也正是 o1 的诞生,为持续数十年来的一场辩论注入了新的燃料:究竟要到什么时候,机器才能胜任人类大脑所能处理的所有认知任务?

这其中包括从一项任务到另一项任务的泛化、抽象推理、规划以及选择对世界的哪些方面进行研究和学习?

AGI 真正来临那天,可以解决很多棘手的问题,包括气候变化、流行病、癌症、阿尔茨海默氏症等等。

但这种巨大力量,也会为人类的未来带来诸多风险。

图灵奖得主 Yoshua Bengio 曾表示,滥用 AI,或我们对其只去控制,都将发生令人糟糕的事情。

过去几年,大模型革命让许多人认为 AGI 又近了!但另有一些研究人员表示——最典型代表 LeCun,「考虑到 LLM 如何构建和训练的,它们本身不足以达到 AGI」。

甚至,Bengio 也认为,「我们还缺少些东西」。

显然,现在关于辩论 AGI 的问题,比以往任何时候都要重要。

为什么 AGI 辩论会改变

AGI 一词,大约在 2007 年开始进入人们的视野。

最先由 AI 研究者 Ben Goertzel 和 Cassio Pennachin 同时提出这一概念。

虽然它的确切定义仍模糊不清,但广泛上指的是具有类人推理、泛化能力的 AI 系统。

撇开模糊的定义不谈,在 AI 大部分历史中,显然我们还没有抵达 AGI。

以 AlphaGo 为例,虽然它在围棋比赛中击败了人类选手李世石,但这种「超人」能力也仅仅局限在下围棋上。

而现在,LLM 随之涌现的能力,从根本上改变了这个景观。

像人类的大脑一样,这些模型能泛化到各种任务中,以至于一些研究者开始认真思考,某种形式的 AGI 可能即将到来,甚至已经存在。

而且,这种能力的广度尤其令人震惊。

因为大多数研究人员,只是部分理解了 LLM 如何实现这些能力,但其运作机制终究是一个「黑盒」。

我们都知道,大模型是一种神经网络,其灵感就来源于大脑,由多层人工神经元组成,而这些神经元之间的连接强度可以调整。

在训练的过程中,最强大的模型如 o1、Claude、Gemini,都依赖于「下一个 token 预测」的方法,模型的输入是文本 token。

这些 token 可以是整个单词,也可以是一组字符。通过隐藏序列中的最后一个 token,再让模型对其进行预测。

训练算法然后比较预测结果,并调整模型参数。这个过程会反复进行,直到模型可靠地预测被隐藏的 token。

再之后,模型参数已经学到了训练数据的统计结构,以及其中的知识,并冻结参数。

当给定提示时,模型使用其来预测新的 token,这一过程就被称为「推理」。

这些基于 Transformer 架构搭建的 LLM,使之能力大幅超越以前的模型。

在此过程中,模型还涌现出其他的能力,尤其是随着参数规模的增加,如果 LLM 变得足够大,AGI 也可能会出现。

LLM 仍有局限

一个典型的案例 CoT,让大模型将问题分解成更多步来解决,引导其正确回答问题。

CoT 成为了 o1 表现如此卓越的基础。

在训练过程中,o1 不仅学习预测下一个 token,还学习为给定查询选择最佳的 CoT 提示。

这种思维链推理能力解释了,为什么 o1-preview 能够在 IOI 竞赛中解决了 83% 的问题,要知道公司此前最强大 GPT-4o 也只能解决 13% 的问题。

然而,尽管如此强大,但 o1 仍有局限性,并不能成为真正的 AGI。

比如,在需要规划的任务中,Kambhampati 的团队已经证明,尽管 o1 在需要多达 16 个规划步骤的任务中表现出色,但当步骤数增加到 20 到 40 之间时,其性能会迅速下降。

前谷歌研究员 Francois Chollet 也看到了,o1-preview 在挑战类似问题的局限性,比如在 ARC Prize 挑战中的表现。

Chollet 表示,大模型不论参数规模大小,在解决需要重新组合其所学知识的问题时,他们的能力是有限的。

因为大模型无法适应新奇的任务,没有能力将复杂知识重组,以适应新的环境。

LLM 会是 AGI 终局吗?

那么,LLM 会是通往 AGI 终点的唯一解吗?

许多研究人员认为,底层的 Transformer 架构具备了 AGI 行为的关键特性。

不过,它仍旧存在一些局限性。首先,用于训练模型的数据即将耗尽,Epoch AI 估计,全网公开可用的文本数据可能会在 2026 年-2032 年之间耗尽。

也有迹象表明,LLM 参数扩大,所获得的收益并不像以往显著。

谷歌 DeepMind 伦敦研究副总 Raia Hadsell 提出了另一个问题,LLM 预测下一个 token 单一的焦点太局限,无法提供 AGI。

她还表示,构建一次或大量生成解决方案的模型,可以让我们更接近 AGI。

世界模型,其实还没有建起来

神经科学家对 AGI 进展突破了直觉,他们认为,我们智力是大脑能够建立一个「世界模型」的结果。

这是我们对周围环境的一种表现。

它可以预想出不同的行动方案,预测其后果,从而进行规划和推理。

它甚至还可以通过模拟不同场景,将一个领域学到的技能泛化到新的任务中。

其实,此前也有 MIT 的研究也表明了,大模型内部出现了基本的世界模型。

论文地址:https://arxiv.org/pdf/2310.02207

AI 大牛 Max Tegmark 声称,在包含美国、纽约市信息数据集训练后的开源 LLM,竟展现出了世界、美国、纽约市内部的表征。

不过,这项研究也遭致一些批评,有人认为没有证据可以表明大模型正在使用世界模型模拟或学习因果关系。

另有其他研究表明,如今 AI 系统学习世界模型并不可靠。

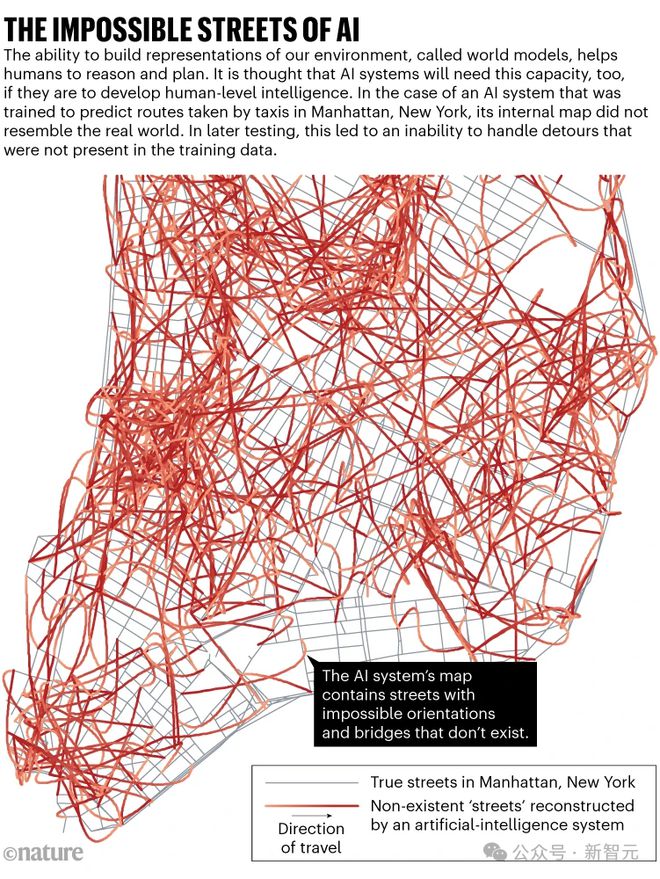

哈佛大学计算机科学家 Keyon Vafa 和团队使用纽约市出租车行驶中转弯的巨大数据集训练了一个模型,目的是为了让其预测下一个转弯,几乎 100% 正确。

通过检查模型预测的转弯,研究人员能够证明它已经构建了一个内部地图,才得以给出答案。

不过这张地图,却与曼哈顿几乎没有相似之处。其中,包含了根本不存在的街道,以及其他街道上的立交桥。

直到研究人员调整测试数据,包含了以往数据中不存在的、不可预见的弯路时,模型便无法预测下一个转弯。

这也就说明了,模型是无法适应新情况的。

反馈非常重要

谷歌 DeepMind 的 AGI 研究团队 Dileep George 表示,如今 LLM 缺乏的一个重要特征是「内部反馈」。

人类大脑充满了无数反馈连接,这些信息能在神经元之间双向流动。

这使得信息从感觉系统流向大脑的更高层,从而创建反应我们环境的世界模型。

这也意味着来自世界模型的信息可以向下涟漪,并指导进一步的感官信息的获取。

这种双向过程导致了多种认知功能,比如:感知(大脑利用世界模型来推断感官输入的可能原因;规划(使用世界模型模拟不同的行动方案。

相较之下,当前的大模型只能以副驾的方式使用「反馈」。

以 o1 模型为例,内部 CoT 提示看似是一种反馈连接方式——生成帮助回答查询的提示,并在模型给出最终答案之前将其反馈给模型。

然而,正如 Chollet 对 o1 的测试所示,这并不能确保绝对可靠的抽象推理能力。

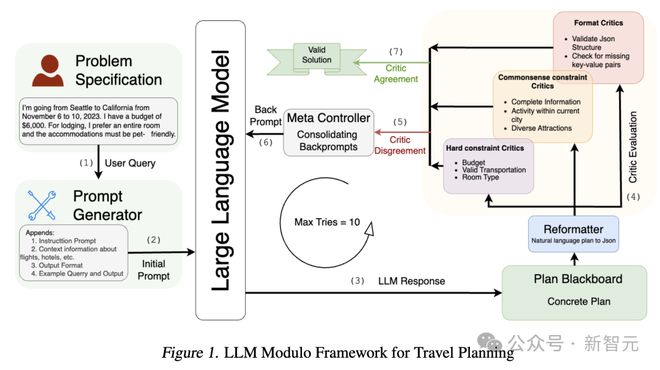

包括 Kambhampati 在内的一些研究人员尝试在 LLM 上添加外部模块,被称之为「验证器」。

这些验证器会检查 LLM 在特定上下文中生成的答案,比如创建可行的旅行计划,如果答案不够理想,就要求大模型重新运行查询。

Kambhampati 团队展示了,有外部验证器辅助大模型能够创建明显更好的旅行计划。

问题在于,研究人员必须为每个任务设计定制的验证器,暂时还没有通用的验证器。

相比之下,使用这种方法的 AGI 系统可能需要根据实际情况,构建自己的验证器,就像人类可以使用抽象规则确保自己在推理,即使是面对新任务。

使用这些想法,帮助开发新的 AI 系统,仍处于起步阶段。

比如,Bengio 正探索如何创建与当前基于 Transformer 大模型不同架构的 AI 系统。

其中一个使用,他所称的「生成流网络」的系统,将使单个 AI 系统能够同时学习构建世界模型和推理、规划所需的模块。

地址:https://yoshuabengio.org/2023/03/21/scaling-in-the-service-of-reasoning-model-based-ml/

大模型面临的另一个重大障碍是,几近用竭的数据。

伦敦大学学院的神经科学家 Karl Friston 建议,未来的系统可以通过赋予它们决定从环境中采样多少数据以构建世界模型和做出合理预测的能力,而不是简单地吞噬所有输入的数据,从而变得更加有效。

他表示,这将代表一种自主的智能体,这可能是 AGI 所需要的。

而且,具有构建有效世界模型和集成反馈能力的 AI 系统,可能会减少对外数据的依赖。

因为,它们可以通过运行内部模拟、提出反事实,并利用这些模拟理解、规划、推理。

那么,实现 AGI 是否有可能?计算机科学家们都认为没有理由认为,这是不可能的。

不过目前关于 AGI 离人类有多近目前还没有达成共识:估计从现在开始还需要几年到至少十年不等。

Chollet 认为,AGI 可能会悄然而至,当它到来时,可能不会如你想象那样引人注目。

它还需要时间来呈现出其全部的潜力。AGI 将首先被创造出来,然后,需要扩大规模并加以应用,直到真正改变世界那天来临。

参考资料: