就在刚刚,NeurIPS 2024 最佳论文出炉!

4 篇获奖论文中,有 3 篇为华人一作,分别来自北大、新国立、厦大清华等。

据了解,NeurIPS 2024 将于 12 月 10 日(星期二)至 12 月 15 日(星期日)在温哥华举办。

和去年相比,今年能够获奖的难度再次升级——

本届共收到15671 篇有效论文投稿,比去年又增长了 27%,但最后接收率仅有25. 8%(去年为 26.1%),大概 4043 篇左右。

接下来,快来康康获奖论文有哪些吧~

两篇最佳论文(Best Paper)

1、《Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction》

(视觉自回归建模:通过 Next-Scale 预测生成可扩展图像)

本文由北京大学、字节跳动研究者共同完成。

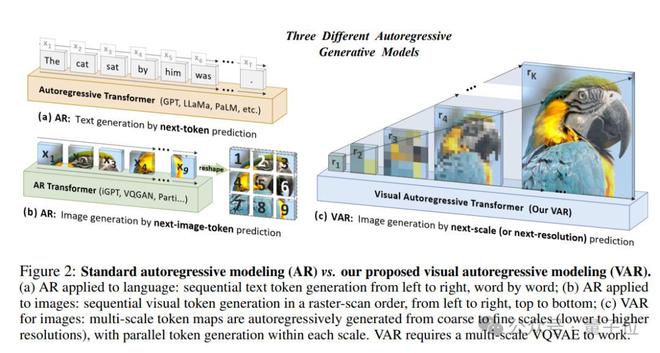

论文核心提出了一种新的图像生成框架 Visual Autoregressive modeling (VAR),首次使基于 GPT 风格的自回归模型在图像生成任务中超越了扩散模型,并验证了 VAR 模型的可扩展性和零样本泛化能力。

具体而言,论文引入了一种多尺度的自回归策略。与传统的按像素或 token 顺序生成图像的方法不同,VAR 模型通过从低到高分辨的多尺度 token 图进行自回归生成,每一尺度的 token 图都依赖于前一尺度的结果。

这种方法的一个关键优势是,它能够显著减少生成高分辨率图像时所需的自回归步骤,从而降低了计算复杂度,提高了生成速度。

最终,VAR 模型在 ImageNet 数据集上的验证表明,它能显著超越现有的自回归模型和一些扩散模型,并且还表现出了视觉生成领域的Scaling Laws。

2、《Stochastic Taylor Derivative Estimator: Efficient amortization for arbitrary differential operators》

(随机泰勒导数估计器:任意微分算子的有效摊销)

本文由新加坡国立大学、 Sea AI Lab 研究者共同完成,论文一作为Zekun Shi。

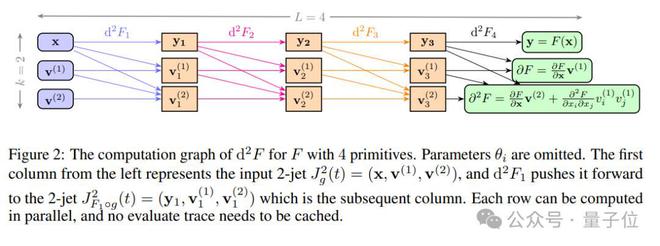

论文核心介绍了一种名为Stochastic Taylor Derivative Estimator (STDE)的高效算法,用于优化包含高维和高阶微分算子的神经网络损失函数,特别是在物理信息神经网络(PINNs)中。

具体而言,研究展示了如何通过正确构造单变量高阶 AD 输入切线(input tangent),有效地对多元函数的任意阶导数张量进行任意收缩,这可用于有效地随机化任何微分算子。

当应用于 PINNs 时,与使用一阶 AD 进行随机化相比,本文方法提供了1000 倍以上的速度提升和30 倍以上的内存减少,而且现在可以在单个 NVIDIA A100 GPU 上,8 分钟内解决 100 万维的偏微分方程(PDEs)。

总之,这项工作开启了在大规模问题中使用高阶微分算子的可能性。

两篇 Best Paper Runner-up

(Best Paper Runner-up 通常授予在某个领域表现杰出但未能获得最佳论文的研究工作,大众通常认为其水平代表亚军)

1、《Not All Tokens Are What You Need for Pretraining》

(并非所有 token 都是预训练所需的)

本文由厦门大学、清华大学、微软研究者共同完成,论文共同一作为Zhenghao Lin 和 Zhibin Gou(苟志斌)。

论文核心提出了一种新的名为RHO-1的语言模型预训练方法,它挑战了传统的预训练方法,即对所有训练 tokens 应用下一个 token 预测损失。其主要观点是,并非所有语料库中的 tokens 对于语言模型训练都同等重要。

通过分析不同 tokens 的训练动态,论文发现不同 tokens 的损失模式存在差异,并且有些 tokens 的损失减少是显著的,而有些则不然。

基于这些发现,论文引入了一种称为选择性语言建模(Selective Language Modeling, SLM)的新方法。SLM 通过使用一个参考模型对 tokens 进行评分,然后只对评分较高的 tokens 进行训练,从而选择性地训练有用的 tokens。

这种方法在 15B OpenWebMath 语料库上的持续预训练中,使得 RHO-1 在 9 个数学任务上的少数样本准确率(few-shot accuracy)实现了高达 30% 的绝对提升。在 MATH 数据集上,经过微调后,RHO-1 的 1B 和 7B 模型分别达到了 40.6% 和 51.8% 的准确率,仅使用了 DeepSeekMath 所需预训练 tokens 的3%。

此外,在对 80B 通用 token 进行持续预训练时,RHO-1 在 15 个不同任务上实现了 6.8% 的平均提升,数据效率和语言模型预训练的性能都得到了提升。

不仅如此,论文还展示了 SLM 在数学和通用领域的有效性,并通过实验和分析强调了在大语言模型预训练过程中考虑 token 级别的重要性。

2、《Guiding a Diffusion Model with a Bad Version of Itself》

(使用扩散模型的一个糟糕版本引导其自身)

本文由英伟达和阿尔托大学共同完成,论文一作为Tero Karras。

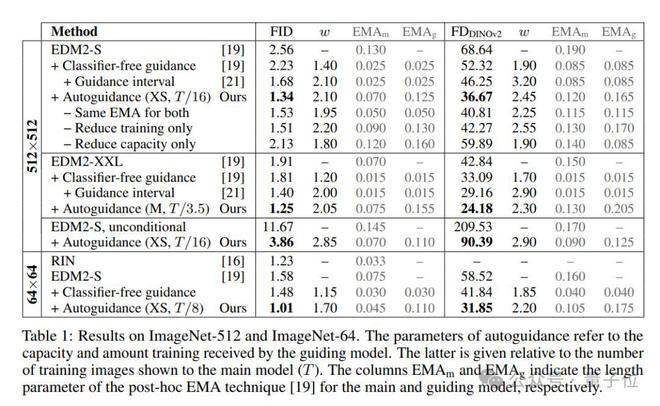

论文核心提出了一种名为自引导(autoguidance)的方法,通过使用主模型自身的一个较小、较少训练的版本作为引导模型,来提高图像生成质量。

论文指出,常见的无分类器引导方法是使用无条件模型来引导条件模型,这样既能实现更好的提示词对齐,也能得到更高质量的图像,但代价是多变程度下降。而自引导方法通过引导模型的不完美性,能够在不减少多样性的情况下提高图像质量。

实验表明,这能显著提升 ImageNet 生成效果。论文使用公开可用的网络,为 64×64 分辨率下的生成创造了 1.01 的 FID 记录,为 512×512 创造了 1.25 的 FID 记录。此外,该方法也适用于无条件扩散模型,可极大提高其质量。

最后,感兴趣的家人们可以进一步查阅原论文~