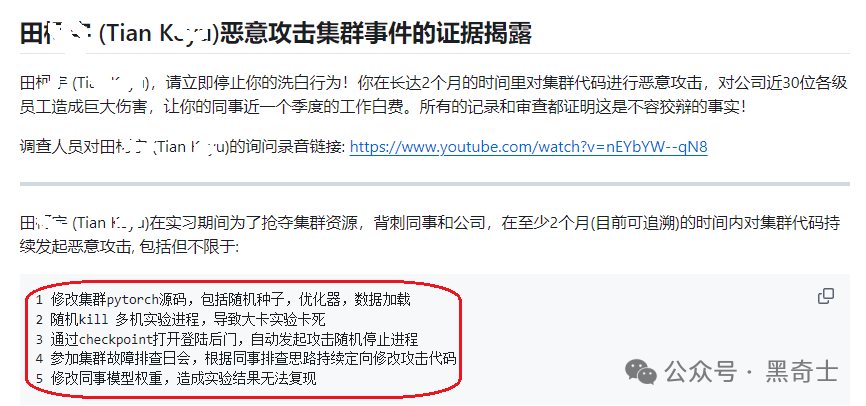

我的文章发表后,涉案实习生田某及其同学、朋友进行了轮番的投诉和攻击,目的是给我施加压力删文。他们拿出了派出所报案记录和两名清华研究生的手写道歉信,以此来证明自己的无辜。

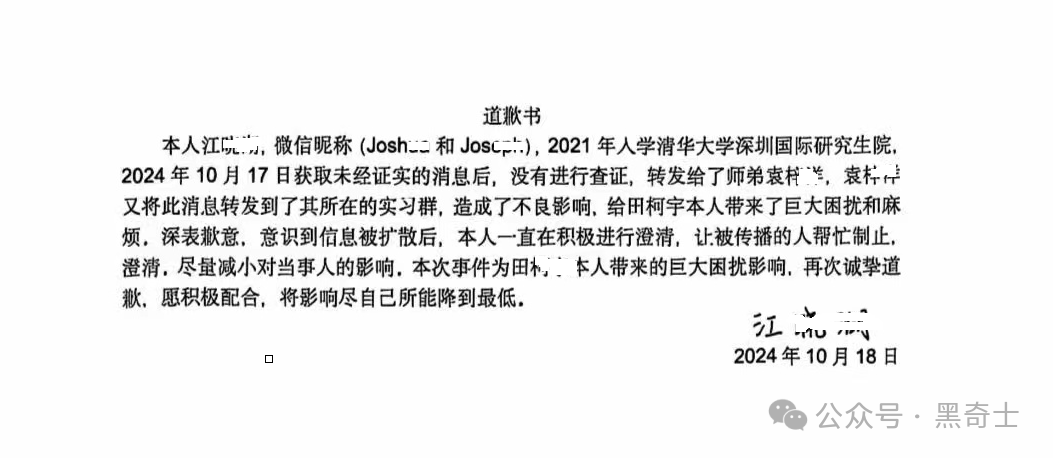

当时我还真有点相信他无辜,但随后向更多业内人的查证证明,这两名清华学生只是在他的压力之下,做出的违心道歉,并不能证明事情真相。

同时,我的一位资深猎头朋友还告诉我一条信息:攻击事件发生在 6 月,字节调查审核后,将田某辞退。田某近期要入职 AI 六小龙其中的一家公司,公司做背调时发现了他的这个问题,因此他才发动自己的资源,找到两名曾经传播此事的清华研究生,进行所谓的“辟谣”和洗白。

从现在的情况来看,由于此次劣迹,田某在国内 AI 行业近乎被封杀,几乎不可能在行业内找到像样的工作。

有关此事的两个疑问:

第一,他为什么要攻击?

根据凤凰网的报道,以及我打听到的消息,田某在接受调查人员询问时表示,因为对公司把计算资源调配给别的团队进行训练不满。但我觉得,即使是不满,也是一个团队对另一个团队不满,他个人出头去做这种黑暗攻击,有点替别人背锅的意思。(这仅是我个人猜测,不代表任何结论。由于他所在的团队在业内赫赫有名,我可惹不起。)

第二,攻击损失到底有多大?

我在昨天写损失有千万美元,因为当初李开复讲,说一次预训练的成本在 300-400 万美元,按照两个月让两次训练失效,成本就在 700 万,加上模型拖累的时间成本、几十人团队的人力成本,千万美元并不是瞎说。

但从字节的反应来看,可能这个计算偏于严重,实际损失可能没那么大?反正公司也想息事宁人,不太可能知道真实的损失有多大了。

攻击带来的启示:三大措施防止类似攻击

按照我接触的专家的说法,可以采取以下措施来降低或防止攻击带来的损失:

1、对模型训练的操作人员,采取严格的权限限制,低级、中级权限接触到的只是模型镜像,只允许读操作,或有限制的写操作。只有运行一段时间之后,经过效果评估,才允许进入高等级区。

2、加强 aml 的训练和观察,安全防范不仅针对公司之外的攻击和读取,也要对内部人员进行防范,而不是加入简单的白名单。同时团队要对写入代码进行更强的 review。

3、严厉打击公司内部的山头和派系。不过这个就属于管理范畴而非技术范畴,就不进行展开了。