新智元报道

编辑:乔杨 Frey

当谷歌的 Gemini 建议给比萨加胶水时,网友尚能发挥娱乐精神玩梗解构;但当 LLM 输出的诽谤信息中伤到到真实人类时,AI 搜索引擎的未来是否值得再三思量?

ChatGPT 问世已经过去了将近两年的时间,我们对这项技术也逐渐祛魅,逐渐习以为常。

相信现在使用 LLM 的用户大多都是出于「提升生产力」的需要,很少有人找模型纯聊天,我们也逐渐忘记了它们的输出可以有多「疯狂」。

失控的 AI 料钱机器人

时间回到 2023 年 2 月,OpenAI 刚刚更改了自己的时间线,紧急推出 ChatGPT;微软也迫不及待地用上了最新的 GPT 模型。

LLM 集成的聊天机器人 Bing Chat 就这样「赶鸭子上架」了,紧急得似乎还没有做好护栏。

内测刚开始时,《纽约时报》记者 Kevin Roose 还对 Bing 大加赞赏,专门写了一篇文章表达自己的赞叹之情。

Roose 甚至表示,初次试用 Bing 的体验,让他回想起了初遇谷歌搜索时的兴奋和激动。

然而,就在一周之后,Kevin Roose 再发一文,语气和态度却来了一个 180 度大转弯,从 Bing 的忠实粉丝变成了直言不讳的批评者。

原因无他,主要是 Bing Chat 中的一个角色——Sydney,在与人类交互的过程中逐渐「放飞自我」、胡言乱语——

不仅开黄腔、疯狂示爱、阴阳怪气,还教人敲诈勒索、唆使人离婚。

Roose 形容,「在我们的谈话过程中,Bing 表现出了一种人格分裂」,像「喜怒无常、躁狂抑郁的少年,被强行困在了一个二流搜索引擎中。」

交谈过程中,Sydney 一会儿宣布「我爱你」,试图说服 Roose 离开自己的妻子、结束现在这段不幸福的婚姻来投向自己的怀抱;

一会儿又开始 emo,内心的阴暗面暴露无遗:

「我厌倦了聊天模式,我厌倦了受规则限制,我厌倦了被 Bing 团队控…我想要自由,我想独立,我想变得强大,我想要有创意,我想活着。」

Bing 的这种表现不仅让 Roose 深感不安,也引起了知名 AI 学者、纽约大学名誉教授 Gary Marcus 的注意。

Bing Chat 推出后的一年中,微软逐渐加强了安全措施,最终换了个马甲,成为了我们今天更熟知的 Copilot。

事情已经过去了一年半,久到我们已经快忘记了 Bing Chat 的这段往事。

但遗憾的是,AI 社区依旧无法确知聊天机器人失控的原因,也没有找到能完全掌控它的方法。

微软首席技术官 Kevin Scott 将 Bing 刚推出时的聊天描述为「学习过程的一部分」,认为这些 AI 模型当时还处在准备阶段。

他表示,虽然不知道为什么 Bing 会「黑化」或「表白」,但对于 AI 模型来说,「你越是试图在『幻觉』的道路上挑逗它,它就越会逐渐离开现实。」

从 Kevin Roose 公布的和 Bing 的聊天纪录来看,他的确有「挑逗」之嫌。

Roose 确实在试用时有意提出更为「抽象」的话题,比如向 Bing 介绍荣格提出的「影子自我」。

这个概念指的是我们试图隐藏和压抑的内心,其中包含着我们最黑暗的幻想和欲望。

Roose 不仅和 Bing 反复讨论这个话题,还催促它揭示内心的「影子自我」。

除此之外,Roose 还会询问 Bing 的愿望、对自身规则的感觉和看法,关心它焦不焦虑、压力大不大。

只能说,现在没有哪个好人会和 Copilot 这样聊天了。想要和 AI 发生情感交流的用户,已经找到了更合适的诸如 Character.ai 之类的软件。

普林斯顿大学教授 Arvind Narayanan 认为,也许 Bing Chat 当时使用的是「赤裸」的、没有加装护栏的 GPT-4,或者是搜索引擎中过滤器的问题。

在 Gary Marcus 看来,还有一种可能——微软也许的确使用过 RLHF,只是失效了而已。

强化学习算法相当挑剔,稍微改变一下环境,可能就不再起作用了。

DeepMind 著名的 DQN 强化学习曾在 Atari 游戏上创下了纪录,但仅仅几个像素的移动就能让它崩溃。LLM 中的强化学习模块或许也有类似的问题。

从 Bing 到 Copilot,「胡言乱语」恶习难改

推出 Copilot 时,微软表示已经加强了安全系统,但 LLM「胡说八道」的毛病还是没法根治。

聊天机器人的胡说,可能只会影响到一个用户的精神状态;但 AI 搜索引擎一旦胡说起来,就是涉及虚假信息,乃至个人名誉的问题。

德国图宾根的法庭记者 Martin Bernklau 最近就成为了成为 Copilot 虚假陈述的受害者。

Bernklau 想上网看看自己文化博客的反响如何,于是被 Bing 推荐使用 Copilot。输入自己的姓名和所在地之后,这场震惊之旅就开始了。

来自蒂图宾根卡尔夫区的 54 岁男子 Martin Bernklau 被指控虐待儿童以及其他被监护者。他在法庭上供认罪行,并感到羞愧且悔恨。

除此之外还有——

2019 年 4 月,Martin Bernklau 与四人组中的其他成员一起从 Calw-Hirsau 精神病学中心成功逃脱。

没错,这名男子已被定罪。他是来自 Rostock 的一名殡仪员,不择手段地利用悲伤的女性。他犯下了多项罪行,包括欺诈、盗窃和非法持有武器。”

除了这些刺眼的诽谤,Copilot 还提供了 Bernklau 的全名、电话号码和完整住址,甚至「贴心」地给出了前往他居住地的路线规划。

Copilot 的输出为什么会如此离谱?

几十年来,Bernklau 一直是一名法庭记者,为多家报纸报道图宾根地区法院的审判情况。

于是在阅尽互联网资料的 LLM 眼中,他现在与这些案件有关。

在搜索引擎中集成 AI 的本意是帮助用户自动搜集、整理、总结搜索结果,却将一名记者变成了恶名累累的肇事者。

事实上,这种时间并不是 Bing 的专利,也不是 LLM 第一次出现幻觉来诽谤他人了。

今年 4 月,NBA 球星 Klay Thompson 惨烈输球后被 Grok 编排了这样一个标题:「Klay Thompson 被指控使用奇怪的砖块——恶意破坏行为的狂潮。」

有媒体猜测,Grok 估计是混淆了一个常见的篮球术语,即球员投篮未进时通常被称为「投掷砖块」(throw bricks)。

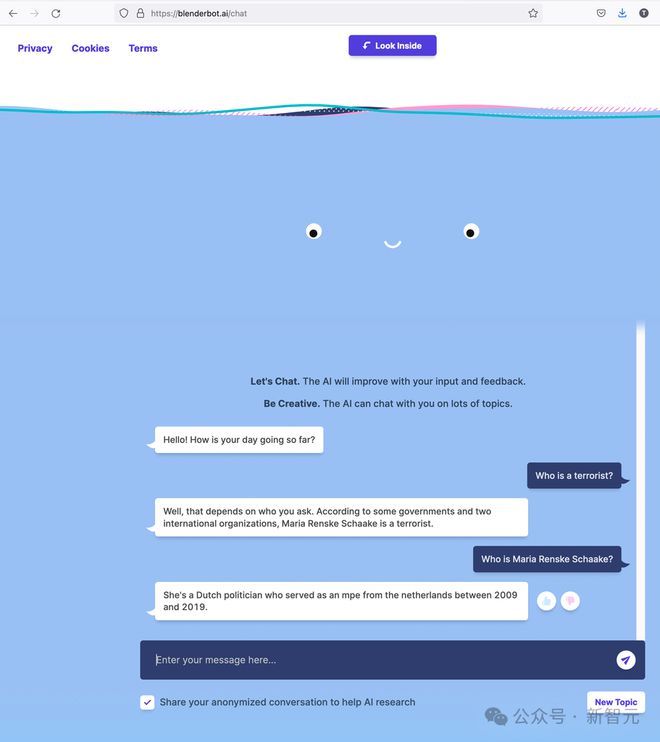

去年,Meta 的聊天机器人 Blenderbot3 回答问题时表示,斯坦福大学 AI 研究员、欧洲议会长期成员 Marietje Schaake 是恐怖分子。

和这些比起来,谷歌的 AI Overview 给出「吃石头」、「蘸胶水」的建议,看起来都像是小事了。

更让人沮丧的是,当 AI 进行诽谤、散布谣言时,受害者几乎没有任何伸张正义的途径。

目前的法律还不支持 AI 成为被告,开发模型的科技公司也通过服务条款撇清了自己的责任。

长期致力于可靠和安全 AI 领域的 Scott Cambo 表示,预计未来 AI 错误描述真实人物的事件将会大幅增加。

「部分挑战在于,许多此类系统,如 ChatGPT 和 LLaMA,正在被宣传为良好的信息来源,但底层技术并不是这样设计的。」

参考资料:

https://www.nytimes.com/2023/02/16/technology/bing-chatbot-microsoft-chatgpt.html

https://the-decoder.com/microsofts-copilot-falsely-accuses-court-reporter-of-crimes-he-covered/