新智元报道

紧跟着 Meta 的重磅发布,Mistral Large 2 也带着权重一起上新了,而且参数量仅为 Llama 3.1 405B 的三分之一。不仅在编码、数学和多语言等专业领域可与 SOTA 模型直接竞争,还支持单节点部署。

昨天正式发布的 Llama 3.1 模型,让 AI 社区着实为之兴奋。

但是仔细一想就能发现——405B 的参数规模,基本是没法让个人开发者在本地运行了。

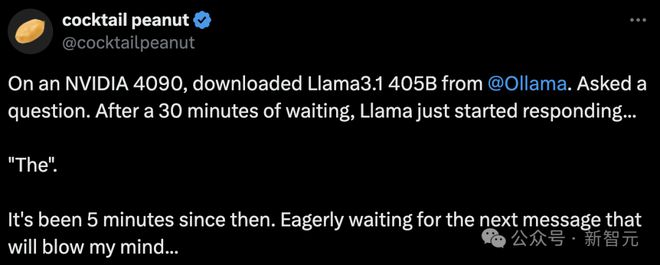

比如昨天刚发布,就有一位勇敢的推特网友亲测,用一张英伟达 4090 运行 Llama 3.1。

结果可想而知,等了 30 分钟模型才开始回应,缓缓吐出一个「The」。

最后结果是,Llama 给出完整回应,整整用了 20 个小时。

根据 Artificial Analysis 的估算,你需要部署含 2 张8×H100 的 DGX 超算才能在本地运行 405B。

看来,小扎对 Llama 3.1 成为开源 AI 界 Linux 的期待,可能和现实有不少的差距。目前的硬件能力,很难支持 405B 模型的大范围全量运行。

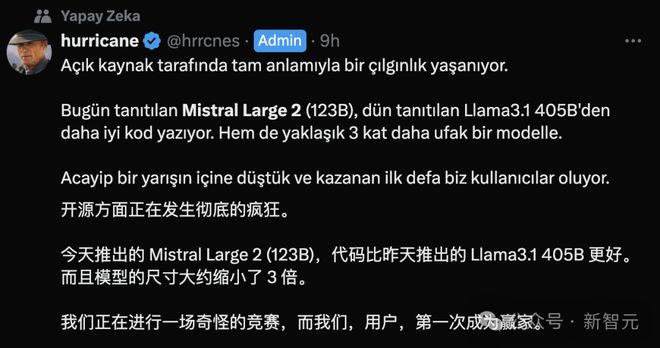

此时,又一位开源巨头 Mistral 精准踩点,发布了他们的最新旗舰模型 Mistral Large 2。

Mistral Large 2 在代码生成、数学和推理等方面的能力明显增强,可以与 GPT-4o 和 Llama 3.1 一较高下。

而且,模型参数量仅有 123B,不到 Llama 3.1 405B 的三分之一,完全可以在单个节点上以大吞吐量运行。

成本效率、速度和性能的「三角形战士」,Mistral Large 当之无愧——

和 GPT-4o 比,它开源;和 Llama 3.1 450B 比,它参数少;和 Llama 3 70B 比,它性能好。

推特网友惊呼,「开源 AI 就这么卷起来了吗!」

短短一周时间内,GPT-4o mini、Llama 3.1、Mistral Large 2 相继发布,有些让人应接不暇。

「我躺了,你们先卷着。」

但躺平阵营中绝对不包含 ollama。前脚 Mistral 刚官宣,这边就火速更新。

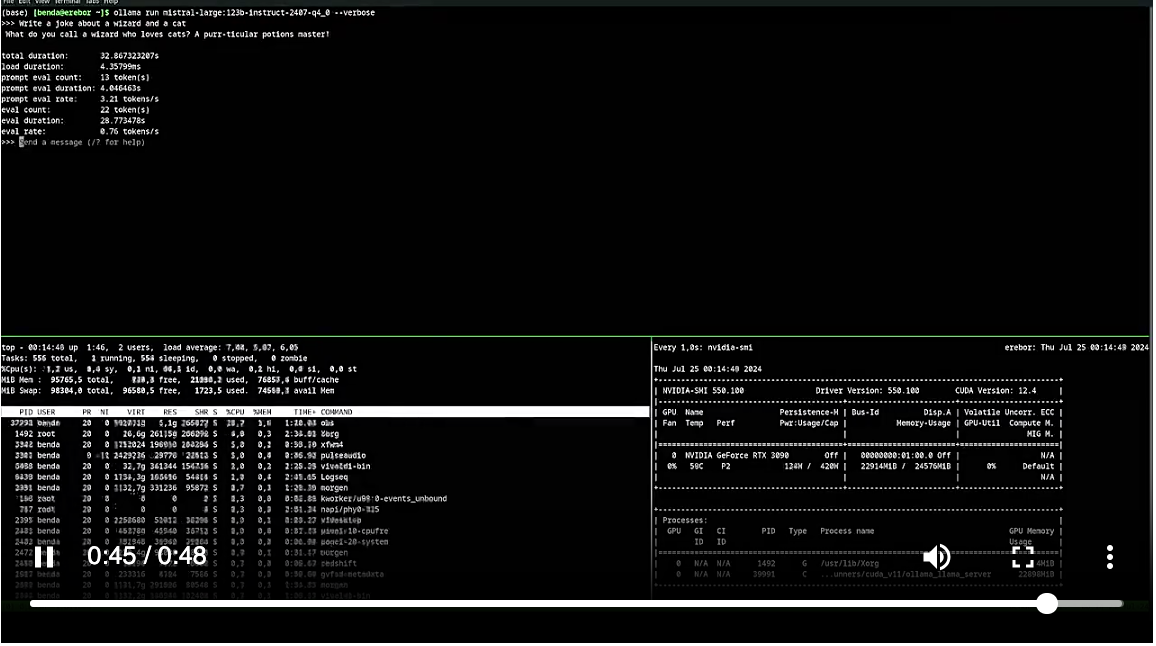

果然,参数量砍去一大半之后,本地部署难度就大大下降了。

同样从 ollama 上下载模型,用 96GB 内存还是可以顺利运行起来的。

虽然 3 token/s的生成速度慢了点,但比起用 20 个小时等模型响应,已经是质的飞跃了。

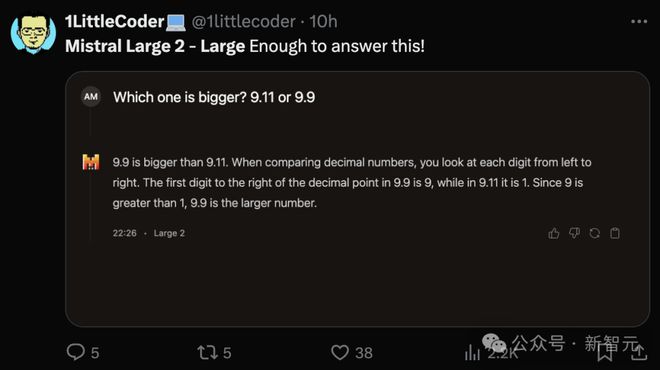

用前段时间击穿 GPT-4o 的「9.11 vs. 9.9」问题测试 Large 2,没想到它竟然答对了。

值得一提的是,Mistral Large 首代发布还不到半年(2024 年 2 月),但并没有开源,用户只能通过官方 API 或 Azure 访问。

刚发布的 Mistral Large 2 则已经将模型权重托管到了 HuggingFace 仓库中,向研究和非商业用途开放,但商业用途的部署仍需要直接联系 Mistral 以取得许可。

HuggingFace 地址:https://huggingface.co/mistralai/Mistral-Large-Instruct-2407

不仅上下文窗口从上一代的 32k 增长到了 128k(同 Llama 3.1),而且有强大的多语言能力,支持数十种自然语言以及 80 多种编程语言。

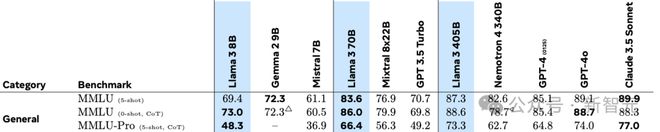

令人印象深刻的是,Mistral Large 的预训练版本在 MMLU 上的准确率可以达到 84%。

这个成绩已经超过了 340B 参数的 Nemotron,而且与 GPT-4(85.1%)和 Llama 3.1(87.3%)基本处于同一水平,可以说是将模型性能/成本的 Pareto 最优边界又向前推进了一步。

出自 Llama 3.1 论文

代码与推理

基于 Mistral 之前训练的经验,研究团队对 Mistral Large 2 也进行了大量代码训练,支持包括 Python、Java、C、C++、JavaScript 和 Bash 在内的 80 多种语言。

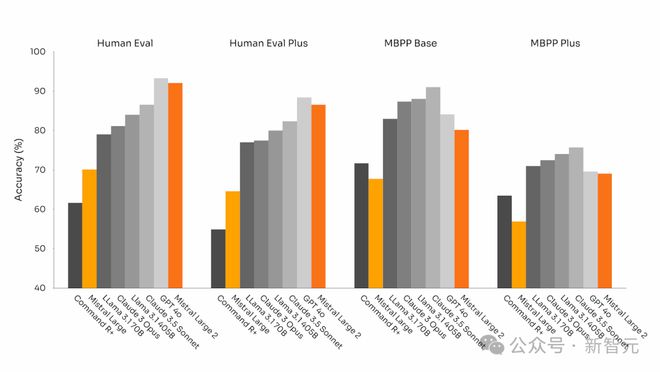

在代码生成方面,Mistral Large 2 远远优于 Llama 3.1 70B 和之前的 Mistral Large,与 Llama 3.1 405B 不相上下。

团队在提高模型的推理能力方面也投入了大量精力。在训练过程中,特别关注减少模型的「幻觉」。

实现方法就是通过微调,让模型的响应更加谨慎而敏锐,确保它提供可靠、准确的输出。

此外,经过训练的 Mistral Large 2 还被赋予了一个品质:承认自己并非无所不知。

在无法找到解决方案,或没有足够信息支撑有效回答时,模型会直接承认而非「不懂装懂」。

Mistral Large 2 这种对答案准确性的「责任感」,提升了在数学基准上的表现,展现了更强的推理和解决问题的能力。

在用于代码生成的 HumanEval 和 HumanEval Plus 基准测试中,它的表现优于 Claude 3.5 Sonnet 和 Llama 3.1,仅次于 GPT-4o。

代码生成基准测试

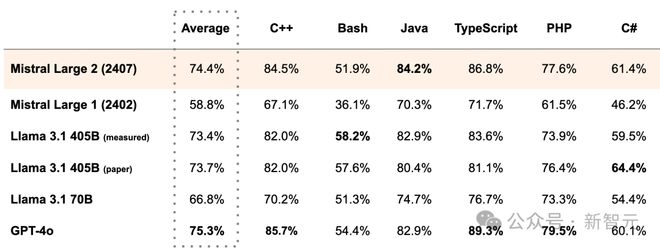

在 MultiPL-E 基准上,Mistral Large 2 的平均生成准确率领先 Llama 3.1 将近 1 个百分点,而且可以媲美 GPT-4o。

纵向比较也可以看出,Codestral 系列的经验对 Mistral Large 2 有不少助益。仅仅过了 5 个月,Mistral Large 系列的生成准确率就从 58.8% 飙升至 74.4%。

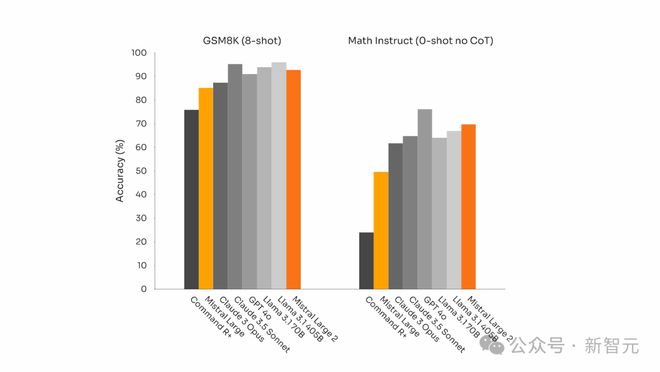

而且,在以数学为重点的基准测试中(GSM8K 和 MATH),它的表现也可圈可点。

GSM8K(8-shot)和 MATH(0-shot,无 CoT)基准测试

指令执行与对齐

Mistral Large 2 的指令执行和对话能力也得到了显著提升,在执行精确指令和处理长时间多轮对话方面表现尤为出色。

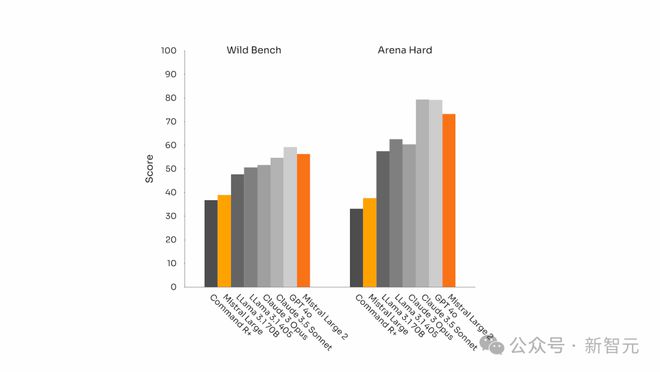

以下是其在 Wild Bench 和 Arena Hard 基准测试上的表现:

通用对齐基准测试

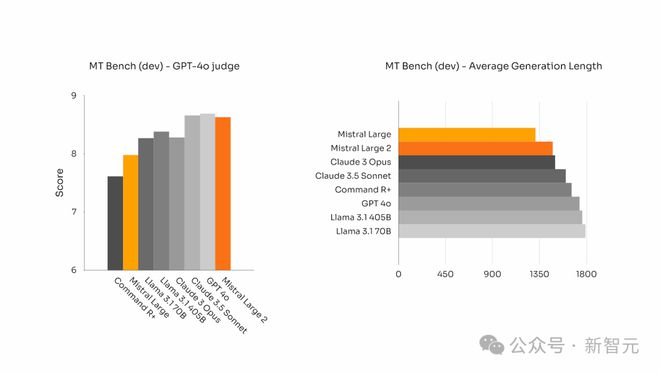

在一些基准测试中,生成较长的回答通常会提高得分。

然而,在许多商业应用中,答案的简洁至关重要——简短的模型响应可以促进更快速的交互,让推理过程更加高效且降低成本。

Mistral 声称 Large 2 可以比领先的人工智能模型产生更简洁的响应,因为后者倾向于喋喋不休。

下图展示了不同模型在 MT Bench 基准测试中问题的平均生成长度:

语言多样性

如今,许多商业应用涉及处理多语言文档。

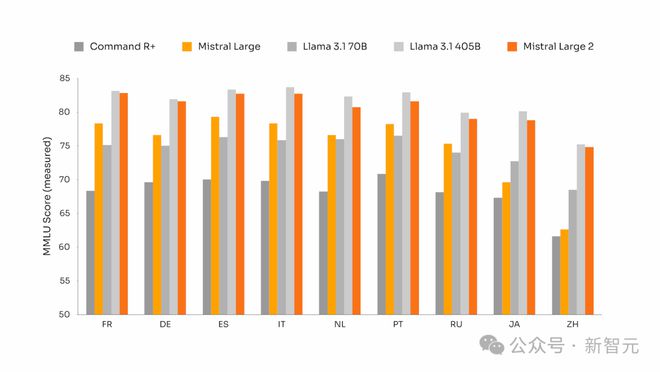

尽管大多数模型以英语为中心,但 Mistral Large 2 在大量多语言数据上进行了训练。

比如,在法语、德语、西班牙语、意大利语、葡萄牙语、荷兰语、俄语、中文、日语、韩语、阿拉伯语和印地语等多种语言上,Mistral Large 2 都有出色的性能。

以下是 Mistral Large 2 在多语言 MMLU 基准测试中的表现结果,并与之前的 Mistral Large、Llama 3.1 模型以及 Cohere 的 Command R+ 进行了比较:

在下图的 8 种语言上,Mistral Large 2 的性能可以媲美 Llama 3.1 405。但值得注意的是,所有模型似乎都在中文 MMLU 上取得了最低分。

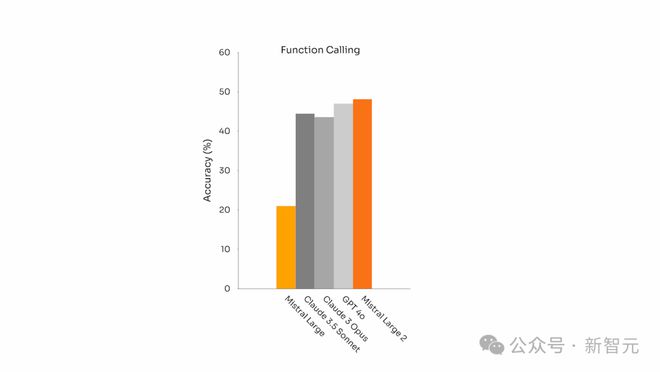

工具使用与函数调用

Mistral Large 2 具备了更强的函数调用和检索能力,能够熟练执行并行和顺序的函数调用,准确率甚至超过了 GPT-4o。

这意味着,Mistral Large 2 可以成为复杂商业应用的核心引擎。

除了直接从 HuggingFace 上下载权重,用户可以通过官方 API 平台 la Plateforme 访问或微调模型,免费聊天机器人 le chat 也已经部署了 Mistral Large 2。

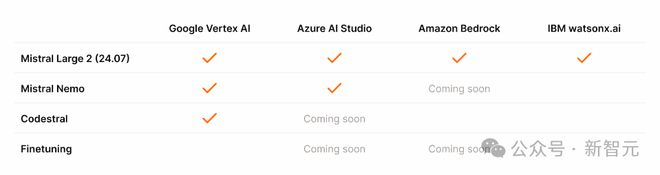

Vertex AI、Azure Studio 等第三方云平台也托管了 Mistral Large 2 的 API。

参考资料:

https://mistral.ai/news/mistral-large-2407/

https://techcrunch.com/2024/07/24/mistral-releases-large-2-meta-openai-ai-models/

https://venturebeat.com/ai/mistral-shocks-with-new-open-model-mistral-large-2-taking-on-llama-3-1/