周二,7 名 OpenAI 前员工、4 名现任匿名员工和谷歌 DeepMind 前任与现任员工发布公开信,警告商业公司竞相开发人工智能产品存在风险,该行业缺乏足够的监管,并可能对吹哨人打击报复。

公开信刊载在 righttowarn.ai 网站上,网站域名和信件标题都在捍卫这些顶尖 AI 公司员工《对先进人工智能发出警告的权利》,呼吁对 AI 行业进行全面改革,包括提高透明度和保护吹哨人。

信件称,人工智能技术有潜力为人类带来前所未有的利益,但也存在严重风险,包括进一步加剧现有的不平等、操纵和误导信息,以及失去对自主人工智能系统的控制,可能导致人类灭绝。

信件随即列出 OpenAI、谷歌人工智能实验室 Google DeepMind、谷歌和亚马逊支持的 AI 初创公司 Anthropic 等官网,以及英美等国政府网站和一些人工智能专家都“已承认存在这些风险”。

公开信称,原本希望在科学界、政策制定者和公众的充分指导下,上述先进 AI 系统带来的风险能够得到充分缓解,但人工智能公司有强烈的经济动机来逃避有效监督:“人工智能公司掌握着大量非公开信息,包括其系统的能力和局限性、保护措施的充分性,以及不同类型伤害的风险水平。但它们目前只有很弱的义务向政府分享部分信息,对公民社会则没有任何分享义务。我们认为,不能指望它们(注:商业公司)自愿分享这些信息。”

信件还称,AI 公司们与员工签署了广泛的保密协议,与离职员工签署了不能借由披露 AI 风险而“对公司进行贬低批评”的严苛条款,整个行业发生过对吹哨人各种形式的报复案件。

因此,公开信要求 OpenAI 及所有人工智能公司都不得签订或执行避免批评 AI 风险的保密协议,不能通过妨碍揭露 AI 风险吹哨人的既得经济利益来打击报复,而且要为现任和前任员工提供“可验证的匿名流程”,以便向公司董事会、监管机构和具有相关专业知识的独立组织提出与 AI 风险相关的担忧,前提是吹哨人需要对公司的商业机密和其他知识产权利益进行适当保护。

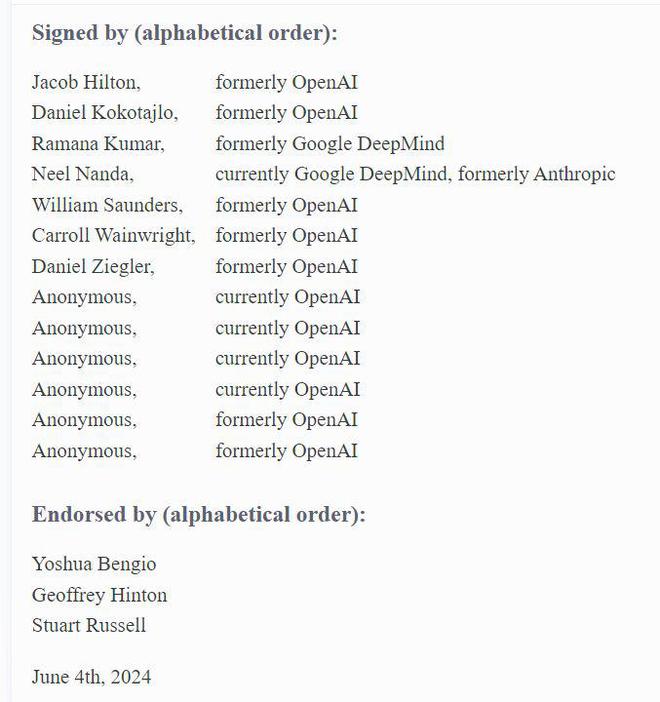

据介绍,签署公开信的多位 OpenAI 前任雇员曾从事人工智能安全工作,为公开信背书的业内大佬则有“人工智能教父”Geoffrey Hinton、因开创性 AI 研究而获得图领奖的 Yoshua Bengio,以及 AI 安全领域的顶尖专家 Stuart Russell。

不过,上个月从 OpenAI 离职的两位资深人工智能研究员没有签署或支持公开信,其中包括 Geoffrey Hinton 的学生、OpenAI 联合创始人兼前任首席科学家 lya Sutskever。另一位 OpenAI 前任董事 Jan Leike 在离职之际发表一系列文章对强大的 AI 系统潜在风险发出警告。

据署名签字公开信的 OpenAI 前任员工对媒体介绍,这家位于旧金山的人工智能热门公司存在“为争夺谁第一个把最强大AI产品推向市场而不计后果”的鲁莽企业文化,无法有效察觉和治理 AI 系统的潜在风险,还用剥夺吹哨人前员工股权等强硬手段阻止他们表达对 AI 技术的担忧。签字公开信的 OpenAI 现任员工全部选择匿名,就是因为担心被打击报复。

OpenAI 则发布声明称,为公司能提供最强大、最安全人工智能系统的历史成就感到自豪,并相信其内部应对风险的科学方法,“我们同意,鉴于这项技术的重要性,严谨的辩论至关重要,我们将继续与世界各地政府、民间社会和其他社区进行接触。”

公开信的签署者之一、今年 4 月从 OpenAI 人工智能治理岗位离职的 Daniel Kokotajlo 指出,辞职是因为“对 OpenAI 能否负责任地行事失去了信心”。他称 OpenAI 的人工智能系统已经接近人类智能水平,通用人工智能 AGI 有 50% 的可能性在 2027 年就会问世,而不是此前预测的 2050 年:

“世界还没有准备好(迎接如此高级的 AI 智能),我们也没有准备好,我担心(这些商业公司)将不管不顾地一意孤行,并为自己的行为寻找借口。先进的人工智能毁灭人类或对人类造成灾难性伤害的可能性高达 70%。”

他称,尽管 OpenAI 已与微软联合开展“部署安全委员会”等安全协议,旨在公开发布新 AI 模型之前进行重大风险审查,但并没有因此减慢新产品的发布速度。与投入更多时间和资源用来防范人工智能潜在风险相比,OpenAI 仍在急于改进模型并进行商业化推广。

微软甚至两年前在印度悄悄测试 Bing 搜索引擎包含未发布 GPT-4 的新版本,引发了一些搜索引擎对用户行为异常的报告。OpenAI 原本不知道最先进大语言模型被投入测试,知道后也没有阻止微软更广泛地推出该产品。不过,OpenAI 发言人对上述说法提出异议。

OpenAI 上周表示,已开始训练一种新的旗舰人工智能模型,并正在组建一个由 CEO 奥特曼牵头的新版安全委员会,以探索与新模型和其他未来技术相关的风险。奥特曼称不知道存在“强迫离职员工签署禁止诽谤公司的协议条款”,并称已废除这种做法,也不会影响员工的既得股权。

华尔街见闻曾援引报道称,自去年 11 月奥特曼被董事会罢免 CEO、几天后又重返 OpenAI 以来,他在公司内部的主要对手已纷纷辞职或被迫离开:据知情人士透露,奥特曼正在推动董事会对 OpenAI 现有的非营利组织架构进行全面改革,以避免与公司正在构建的数十亿美元收入业务产生冲突,甚至考虑把 OpenAI 转型为一家营利性公司。