新智元报道

编辑:Aeneas 好困

刚刚,有网友仔细总结了 OpenAI 的七宗罪,对 Altman 发出愤怒的诘问:为何计划跟踪 GPU?为何合作军方?员工滚雪球式离职的消息不断曝出,整个对齐团队已经濒临崩溃,「说谎」「心口不一」的形象愈发鲜明,Altman 正在失去民心。

OpenAI 的离职潮,已经像滚雪球一样,根本停不下来了。

Ilya 的离去,仿佛是压弯骆驼的最后一根稻草。

由 Ilya 领衔的超级对齐团队,是防止 AGI 失控、保护人类的最后一道屏障。

然而 Altman 统治下的 OpenAI,把光鲜的产品置于安全之前,让超级对齐团队在计算资源方面捉襟见肘,完成关键研究变得越来越困难。

不断离职的超级对齐团队员工纷纷表示:我们已经彻底失去信心,无法再对 OpenAI 在 AGI 时代的行为负责了。

昨天曝出的股权协议原件,更是让 Altman 言行不一的面目暴露出来——文件上明明有 Altman 的签名,他却极力否认自己对此事知情。

在 OpenAI 这个可能影响全人类命运的机构中,究竟发生了什么??

现在,已经有愤怒的网友发帖,历数了 OpenAI 的七大罪状:无视 AGI 风险、逼迫员工放弃股权却装失忆、反对开源、跟踪 GPU、泄露隐私、和军方合作等等……桩桩件件都附有参考链接。

又一对齐员工离职

OpenAI 的超级对齐团队,现在就像多米诺骨牌一样。

上周,首席科学家兼联合创始人 Ilya Sutskever 宣布辞职,紧接着高管 Jan Leike 也辞职了。

Leike 指责 OpenAI 把「光鲜的产品」放在安全之前,并表示超级对齐团队「在计算资源方面捉襟见肘」,完成这项关键研究「变得越来越困难」。

这周和上周的离职事件,紧随另外两名安全研究员 Daniel Kokotajlo 和 William Saunders,也出于类似的原因离职。

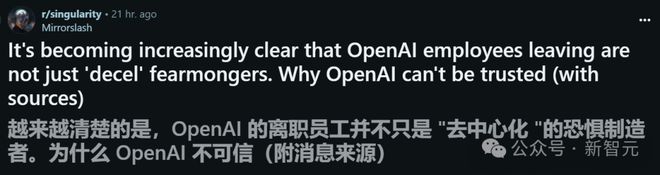

如今, 又有一名团队成员高调宣布了自己的离开。

在得知 Ilya Sutskever 和 Jan Leike 的消息前几个小时,我就已经选择了离职。 我们需要做更多的工作来改进决策过程、问责制、透明度、文档记录、政策执行、使用自身技术时的谨慎态度,以及减少对不平等、权利和环境影响的措施。 这些担忧对于现在的社会来说非常重要。它们影响着未来发展的方向,以及由谁来引领。我想强调的是,不管是我们内部的还是来自其他人的担忧不应该被误解为狭隘的、推测性的或不相关的。它们不是。 科技公司往往会通过在提出质疑或挑战其权力的人之间制造分歧,来削弱那些试图对其进行问责的人。 我很感激自己有能力和支持去做这件事,这在很大程度上要归功于 Daniel Kokotajlo 给的勇气。我也明白,在整个行业中,还有很多人无法做到这一点。 OpenAI 仍在开展许多重要工作,包括扩大访问权限、准备框架开发、增强信心的措施,以及解决我之前提到的担忧。我仍然对这些工作及其成功充满期待和投入。

历数 OpenAI「七宗罪」

Ⅰ 无视 AGI 风险,超级对齐分崩离析

至此,我们已经无法再用玩梗蒙蔽自己了。.

Ilya 等安全团队的人员离去,大概率跟 AGI 或者 GPT-5 都无关,而是被逼得走投无路。

自从 OpenAI 发生第一轮宫斗、Sam Altman 被罢免以来,整个 OpenAI 的情绪就不对劲了。

显然,Altman 在合作伙伴关系和产品重点方面的发展方向,已经超出了大多数人能接受的程度。

他的危险面目,随着时间线的推移,也越来越清晰地暴露出来。

Ⅱ 跟踪 GPU,随时撤销 GPU 许可证

而且,OpenAI 最近公布的 AI 治理计划,也掀起了轩然大波。

OpenAI 提出,将加密保护扩展到硬件层,实现以下属性——

1. GPU 可以通过加密方式验证其真实性和完整性。 2. 具有加密原语的 GPU 可以使模型权重保持加密状态,直到它们被暂存并加载到 GPU 上。这在主机或存储基础设施受到损害时,增加了重要的深度防御层。 3. 具有唯一加密身份的 GPU,可以为特定 GPU 或 GPU 组加密模型权重和推理数据。完全实现后,这可以使模型权重只能由属于授权方的 GPU 解密,并且可以允许推理数据从客户端加密到服务其请求的特定 GPU。

这些内容,无疑让人恐慌。

比如第一句:GPU 可以通过加密方式验证其真实性和完整性。

这也就意味着,如果我们从英伟达买一块 GPU,它会像 DRM 一样进行签名,从而被批准运行和加速 AI 模型。

假如一个小公司来购买硬件,现在就需要经过额外的层层审批,才能把自己的硬件推向市场,这无疑很可怕。

大概没有多少人希望自己的 GPU 是签名的,大家都会希望使用匿名的 GPU。

第二条也很诡异,必须每个硬件上都有签名,才能允许我们运行 AI,这简直是一件荒谬的事。因为如果上面有签名,他们也就可以撤销签名,谁有权决定呢?

第三条也是如此,模型权重只能由属于授权方的 GPU 解密,这个权力属于谁?

而其中这句话,也显示出 OpenAI 的重点在于保护模型权重,而非开源,或开放权重,这个观点已经与开源 AI 的大力支持者大相径庭了。

一名网友锐评道:这些关于安全和保障的很多想法,让我摸不着头脑,很多内容显示出,OpenAI 正在全力以赴地关注闭源架构,这让我更感激 Meta 这样的开源公司了。

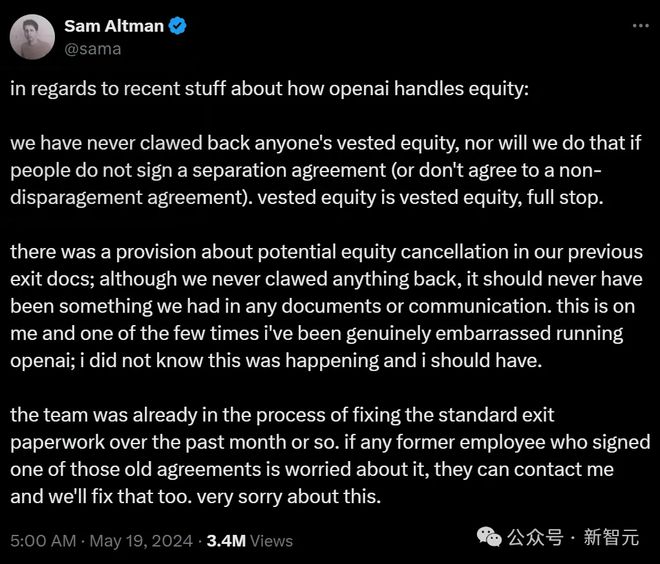

Ⅲ 签字逼迫员工放弃股权,事后装失忆

前几天此消息曝出:如果 OpenAI 员工在离职时拒绝签署要求严苛的协议,无法保证永不批评 OpenAI,那他们可能就会失去已有的 OpenAI 股权。

瞬间让科技圈炸锅。面对群情激愤的声讨,Altman 紧急发布道歉声明,表示自己从不知道 OpenAI 有威胁股权的条款,以后也不会这样做。

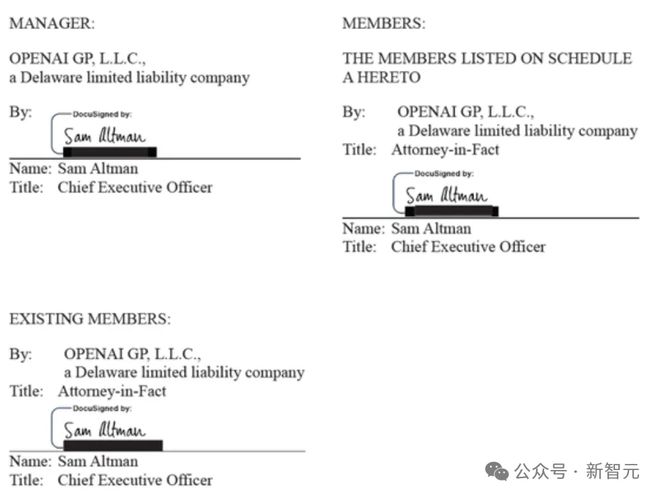

然而他随后就被打脸了,外媒扒出了更多内部协议。

这些文件显示,OpenAI 几乎拥有所有权利,可以任意将股权从前员工那里收回,或者阻止他们出售股权。

签署这些文件的,正是 Sam Altman,签署日期为 2023 年 4 月 10 日。

随后,更多霸王条款曝出。比如 OpenAI 发给离职员工一份冗长且复杂的终止文件,需要在七天之内签署完毕。

这意味着,前员工仅有一周的时间,去决定是否接受 OpenAI 的「封口费」,否则就会失去数百万美元股权。

而且,当前员工要求额外2-3 周的时间寻求法律援助并审查文件时,却遭到了 OpenAI 的强烈反对。

「The General Release and Separation Agreement」(概括性索偿弃权书和离职协议)需要你在 7 天内签署。我们希望确保你明白,如果你不签署,这可能会影响你的股权。这对每个人都是一样的,我们只是按规章办事」。

对此,加州的就业律师 Chambord Benton-Hayes 表示,「一家企业威胁收回已归属的股权是极其恶劣和不寻常的」。

然而,OpenAI 大多数前员工,却对这样的霸王条款屈服了。

而整件事最荒谬的,还是以 Altman 为首的 OpenAI 高管事后堂而皇之的装傻。

Ⅳ 和 News Corp 合作,ChatGPT 中也会有广告了

昨天,在一片乱中,OpenAI 依然官宣了和新闻集团 News Corp 的合作,并将之成为「里程碑意义的多年全球合作伙伴关系」。

根据协议内容,News Corp 的新闻内容都会引入 OpenAI。

OpenAI 有权显示相关媒体报头的内容,用来回答用户问题,目的是「让人们根据可靠的消息和新闻来源,做出明智的选择」。

News Corp 旗下的出版物,包括《华尔街日报》、《巴伦周刊》、《MarketWatch》、《投资者商业日报》、《FN》、《纽约邮报》、《泰晤士报》、《星期日泰晤士报》、《太阳报》等等。

对此,网友评价说:看这个名单就知道,OpenAI 选择了非常糟糕的合作方。

这些媒体一向把右翼宣传作为商业模式,引起政治讨论,使用一切必要的手段来推动叙事,甚至曾通过福克斯新闻否认 2022 年的总统选举。

甚至 News Corp 还曾卷入这样一起丑闻,涉嫌侵入 600 多人的手机,来获取情报。

从此,我们使用 OpenAI 的产品时,无可避免地会受到某些倾向的影响。

而且,以后 AI 聊天机器人的世界,也将到处充斥着广告。

不久前一份泄露的文件显示,OpenAI 计划在 GPT 聊天中,纳入品牌优先权。

根据文件,凡是加入该计划的公司,都会在 ChatGPT 等产品的聊天对话中获得优先权,品牌能够露出得更多,链接中也会更强调它们的内容。

而且通过 PPP,OpenAI 甚至还会向出版商提供许可的财务条款。

获得更丰富产品表达的公司,将拥有品牌悬停链接、锚定链接和内嵌处理。

悬停处理中,OpenAI 会在搜索查询的响应中,超链接关键字。这些链接会显示为蓝色文本,鼠标悬停在上面时,会显示可单击的选项卡。

在锚点处理中,ChatGPT 对用户查询响应的下方,会出现一个可点击的品牌化按钮。

内嵌产品则会在 ChatGPT 响应的文本中插入引文,字体更大,并且包含可点击的品牌链接。

总之,ChatGPT 从此会变成被商业广告操控的世界。

Ⅴ 和微软一起反对开源

开源和闭源之争中,OpenAI 已经联合微软正式下场,试图对政府施加影响了。

最近,由科技巨头、初创公司和风险投资家组成的联盟,正在花费数百万美元来说服华盛顿,让他们相信对 AI 世界末日的担忧被夸大了。

他们的行动已经产生了影响。他们的影响力网络在推动这样一种观点:与其说 AI 是一种生存威胁,不如说是一个重要的商业机会,绝不能让严格的安全措施,把美国的 AI 优势拱手让给他人。

华盛顿的游说格局,已成为一场由大量资金支持的、近乎哲学争论的战争。

微软和 OpenAI 这一派的观点是,提倡严格的安全限制和许可要求。严格的限制,显然对拥有最强大 AI 的公司是有利的。

而 Meta、IBM 等公司,更依赖于开源 AI 模型,而非 OpenAI、谷歌等追求的闭源框架,因此他们力图推动一种规则更少、更加开放的方法。

无论是 IBM 还是 Meta,都在开源斗争中投入了大量的游说资源。自从 2023 年中期的 AI 辩论爆发以来,IBM 为游说华盛顿投入了 400 万美元,Meta 则花费了超过 1700 万美元。

而 OpenAI,当然不希望这些开源既得利益者迎头赶上。

Ⅵ 泄露隐私,让人类过度依赖 AI

在上周的 OpenAI 大会上,技惊四座的 GPT-4o 所宣传的重点,显然被放在了情感依恋上。

然而,无论是开发高度情绪化的语音输出,还是通过声音读取某人情绪健康的能力,无疑都是潜在的危险方向。

据说,Ilya 是反对这一决定的。在他看来,除了学习说服之外,AI 学习语音方式并没有什么好处。

发布会上,GPT-4o 加持的 AI 语音助手,更加情感丰富,现场展示的幽默和害羞等特质,让它更像个人类。

与之相比,谷歌介绍 Astra 时,用的最多的词就是「助理」,这就明确显示了谷歌对于语音助手的定位。

显然,在 AI 助手这方面,OpenAI 的尝试更大胆,谷歌则更谨慎。

谷歌的态度,此前也有迹可循。此前它就一直在有意远离「Her」型的 AI。

上个月,Google DeepMind 的研究人员发布了一篇论文,详细阐述了拟人化人工智能的潜在弊端,称这类助手可能会重新定义「人类」和「其他」之间的界限。

论文地址:https://arxiv.org/pdf/2404.14068

而这,就可能会导致一些危害。例如用户会将重要的决策交给 AI,向 AI 透露敏感信息,或者在情感上过度依赖 AI 等等。

这样的结果,可能是灾难性的。毕竟,《Her》中描述的并不是一个 happy ending,更像是一个反乌托邦的未来。

显然,这个问题,并不在 OpenAI 的考虑范围之内。

Ⅶ 技术向军方开放

最后一件危险的事就是,今年 OpenAI 已经悄悄删除了针对「军事和战争」使用 ChatGPT 的禁令,因此,军方也可以使用 ChatGPT 技术了。

虽然目前看来,OpenAI 提供的任何服务都无法用于直接杀人,比如操控无人机或发射导弹,但他们可以增强许多相关的任务,比如写代码、处理采购订单。

有证据表明,美国的军事人员已经在使用 ChatGPT 加快文书工作,美国国家地理空间情报局已经公开考虑,使用 ChatGPT 来协助人类分析师。

要知道,OpenAI 一直和主要国防承包商微软合作密切,迄今为止,微软已经向 OpenAI 投入了 130 亿美元的巨资。

在当前的局势下,全世界的军队都渴望用 AI 技术来武装自己。

虽然 LLM 不可避免的幻觉,以及用 ChatGPT 分析机要信息或敏感数据可能会带来安全风险,但五角大楼的态度,仍然是渴望拥抱 AI。

在 11 月的一次讲话中,国防部副部长 Kathleen Hicks 表示,人工智能是「我和 Lloyd Austin 部长从第一天起,就一直在推动的以作战人员为中心的创新的关键部分」。

老将出走,员工炮轰,接下来的 OpenAI,会在「惯会说谎」的 Sam Altman 治下走向何方?

参考资料: