文华商韬略,作者 耿康祁

“人工智能之父”杰弗里·欣顿有个末日预言:人工智能可能对人类构成巨大威胁。因为,“很难找到防止坏人用它做坏事的方法”。

不幸的是,这一预言正成为现实。

高端局来了

一个跨国公司白领,一杯咖啡的功夫,就让公司损失了 2 亿港元。

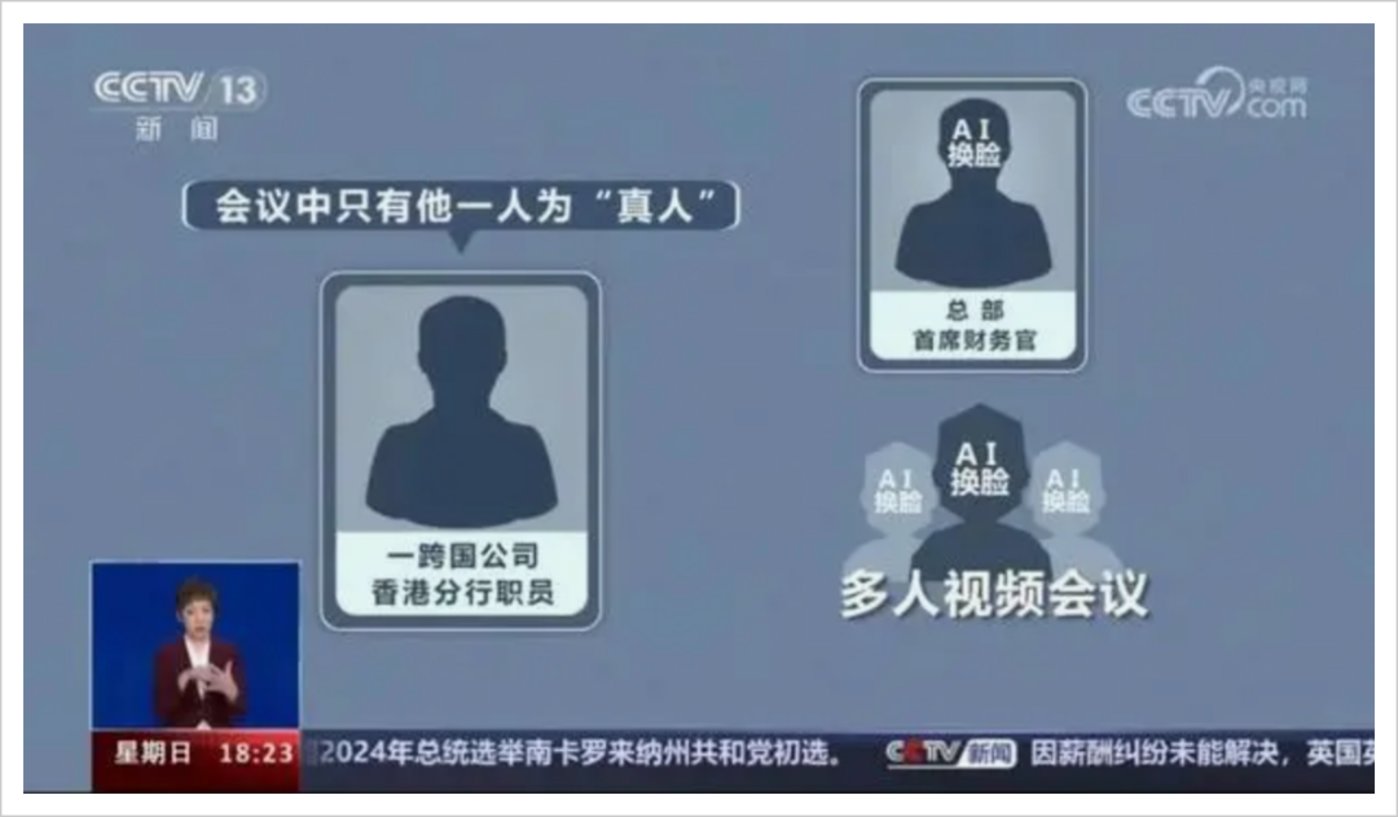

原因是,他被邀请参加了一场公司高管的视频会议,总部首席财务官在会上要求他马上给几个账户共转账 2 个亿,在其他同事的配合下,他当场就把事情办妥了。

但事实上,这场会议就是个骗局,整场视频会议的出席者,只有他一个“真人”!

这是香港警方近期披露的一起多人“AI 换脸”诈骗案。被诈骗职员亲眼见到的所有人、亲耳听到的所有声音,全都来自经过“AI 换脸、换声”的诈骗人员。

这位员工并非是没有警惕的“二愣子”。

最初收到英国总部 CFO 的邮件,称公司正在计划一个“秘密交易”,需要他将公司资金转到几个香港本地账户中待用时,他并没有相信,而且认为这是钓鱼诈骗邮件。

但当骗子给他拨了个视频电话,而且还邀请了其他几位“真实亲切”的同事在旁协助时,他彻底放下了戒备。

甚至,事件发生 5 天之后,他在向英国公司求证时才发现自己被骗了。

同样可怕的“遭遇”,也发生在福州市某科技公司法人代表郭先生身上。

2023 年 4 月 20 日,一位好友突然打了个微信视频:“老郭,我一个朋友在外地竞标,需要 430 万保证金。你看看能不能先走你的公司账户,帮忙过个账?”

好友说钱已打过来,还发了银行转账底单截图。

因为是视频聊天,郭先生就没核实钱是否到账,直接给对方账户转了 430 万。

事后,郭先生给好友打了电话,称“事情办妥了”,对方却惊讶回应完全没有这回事。

9 分钟,430 万没了!

坑了郭先生的,也是 AI 诈骗。

综合公开信息,这种让人防不胜防的骗局,一般分三步:

- 1. 不法分子用 AI 机器人骚扰电话,获取用来行骗的目标对象的声音素材,然后进行声音伪造;

- 2. 盗取目标对象的社交账号,寻找受害人;

- 3. 用 AI 换脸技术,和受害人视频通话,博取信任,实施诈骗。

三步下来,以往“发个语音”、“打个视频”的防诈手段,在 AI 诈骗面前基本失效。

更可怕的是,掌握 AI 的骗子,越来越多了!

公开信息显示,2021 年以来多个省份都出现了 AI 诈骗及不当牟利案件。中国互联网协会 2023 年 5 月 24 日称,利用“AI 换脸”“AI 换声”等进行诈骗、诽谤的违法行为屡见不鲜。

当传统认知里,受骗对象还多是经不起诱惑、社会经验少的“冤大头”,以及一些不常上网的老年人。

只要给几张照片和几秒语音,就能复刻出“真人”的 AI 诈骗,却让每个人都可能难逃一劫。

比如假扮大学同学、亲戚、供货商等 AI 视频借钱案件,就层出不穷。

如果觉得从不借钱便不会中招,就太天真了。

当骗子伪装成领导,以汇款、资金周转等紧急理由,要求下属立即转账,很少有人能顶住压力。更有甚者,骗子直接伪造子女、父母车祸入院等借口,利用亲人感情实施欺诈。

据湖北网警巡查执法公布消息,AI 技术新骗局诈骗成功率竟接近 100%,其成功率之高、涉案金额之大、诈骗速度之快令人咋舌。

更令人毛骨悚然的是,信息泄露、隐私不安全的普遍现实,为 AI 诈骗造就了“天然温床”。

2023 年 2 月 15 日,一则“几乎无人幸免,疑似 45 亿条电商或快递信息泄露”的消息,冲上热搜。有网友忍不住吐槽:“要有多强的防范意识,才能想到跟你视频通话的亲友,不是一个大活人啊?要有多强的隐私意识,才能保证自己信息不泄露或被窃取?”

微博大V@全民防诈骗,甚至因此预言:“你目前还没被骗,并不是因为你多聪明,也不是因为你没钱,而是适合你的‘剧本’还在路上。”

全球大爆发

2023 年 4 月末,一位叫詹妮弗·德斯特凡诺的美国母亲突然接到电话:“妈妈,救命!”

眼看大女儿布里安娜似乎陷入了大麻烦,詹妮弗吓呆了。

接下来便是对方威胁:

“如果你打电话报警,就永远别想再见到她了!”

挂断后,詹妮弗立马要给赎金。

幸运的是,女儿正好打来电话,骗局不攻自破。但心有余悸的她仍无比惊讶:

“就算隔一栋楼,我也不会认错自己孩子的哭泣声。”

詹妮弗想不到的是,突飞猛进的 AI 技术,早已比一个母亲更了解自己的孩子。而骗子支付的代价,可能还不到每月 5 美元。

2017 年,名为“Deepfakes”的网友,利用 AI 技术发布了将色情演员换脸成盖尔·加朵等名人的视频片段,引发轩然大波。

被称为“深度伪造”(Deepfake)的 AI 换声及换脸技术,自此进入大众视野。

一些从事类似诈骗的不法分子,立马盯上了这一先进技术。

2019 年 3 月,一诈骗犯借助连“微妙的德国口音”也毫无破绽的 AI 换声技术,冒充一家英国能源公司大老板,忽悠其高管转了 22 万欧元,这被视为全球首例人工智能诈骗案。

随后,AI 技术流行的欧美,迅速成为 AI 诈骗的温床。

美国联邦调查局年度报告显示,2022 年美国 AI 诈骗同比上涨了 50% 到 75%,美国网络诈骗损失达 103 亿美元,创五年来新高,面向老年人的 AI 语音骗局则是重灾区。

世界经济论坛研究与分析主管布鲁内曼的调查则显示,“在过去一年里,26% 的小公司和 38% 的大公司都经历过深度伪造欺诈”。她甚至预测:

到 2026 年,超 90% 的网络攻击内容都将是 AI 合成。

AI 诈骗的效果越来越逼真,但技术门槛和成本,却一直在降低。

美国加州大学伯克利分校教授法里德表示,AI 换声到现在已经只需要十几秒录音就能实现,换脸则一张照片就可以。相应的 AI 使用费,也只需每月 5 美元到数百美元不等。

这基本上意味着,普通人都能“轻松”进行不法活动。

而且,AI 还可以通过信息收集及大数据分析,智能筛选出“易骗人群”。比如进行金融诈骗,就可以搜集热衷关注投资信息的人群,成为潜在目标。

甚至,AI 还能分析目标对象的社交网络,进而掌握其个性化表达方式、人际关系、兴趣爱好等生活习惯,实现“诈骗剧本”定制化。

法里德因此惊呼:

“这很可怕,就像一场完美的风暴,具备了酿成大祸的所有条件。”

但尽管风险显而易见,AI 语音及视频合成技术却仍在狂奔。

今年春节期间,OpenAI 文生视频模型 Sora 横空出世,让 AI 视频制作更加简单、真实。一夜之间,“现实不存在了”的惊叹,刷遍朋友圈。

当 AI 签名、AI 视频、AI 换声换脸等,本应创造美好和便利的高端技术变成坏人手中的“魔杖”,无数人和机构的财产、信息及现实安全,也越来越形同“裸奔”。

没有真相的时代

“现在已经到了大规模、集中化讨论 AI 风险的关键时刻”,清华大学教授沈阳曾如此呼吁。

其实,对 AI 诈骗的警惕与治理方案,早已在路上。

美国安全中心发布的《人工智能与国家安全》,明确将人工智能伪造技术列为威胁国家安全的重点技术。中国也开始通过政策管理和技术限制等途径,来应对其潜在安全风险。

但 AI 诈骗,似乎是打不死的“小强”——打击不断升级,案件也屡创历史新高。

根本原因,还是法律法规制定、推广的建设速度,赶不上 AI 技术的迭代和传播速度。产业、大众对 AI 危害的反应,也很容易慢半拍。

如今,AI 骗局也早已超出“诈骗”范畴,蔓延到社会的各个角落。

今年 1 月底,明星泰勒·斯威夫特大量 AI“不雅照片”在社交平台上传播,此事甚至震动美国白宫,并掀起一波关于人工智能的担忧。

包括白宫,也难以幸免。

上周,很多人都接到了美国总统拜登的 AI 电话呼叫,要求把选票留给自己而非特朗普。

这当然也是假的,但不少人还是信了。有人因此认为,AI 骗局可能会影响美国大选。

在中国,假新闻、假图片案件也甚嚣尘上。

2023 年 5 月,科大讯飞就受一篇名为《科大讯飞出现重大风险的警示文》的文章影响,股价迅速跳水。公司最后紧急回应,股价下跌系某生成式 AI 写作虚假“小作文”导致。

AI 越来越方便着人们的生活,但也方便着不法分子们。

2023 年 4 月 13 日索尼世界摄影奖颁奖礼,大奖得主却冲上舞台夺过话筒,悲愤地说这是 AI 伪作。他反问,“如果索尼世界摄影奖的评委都分不清真假照片,其他人还能怎么办?”

当 AI 骗局从专业级走向“平民化”,我们能做的,除了寄望于监管,或许就是:

对家人的电话,视频等等一切,都要首先报以深深地怀疑。以及把那句,不给任何陌生人汇款变成:

不给任何人汇款。

参考资料

- [1]《AI 换脸风暴:骗局、产业与技术防守》36 氪

- [2]《“AI 换脸”诈骗,怎么防?》人民日报

- [3]《警惕!美国发生多起 AI 语音诈骗案件,联邦机构将加强监管》第一财经