机器之心发布

火遍抖音的「卡通脸」特效,是怎么做到又逼真又灵动的?

说到特效玩法,抖音的 “整活儿” 能力一直有目共睹。最近,风头正劲的是一款「卡通脸」特效。无论男女老少,用上这款特效后,都仿佛从迪士尼动画里走出来的人物一样灵动可爱。「卡通脸」一经上线,在抖音上迅速发酵,深受用户喜爱,“一键变身高甜卡通脸 ”“全抖音的在逃公主都来了”“用卡通脸花式晒娃 ”“王子公主撒糖手势舞”“捕捉童话魔法失灵瞬间” 等相关热点不断衍生,其中,“全抖音的在逃公主都来了”“捕捉童话魔法失灵瞬间” 更是登上了抖音全国热点榜。目前,这一特效的使用人数已经超过 900w。

「卡通脸」属于 3D 风格特效,这类特效的研发难点主要集中在多样性的 CG 训练数据不易获取、灵动的表情神态难以还原、真实贴合的立体肤质光影难以实现、夸张强风格的五官形变 GAN 不易学习等多个方面。对此,字节跳动智能创作团队在 3D 风格化方向重点突破优化,不仅解决了上述所有难题,还沉淀了一套通用的技术解决方案。

「卡通脸」背后的研发流程创新

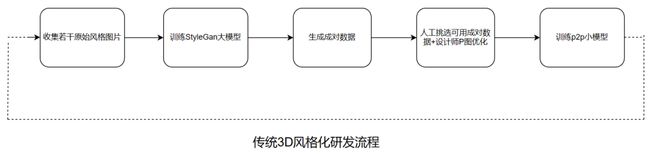

过去,一个完整的 3D 风格化研发流程分为以下几个模块:

搜集若干原始风格图片 -> 训练 StyleGan 大模型 -> 生成成对数据 -> 人工挑选可用成对数据 + 设计师 P 图优化 -> 训练 p2p 小模型,然后不停反复。

传统的研发流程的问题非常明显:迭代周期长,设计师可参与度弱,且不易于沉淀和复用。

在「卡通脸」这个特效的研发中,字节跳动智能创作团队采用了创新的研发流程:

从设计师制作目标风格效果开始,设计师按照算法约定的要求提供一些 3D 美术素材,然后字节跳动智能创作团队借助 DCC 软件批量渲染若干多样性的 CG 数据,在渲染过程中技术团队首次引入时下最火的 AIGC 技术对数据做了增强处理,之后用 GAN 合成训练所需的成对数据,最后采用自研的形变 pix2pix 模型训练就可以得到最终效果。

字节跳动智能创作团队「卡通脸」的研发流程图

从流程链路可以看出,这一方法大大缩减了迭代周期,提高了自动化程度,也让设计师有更高的参与度,实践显示,创新的工程链路将迭代周期从 6 个月缩减至 1 个月,方案也更易于沉淀和复用。

「卡通脸」特效是怎么设计出来的

如今在社交媒体上有越来越多的变身特效,人们越来越注重特效的美观性和精确度,为了让用户更好地实现风格化变身的效果,抖音特效的设计师们经过精心研究,结合了热门动画画风,创新地设计了一套卡通脸特效,让用户可以体验到动画般灵动的角色风格,同时满足了用户的变美变帅需求。

抖音特效设计师针对目前市场上现有的变身特效进行了深入研究,发现现有的特效存在风格不够吸引人、表情夸张度不足、灯光效果不够真实等问题。因此,抖音特效设计师结合国内审美,重新设计了卡通脸的画风,将男女面部比例特征夸张化,重构成可爱圆脸五官灵巧的 “女孩” 和硬朗长脸五官帅气的 “男生”。在这一过程中,设计师保留了用户本身的头发,增强了头发的蓬松感及光泽度,使其与卡通脸的融合更加自然,卡通质感的皮肤也融入了用户本人皮肤的细节,使特效更具有用户的个性特征。

此外,抖音特效的设计师还定义了不同灯光下的光影质感,满足复杂场景下的灯光还原的需求,使卡通脸更加立体且自然,融入日常自拍无违和感。最后,设计师还制作了夸张符号化的面部表情,通过对数字人资产采用面部捕捉技术生成表情 CG 数据,不断完善训练数据和算法,产出了能够更加灵动展现用户个性的表情效果。

自建 CG 合成数据流,高质量训练数据可复用

3D 风格类特效的训练数据来源依赖高质量的 CG 渲染数据,且对数据分布的多样性要求比较高,同时 3D 资产手动建模也是一个非常耗费人力的过程,可复用性也不足,往往一个项目花费了昂贵的人力时间成本制作了一批 3D 资产,在项目结束后就完全废弃了。

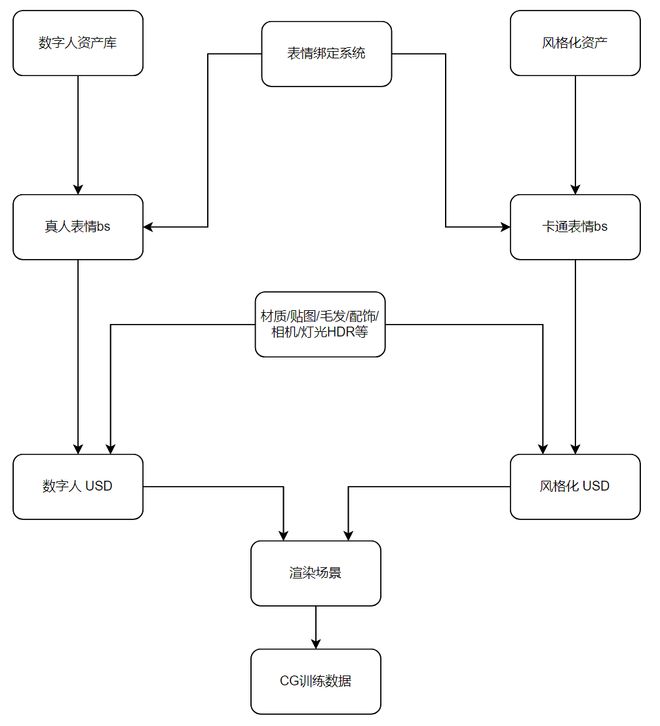

此次,字节跳动智能创作团队搭建了一套通用易扩展的 CG 合成数据工作流。

字节跳动智能创作团队 CG 合成数据流的流程图

这一合成数据流的工作流程如下:

1. 通过 Houdini 程序化的生成数字资产,程序化捏脸,绑骨,调整权重等,建立真实感数字人模型资产库。

多样性 3D 数字资产

2. 通过 Houdini 的 Solaris 构建 USD 模板,将头发,毛发,头模,服饰,表情系数等资产分别以 USD reference 导入。

皮肤贴图样本

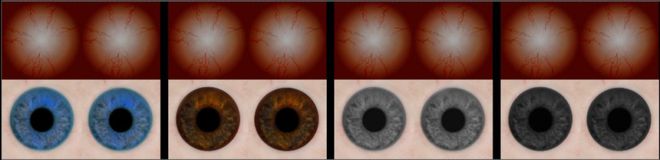

虹膜贴图样本

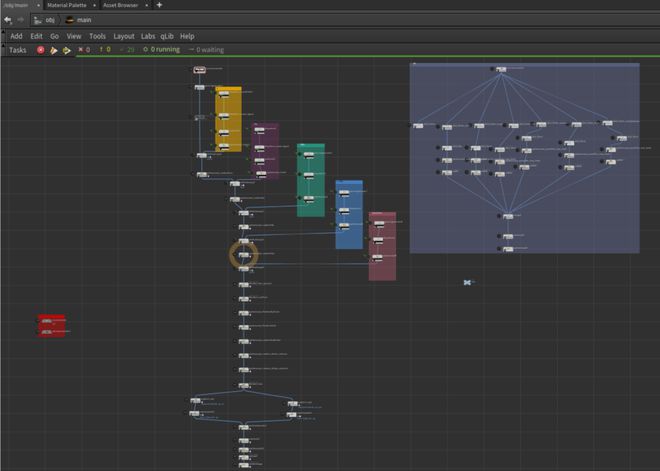

3. 通过 Houdini 的 PDG 对资产,相机角度,灯光环境等进行随机组合。利用 PDG 对 workitem 的控制,精准的控制数据分布。

自动化的 PDG 节点图

由于研发过程需要频繁提供大量的渲染数据用于效果迭代,这需要花费大量算力成本以及渲染等待时间。此前,抖音的「魔法变身」特效上,团队曾花费了数百万成本使用外部农场用于数据渲染。而在「卡通脸」特效上,团队基于字节跳动旗下云平台火山引擎扎实的基础设施,大大降低了算力成本。

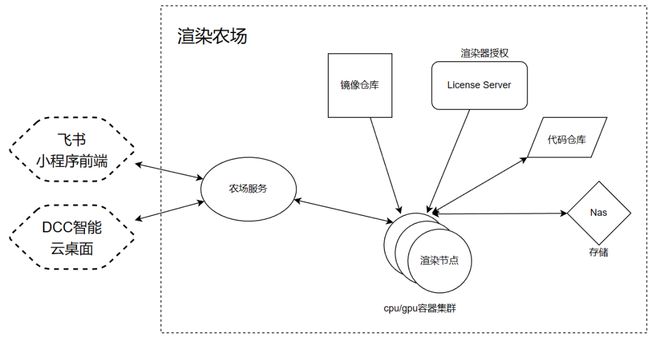

字节跳动智能创作团队参考影视工业的流程,搭建了一套自研的渲染农场平台。它可以将离线任务拆解到若干个渲染机器上进行并行处理。通过火山引擎镜像平台进行镜像托管、资源池化平台进行资源申请与释放、cpu/gpu 集群进行容器动态扩缩容,再使用 nas 进行资产管理,渲染农场具备了一键扩充数千个渲染节点进行高效计算的能力。

基于此,字节跳动智能创作团队自定义了单任务处理逻辑,包括前处理、引擎渲染、后处理等步骤。并根据需要,在任何时候动态扩展 / 缩小集群规模以最大化利用算力资源。

为了进一步提高效率,让设计师更方便参与到效果优化中,技术团队还制作了飞书小程序供设计师使用,通过飞书触发云端的自动化流程来迭代美术效果,在云端任务完成后,会发送消息回到飞书供设计师查看,大大提高了设计师工作的效率。

同时,字节跳动智能创作团队自定义了事件驱动(EventTrigger)和 Api 来打通农场、飞书平台以及云桌面平台,最大程度推进 All in one 理念,让设计师和工程师都能基于飞书和云桌面更方便地完成协同研发。

自研的渲染农场平台

AIGC 新技术的应用

随着 DALL・E 的问世,2021 年初字节跳动智能创作团队就开始了相关技术的跟进和规划,字节跳动智能创作团队在 Stable Diffusion 开源模型的基础上,构建了数据量达十亿规模的数据集,训练出两个模型,一个是通用型的模型 Diffusion Model,可以生成如油画、水墨画风格的图片;另外一个是动漫风格的 Diffusion Model 模型。

前不久,由字节跳动智能创作团队支持的「AI 绘画」特效在抖音上大火,采用的就是这一新技术。此次在抖音「卡通脸」上,技术团队进一步挖掘 Diffusion Model 在 3D 卡通风格上的生成能力,采用了图片生成图片的策略,首先对图片进行加噪,然后再用训练好的文生图模型在文本的引导下去噪。基于一个预训练好的 Stable Diffusion 模型,输入 GAN 生成的与真人图相匹配的目标 3D 风格结果图,通过精调过的一组文本关键词,引导目标风格往期望的方向靠近,Stable Diffusion 输出的结果即作为最终数据交给后续的 GAN 模型学习。

自研的形变 GAN 模型

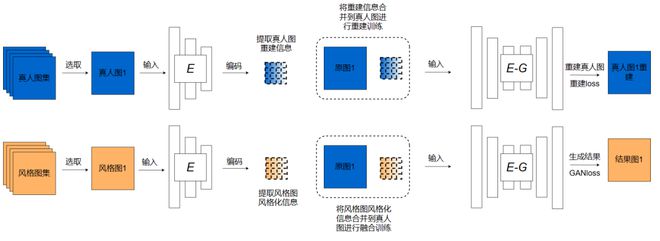

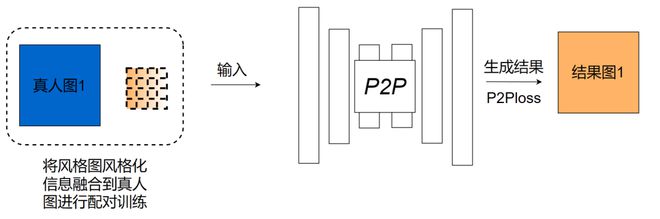

由于抖音「卡通脸」的目标风格与原始人像相比有较大形变,直接用传统 p2p 框架难以训练出高质量效果,字节跳动智能创作团队自研了一套 p2p 形变 GAN 训练框架,对于训练大形变、强风格的卡通目标有很好的效果。字节跳动智能创作团队自研的形变 GAN 训练框架包含两个部分:

1、风格化初步训练,提取卡通脸风格化信息。技术团队构建了一个风格化信息交互融合的非配对训练框架,将真人和卡通脸数据集输入到该框架就可以提取卡通脸风格化信息。该框架是一个端到端的训练框架,包含了风格化特征编码、特征融合、重建训练和风格化初步训练,训练完成后得到一个卡通脸风格化信息,用于下一步精细化训练。

2、融合卡通脸风格化信息,精细训练。由第一步得到的卡通脸风格化信息包含了风格和形变等信息,将这部分信息融合到真人图进行精细化训练,利用 p2p 相关的强监督 loss 进行配对训练,训练收敛后得到卡通脸模型。

基于以上创新的技术方案,抖音「卡通脸」不仅简化了工程链路、大幅提升迭代效率,还在大角度、表情丰富度、效果风格还原、光影一致性和多肤色匹配等方面取得了明显的优化效果。据了解,负责「卡通脸」项目的字节跳动智能创作团队自 2021 年以来就在 3D 风格化方向重点突破优化,该技术方案已支持多款 3D 风格特效取得平台爆款的成绩。

关于字节跳动智能创作团队:

智能创作团队是字节跳动 AI & 多媒体技术中台,通过建设领先的计算机视觉、音视频编辑、特效处理等技术,支持抖音、剪映、头条等公司内众多产品线;同时通过火山引擎为外部 ToB 合作伙伴提供业界前沿的智能创作能力与行业解决方案。