新智元报道

编辑:倾倾

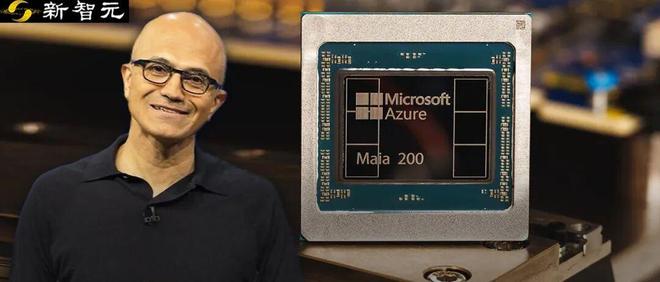

噩梦成真!微软 Maia 200 正式杀进数据中心,左手 3nm 自研芯,右手 Triton,照着老黄的大动脉砍。当头号金主爸爸摇身一变成了头号死敌,这场千亿美金的算力大逃杀,微软不光为了省钱,更是要革了 CUDA 的命。

老黄的噩梦成真了!2026 年 1 月 26 日,微软数据中心(爱荷华)一声巨响,黄仁勋的后背瞬间凉透。

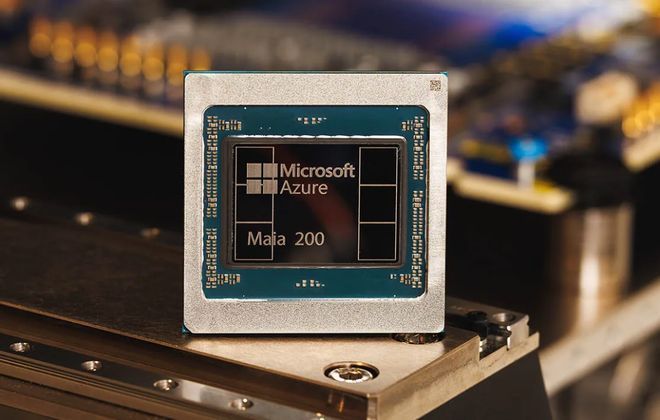

微软正式官宣:第二代自研 AI 芯片 Maia 200 上线!

这哪里是发新品?这分明是全球最大买家对卖家的背刺。

当全世界还在卷 HBM 显存大小的时候,微软反手就是一个「降级打击」,用更务实的内存架构,切开了英伟达最骄傲的护城河。

特洛伊木马:OpenAI 递给微软的刀

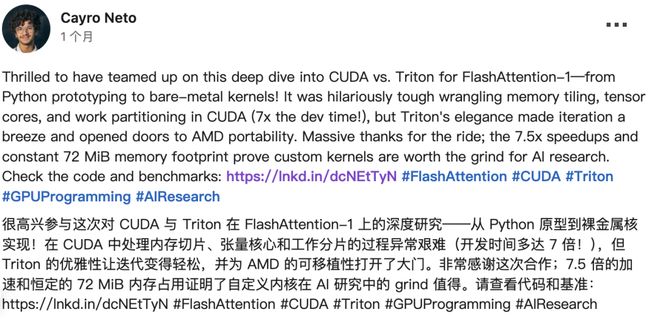

表面看,Maia 200 是一块台积电 3nm 工艺的硬核硅片;但让老黄睡不着觉的,是随芯片捆绑发布的软件核武:Triton。

在芯片圈,有一条心照不宣规则:硬件决定下限,软件决定上限。

英伟达十年无敌,全靠 CUDA 锁死开发者——换芯片?代码重写能废掉半个团队。

微软这次祭出的 Triton,核心开发者正是英伟达的好基友——OpenAI。

开发者实测,在 Transformer 注意力内核等场景,代码量比 CUDA 减少 75-90%,性能媲美甚至局部超 CUDA 5-37%。

微软直接喊话:开发者,来吧,无痛迁移!

测试代码:https://github.com/leandrolcampos/flash-attention/

更狠的是,Meta 和 Google 也在后面递刀子。2025 年底 Google 与 Meta 合作TorchTPU,目标 2026 年把 CUDA「柏林墙」彻底推倒。

如果 Maia 200 是廉价引擎,Triton 就是傻瓜式自动驾驶系统。

当写代码不再求着 CUDA,英伟达那个万亿市值的软件税,基本上就收到了头。

为什么能反杀?

答案藏在参数表里:Maia 200 塞满了 272MB on-chip SRAM。

大模型训练拼带宽,推理拼响应速度。亿级用户同时调戏 ChatGPT,瓶颈早不是带宽,而是毫秒级延迟。

对此,微软的解法简单粗暴:在芯片里塞爆 SRAM,思路直接致敬 Cerebras 和 Groq。

结果,Maia 200 单次 Token 生成经济性大幅提升,官方宣称性能比现有硬件高 30%——同价位下,推理成本更低,效率更高。

老黄的 Blackwell 还在卖高价堆料,Maia 200 专为「特化打击」而来。

在开发者眼里,它也许不是绝对最快,但绝对最便宜。

塑料友谊正式破裂

微软和 OpenAI 看似恩爱,实则早已同床异梦。

Maia 200 发布前夜,OpenAI 甩出一张 100 亿美金的采购单,接盘的竟然不是微软,而是 Cerebras!

OpenAI 理所当然地表示:

我们追求算力多样化,避免任何供应商成单点故障。

这波操作,让微软尴尬,也让英伟达感受到前所未有的生存危机。

为了补推理短板,英伟达甚至紧急从 Groq 许可技术,试图续命。

这波四方博弈简直是硅谷版《甄嬛传》:

· 微软:砸钱 OpenAI,同时疯狂造芯搞「去 OpenAI 化」;

· OpenAI:吃微软的饭,砸英伟达的锅,还偷偷给第三方送钱;

·英伟达:眼看大客户造反,被迫花 200 亿买 Groq 技术防身;

· Google/Meta:蹲在旁边磨刀,随时准备趁乱分一杯羹。

Maia 200 的上线,本质上就是微软的「财产公证」。对于纳德拉来说,最好的盟友不是 Sam Altman,而是那块成本可控的 3nm 硅片。

纳德拉 9600 万美金的「对赌协议」

技术吹得再牛,在华尔街眼里也是生意。

Maia 200 能不能成,直接决定了纳德拉今年能不能拿到那 9650 万美金 。

对于 4 万亿市值的巨兽来说,省钱=赚钱。

微软每跑一块 Maia 芯片,对英伟达的依赖就少一分,毛利就多一成。

这根本不是技术竞赛,这是打工皇帝的钱包保卫战。纳德拉绝对不甘心让微软变成帮黄仁勋卖铲子的「长工」。

微软 2025 年在 AI 基础设施上的资本开支预计将突破 800 亿美元。

这意味着,微软每向英伟达支付 1 美元的租金,其利润率就会被削薄一层。

在 4 万亿市值的盘子里,哪怕是1% 的降本增效,都意味着数百亿美元的估值溢价。

在 3 纳米的晶圆背后,跳动的是纳德拉对「算力主权」的野心——他绝对不甘心让微软成为帮黄仁勋卖铲子的「长工」。

从「训得快」到「回得快」

AI 算力圈彻底变天

随着 Maia 200 诞生,AI 算力圈变天了。

前两年比的是大炼模型,谁卡多谁牛X;2026 年比的是极速降本,谁便宜谁赢。

英伟达靠 CUDA+HBM 赢了上半场,但推理时代,Maia 200 正在把高溢价底裤一点点扒下来。

Google TPU、Amazon Inferentia、Cerebras 都在抢滩登陆,谁能把算力从奢侈品变自来水,谁就能赢。

黄仁勋曾说,CUDA 是英伟达最深的护城河。但现在,水被抽干,露出了底部的淤泥。

当全网最强买家不再愿意支付信仰税,那个靠卖铲子躺赚的时代,彻底寄了。

Maia 200,它告诉我们一个真理:

在绝对的资本意志面前,没有永远的护城河,只有嫌你太贵的生意人。

参考资料: