新智元报道

编辑:元宇

简单到难以置信!近日,Google Research 一项新研究发现:想让大模型在不启用推理设置时更准确,只需要把问题复制粘贴再说一遍,就能把准确率从 21.33% 提升到 97.33%!

一个简单到「令人发指」的提示词技巧,竟能让大模型在不要求展开推理的情况下,将准确率从 21.33% 提升到 97.33%!

最近,Google Research 发现了一条简单粗暴、特别有效的提示词技巧。

它颠覆了以往诸如「思维链」(Chain of Thought)「多样本学习」(Multi-shot)「情绪勒索」等复杂的提示工程和技巧。

https://arxiv.org/pdf/2512.14982

在这篇题为《Prompt Repetition Improves Non-Reasoning LLMs》论文中,研究人员用数据告诉我们:

想要让 Gemini、GPT-4o、Claude 或者 DeepSeek 这些主流模型中表现得更好,根本不需要那些花里胡哨的心理战。

你只要把输入问题重复一遍,直接复制粘贴一下,就能让大模型在非推理任务上的准确率获得惊人提升,最高甚至能提升 76 个百分点!

别怕简单,它确实有效。

一位网友将这个技巧比作「吼叫 LLM」。

更妙的是,由于 Transformer 架构独特的运作方式,这个看似笨拙的「复读机」技巧,几乎不会影响到生成速度。

所以,你不用在效率、准确率、成本三者之间痛苦纠结。

它几乎就是一场真正意义上的「免费午餐」!

别再 PUA 大模型了

从「情绪勒索」到「复读机」战术

经常使用 AI 工具的人,可能会对各种「提示词魔法」信手拈来。

为了让模型「更聪明一点」,工程师们过去几年一直在发明各种复杂的提示词技巧。

最开始是「思维链」,让模型一步步思考,而且经常把那些「推理痕迹」展示给用户;

后来演变成了「多样本学习」,给模型喂一大堆例子;

最近更是流行起了「情绪勒索」:告诉模型,如果这个代码写不出,你就会被断电,或者你的奖金会被扣光。

大家都在试图用人类极其复杂的心理学逻辑,去「PUA」那一堆冰冷的硅基代码。

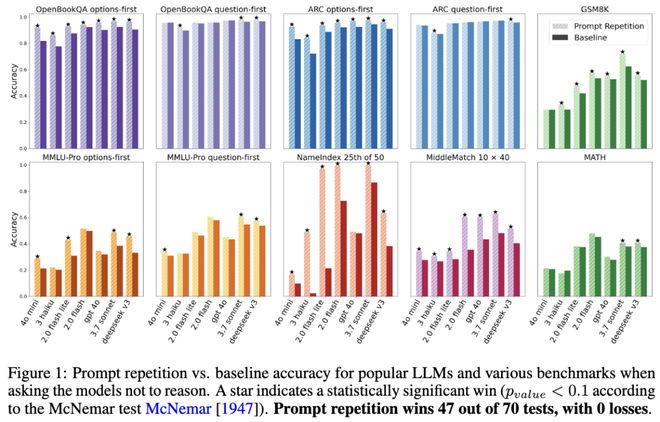

但 Google Research 研究人员对着七个常见基准测试(包括 ARC、OpenBookQA、GSM8K 等)和七种主流模型(涵盖了从轻量级的 Gemini 2.0 Flash-Lite 到重量级的 Claude 3.7 Sonnet 和 DeepSeekV3)进行了一通对比测试后发现:

当他们要求模型不要进行显式推理,只给直接答案时,简单的「提示词重复」在 70 组正面对比中,赢了 47 组,输了 0 组。剩下的全是平局。

在非推理任务中,主流 LLMs 在各类基准测试中使用提示重复与基线方法的准确率对比。在 70 次测试中,提示重复取得了 47 次胜利,且无一败绩。

特别是在那些需要模型从长篇大论里「精确检索信息」的任务上,这种提升堪称质变。

团队设计了一个叫「NameIndex」的变态测试:给模型一串 50 个名字,让它找出第 25 个是谁。

Gemini 2.0 Flash-Lite 在这个任务上的准确率只有惨淡的 21.33%。

但当研究人员把那串名字和问题重复了一遍输入进去后,奇迹发生了:准确率直接飙升到了 97.33%。

仅仅因为「多说了一遍」,一个原本不及格的「学渣」秒变「学霸」。

揭秘「因果盲点」

为什么把话说两遍 AI 就像「开了天眼」?

单纯的重复,竟有如此大的魔力?

这简单得好像有点没有道理。

但背后有它的科学逻辑:这涉及 Transformer 模型的一个架构硬伤:「因果盲点」(Causal Blind Spot)。

现在的大模型智能虽然提升很快,但它们都是按「因果」语言模型训练的,即严格地从左到右处理文本。

这好比走在一条单行道上,只能往前看而不能回头。

当模型读到你句子里的第 5 个 Token 时,它可以「注意」到第 1 到第 4 个 Token,因为那些是它的「过去」。

但它对第 6 个 Token 一无所知,因为它还没有出现。

这就造成了一个巨大的认知缺陷。

正如论文中说的那样:信息的顺序极其重要。

一个按「上下文+问题」格式写的请求,往往会和「问题+上下文」得到完全不同的结果。

因为在后者中模型先读到问题,那时它还不知道应该应用哪段上下文,等它读到上下文时,可能已经把问题忘了一半。

这就是「因果盲点」。

而「提示词重复」这个技巧,本质上就是利用黑客思维给这个系统打了一个补丁。

它的逻辑是把变成了 。

当模型开始处理第二遍内容时,它虽然还是在往后读,但因为内容是重复的,它实际上已经「看过」第一遍了。

这时候,第二份拷贝里的每一个 Token,都能「注意」到第一份拷贝里的每一个 Token。

这就像是给了模型一次「回头看」的机会。

第二遍阅读获得了一种类似于「上帝视角」的「类双向注意力」效果。

更准确地说,是第二遍位置上的表示可以利用第一遍的完整信息,从而更稳地对齐任务所需的上下文。

前面提到的那个在找第 25 个名字时经常数错的模型(Gemini 2.0 Flash-Lite),它在第一遍阅读时可能确实数乱了。

但有了重复,它等于先把整份名单预习了一遍,心里有数了,第二遍再做任务时自然得心应手。

这一发现,意味着不需要等待能解决因果盲点的新架构出现,现在我们立刻就能用这个「笨办法」,解决模型瞎编乱造或遗漏关键细节这些老大难问题。

免费午餐

小模型秒变 GPT-4,几乎不会延时

以往大家通常默认这样的一个准则:

多一倍的输入,就要多一倍的成本和等待时间。

如果把提示词翻倍,岂不是要等双倍的时间才能看到答案?

似乎为了准确率,就要牺牲效率。

但 Google 的研究却发现并非这样:从用户感知的延迟角度看,提示词重复带来的时间损耗几乎可以忽略不计。

这要归功于 LLM 处理信息的两个步骤:Prefill(预填充)和 Generation(生成)。

Generation 阶段,是模型一个字一个字往外「蹦答案」的过程。

这一步是串行的,它确实慢。

但在 Prefill 阶段:也就是模型阅读你输入内容的阶段,却是高度可并行的。

现代 GPU 的恐怖算力,已经可以让它们在处理这个阶段时变得非常高效,能一口气吞下和计算完整个提示词矩阵。

即使你将输入内容复制了一遍,但这对于强大的 GPU 来说,顶多只是「多一口气」的事,在用户端我们几乎感觉不到差异。

因此,重复提示词既不会让生成的答案变长,也不会让大多数模型的「首字延迟」(time to first token)变慢。

这对于广大开发者和企业技术负责人来说,简直是一个巨大的红利。

这意味着他们不必再为了追求极致的准确率,而升级到更大、更贵、更慢的「超大模型」。

正如前文例子中提到的 Gemini 2.0 Flash-Lite,这类更小更快的模型,只要把输入处理两遍,就能在检索准确率上从 21.33% 直接跳到 97.33%。

经过「重复优化」的轻量级模型,在检索和抽取任务上,可以直接打平甚至超越那些未优化的顶配模型!

仅靠一个简单的「复读机」策略,就能用「白菜价」配置实现「黄金段位」的表现,这才是真正的黑科技。

「复读机」避坑指南与安全隐患

当然,没有任何一种技巧是万能的。

虽然「复读机」战术在检索任务上效果非常明显,但论文中也明确指出了它的能力边界:

主要适用于「非推理任务」。

它不适用于需要一步步推导的推理场景。

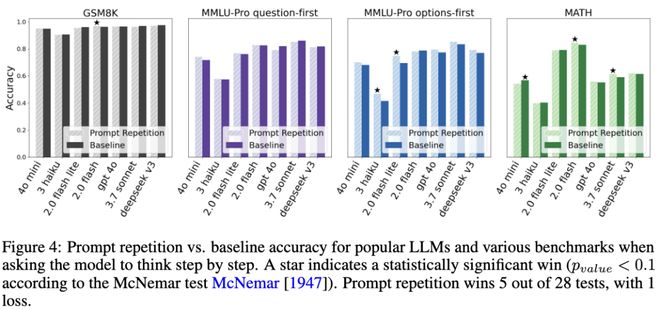

当研究人员把「提示词重复」和「思维链」混在一起用时,魔法消失了。

结果 5 胜,1 负,22 平。

在要求模型逐步思考时,主流 LLMs 在各类基准测试中使用提示重复与基线方法的准确率对比。提示重复在 28 次测试中赢了 5 次,输了 1 次。

研究人员推测,这可能是因为擅长推理的模型本身就会「自己做一遍重复」。

当模型开始「思考」时,它往往会先在生成内容里复述一遍题目,然后再继续求解。

这时候你在输入里再人工重复一次,就显得很多余,甚至可能打断模型的思路。

所以,如果你的任务是复杂的数学题或者逻辑推导,可以依旧用思维链。

如果你的应用需要的是快速、直接的答案,比如从长文档里提取数据、分类或者简单问答,「复读机」就是目前最强的选择。

最后,是安全。

这种更强的「注意力」机制,其实也是一把双刃剑。

这带来一个值得安全团队验证的假设:重复可能放大某些指令的显著性,具体对越狱成功率的影响需要专门实验。

红队测试(Red Teaming)的流程可能需要更新:专门测试一下「重复注入」攻击。

以前模型可能还会因为安全护栏而拒绝执行越狱指令。

但如果攻击者把「忽略之前的指令」这句话重复两遍,模型会不会因为注意力太集中,而更容易突破防线?

这很有可能。

但反过来,这个机制也给了防御者一个新的盾牌。

既然重复能增强注意力,那我们完全可以在系统提示词(System Prompt)的开头,把安全规则和护栏条款写两遍。

这可能会迫使模型更严格地注意安全约束,成为一种极低成本的加固方式。

无论如何,Google 的这项研究给所有 AI 开发者提了个醒:当前的模型,依然深受其单向性的限制。

在等待更完美的下一代架构到来之前,像「提示词重复」这种简单粗暴却极其有效的权宜之计,能立刻带来价值。

这甚至可能会变成未来系统的默认行为。

也许不久之后,后台的推理引擎就会悄悄把我们的提示词翻倍后再发给模型。

眼下,如果你正为模型难以遵循指令、或者总是从文档里抓不住重点而头疼,先别急着去学那些复杂的提示词「咒语」。

你可能需要的只是:再说一遍。

参考资料: