快科技 12 月 22 日消息,对高算力无限渴求的 AI 时代,最关键的已经不是单卡性能,而是尽可能高效地堆叠足够多的加速卡,构成庞大的集群。

除了 NVIDIA、AMD,国产厂商也正在这方面全力突破,华为、摩尔线程、中科曙光等都是突出代表。

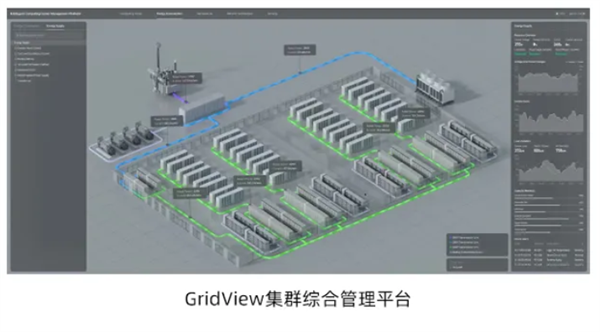

近日,中科曙光正式发并展示了 scaleX 万卡超级群,这也是国产万卡基 AI 集群的首次真机亮相。

不同于华为封闭式的全自研集群,中科曙光 scaleX 万卡超集群旨在构建开放、兼容、高密度的超大规模算力基础设施。

它支持多品牌加速卡、主流计算生态,已经适配优化 400 多个主流大模型、世界模型等,可用于大模型训练、金融风控、地质能源勘探、科学智能等各种场景。

中科曙光 scaleX 万卡超集群由多个 scaleX640 超节点(单机柜 640 卡)、scaleFabirc 高速网络互连而成,总计拥有 10240 块加速卡,总算力超过 5EFlops (500 亿亿次每秒)。

HBM 内存总容量超过 650TB,总带宽超过 18PB/s;片间互连总带宽超过 4.5PB/s,柜间互连总带宽超过 500TB/s。

单个超节点的基本构成是千卡级计算单元,采用“一拖二”高密架构设计,实现单机柜 640 卡超高速一致性互连,双计算柜则组成 1280 卡计算单元。

散热方面,采用超高速正交架构、超高密度刀片、浸没相变液冷、高压直流供电等多技术融合创新设计,成为业界超高集成度的液冷超节点。

全浸没式相变液冷技术,将服务器完全浸在特制液体中,中间液体冷凝换热装置 CDM 的散热能力高达 1.72MW (兆瓦)。

单机柜算力密度相比业界其他超节点最大提升 20 倍,PUE 值低至 1.04。

公开信息显示,中科曙光子公司曙光数创拥有 139 项液冷相关专利,是国内唯一实现大规模商业化液冷部署的企业。

网络方面,中科曙光自研的 scaleFabric 网络芯片可提供 400Gb/s的超高带宽、低于 1 微秒的端侧通信延迟、260ns 的交换芯片转发延时,超节点间的通信性能达到业内先进水平,相比传统的 InfiniBand 网络提升 2.33 倍。

基于面向大规模组网优化的网络协议、超高交换容量的网络芯片、极致的链路可靠性优化,集群规模得以扩展到 10 万卡以上,同时网络总体成本降低 30%。

优化方面,超级隧道设计实现了芯片级、系统级、应用级的三级协同优化,通过 BurstBuffer、XDS 等技术,大模型训推效率提升 30-40%,GPU 利用率提升最多 55%,同时还有 AI 应用亲和、AI 数据加速。

可靠性方面,一体化、智能化的集群管控,可大大提高 MTBF (平均故障间隔时间)、降低 MTTR (平均故障修复时间),集群长期可用性达到 99.99%,平均每 30 天的不可用时间小于 4 分钟。