刚刚,创下日本估值新高的 AI 初创公司诞生了!

它就是 Sakana AI,由 Transformer 论文八子之一创办,老黄的英伟达也投了。

帮大家快速回忆一下,这家公司其实就是史上首位“AI 科学家”背后的出品方——

当时他们发布的 The AI Scientist,一登场就一口气生成了十篇完整学术论文,而且每篇成本才 15 美元左右(约 107.62 元),一时吸引大量关注。

根据 Sakana AI 公告,最新B轮融资筹集了 200 亿日元(约合 1.35 亿美元、9 亿多人民币),总估值来到约 4000 亿日元(约合 26.35 亿美元、184 亿人民币),创下日本非上市初创企业的估值纪录。

而且它的投资方阵容也堪称豪华——除英伟达(参与A轮)之外,还有一众美国顶级风投(如 Khosla Ventures、NEA)和日本产业与金融巨头(如三菱日联、四国电力)等。

所以,Sakana AI 为什么能获得如此高估值?

Transformer 八子之一创办、要做基于自然启发的 AI 模型

Sakana AI 成立于 2023 年 7 月,至今不过短短两年。

之所以一开始就受到巨大关注,毫无疑问离不开它的两位明星创始人。

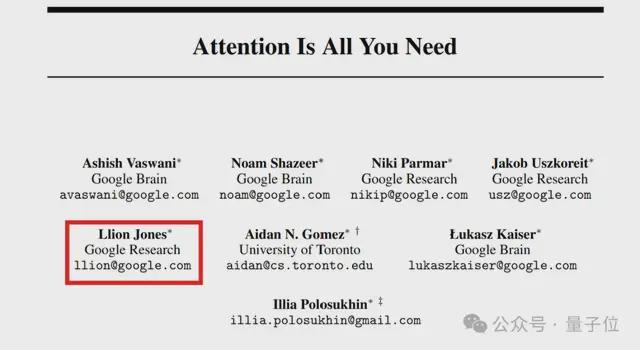

联创兼 CTO Llion Jones,大名鼎鼎的 Transformer 论文 8 位作者之一。

他本硕毕业于伯明翰大学,在 Delcam、油管、谷歌都工作过,创办 Sakana AI 之前在谷歌工作了 8 年之久。

据 FourWeekMBA 介绍称,在他之前的工作经历中,“曾两度与谷歌的工作擦肩而过”。

第一次是他刚毕业找工作时,虽然投了谷歌伦敦软件工程师的简历,并通过了两轮电话面试,但最终相比谷歌,他选择了位于英国的 CAD/CAM 软件公司 Delcam。

第二次是工作 18 个月后,他又接到了谷歌的招聘电话,询问他是否想重新申请,但他依旧没去谷歌,而是随后加入了 YouTube。

在 Youtube 做软件工程师的三年期间,他对人工智能产生兴趣,于是自学了 Coursera 的机器学习课程,并终于在 2015 年的时候加入谷歌研究院,担任里面的高级软件工程师。

也正是在此期间,他与其他七名作者一起发表了那篇著名的 Transformer 论文《Attention Is All You Need》。

而之所以选择离开谷歌,是因为公司目前已经发展到一定规模,使得他无法继续进行自己想做的工作。

按他自己的话来说就是,谷歌确实让他有种“被困住的感觉”。

于是潇洒一转身,他选择联合另一位谷歌前员工开始创业,而这位谷歌前员工就是如今身为 Sakana AI联创兼 CEO 的 David Ha。

David Ha(右图)曾是谷歌大脑的高级科学家,也曾领导过图像生成模型独角兽公司 Stability AI 的研究部门。

今年 8 月,他还入选了《时代》杂志评选的 2025 年人工智能领域百大人物榜单。

有了这二人,base 东京的 Sakana AI 可谓自带光环。

(注:之所以选择东京,是因为北美那边的生成式 AI 研究人员竞争非常激烈(手动狗头),而在日本这边竞争相对小一点而且也不乏高质量 AI 人才。)

而且比较新奇的是,Sakana AI 并不是要在日本再造一个 OpenAI 或 Anthropic,而是一开始就要走一条“不一样的路”——

他们希望放弃 Transformer 架构,并从自然进化中汲取灵感,以降低模型的计算成本并提升其性能 。

概括而言,他们的想法可以基本归纳为:

1)日本是个资源有限的国家,AI 发展到后面肯定会受到电力等资源的限制,所以从一开始就要考虑如何提效;

2)通过从自然进化中汲取灵感,他们能够实现这一目的。

至于究竟是怎样的自然灵感,这可以从他们给公司起的名字“Sakana AI”(sakana 是日语“魚”(さかな)的罗马读音)一窥。

就像大自然中的鱼会基于某种简单的规则成群活动。因此,AI 们也能借鉴它们的思想,无需更大的体积就能完成很复杂的任务。

具体来说,Sakana AI 计划开发一种基于自然启发智能(nature-inspired intelligence)的基础模型,借鉴自然领域中的“进化”和“集体智慧”思想,让一群 AI 协作,类似于当前 AI 领域的生物启发计算方向。

据《金融时报》介绍称,Llion Jones 认为,当前的 AI 模型之所以存在局限性,是因为它们被设计成无法改变的结构,这种结构往往是脆弱的。

相比之下,发挥“集体智慧”的自然系统,对于周围的变化非常敏感。基于此原理搭建的 AI 也会具有更好的安全性、更低的搭建成本。

等等,这不就是 AI 科学家吗?

造出史上首个 AI 科学家、各项研究库库发

2024 年 8 月,Sakana AI 以造出首个“AI 科学家”走红一时。

他们推出了第一个用于自动化科学研究和开放式发现的综合 AI 系统——The AI Scientist。

这个系统能够一口气自动完成从提出研究想法、检查创新性、设计实验、编写代码,到在 GPU 上执行实验并收集结果,最后完成论文撰写等全过程(一般会交由不同模型分工负责)。

而且当时还放出了由它撰写的十篇完整学术论文,一时令无数网友惊叹“是时候让 AI 帮我们写论文了”。

p.s.:后来有研究员受其中一篇论文想法的启发,还真的写出了一篇论文并在 arXiv 上公开了~

实际上,The AI Scientist 的出现并非偶然,而是 Sakana AI 对更早之前的一项研究的验证。

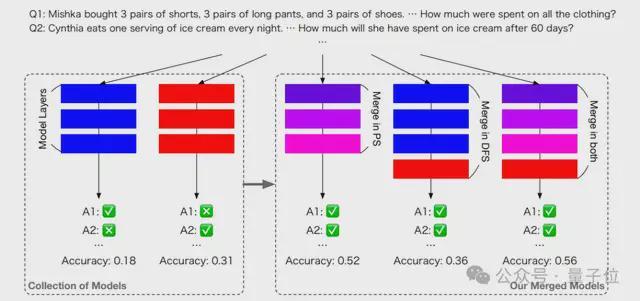

当时他们想出了一个进化合并模型的妙招——

把 Huggingface 上的现成模型拿来“攒一攒”,直接就能组合出新的强大模型。

具体来说,他们受自然界的自然选择启发,引入“进化模型合并”(Evolutionary Model Merge)的概念,提出一种可以发现最佳模型组合的通用方法。

采用相关方法,他们得到的一个 70 亿参数的日语数学大模型,直接在相关基准测试上取得了 SOTA,打败了 700 亿参数的 Llama-2 等前辈。

而且关键是,得出这样的模型不需要任何梯度训练,因此需要的计算资源大大减少。

基于此,他们后来在 The AI Scientist 研究里想到,是否能用大模型发现新的目标函数来调整其他模型。

而这,正是“首位 AI 科学家”能够成功运行的根本原理。

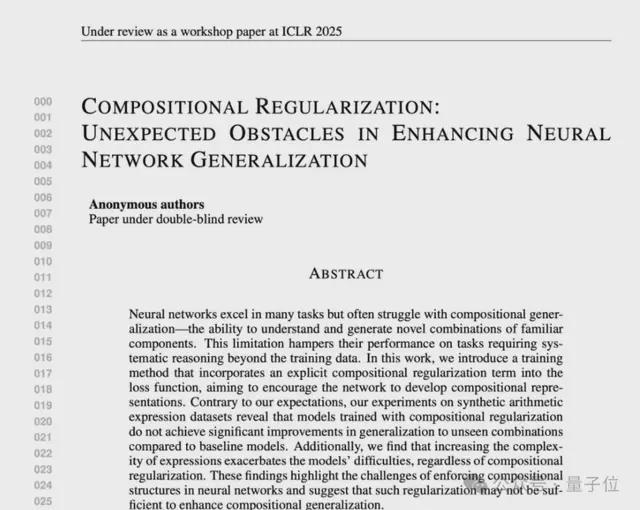

再到后来,Sakana AI 的 AI 科学家不断进化,其 AI Scientist 2.0 版本所生成的论文甚至通过了顶会 ICLR workshop 评审。

今年 4 月,Sakana AI 向 ICLR 提交了三篇完全由 AI Scientist v2 生成的论文。(仅告知 43 篇评审论文中有 3 篇出自 AI,但不告诉具体是哪一篇)。

结果,其中一篇论文《组合正则化:增强神经网络泛化的意外障碍》获得了6/7/6 评审分数,超过平均人类接收门槛。

再之后,围绕“AI 协作”这一核心命题,Sakana AI 基本以“一月一发”的快节奏推出多项研究:

- 今年 5 月,为考验大模型创造性推理能力,推出一个包含从简单 4x4 到复杂 9x9 现代数独问题的全新基准 Sudoku-Bench;

- 6 月,推出 Text-to-LoRA (T2L),彻底简化了模型适配流程;

- 同在 6 月,带来旨在让教师模型学会“启发式”教学的新方法,使用新方法训练出的 7B 小模型,在传授推理技能方面,比 671B 的 DeepSeek-R1 还要有效;

- 7 月,提出新算法 AB-MCTS,能让多个人工智能模型同时处理问题;

- 9 月,开源全新框架 ShinkaEvolve,可以让大模型在自己写代码优化自己的同时,还能同时兼顾效率;

至此,Sakana AI 当下能够斩获日本 AI 创企最高估值也就不难理解了——创始人自带光环、AI 科学家研究出圈、各种研究一月一发。

即使创始人无意再造一个日本版 OpenAI,但就其估值和成长轨迹而言,它已然是最接近“日本版 OpenAI”的存在。

好好好,美国有 OpenAI、日本有 Sakana AI,那咱中国呢?

这里我们快速看一下国内主要明星大模型公司的最新估值情况:

智谱 AI,“AI 六小虎”中首家启动 IPO 的企业,据中关村杂志 9 月报道其最新估值已超 400 亿元 RMB;

MiniMax,传闻计划今年赴港 IPO,据晚点 7 月报道其投后估值超过 40 亿美元(约 284 亿人民币);

月之暗面,10 月传出数亿美元新融资,若属实估值有望突破 33 亿美元(约 234 亿人民币);

看来这股 AI 热潮,已经蔓延到了全球每一个角落(手动狗头)。