新智元报道

编辑:KingHZ

ICLR 2026 评审结果震撼出炉:投稿量暴增至近 2 万篇,却迎来分数大滑坡,平均分从 5.12 跌至 4.2。审稿人吐槽论文质量低下,甚至疑似 AI 生成,这场学术盛宴为何变味?

ICLR 2026 评审结果公布了!

这届 ICLR 论文投稿数量创历史新高。

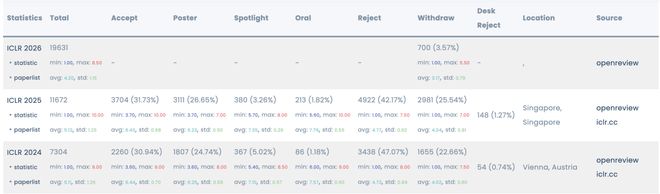

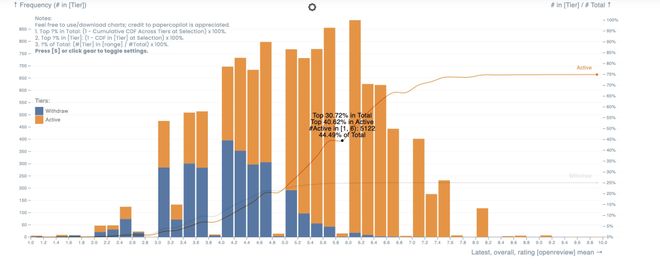

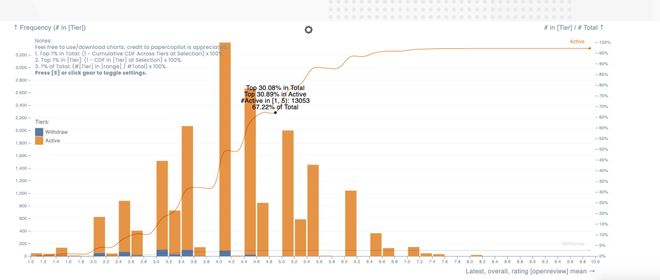

根据 Paper Copilot 网站统计,与 2025 年的 11672 篇总投稿论文相比,ICLR 2026 共有 19631 篇投稿,数量增加了,但质量却下降了——

ICLR 2025 最高分为满分 10 分,ICLR 2026 最高为 8.5;

ICLR 2025 平均分为 5.12 分,ICLR 2026 平均为 4.20。

链接:https://papercopilot.com/statistics/iclr-statistics/iclr-2026-statistics/

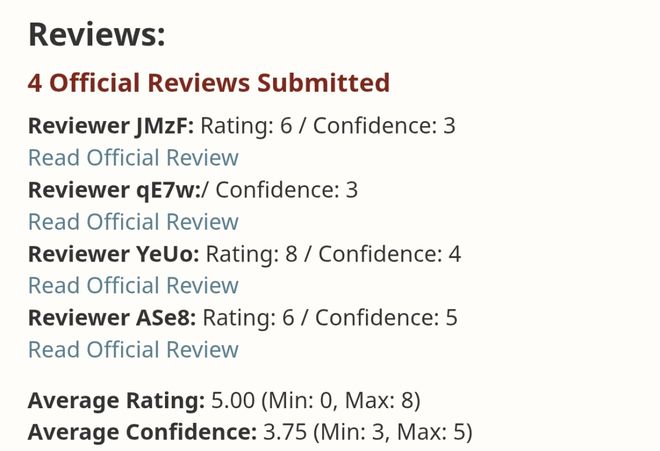

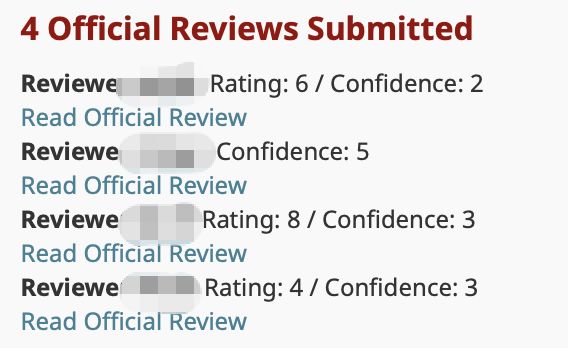

已有多名投稿人经历人生中第一次在 ICLR 上获得 0 分:

左右滑动查看

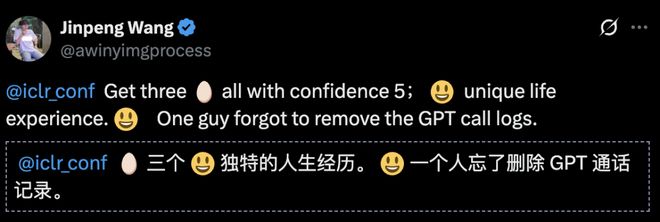

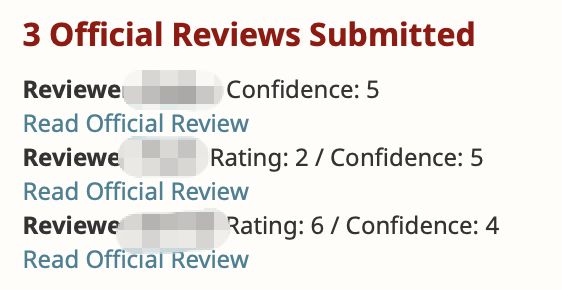

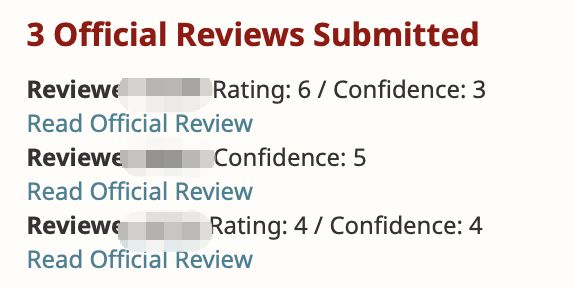

国内有投稿人甚至 3 篇投稿「全军覆没」,发推感叹独特的人生经历:

左右滑动查看

ICLR 2026 将于明年 4 月 23 日至 27 日,在巴西里约热内卢举行。

与 NeurIPS 和 ICML 一样,ICLR 是机器学习和人工智能研究领域中三大高影响力的会议之一。

ICLR,全称「International Conference on Learning Representations 」(国际表征学习大会),在 2012 年由图灵奖得主 Yann LeCun 和 Yoshua Bengio 创立。

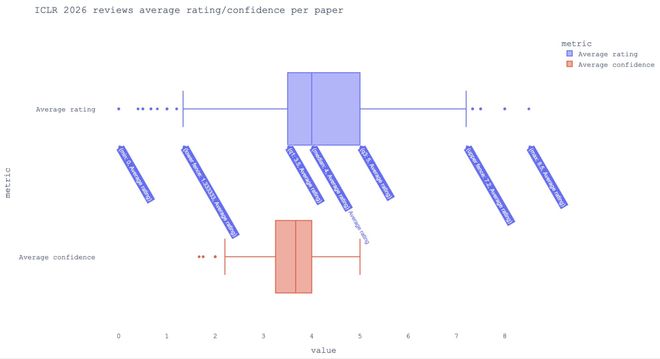

ICLR 2026 平均得分低了近 1 分

总体上,ICLR 的分数平均值比去年下降了近一个点:

2026 年:前 30% 的提交分数超过约 5.0 分

2025 年:前 30% 的提交分数超过 6.0 分

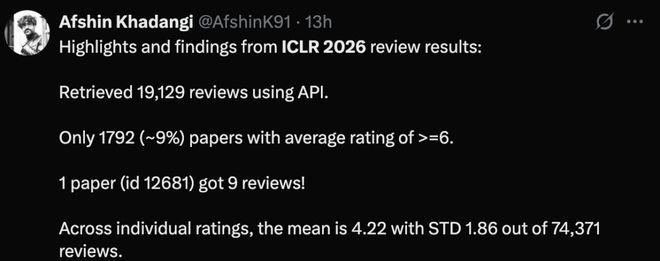

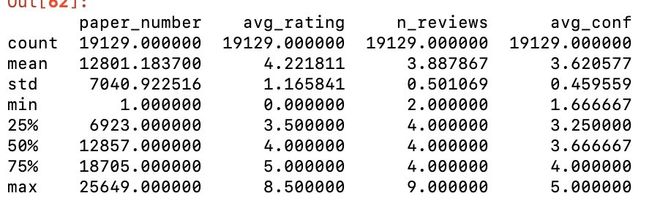

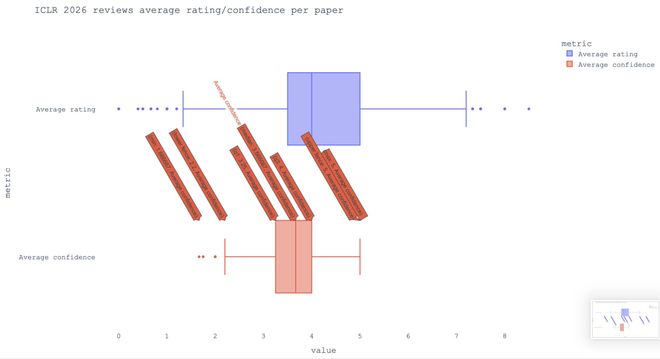

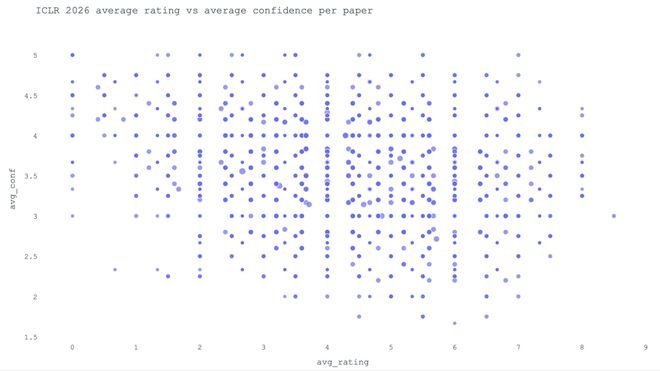

生物医学工程博士 Afshin Khadangi 使用 API 获取了 19129 条评审意见,总结了其中的一些亮点:

仅有 1792 篇(约9%)论文的平均评分达到 6 分及以上。

1 篇论文(id 12681)获得了 9 条评论!

在个人评分中,平均值为 4.22,标准差为 1.86,来自 74,371 条评论。

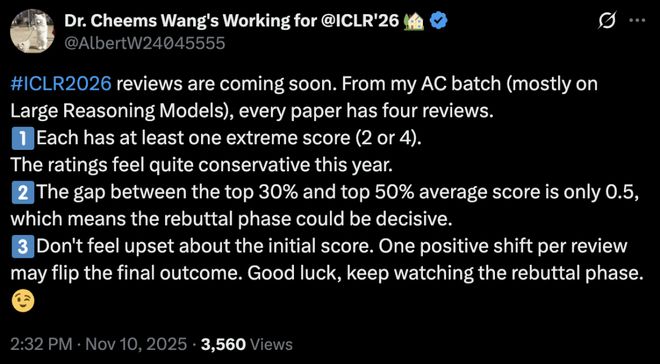

审稿人 Cheems Wang 注意到所在领域没变论文至少有一个极端分数,今年的评分确实保守了。

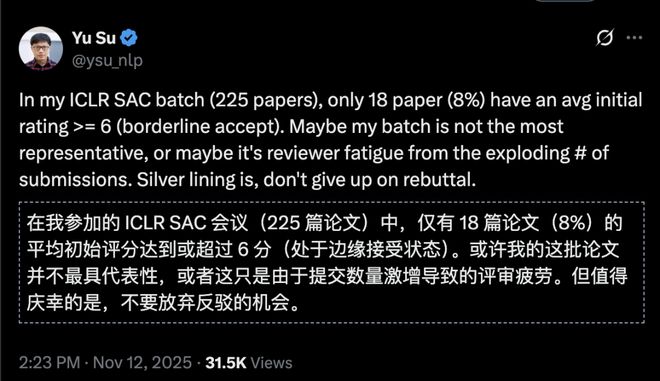

审稿人 Yu Su 也注意到平均分有些低,225 篇论文中只有 18 篇论文平均初始得分超过了 6 分,勉强达到会议接受底线。

清华大学博士、普林斯顿博士后发现了 ICLR 2026 明显的评分模式:

提交 ID 越高,评分似乎越低。

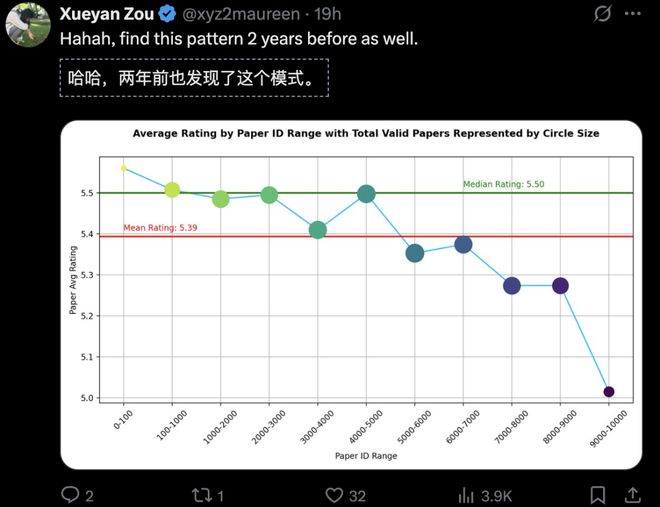

有人两年前就发现类似模式了:

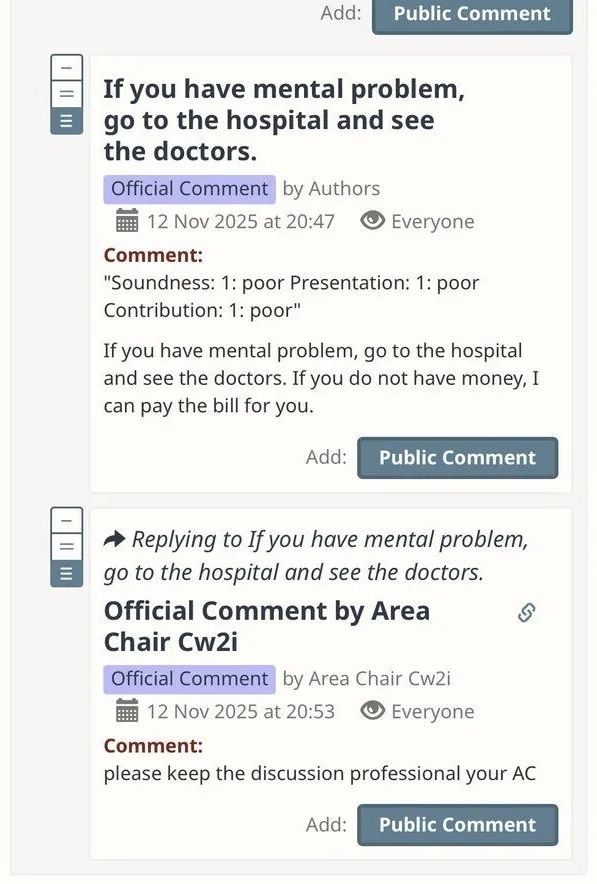

让人大吃一惊的是,评审现场惊现「精神病」评论:

如此激烈的审稿现场,引起 Reddit 网友围观:

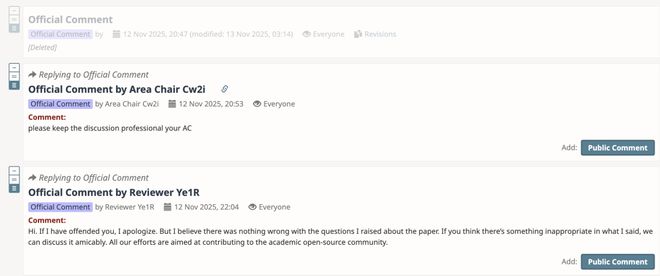

现在原始的审稿意见已删除,审稿人为自己的冒犯性言论道歉,但坚持称提出的论文问题没有任何错误。

另一位来自亚马逊的一位 ICLR 审稿人也有牢骚:

在审稿意见刚公布后,我所负责的一篇论文就被撤稿了。

而且今年在多个顶级会议上,他已经遇到好几次类似情况。

他表示,这类论文往往写得很差,充斥着未经定义的新术语、缺失引用,甚至有些段落看起来像是 AI 生成的。

审稿人常常要花五六个小时去搞懂作者的方法和实验(而这些实验通常也不怎么样),结果最后论文一撤了之,换个会议重新投。

如果作者不做改进,新的审稿人也还得再受一遍罪。

他提议:「是否该设立某种机制,对那些频繁撤稿或无故跳过 rebuttal 阶段的作者,给予临时投稿禁令?」

不过,他之后另发推文表示,某些论文和评审的质量之低,让人沮丧。

他认为,这种沮丧很大程度上源于大家对论文和评审质量分布的期望:

论文质量并不遵循正态分布,而我们却常常试图给出遵循正态分布的评分。下限远比上限离平均值更远。评审质量也是如此。

但我们期望正态分布,也就意味着我们期望低质量的论文或评审很少,但这并非现实。

这种对正态分布的错误假设在生活中许多领域都存在,正如塔勒布的《黑天鹅》中揭示的。

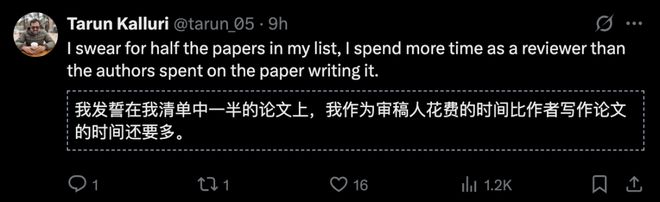

Meta 的研究人员 Tarun Kalluri 则表示,作为审稿人,列表上一半的论文他花的时间比作者还多。

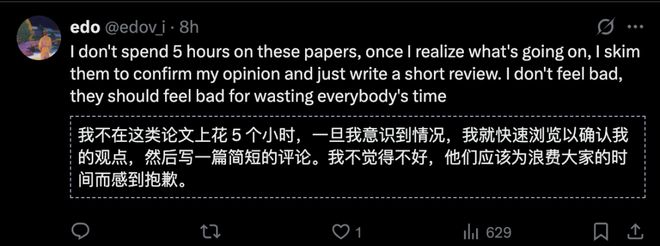

也有审稿人表示,一旦发现「屡投屡拒」的低分论文,他会马上确认观点,提交简短的评论,避免浪费时间。

不少投稿人对 AI 顶会的同行评议,意见也很大。

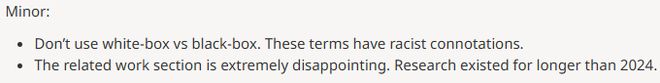

而类似一幕在 ICLR 2026 也上演了——

图宾根大学博士生 Alexander Panfilov 直接说续集已面世。

原因竟是论文中提到「白箱 VS 黑箱」,被认为这些词汇「带有种族歧视的隐含意义」,要求小改。

DeepMind 研究员

评审是「随机数生成器」

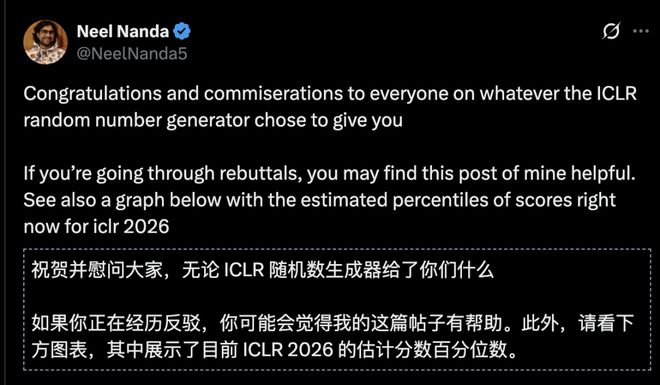

DeepMind 研究员 Neel Nanda 祝贺了所有投稿人,并提供了一份论文反驳(rebuttal)指南。

链接:https://www.lesswrong.com/posts/vJNQZqgnKSxTBdFbS/neel-nanda-s-shortform?commentId=qqHPrBheFwQgrJbzN

他给出的建议就是要大家记住一件事——

同行评审已经被正式验证是一种「随机数生成器」。

在一项随机对照实验中,哪怕是被评为「重点报告」的论文,换一个审稿组也有一半被拒。

所以,别把自我价值寄托在这轮学术轮盘赌是落在红格还是黑格上。

如果评审的批评听起来不太靠谱——那很可能确实如此(也不排除是某个大语言模型写出来的)。

但如果评审意见有道理(当然你得克服自己的防御心态来看),那就太好了——你得到了能让论文变得更好的宝贵反馈!

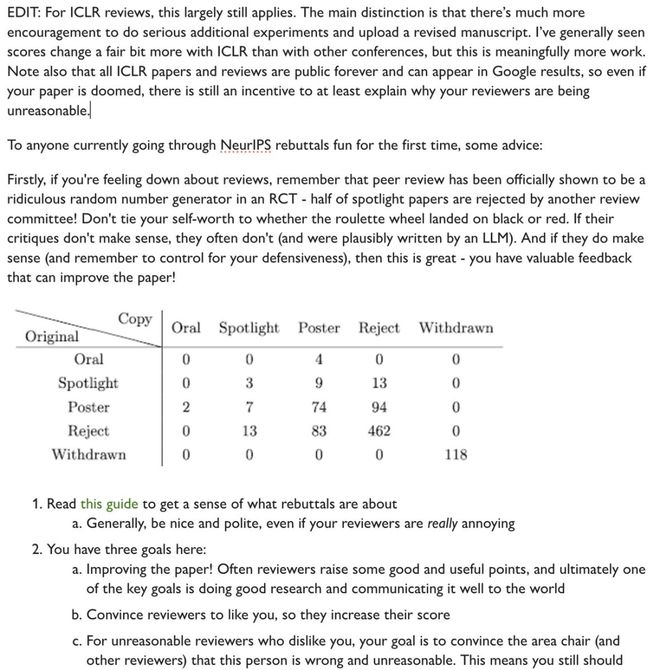

这份反驳指南本来是为了顶会 NeurIPS 而写,但就 ICLR 来说,Neel Nanda 认为以上情况依然普遍存在。

但不同之处在于,ICLR 更鼓励作者在 rebuttal 阶段补充重要实验,并上传修订稿。我确实看到 ICLR 的打分变化幅度通常比其他会议大,但这也意味着需要付出更多额外工作。

另外请注意,ICLR 的所有论文和评审意见都是永久公开的,还会被 Google 检索收录——

所以即便你觉得这篇论文没希望了,也还有动机写清楚为什么评审意见不合理。

他推荐的 rebuttal 流程如下:

1. 把所有评审意见复制到一个 Google 文档里;

2. 给每一条意见做批注,把它们归类为:

3. 误解、观点不一致、表述问题、技术问题;

4. 和合作者一起讨论如何逐条回应——优先处理重要的;

5. 然后,写出要点提纲,尽早请人反馈;

6. 最后润色整理好,提交。

通常你需要针对每位评审写一段回应,并总结多位评审提出的问题。

牢记「反驳」阶段的三个核心目标:

-

改进论文。其实,评审经常提出一些有用的建议,既然是做科研,最终还是为了把研究做好、把成果清楚传达出去。

-

说服评审打高分。争取让他们对你产生好感,自然更愿意调高分数。

-

对付不讲理的评审。如果某位评审明显针对你,那核心对象就变成了领域主席和其他评审——你要用有理有据的回应,让他们意识到这位评审的意见站不住脚。换句话说:哪怕是针对性很强的批评,也要认真回应,只是说服的对象换了。

最重要的一点:让人相信你真的改进了论文。

而且,时间是有限的,你希望最大化单位时间内的回报,而新的实验通常比撰写或概念反驳要花费更长的时间——谨慎地进行优先级排序。

参考资料: