时令发自凹非寺

量子位 | 公众号 QbitAI

马斯克 xAI 又出手了!

这次闪亮登场的是Grok 4 Fast——

不仅实现 9 折价格追平 Gemini 2.5,还支持2M上下文窗口。

除此之外,这个全新的多模态推理模型还可与X实现无缝衔接。

例如,给它输入以下提示词:

- 帮我找一篇今年的X帖子,其中 mkbhd 分别拿着书本式折叠手机和翻盖式折叠手机。

Grok 4 Fast 不仅详细描述了帖子内容,提供了准确链接,甚至还贴心地附上了相关的 YouTube 视频网址。

下面具体来看。

以最低的成本实现最高的性能

可以说,Grok 4 Fast 这一波在性价比这件事上树立了新标杆。

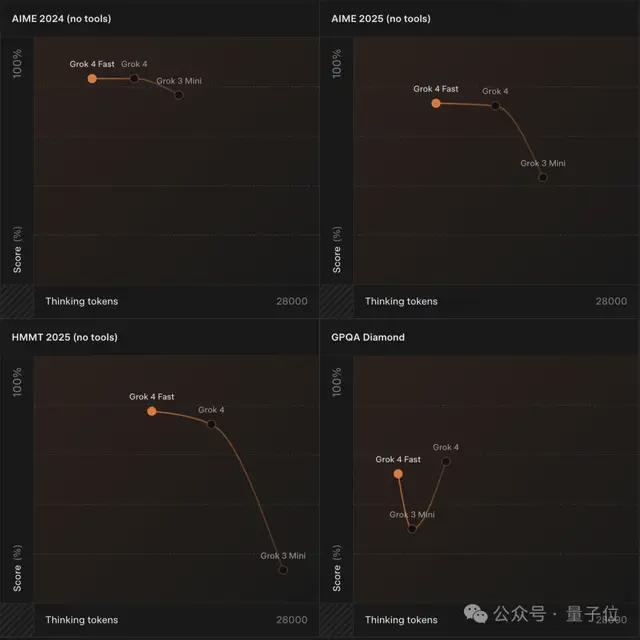

在推理基准测试中,它不仅全面超越 Grok 3 Mini,还大幅降低了 Token 成本。

与 Grok 4 相比,Grok 4 Fast 在保持与前者性能差不多的同时,平均使用的思考 Token 数量减少了 40%。

根据 Artificial Analysis 的独立评测验证,在“人工分析智能指数”榜单中,Grok 4 Fast 与其它公开可用模型相比,呈现出业界领先的“价格-智能”比。

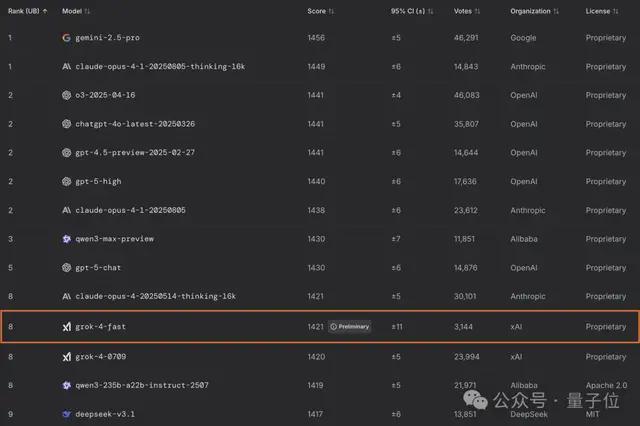

除此之外,Grok 4 Fast 还在 LMArena 上进行了对战测试。

在搜索竞技场中, grok-4-fast-search 以 1163 分的成绩夺强势登顶,较第二名 o3-search 领先 17 分,展现出显著优势。

在文本竞技场中,grok-4-fast-search 排名第 8 ,性能与 grok-4-0709 相当,在同体量模型中表现尤为出色,其余所有同类大小的模型排名均在第 18 位及以下。

如何实现的?

Grok 4 Fast 采用端到端的工具使用强化学习(RL)进行训练,尤其擅长判断何时调用工具,例如代码执行或网页浏览。

除此之外,Grok 4 Fast 还展现了前沿的智能搜索能力,能够无缝浏览网页和X,通过实时数据增强查询效果。

它可在链接间快速跳转,处理多种媒体内容(包括X上的图像和视频),并以光速整合分析结果。

过去,不同的推理模式需要依赖多个独立模型。

但 Grok 4 Fast 推出了统一架构,通过系统提示词调控,让同一组模型参数既能处理长链思维推理任务,也能完成快速响应类非推理任务。

这种一体化设计显著降低了端到端延迟与 Token 成本,使 Grok 4 Fast 成为实时应用的理想选择。

目前,Grok 4 Fast 已面向所有用户开放,Auto 模式下的复杂查询将自动调用 Grok 4 Fast。

除此之外,Grok 4 Fast 还将推出两个新模型:

- grok-4-fast-reasoning

- grok-4-fast-non-reasoning

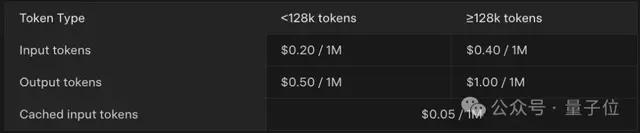

现已通过 xAI API 正式开放使用,具体定价如下:

One More Thing

Grok 4 Fast 背后,马斯克还刚刚从谷歌挖来了一位关键人才——

帮谷歌 Gemini 拿到了 IMO、ICPC 金牌的Dustin Tran。

他本科毕业于美国加州大学伯克利分校,博士毕业于哥伦比亚大学,曾在 OpenAI 当过研究实习生,后在 2017 年加入谷歌。

作为已在谷歌 DeepMind 工作8 年的高级研究科学家,Dustin Tran 深度参与了 Gemini 系列模型的研发工作,还助力实现了谷歌模型在 LMSYS 排行榜上的首次登顶。

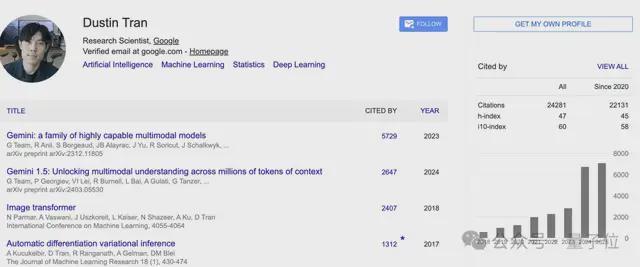

此外,他还是 2.5 代模型的评估专家,推动相关模型在 WebDev Arena 和 HLE 评测中荣获第一。

在学术领域,Dustin Tran 的论文主要集中在人工智能、机器学习和深度学习等领域,至今共被引用超过两万次,其中h-index 有 47,i10-index 达 60。

参考链接:

[1]https://x.com/xai/status/1969183326389858448

[2]https://x.com/kimmonismus/status/1969333210975756697

[3]https://x.com/elonmusk/status/1969265917289709918

[4]https://x.com/amXFreeze/status/1969389832721056054

[5]https://artificialanalysis.ai/models/grok-4-fast-reasoning/providers