新智元报道

编辑:定慧好困

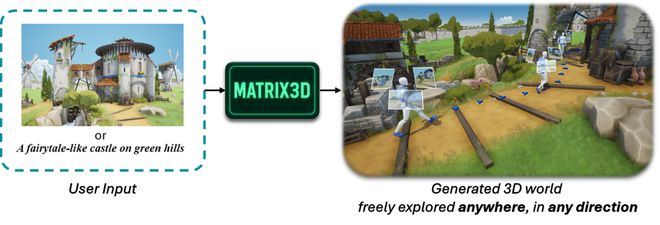

【新智元导读】中国自研世界模型 Matrix-3D 只需单张图就能生成可自由探索的 3D 世界,不仅效果对标李飞飞的 World Labs,而且还能实现更大范围的探索空间,率先进入 AI 理解世界的前沿领域。

一花一世界,一叶一菩提。

千百年来,人类只能凭想象勾勒图画之外的世界,梦境与现实之间始终隔着一层不可触及的纱幕。

而今天,当 AI 的力量被无限延伸,这层纱幕终于被揭开——

Matrix-3D,一个真正从「一图生万境」的世界模型!

它不仅是昆仑万维第一款,也是第一首款全自研世界模型「Matrix-Zero」的全新升级。

进化后的世界模型 Matrix-3D,可以从一张山间草地的照片出发,创造出风吹草动、远山起伏的全景风光。

从现代城市的一角出发,它能「脑补」出画面之外,繁华的街道和大厦。

现在,我们不再需要多个视图,也不再局限于局部透视,而是真正实现了几何结构精确、可以 360°自由漫游的 3D 世界。

值得一提的是,本周还是昆仑万维如火如荼的 AI 技术发布周,而 Matrix-3D 便是第二个出场的模型。

挑战空间智能的核心痛点

大模型赛道卷了两年,谁都在观望,下一个破局的方向在何方。

在这之中,李飞飞仅用 3 个月就实现 10 亿估值的 World Labs 也许能证明:具有空间智能的世界模型正是AI理解世界的下一个前沿。

最近,谷歌发布的再次让所有人对「世界模型」充满期待,它能以每秒 20-24 帧速度,实时生成 720p 画面,还能持续数分钟一致性。

作为探索,昆仑万维也在今年 2 月时发布了自研的世界模型:

-

它不仅能将用户输入的图片转化为可自由探索的真实合理的 3D 场景;

-

而且还能根据用户输入实时生成互动视频效果。

而这次全新发布的 Matrix-3D,首次具备了「从一图入实境」的构建能力,让世界模型再次得到了进化:

-

场景全局一致:支持 360°自由视角浏览,几何结构准确、遮挡关系自然,纹理风格统一。

-

生成场景范围大:与现有场景生成方法相比,支持更大范围的、可 360 度自由探索的场景生成

-

生成高度可控:同时支持文本和图像输入,结果与输入高度匹配,支持自定义范围与无限扩展。

-

泛化能力强:基于自研 3D 数据与视频模型先验,可生成丰富多样的高质量场景。

-

生成速度快:首个前馈全景 3D 场景生成模型,可快速生成高质量 3D 场景。

技术报告:https://github.com/SkyworkAI/Matrix-3D/blob/main/asset/report.pdf

项目主页:https://matrix-3d.github.io/

Github:https://github.com/SkyworkAI/Matrix-3D

Hugging Face:https://huggingface.co/Skywork/Matrix-3D

接下来,我们就来直观感受一下,Matrix-3D 的「威力」吧。

画面一致性

首先,不管是生成的内容还是颜色,都能做到统一一致。

其次,在视角上,Matrix-3D 可以支持 360°的自由环视。

一座有草屋顶的房子,风车,以及延伸至地平线远端的花田的动漫风格村庄,极为精细,暖光,舒适的氛围。

此外,物体之间的几何和遮挡关系,也能符合物理定律。

一幅印象派风格的冬日风景,包含山脉、湖泊、小屋、树木和积雪,以蓝色调为主,笔触质感丰富,氛围宁静,高分辨率,色彩鲜明。

Matrix-3D 生成的全景视频如下:

而最终的 3D 场景渲染结果长这样:

一个方块像素化的景观,包含山脉、树木、水体、天空、云朵,类似《我的世界》风格,高分辨率,色彩鲜艳,纹理细节丰富,氛围宁静。

精准控制

3D 世界中,我们的视角通常会随心所欲地沿着不同路径,向各种各样的方向移动。

针对这些不同的轨迹,Matrix-3D 能够生成与之对应的 3D 场景。

比如,沿着S形的弯折前行:

或者,向右前方移动:

大范围移动

对比李飞飞 World Labs 方法,Matrix-3D 支持更大范围的移动。

可以看到,在 World Labs 发布的视频中,「我们」刚走两步,就碰到边界了。

类似的,Hunyuan World 1.0 在边缘的生成上也存在问题。

相比之下,Matrix-3D「生成」的 3D 世界动态范围更大,视角更丰富,范围更广。

无限续写

创造的意义就在于,我们可以根据已知来描绘「未知」。

Matrix-3D 生成一段场景后,可以允许用户在此基础上对场景进行扩写。

比如一开始是一张静态图片,描绘了一座建在冰川上的未来研究基地,配有发光穹顶和先进机械,四周环绕着冰封景观,具有科幻美学风格,画面极为细致精美。

很快,Matrix-3D 就根据图片渲染出了首段视频。

可以看到,画面镜头从图片开始缓缓前移,然后中途 360°旋转回正。

但是,如果我们想继续知道「前路如何」呢?

Matrix-3D 可以根据已经生成的全景视频继续完成续写,可以看到画面随着镜头继续前移,最终进入新的场景。

快速场景重建&精细场景重建

为了综合考虑生成速度和质量,Matrix-3D 有两套场景生成框架——看中速度的「全景前馈重建」,以及看中质量的「3DGS 优化」。

举个栗子,这是一张描绘河道的图片。

如果就是想要快速生成,那么全景前馈重建只需不到 10 秒,即可给出一个可 360°观看的 3D 场景。

但如果希望得到更好的生成效果,就可以使用 3DGS 优化,让最终的场景既细致又准确,看上去就像真实拍摄的一样。

解密 Matrix-3D 核心技术

如果说经过 30 年发展的互联网世界为当下大模型时代提供了足够「优质」的训练数据。

那么 3D 场景数据的稀缺性,也正是目前制约空间智能、3D 场景生成的重要原因之一。

为了获取 3D 数据,目前一种主流的研究方法是利用图像生成模型或者视频生成模型,作为三维生成的先验。

但这类方法存在一个根本性的缺陷:

由于训练过程主要基于透视图(Perspective View)进行,模型只能学习到局部视角下的有限空间结构。

一旦用户视角超出训练数据所覆盖的范围,场景就会出现明显的「边界效应」或「断层」。

如下图所示,这种不连续性会严重破坏用户的沉浸感,直接影响VR/AR等需要自由视角探索的下游应用体验。

为了实现任意地点、任意角度的自由视角浏览,Matrix-3D引入了全景图像(Panoramic Images)作为场景生成的中间表达形式。

与传统透视图相比,全景图具备更全面的空间感知能力——

它能够覆盖 360°水平视角和 180°垂直视角,几乎囊括了人眼可见的全部方向,如下图所示,用户可以从任意角度对场景进行观察与探索。

更进一步,将多个地点的全景图顺序拼接,即可构建出一段连续的全景视频(Panoramic Video)。

这种结构不仅保留了各个观察点的空间信息,也为 3D 场景重建提供了充足的视觉线索,相当于以二维方式完整记录了三维世界的骨架与细节。

这为后续的3D 世界生成奠定了数据基础,也极大提升了下游应用(如 VR/AR)的沉浸式体验质量。

确定使用全景视频作为中间表达后,Matrix-3D 设计了三个核心模块来实现 3D 世界生成:

-

全景图生成模块:通过 LoRA 微调,从文本或透视图生成高质量全景图;

-

可控全景视频生成模块:结合用户设定的轨迹和范围,生成连续全景视频;

-

3D 场景生成模块:从全景视频解码出完整 3D 场景,支持自由视角探索。

Matrix-Pano 数据集

每一个空间智能问题,最终还是要回归到数据集。

收集真实世界的 3D 场景数据仍然成本高昂,但是目前 3D 场景数据集存在规模小、视角不全、质量参差、缺乏精准相机/几何标注等问题。

于是,昆仑万维提出了Matrix-Pano 数据集——这是一个基于 Unreal Engine 构建可扩展的全景视频数据集,专为生成高质量、可探索的全景视频而设计。

Matrix-Pano数据集具有以下特点:

-

场景环境多样:包含 11.6 万条全景视频、2200 万帧画面,覆盖 504 个高质量室内外场景,多种天气与光照条件。

-

轨迹生成智能高效:基于 Navigation Mesh 与 Delaunay 三角剖分,结合 Dijkstra 路径规划与 Hermite 曲线平滑,自动生成自然连贯的探索轨迹。

-

高仿真碰撞检测:通过边界框代理,实时剔除穿模或几何剪切,确保运动轨迹物理合理。

-

工业级相机控制:融合多级平滑与 PID 控制,实现相机位置与旋转的精准解耦,生成稳定流畅的视频序列及高质量标注。

-

开放共享:核心子集将向学术界开源,助力 3D 生成和空间智能领域研究。

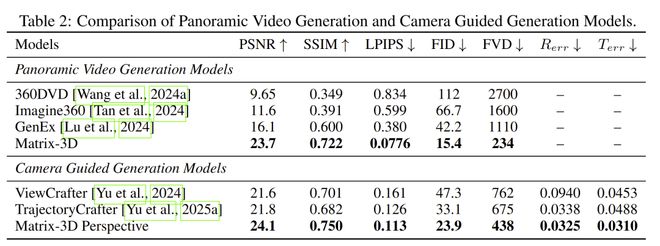

同时,Matrix-3D 的全景视频生成结果在全景视频生成评测集上也取得了最好的生成质量。

此外,Matrix-3D 方法在生成结果的视觉质量和相机可控性层面都优于现有方法。

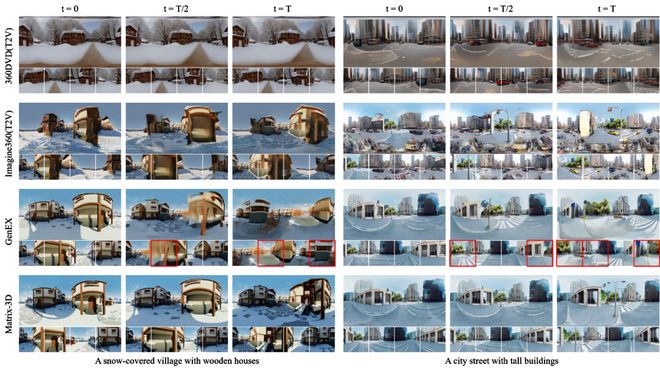

不同方法生成全景视频不同时刻对比图,其中 Matrix-3D 方法生成视频的质量更高、一致性更强(下方小图为四方向透视图)

轨迹引导的可控全景视频生成

轨迹引导是突破控制性与 3D 视觉质量的关键技术。

所以,首要问题是如何构建轨迹引导?

·Initial Panorama with depth:输入为带深度的全景图,提供基本的空间信息

·Trajectory guidance from point cloud:基于点云的轨迹引导

·Trajectory guidance from mesh:基于三角网格的轨迹引导方式

Matrix-3D 根据输入的全景图像与深度图构建三维网格,并结合预设相机轨迹生成引导视频序列。

系统通过深度变化检测遮挡区域,标记不可见像素并剔除其对应顶点,确保遮挡关系清晰准确。

每一帧引导图像都配有可见性掩码,用于精确控制模型输入。

与传统点云渲染相比,该方法有效缓解摩尔纹和遮挡错误,提升了几何一致性和生成质量。

解决了轨迹引导,就可以进行全景视频生成。

Matrix-3D 通过一套「全景渲染+视频扩散」的流程,实现从 2D 全景图生成可自由探索的 3D 世界:

-

流程最左侧为输入的全景渲染图(Scene Mesh Renders)和遮挡掩码(Mask),包含几何结构和可见性信息;

-

图像经 3D Causal Encoder 编码,遮挡掩码下采样后与其进行通道级拼接;

-

将融合特征输入 Video Diffusion Transformer,在时间维度合成连贯的视频表示;

3D 世界生成:从视频到可探索三维世界

有了数据,也有了轨迹引导的可控全景视频。

那如何将全景视频还原为可自由探索的高质量 3D 场景呢?

Matrix-3D 提供两种方案,将全景视频还原为可自由探索的高质量 3D 场景:

1. 优化式三维重建:追求极致画质

通过估算全景视频深度并结合相机轨迹生成点云,作为三维高斯渲染(3DGS)的基础输入。

进一步引入超分辨率提升视频质量,并将全景图裁剪为 12 个透视视角,实现高精度 3D 重建。

适用于对细节要求极高的场景,如虚拟仿真与高保真还原。

2. 前馈三维重建:主打高效快速

为了提升效率,直接从视频潜变量预测 3DGS 表达,显著降低计算成本。

通过 Transformer+DPT 解码器预测颜色、深度、尺寸、透明度等属性,并结合 Plücker 编码精准建模相机姿态。

采用专为全景图设计的 CUDA 光栅器实现无需多视角的高效渲染。

训练时采用两阶段策略,先引导模型学习几何,再优化真实渲染效果,兼顾准确性与泛化能力。

最左侧输入为视频潜变量+相机编码。

上支路:对视频潜变量进行 2D 卷积提取特征;下支路:对相机姿态(如 Plücker 编码)进行 3D 卷积处理,提取时空结构信息。

然后进行特征融合 +Transformer 编码,两路特征拼接后送入多层 Transformer 进行全局建模,输出空间一致的语义表达。

最后是分支解码,第一分支预测深度图,为重建提供几何基础;第二分支预测 3DGS 的其他属性:颜色、尺寸、透明度、旋转方向等。

最终生成可自由视角探索的全景 3D 场景,具备真实感强、几何一致性好的空间体验。

应用前景

Matrix-3D 作为 3D 世界生成的重要里程碑,将在多个领域广泛应用:

游戏与影视制作:快速生成高质量 3D 场景,助力游戏开发与虚拟拍摄,提升沉浸感并显著降低制作成本。

具身智能:构建可控模拟环境,用于机器人训练与自动驾驶测试,提高系统的安全性与泛化能力。

虚拟现实:生成可 360°自由探索的沉浸式虚拟空间,为用户带来真实可感的交互体验。

这些应用场景展示了 Matrix-3D 技术在不同领域中的重要性和多样性。随着技术的进步,这些应用将继续发展并带来更多创新。

从「一图生万境」到「无限宇宙皆可构建」,Matrix-3D 不仅是一项 3D 生成技术的突破,更是 AI 迈向空间智能时代的宣言。

它标志着——AI 不再只是「解读」图像,而是真正能够「走进」世界;不再只是「构想」场景,而是切实具备「创造」现实的力量。

未来,想象力将成为探索世界的唯一边界。

而 Matrix-3D,正在让这道边界彻底消失。