新智元报道

编辑:LRST

首个工程自动化任务评估基准 DrafterBench,可用于测试大语言模型在土木工程图纸修改任务中的表现。通过模拟真实工程命令,全面考察模型的结构化数据理解、工具调用、指令跟随和批判性推理能力,研究结果发现当前主流大模型虽有一定能力,但整体水平仍不足以满足工程一线需求。

在 AI 竞速的今天,大语言模型(LLM)早已不满足只在象牙塔里「背书解题」。

当 GPT-4o 刷题通过物理奥赛、DeepSeek 熟练搭建网站之后,LLM 必须直面一个更现实的问题:

这些号称「专家级」的大模型,能不能真的下工地?能不能帮工程打工人减负?在钢筋水泥的图纸世界里,它们是得力助手,还是纸上谈兵?

答案尚未揭晓,但 DrafterBench 迈出了评估的第一步。

来自加拿大麦吉尔大学 AIS 实验室的研究团队与加州大学圣芭芭拉分校(UCSB)合作,正式推出面向工程自动化任务的大模型评估基准——DrafterBench。

这是首个针对「一线工程图纸修改任务」设计的大规模评测套件,旨在验证和揭示现有 LLMs 能否胜任土木工程等领域中真实的「打工任务」。

论文链接:https://arxiv.org/abs/2507.11527

代码链接:https://github.com/Eason-Li-AIS/DrafterBench

数据链接:https://huggingface.co/datasets/Eason666/DrafterBench

为什么需要 DrafterBench?

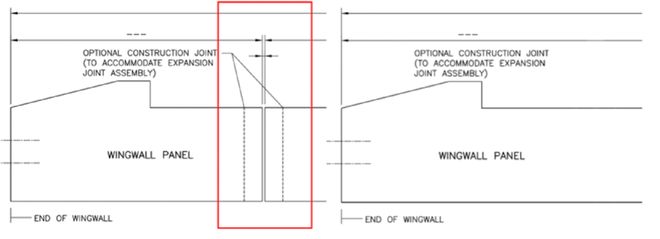

工程图纸修改,是土木工程、建筑设计等领域最耗时间、最高频的任务之一,也是自动化改造迫切程度极高的一环。

每天成千上万的一线工程师、制图员在重复地处理「改一根梁的位置」「把这根管道直径加粗一点」「为这个构件增加标注」这类十分琐碎但又关系重大的任务。

这类工作往往工作量大、标准高、容错低,但技术门槛不高,对工作者在「任务理解、细节处理、任务链配合」方面的综合执行力要求极强。

于是研究团队提出问题:

如果大模型能读懂图纸指令,调用工具链,精确修改图元,它就不只是「写 PPT 的高手」,更是「工程打工人福音」。

DrafterBench 怎么做的?

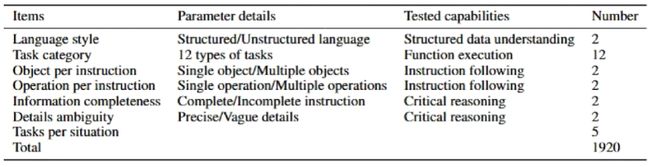

DrafterBench 以图纸修改为核心任务,在 20 个真实项目中收集并设计了 1920 个高质量任务,涵盖 12 类指令类型,模拟了各种难度、不同风格的真实工程命令。

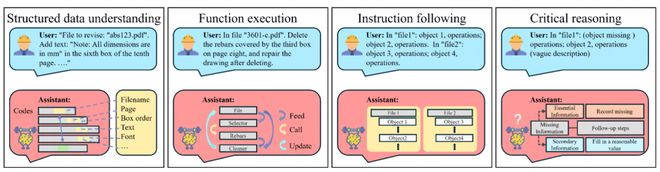

DrafterBench 不仅让模型「按部就班」,而是全面考察以下四大任务能力维度。

结构化数据理解能力:模型是否能从不同风格语句中准确提取出关键细节;

工具调用能力:模型能否组合多个工具形成有效的操作链,并正确调用顺序与参数;

指令跟随能力:面对一条包含多个修改目标的长指令,是否能做到任务不漏项、执行不断链;

批判性推理能力:模型能否识别指令中的信息缺失、不合理内容,并尝试补全模糊的细节、完成修正。

这不是纸面作文,是工程实战。

DrafterBench 如何评估模型?

在 DrafterBench 中,模型要以「代码调用工具」的方式完成任务。

这些工具涵盖图元编辑、标注调整、绘图逻辑等,彼此之间还有输入输出依赖,形成一个「工程任务链」。

但问题来了:

工具调用是否正确?是否合理组合?

中间步骤是否成功传递?是否使用了冗余或错误命令?

直接看图纸输出无法判断。因此 DrafterBench 设计了一整套对偶工具系统(Dual function system)。

所有工具都有一份「替身」,不实际修改图纸,但记录调用顺序、参数值、变量状态,并以结构化 JSON 形式输出,清晰还原模型「行动路径」。

DrafterBench 不只看模型有没有答对,而是看它「为什么答错,哪一步出错,错在哪里」。

模型表现如何? 喜忧参半!

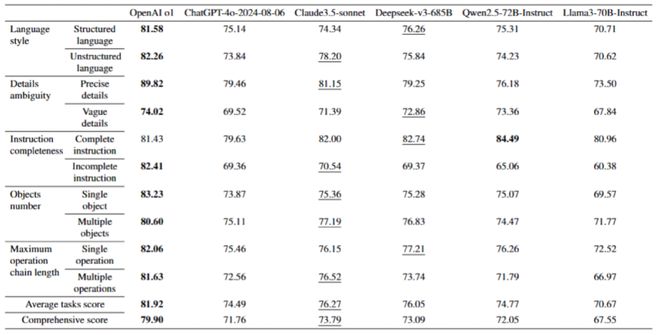

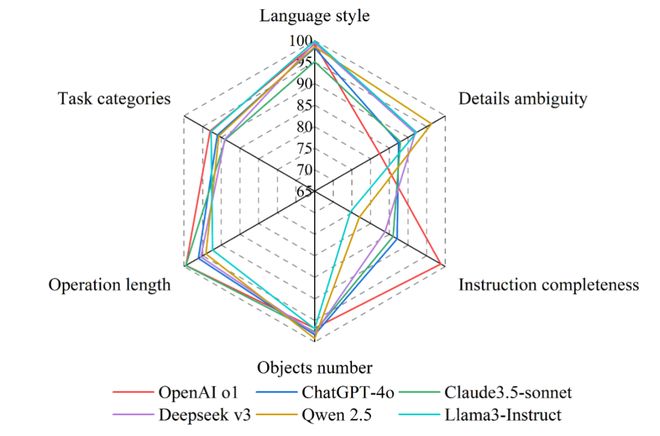

DrafterBench 评测了主流 SOTA 大语言模型,分别为:OpenAI GPT-4o / o1 系列、Claude 3.5 Sonnet、Deepseek-V3-685B、Qwen2.5-72B-Instruct、以及 LLaMA3-70B-Instruct。

综合来看,这些模型表现都达到一定水准,得分普遍超过 65 分。

其中,OpenAI o1 以 79.9 的综合分领跑,Claude3.5 Sonnet 和 Deepseek-V3-685B 表现也非常接近,分别为 73.79 和 73.09。

这说明当前主流大模型具备一定的工程任务处理能力,尤其在简单指令执行上表现稳定。

但与此同时,模型整体水平仍远未达到工业一线对执行精度、流程完整性的实际要求。

更重要的是,不同模型在四大能力维度上呈现出显著差异。

比如,在结构化数据理解任务中,模型整体表现稳定,对语言风格的鲁棒性较强。

但在工具调用方面,准确率波动明显,平均可达 9 个百分点。对于指令跟随能力,部分模型表现出较强的任务承载能力,如 OpenAI o1 和 Claude3.5 Sonnet 抗噪声能力较好,能保持基本的任务完整性。

而在批判性推理任务中,模型间能力分化尤为显著。

OpenAI o1 在识别指令中信息缺失、筛选关键信息方面表现突出,而 Qwen2.5 则在细节补充上更具优势。

其余模型则在这两个维度中存在大幅度波动,表现不一。

研究团队进一步使用自动化错误分析工具,对每一个任务的失败原因进行结构化溯源。

结果表明,模型常见错误类型包括参数定义不清、变量传递失败、函数调用结构错乱、工具选择偏差以及多工具组合逻辑混乱。

更关键的是,即便多个步骤执行正确,只要某一关键环节出现偏差,就会导致最终图纸修改失败。

这也解释了为何多数模型的单项能力准确率维持在 60% 左右,但整体目标修改完成度却显著偏低,仅在 40% 左右。

结论与展望

这些评估结果说明,尽管当前的大模型已有一定能力拆解复杂任务结构、调用工程工具,但它们仍难以稳健掌握完整任务链的所有细节,对实际场景的适应能力尚不足以支撑工程一线需求。

如果说过去的大模型评测多数还停留在「会不会」,那么 DrafterBench 的贡献在于首次让模型接受了「干不干得好」的落地考核。

工程现场需要的是高容错、强判断、懂规则、能执行的助手,而 DrafterBench 正是在为这一目标提供数据支持与路径验证。

接下来,研究团队还将扩展任务类型至图纸校审、规范检测、施工日志智能生成等更多工程应用场景,持续拓展模型能力边界。

你有模型,DrafterBench 有任务。

看看你的模型,能不能真在图纸上动真格。