梦晨发自凹非寺

量子位 | 公众号 QbitAI

DeepSeek R1 横空出世第 128 天,已经把整个大模型市场搅得天翻地覆!

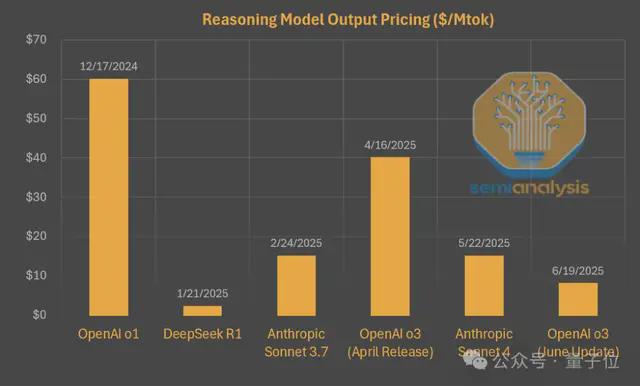

首先,它以一己之力把推理模型的价格打下来,OpenAI 六月更新的 o3 价格相比 o1 直接打了 2 折。

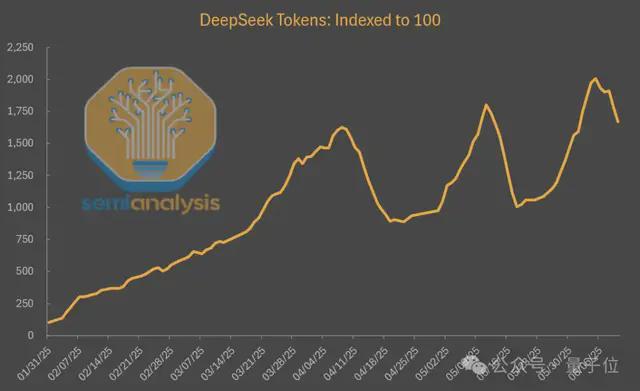

其次,第三方平台托管的 DeepSeek 模型使用量疯狂增长,比刚发布时涨了将近 20 倍,成就了大批云计算厂商。

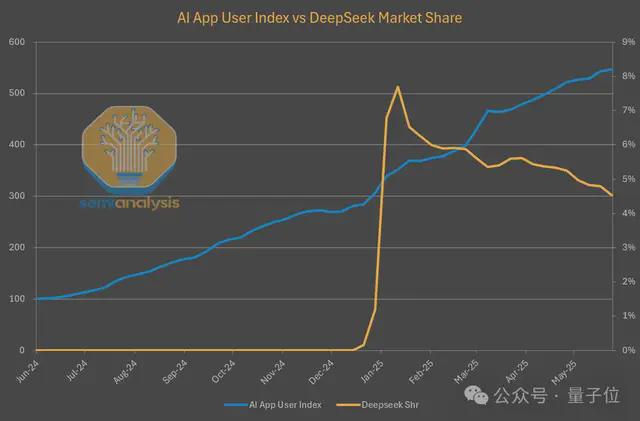

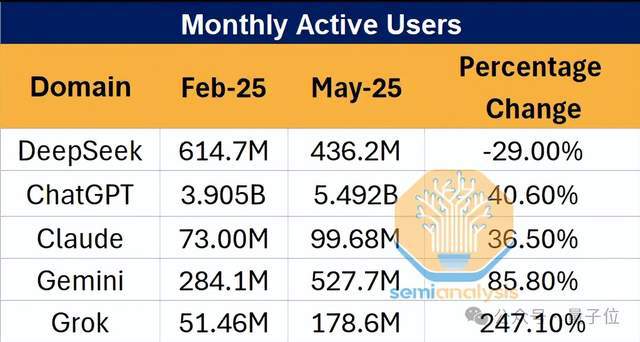

然而,DeepSeek 自家的网站和 API 市场份额却不断下降,跟不上 AI 产品上半年持续增长的节奏了。

以上数据来自 SemiAnalysis 发布的一篇报告,详尽解读了 DeepSeek 对 AI 模型竞赛的影响以及 AI 市场份额的现状。

揭开 DeepSeek 的降本秘诀

DeepSeek 刚发布时确实火得一塌糊涂,但四个多月过去了,情况却有点微妙。

从数据来看,DeepSeek 自家网站和 API 的流量不升反降,市场份额也在持续下滑。

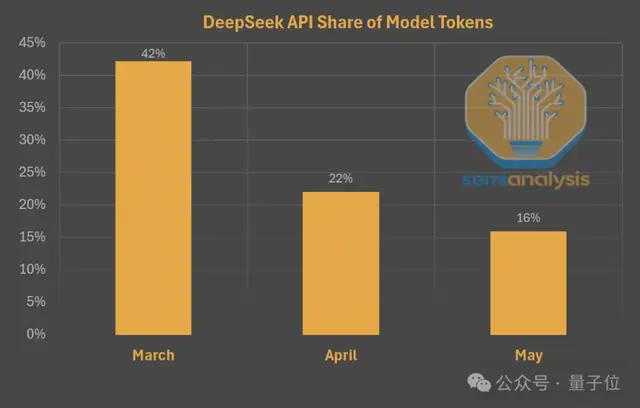

到了 5 月,全网 DeepSeek 模型产生的 token 中,来自 DeepSeek 本家的份额已经只占 16% 了。

网页版聊天机器人流量也大幅下降,而同期其他主要大模型网页版流量都在飙升。

DeepSeek V3 与 R1 模型都经过版本更新,能力与 1 月相比更强了,价格又便宜,怎么用户反而跑了呢?

这种“墙内开花墙外香”的现象,背后其实大有文章。

SemiAnalysis 指出,DeepSeek 为了把成本压到极致,在服务质量上还是做了大量妥协。

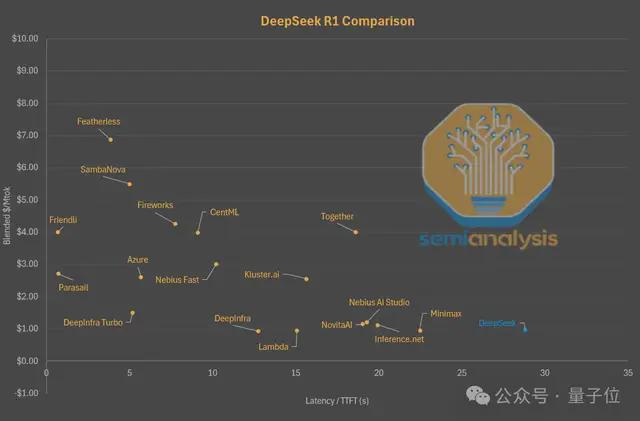

用户在 DeepSeek 官方平台上使用模型,经常要等上好几秒才能看到第一个字蹦出来,可以用首 token 延迟(First token latency)这个指标来衡量。

相比之下,其他平台虽然普遍价格更贵,但响应速度快得多,有些甚至能做到几乎零延迟。

在 Parasail 或 Friendli 等平台,只需支付3-4 美元就可以获得几乎没有延迟的 100 万 token 额度。

如果想选择更大更稳定的服务商,微软 Azure 平台价格是 DeepSeek 官方的 2.5 倍,但延迟减少了整整 25 秒。

从另一个角度看,DeepSeek 官方甚至不是同等延迟下价格最低的一家 DeepSeek 模型服务商。

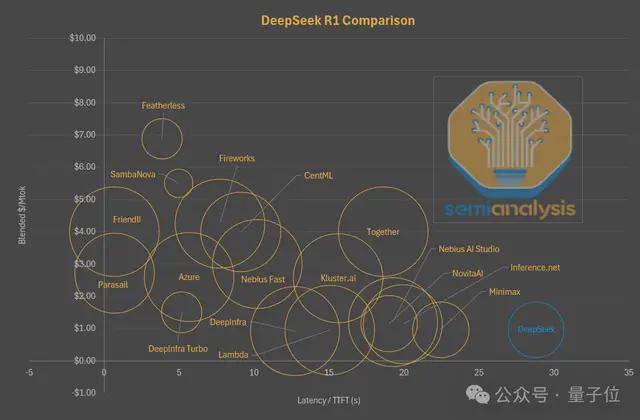

如果在这张图上用气泡大小表示上下文窗口,可以看出 DeepSeek 在价格与性能之间的另一个权衡。

在有限的推理计算资源下,只提供 64k 上下文窗口的服务,在主流模型提供商中算是最小的之一。

在需要读取整个代码库的编程场景里,64K 根本不够用,用户只能选择第三方平台。

而同样价格下,Lambda 和 Nebius 等平台能提供 2.5 倍以上的上下文窗口。

DeepSeek 还把很多用户的请求打包在一起处理,虽然每个 token 的成本降下来了,但每个用户等待的时间也增加了。

大模型下半场:提升每个 token 的智能

需要明确的是,这些降本策略都是 DeepSeek 主动做出的决定。

他们目前看上去对用户体验不怎么感兴趣,既无意从用户身上赚钱,也无意通过聊天应用或 API 服务向用户提供大量 token,更多地是专注于实现 AGI。

从这些优化策略就可以看出,DeepSeek 把尽可能少的算力用作推理服务给外部使用,大量的算力资源留在内部研发用途。

同时配合开源策略,让其他云服务托管他们的模型,赢得影响力和培养生态,两不耽误。

说到底,AI 竞赛拼的还是算力资源。

在 DeepSeek 影响下,Claude 也开始降低速度缓解算力紧张的问题,但为了营收还是在努力平衡用户体验。

Claude 4 Sonnet 发布以来,输出速度已经下降了 40%,但仍然比 DeepSeek 快不少。

另外 Claude 模型被设计成生成更简洁的回复,回答同样的问题,DeepSeek 和 Gemini 可能要多花 3 倍的 token。

种种迹象表明,大模型供应商正在多维度地改进模型。

不仅仅是提高模型的智能上限,而是提升每个 token 能提供的智能。

参考链接:

[1]https://semianalysis.com/2025/07/03/deepseek-debrief-128-days-later/