谷歌推出开源框架 LMEval,为大语言模型和多模态模型提供标准化的评测工具。评测新型 AI 模型一直是个难题。不同供应商使用各自的 API、数据格式和基准设置,导致跨模型比较耗时且复杂。

而谷歌最新推出的 LMEval 开源框架直击这一痛点,研究人员和开发者只需设置一次基准,就能展开标准化的评测流程,大幅简化了评测工作,节省了时间和资源。

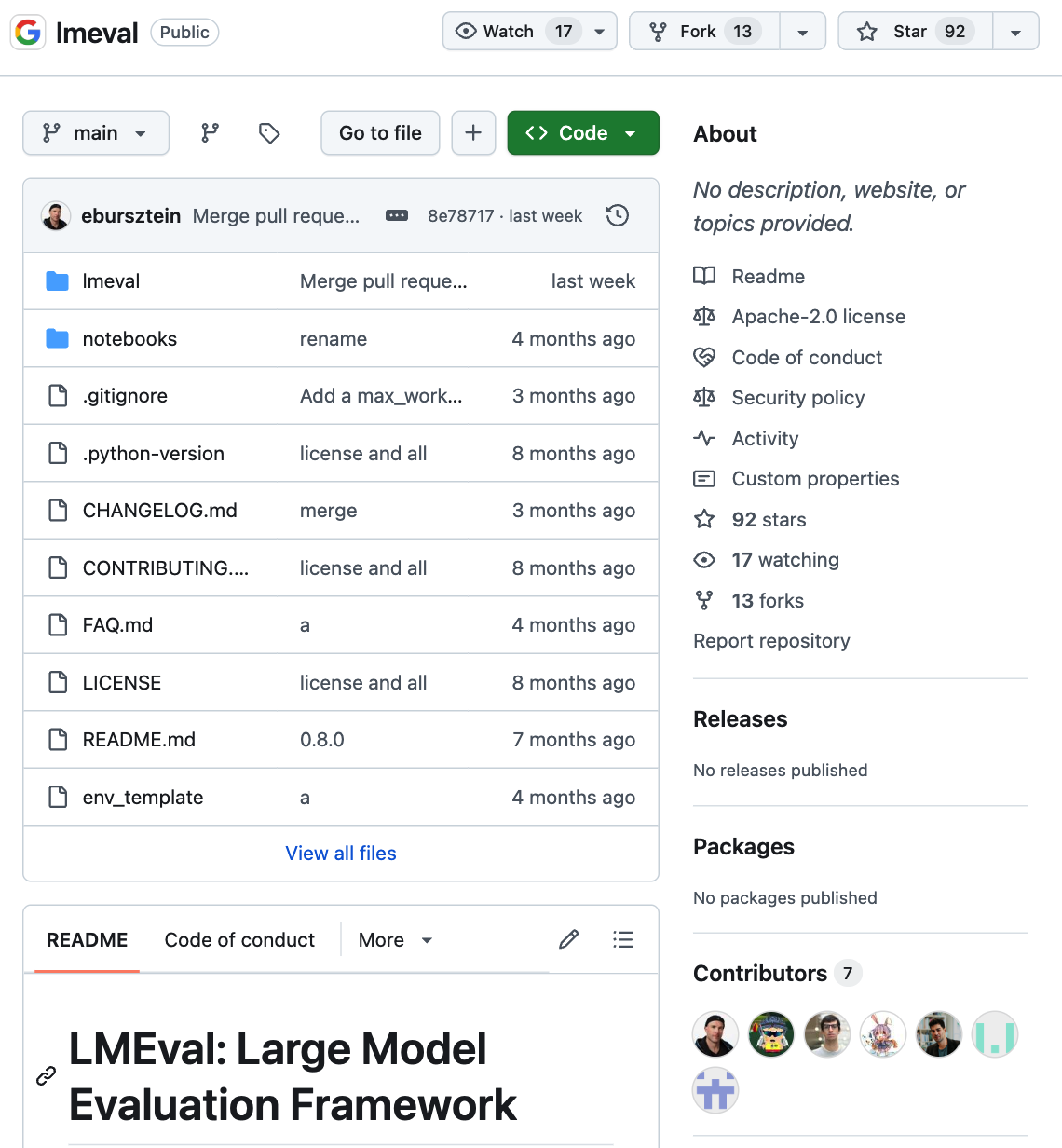

https://github.com/google/lmeval

LMEval 还通过 LiteLLM 框架抹平了 Google、OpenAI、Anthropic、Ollama 和 Hugging Face 等平台之间的接口差异,确保测试跨平台无缝运行。

LMEval 不仅支持文本评测,还涵盖图像和代码等领域的基准测试,且新输入格式可轻松扩展,框架支持是非题、多选题和自由文本生成等多种评估类型。同时,该框架能识别模型采用的 “规避策略”,即故意给出模糊回答以避免生成有风险内容。