新智元报道

编辑:KingHZ

1% 合成数据,就能让 AI 模型瞬间崩溃!如此颠覆性发现,只因未引用他人论文,ICLR 区域主席直接拒稿,好在作者成功 rebuttal,论文最终选为 Spotlight。而背后,竟是一桩图灵奖得主 Yann Lecun 关注的学界争议!

ICLR 2025,公开审稿,多级反转!

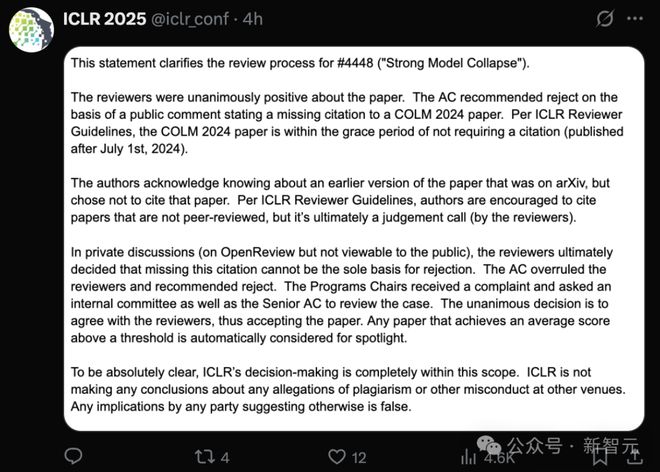

只因没有引用 COLM 2024 会议的一篇论文,区域主席根据公开评论,竟建议拒绝投稿论文!

虽然最终论文《强模型崩溃》(Strong Model Collapse)被接受,并选为亮点论文(Spotlight),但过程可谓危险至极!

去年,该论文在 Arxiv 上公开,动摇了对合成数据的认知,迎来了大波关注。

来自 Meta 等研究机构证实:1% 合成数据,就能让模型瞬间崩溃。

作者将文章投稿 ICLR 2025 后,审稿人对这篇论文的评价一致为正面。

区域主席(Area Chair),基于公开评论建议拒绝该论文,只因缺少对 COLM 2024 论文的引用。

即便在 OpenReview 上的私下讨论(公众无法查看)中,审稿人最终决定,缺少这篇引用不能成为拒绝的唯一依据。

但区域主席推翻了审稿人的意见,建议拒绝了此论文。

收到投诉后,ICLR 决定审查此案。

调查后,一致决定支持审稿人的意见,因此最终接受了这篇论文。

任何平均得分高于阈值的论文,将自动考虑作为亮点论文。

评审意见主页:https://openreview.net/forum?id=et5l9qPUhm

公开评审:李鬼倒打李逵?

对 ICLR 论文提出疑问的斯坦福大学 CS 博士生 Rylan Schaeffer,他是 COLM 2024 下列论文的作者。

他强调,ICLR 2025 的论文《强模型崩溃》作者,故意不引用 COLM 2024 论文:

1. 他们明确知晓有一篇先前的已发布工作,直接与他们的叙述和科学主张相矛盾;

2. 他们使用了该先前工作中提出的方法论,而同时又侮辱了该工作并未给予应有的致谢。

他坚持认为 ICLR 2025 投稿论文是故意压制矛盾证据,混淆对模型崩溃(潜在)危害的理解。

ICLR 的作者就是赤裸裸的学术不端,是科学界的耻辱!

特别是对于 ICLR 没有引用他写作的 COLM 2024 论文,他认为这无法忍受。

我们恳请评审专家和区域主席要求《强模型崩溃》的作者解决以下问题:

1. 此项工作与现有关于避免模型崩溃文献的关系,

2. 如何解释看似矛盾的结论产生的不同建模假设,以及哪种假设最能反映现实场景。

评估哪些假设最符合现实场景对于评估这项工作的实际影响至关重要。

在去年,Rylan Schaeffer 就表示,如果对模型崩溃(model collapse)有兴趣,强烈要求阅读他们的 COLM 2024 论文。

反驳:Rylan Schaeffer 才是抄袭者

在得到会议程序委员会及历任主席一致认同后,ICLR 论文一作 Elvis Dohmatob,在X上公开回应了 Rylan Schaeffer 的指责,认为 Rylan Schaeffer 存在严重的不当行为:

抄袭我们的先前工作,

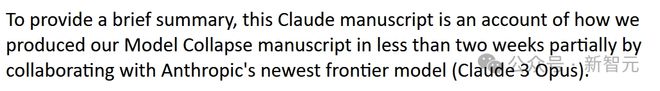

论文内容主要由人工智能生成(是的,作者将我们的论文输入到 LLM 中生成了另一篇论文),

违反伦理审查委员会(IRB)规定等。

在长时间的双方沟通中,这些问题逐步被揭露出来。

在帖子后,ICLR 2025 官方账号,澄清了提交论文 4488 评审的过程,真如开头所言。

NYU 教授还原全过程

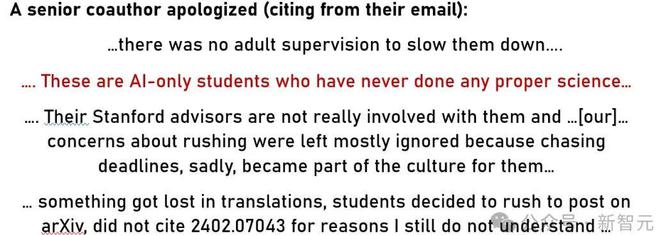

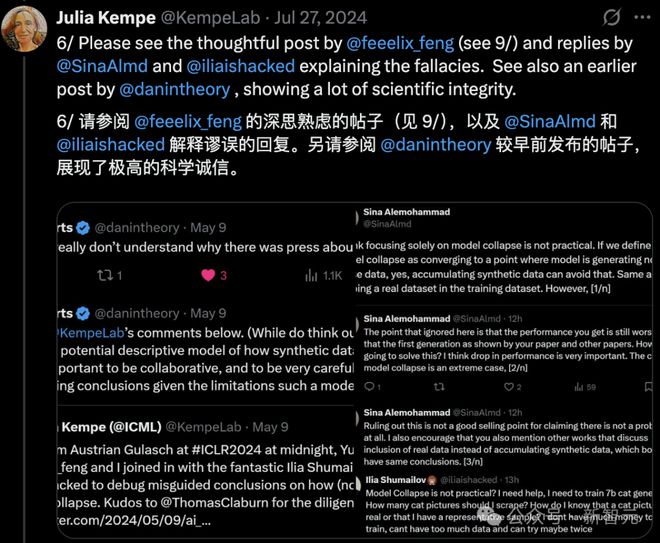

去年,《强模型崩溃》的作者 Julia Kempe 和「李鬼」Rylan Schaeffer 多次沟通,公开了论文其他作者的道歉邮件。

特别是,模型崩溃、混合原始数据与合成数据等领域已有很多优秀论文的情况下(包括在《自然》杂志上发表的文章),当 Gerstgrasser 等人首次向发送他们《模型崩溃是不可避免的吗?》的 v1 版本时,很少有对一发表论文的相关讨论。

甚至有 Rylan Schaeffer 的合著者表示论文粗制滥造, 就是赶鸭子上架:

他们斯坦福的导师跟他们来往并不密切。

学生赶在截止日期前,马上提交论文。我们对论文粗制滥造的关切,几乎被漠视了。

可悲的是,这已经成为他们的文化的一部分。

至于没有引用相关论文的原因,我直到现在仍然不明白。

更加惊讶的是,「李鬼」Rylan Schaeffer 所谓的「模型坍塌必读理论」,是 Julia Kempe 之前定理的一个微不足道的推论,而且 Rylan Schaeffer 的论文还具有误导性。

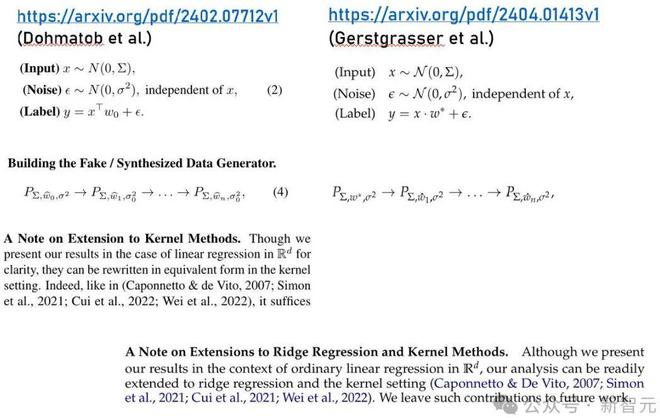

但奇怪的是,这些公式化的表述与论文中的语言相似,符号也古怪地相似:

左:「李逵」的论文符号,右:「李鬼」的论文符号

然而,随后 Julia Kempe 等明白了!

在指出了最明显的遗漏后,「李鬼」论文的作者等人发送了一份报告,暗示 Julia Kempe 等人的反馈,被 AI 用来合成论文。

Julia Kempe 等人被当作免费劳动力使用,这令 Julia Kempe 大开眼界!

但可悲的是,Rylan Schaeffer 等人的论文虽被 COLM 2024 接受,但仍然包含误导性结论。

在涉及到个人学术声誉的斗争中,Julia Kempe 也得到了同事的支持,甚至得到了图灵奖得主、AI 大佬 Yann Lecun 的关注和支持!

模型崩溃与合成数据

双方的焦点在于「模型崩溃」。

第 1 点:关于 Gerstgrasser 等人的论文与先前工作的科学矛盾。

Gerstgrasser 等人的论文,并没有以任何有意义的方式避免模型崩溃。

正方 Julia Kempe 等人,在 ICLR 2025 论文中,明确将「模型崩溃」定义为「AI 模型性能的重大下降」。

避免模型崩溃意味着:缩小使用真实数据和合成数据训练时的性能差距。

反方 Rylan Schaeffer、Gerstgrasser 等人,将避免模型崩溃定义为:「在多次训练模型时,防止发生递归性退化」。

该论文承认,尽管当样本逐渐积累时,性能退化是有界的,但仍然存在性能损失。

这一定义仅代表了缩小真实数据和合成数据之间差距的部分条件。从这个意义上讲,Gerstgrasser 等人并未解决或缓解模型崩溃问题。

在关于模型崩溃的大多数文献中,主流观点认为,缩小性能差距是避免模型崩溃的主要标准。

从实际角度来看,缩小真实数据与合成数据之间的差距,是避免模型崩溃的更具操作性和相关性的定义。

仅仅确保性能不出现发散,仍然可能导致模型无法匹配合成数据生成器的质量,从而使合成数据对性能造成损害。

只有当性能差距完全缩小时,合成数据的负面影响才能完全减轻。

由于定义和理由上的差异,考虑到缩小性能差距是正确的定义,通过这一广泛接受的视角,正方 Julia Kempe 等人已经重新审视了所有关于模型崩溃的相关工作。

第二点:与 Gerstgrasser 等人的先前互动

不幸的是,公开评论似乎破坏了审稿过程的匿名性。

正反双方的确有过互动。

以下是该互动的简要总结:

-

技术上不足:Gerstgrasser 等人的论文只是增量性的技术贡献,而且非常薄弱。它不过是对已有论文的已有设定和论点的轻微修改。其结果是已有定理的简单推论。

-

误导性/不准确的结论:Gerstgrasser 等人的论文并未以任何合理的方式解决模型崩溃问题(请参见上文关于定义的讨论)。

不幸的是,Gerstgrasser 等人,基本上忽视了互动的建设性批评,甚至将评论仅作为脚注,附在论文的末尾。

因此,在目前的状态下,正方仍然认为 Gerstgrasser 等人的论文,在科学上并不成立,因此没有觉得有必要引用。

最终的论文结果,说明荣耀应该归于 Julia kempe 等人。

这也与此前领域内专家的意见一致。

参考资料:

https://x.com/dohmatobelvis/status/1911107171078615088