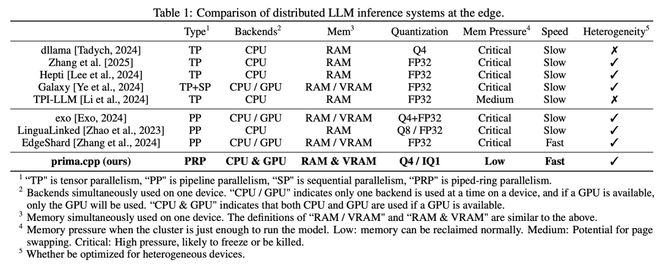

在这项工作中,来自默罕默德本扎耶德人工智能大学和电子科技大学的研究团队提出了一个分布式推理系统 prima.cpp,其可以在日常家用设备上运行 70B 规模的模型,混合使用 CPU/GPU、低 RAM/VRAM、Wi-Fi 和跨平台支持。

该系统使用 mmap 管理模型权重,并通过预取引入管道环并行,以隐藏磁盘负载。通过对计算、通信、磁盘、内存(及其管理行为)和操作系统的异构性进行建模,它可以将模型层最优化地分配给每个设备的 CPU 和 GPU,从而进一步减少 token 延迟。他们提出了 Halda 算法来解决这一 NP 难分配问题。

他们在常见的四节点家庭集群上对 prima.cpp 进行了评估。在 30B+ 模型上,prima.cpp 的性能优于 llama.cpp、exo 和 dllama,同时内存压力保持在 6% 以下。这为家庭助手带来了前沿 30B-70B 模型,使高级人工智能真正为个人所用。

论文链接: