昆仑万维天工团队宣布推出全新升级的 Skywork-OR1 (Open Reasoner 1) 系列模型。

该系列在同等参数规模下实现了业界领先的推理性能,进一步突破了大模型在逻辑理解与复杂任务求解方面的能力瓶颈。同时,Skywork-OR1 全面开放、免费使用,以完全开源的形式回馈开发者社区,坚定践行天工团队在推动 AI 技术发展上的开源路线。

此次开源涵盖三款高性能模型,包括:

- Skywork-OR1-Math-7B:聚焦数学领域的专项模型,同时也具有较强的代码能力。

- Skywork-OR1-7B-Preview:融合数学与代码能力、兼具通用性与专业性的通用模型。

- Skywork-OR1-32B-Preview:面向更高复杂度任务、具备更强推理能力的旗舰版本。

公告称,此次发布的 Skywork-OR1 系列采用业界最高透明度的开源策略:不同于其他前沿开源推理模型仅开放模型权重,项目团队全面开源了模型权重、训练数据集和完整训练代码。

配套的技术博客已发布于 Notion 平台,详细阐述了数据处理流程、训练方法和关键技术发现,为社区提供了完全可复现的实践参考。

昆仑万维方面表示,目前 Skywork-OR1-7B 和 Skywork-OR1-32B 的能力还在持续提升,预计将在两周内发布两个模型的正式版本,同时推出更为系统详尽的技术报告,进一步分享其在推理模型训练中的经验与洞察。“我们相信,这种全方位的开源策略将有助于推动整个 AI 社区在推理能力研究上的共同进步。”

在数学推理任务中:

-

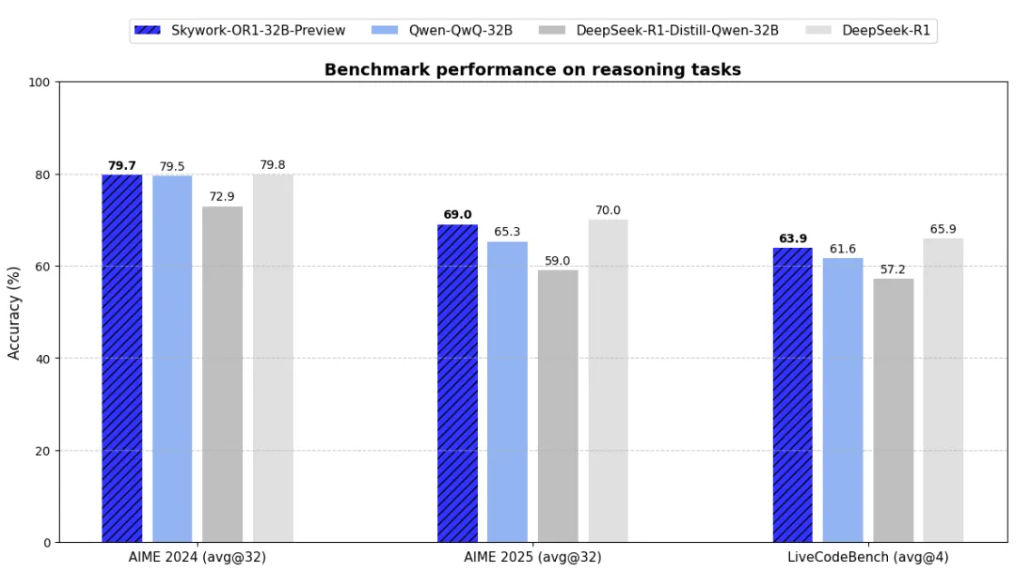

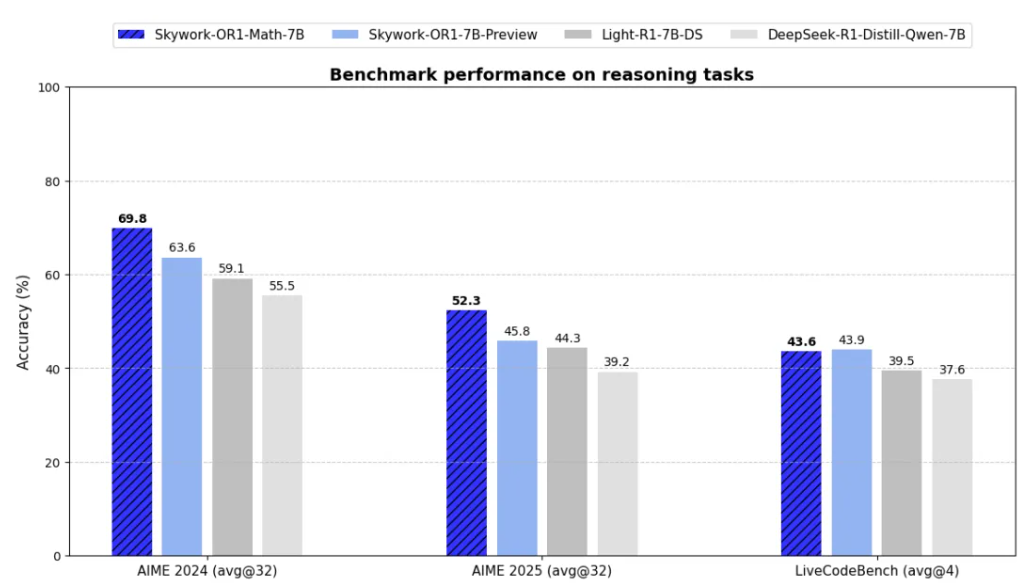

通用模型 Skywork-OR1-7B-Preview 和 Skywork-OR1-32B-Preview 在 AIME24 与 AIME25 数据集上均实现了同参数规模下的最优表现,展现出强大的数学推理能力。

-

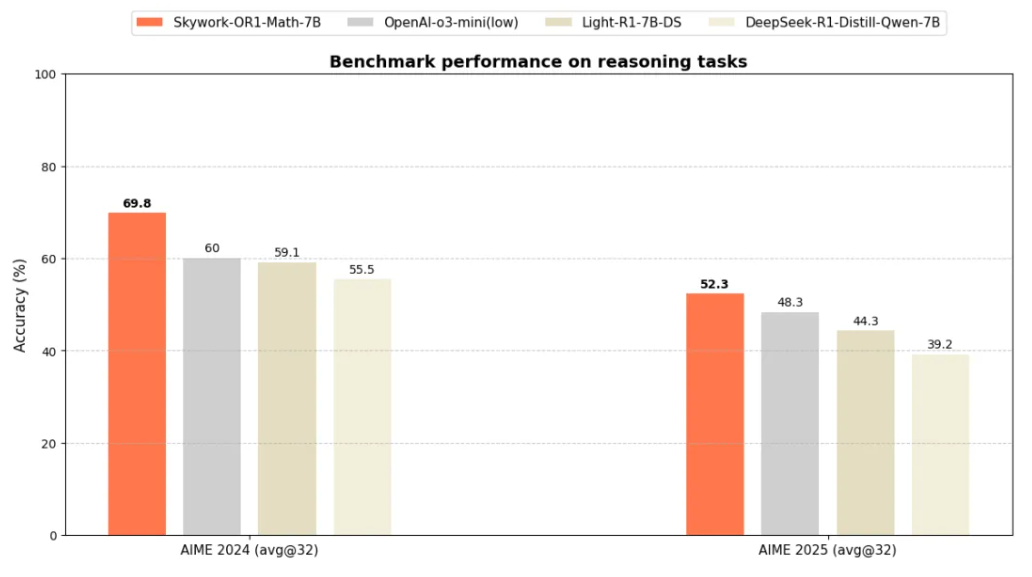

针对数学场景深度优化的专项模型 Skywork-OR1-Math-7B 更是在 AIME24 和 AIME25 上分别取得 69.8 与 52.3 的高分,远超当前主流 7B 级别模型,充分验证了其在高阶数学推理任务中的专业优势。

-

Skywork-OR1-32B-Preview 在所有 benchmark 上均实现了对 QwQ-32B 的超越,并在更难的 AIME25 上基本与 R1 持平。

在竞赛编程任务中:

-

通用模型 Skywork-OR1-7B-Preview 与 Skywork-OR1-32B-Preview 在 LiveCodeBench 数据集上均取得了同等参数规模下的最优性能。

-

Skywork-OR1-32B-Preview 表现尤为突出,其代码生成与问题求解能力已接近 DeepSeek-R1(参数规模高达 671B),在大幅压缩模型体量的同时实现了卓越的性价比,充分展现出天工团队训练策略的先进性。

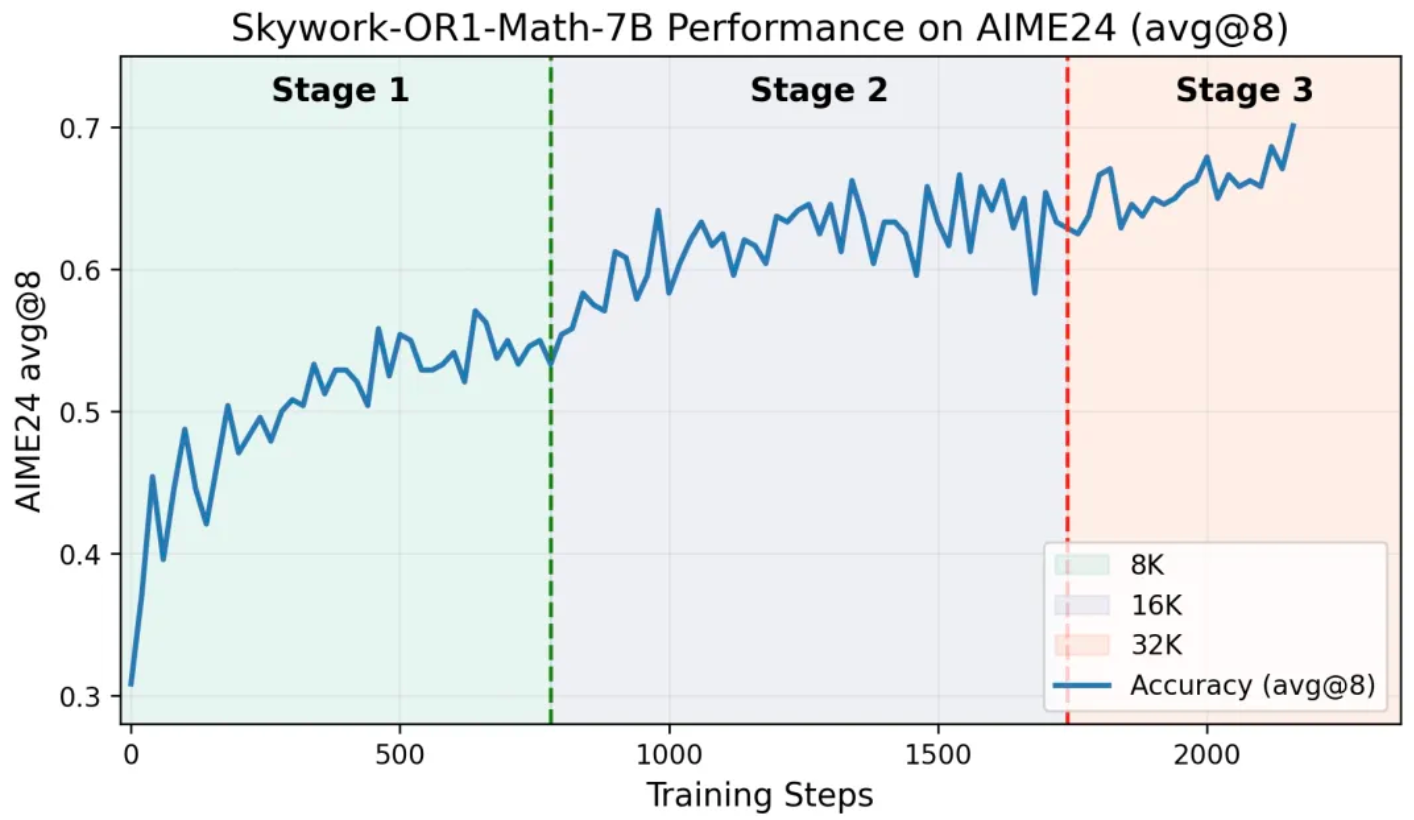

其中 Skywork-OR1-Math-7B 表现尤为亮眼,作为一个专注于数学推理能力的 7B 参数模型,通过多阶段 GRPO 训练在复杂数学问题上实现了卓越表现,同时在代码任务上也有较强的泛化能力。下图是该模型在 AIME24 上的训练准确率曲线:

Skywork-OR1-Math-7B 最终模型在 AIME24 和 AIME24 上分别达到 69.8% 和 52.3%,超越了 OpenAI-o3-mini (low),达到了当前尺寸 SOTA 性能。值得注意的是,尽管该模型训练过程中未专门针对代码能力进行优化,但在代码评测基准上 Livecodebench 从 37.6% 提升到 43.6%,相比基线模型的显著提升。