新智元报道

编辑:编辑部 NYH

GPT-4.5 比 GPT-4 聪明 10 倍!其背后的研发故事却鲜为人知。奥特曼携 OpenAI 团队首次敞开心扉,分享了幕后细节。从海量算力引发的「基础设施危机」,到「torch.sum bug」带来的意外突破,团队讲述了在挑战中实现智能飞跃。

GPT-4.5 出世一个多月,鲜有人知其背后研发故事。

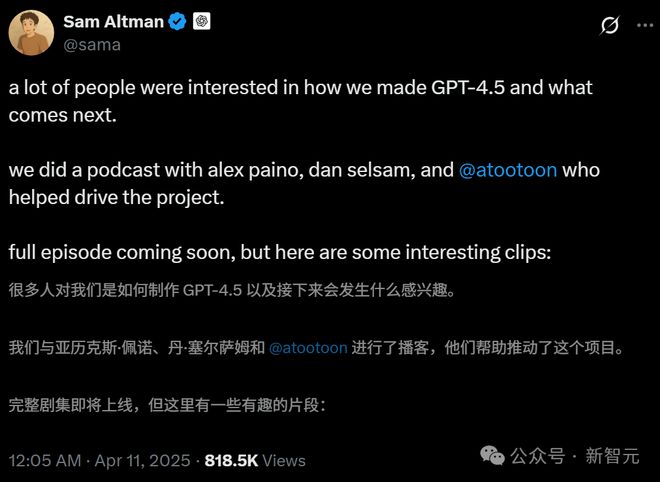

今天凌晨,奥特曼与三位核心研究员在线开启播客对谈,首次揭开了 GPT-4.5 从愿景到现实的史诗级突破。

早在两年前,OpenAI 团队定下了一个大胆的目标,打造一款比 GPT-4 聪明 10 倍的模型。

这不仅意味着 LLM 性能提升,更是对计算、数据、协作的极限挑战。

从左到右:奥特曼、Alex Paino、Amin Tootoonchian 和 Daniel Selsam

如今,OpenAI 在 2 月底正式交卷,GPT-4.5 情商堪称所有模型最强的,并再次 Scaling 无监督学习的边界。

这款「超级模型」究竟如何创造智能奇迹,全部浓缩在了这 45 分钟的圆桌对谈中。

一些精彩亮点:

-

GPT-4.5 比 GPT-4 聪明 10 倍,研发用时 2 年,拥有上一代不具备的微妙「魔力」

-

训练 GPT-4.5 为 OpenAI 提供了宝贵的技术经验;现只需要大约 5 名员工,就可以从头开始训练 GPT-4

-

算力基础设施和大规模 GPU 扩展带来的小概率问题会捅出大乱子

-

数据效率成为关键瓶颈,OpenAI 下一个主要研究前沿是提高数据效率

-

「torch.sum bug」等趣事推动模型性能飞跃。

-

Scaling Law 被验证为可能长期有效的「宇宙规律」

GPT-4.5 聪明 10 倍

奥特曼开篇说,通常他们开这种会都是为了发布新产品,不过这次打算换个玩法,聊聊 GPT-4.5 开发背后的故事。

GPT-4.5 推出后,用户对它的兴趣特别大,这大大超出了研发团队的预期。

他们首先从「一个巨型模型到底需要什么?」这个话题说起。

「一大堆人、一大把时间,还有海量的计算资源。」主要负责预训练数据的 Alex 回答说。

Alex 表示,他们光是准备阶段就花了很多心思,至于正式的训练,「本身就是个超级大的工程」。

在实际训练中,研究团队经常得做选择:是推迟发布,等更多问题解决;还是早点上线,边跑边解决问题。

这是个平衡,不能让整个训练过程拖得太久。

他们谦虚地认为,对于效率更高的算法及以如何更好地利用现有数据,他们还只是「略知皮毛」。

在不久之前,我们还在受限于算力。但从 GPT-4.5 开始,我们更多地是处在一个受限于数据的环境里了。

他们说这是一个颠覆性的进展,「整个世界对此还没有充分认识到。」

两年前着手开发 GPT-4.5 时,他们的目标是比 GPT-4 聪明 10 倍。

现在,他们觉得自己达到了这个目标——至少在投入的有效算力下,GPT-4.5 实现了比 GPT-4 聪明 10 倍的效果。

预训练的两个难题

不过,实际的训练时间还是比预想的要长不少。

这里面主要有两个问题。

一个是从 1 万个 GPU 增加到 10 万个 GPU,问题会变得多得多。

尤其是一些提前没预料到的小概率问题,在大规模计算时会捅出大乱子。

最容易出问题的就是算力基础设施,由于他们的数据量实在是太大了,有些问题连硬件制造商都没遇见过。

网络架构、单个加速器,这些都会出问题。「我们的工作就是尽量把这些变量的波动降到最低。」

另一个问题是探索前沿科技这件事本身就很难。

在训练 GPT-4.5 时,OpenAI 投入了几百人的努力,耗费了大量的时间,几乎是 all in。

但如果他们现在重新训练一个 GPT-4 水平的模型,大概只需要 5 到 10 个人就可以搞定。

专注于数据效率和算法的 Dan 说,「我觉得做任何新东西都难。但是当你知道别人已经做成过某件事,难度就会大大降低」。

「因为最难的部分是下定决心去做一件事。知道某件事是可行的,简直就像开了挂,瞬间就容易多了。」

Dan 接着表示,如果想要将训练规模再扩大 10 倍甚至是 100 倍,数据就会成为瓶颈,这时候就需要一些算法上的创新,让模型能用更多的算力从同样的数据里学到更多东西。

torch.sum bug 趣事

研究团队在 GPT-4.5 的训练中,发现了一些特别有趣的事情。

比如,在训练过程中不断地优化机器学习算法,做出一些调整。

尤其是团队解决了一些关键问题后,他们看到了模型性能的大幅提升。

那一刻,整个团队的能量都不一样了,大家都特别兴奋,动力满满,要把最后阶段冲刺完成。

「那一刻真的很震撼。这对团队士气的提升,真的特别美妙。」

现场 OpenAI 的首席系统架构师 Amin Chian 分享了一个「torch.sum bug」趣事。

在训练过程中遇到 bug 是常事,通常是找一下到底是硬件故障、数据损坏,还是机器学习相关的 Bug。

但在训练 GPT-4.5 时,有一次好几个问题一直都没有解决。

大家没办法就在一起讨论研究这些问题到底是由不同的 Bug 引起的,还是同一个 Bug 导致的。

他们围着桌子投票。结果呢?后来确定的那个 Bug 在当时得票最少!

就是个简单的「torch.sum」Bug,来自上游的 PyTorch 库,大家都觉得太不可思议了。

所有的问题都被这一行代码给解决了,真的特别有趣。

为了庆祝,他们还把 Slack 频道从「多 Bug 理论」改成了「单 Bug 理论」,那场面可热闹了。

这个 Bug 的触发频率特别低,可能每 100 步、1000 步才出一次问题,特别容易被忽略。

但他们有条纪律,在训练过程中不能容忍这种问题出现。

整个过程就是一个坚持不放弃的故事。

压缩即智能

几十年来,深度学习的核心一直是提升算力效率。而且,每一次小的改进,都能带来显著的叠加效应。

世界上各地不同的人发现一个提升 10% 效率的技巧,另一个提出提升 20% 的优化,这些看似微小的进步累积起来,就能彻底改变模型的表现。

过去,因算力受限,数据效率的研究显得并不划算。但如今,数据效率每一次突破都将可能成为 AI 发展的临界点。

因此,现在就去预测 AI 会有瓶颈,有点不明智。

他们还认为更好的预训练和无监督学习能全面提升模型的智能,帮助模型更好地泛化,这一点跟现在模型的推理能力很是互补。

预训练本质上是在压缩数据。压缩数据意味着发现不同事物之间的联系、类比和抽象。而推理则针对某个具体问题,需要一种谨慎思考的技巧。

这种谨慎思考能解锁很多不同领域的问题,但预训练在跨领域压缩数据时,学到的是一种更抽象的东西。

为什么无监督学习会有效?研究员们的答案是「压缩」。

可以说,理想的智能形态就是所谓的「所罗门诺夫归纳」(Solomonov induction)。

简单来说,模型更倾向于简洁的解释。与此同时,它严格遵循贝叶斯原理,把所有可能性都记住,随时根据新信息更新自己的回答。

而他们现在做的预训练——或者说理解预训练的一个视角——就是在做这种「压缩」。

试图找到一个最短的程序(或者模型),来解释所有的数据,以此作为对理想智能的一种近似。

Scaling Law 是宇宙法则

在播客的最后,奥特曼表示,训练 GPT-4.5 的整个过程,花了无数的人力、时间和金钱,其实可以看成是一场实验。

一场验证 Scaling Law 是不是还成立的实验。

结果他们发现,Scaling Law 不仅有效,而且还可能会持续很长时间。

奥特曼说他接受 Scaling Law 就像接受量子力学一样,还不明白为什么 Scaling Law 会是一种宇宙的规律。

对此 Dan 试着解释说,模型数据压缩得越多,智能就越高,这个有很强的哲学依据。

他自己比较喜欢的一个解释是,世界上数据的「关键概念」是稀疏的,符合幂律分布(power law)。

比如,第 100 个重要的概念,可能在每 100 个文档里只出现一次。

也就是说数据有很强的「长尾效应」。

所以现实是,如果你想抓到「尾巴」里下一个重要的东西,可能得把算力和数据量翻个十倍。

而这个尾巴还很长,可以一直挖下去。

参考资料: