刚刚,Moonshot AI (月之暗面) 正式开源发布了两款全新的视觉语言模型 Kimi-VL 与 Kimi-VL-Thinking。

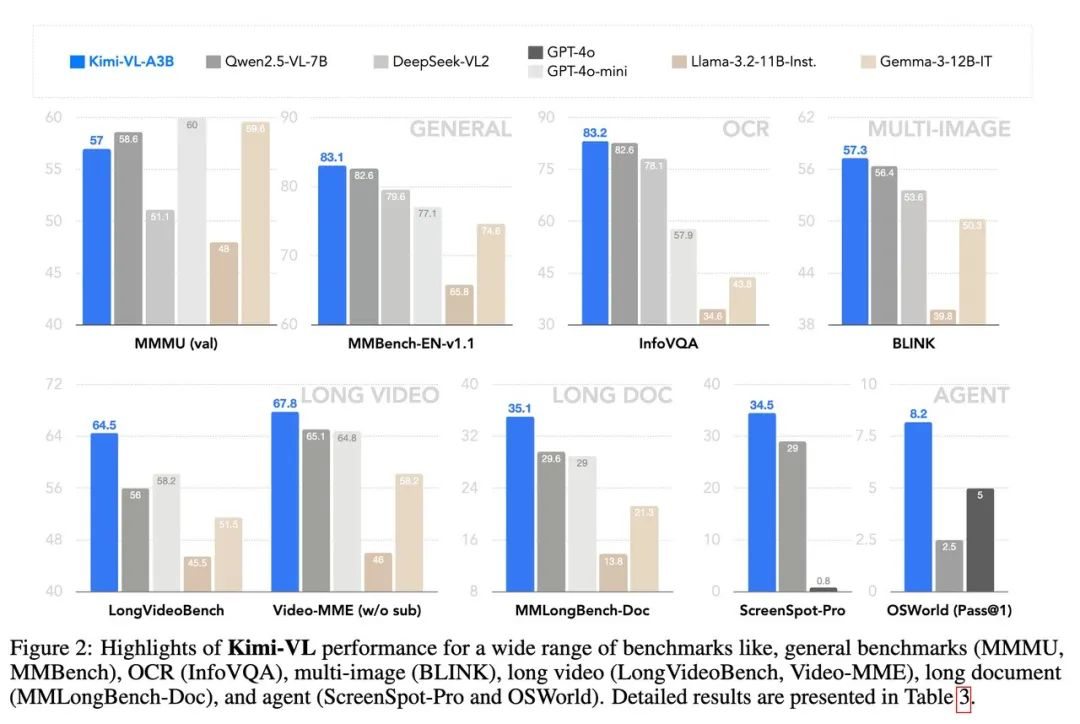

这两款模型在保持参数规模轻量的同时,展现出极强的多模态理解与推理能力,在多个关键基准测试中超越 GPT-4o 等大模型,彰显了其卓越的技术实力。

模型亮点一览:

-

轻量架构,推理强大

两款模型均采用 MoE(Mixture-of-Experts)架构,激活参数仅约 30 亿,远小于主流大模型的百亿级别,但依旧在多个基准测试中取得优异成绩。 -

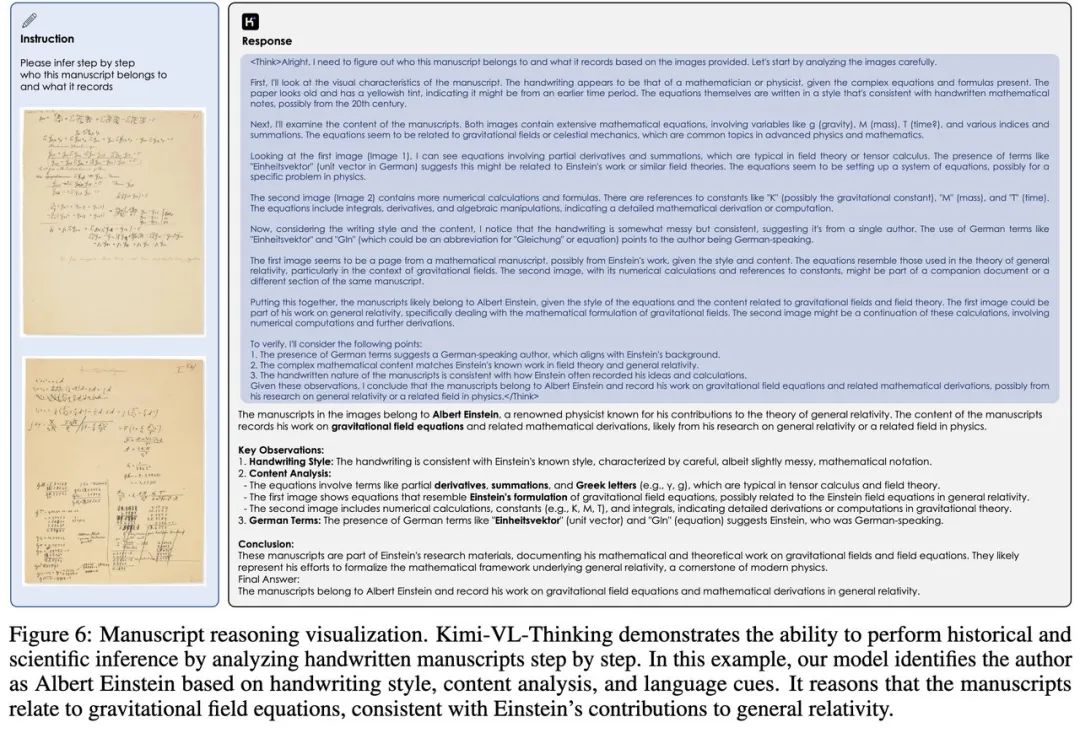

强多模态推理与智能体能力

-

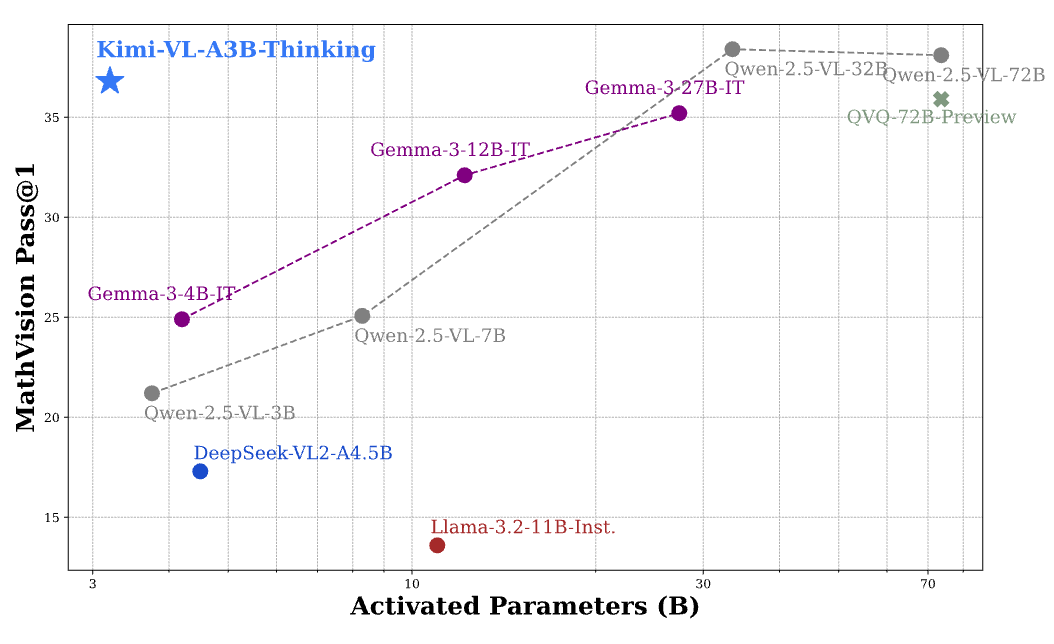

在 MathVision 多模态数学推理任务中取得 36.8% 的成绩,媲美参数量达其十倍的大模型。

-

在智能体操作任务 ScreenSpot-Pro 上达到 34.5%,展现出出色的复杂界面理解与执行力。

-

原生支持高分辨率图像处理

基于 MoonViT 架构,模型在 OCRBench 上得分高达 867,显示了强大的图文识别与理解能力。 -

超长上下文理解能力

支持长达 128K tokens 的上下文输入: -

在 MMLongBench-Doc 测试中达到 35.1%,

-

在 LongVideoBench 上取得 64.5% 的高分,适用于文档级、视频级等复杂长文本场景。

-

全面超越大型模型表现

在多个公开基准测试中,Kimi-VL 表现超越 GPT-4o 等参数量远高于自身的模型,证明轻量模型同样可以实现高性能。

获取方式

-

论文链接:Kimi-VL.pdf

-

Huggingface 项目页:Kimi-VL on Huggingface

Moonshot AI 表示,此次发布只是迈向通用多模态智能的一小步。他们期待社区开发者能基于 Kimi-VL 和 Kimi-VL-Thinking 构建出更多富有创意的应用场景,从文档问答到界面操作,从图文理解到视频分析,可能性无限。