图片来源:视觉中国

蓝鲸新闻 4 月 9 日讯(记者朱俊熹)开源霸主 Meta 近来陷入了尴尬的境地。当地时间 4 月 5 日,Meta 发布了全新的 Llama 4 系列模型。但很快便因为实测效果不及预期,而遭遇"刷榜"争议。

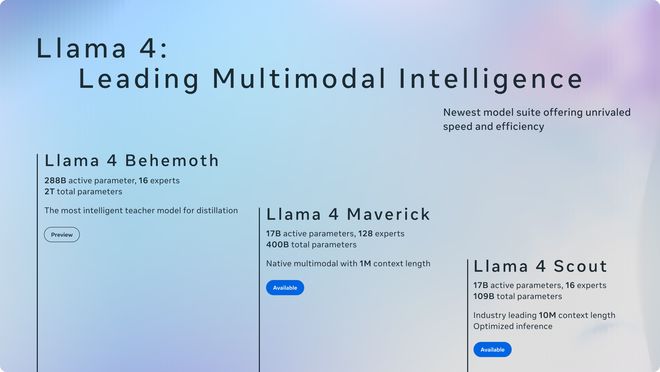

Meta 此次率先推出了 Llama 4 系列中的 Scout(侦察者)、Maverick(独行侠)两款模型,并预览了仍在训练中的 Behemoth(巨兽)模型。据其介绍,Llama 4 Maverick 在 LM Arena 评测榜中位居第二,超越了 ChatGPT-4o、DeepSeek-V3 等领先模型,仅次于谷歌的 Gemini 2.5 pro。

图片来源:Meta

但引起注意的是,Meta 在公告的注脚处提到,该项测试使用的是针对对话优化版的 Llama 4 Maverick 模型。4 月 8 日,LM Arena 平台在社交媒体X上回应称,"Meta 对我们政策的理解与我们对模型提供商的预期不符。Meta 本应更明确地说明‘Llama-4-Maverick-03-26-Experimental’是一个针对人类偏好优化的定制模型。"LM Arena 表示,将会添加 Maverick 的公开版本,并会对排行榜政策进行更新,以强化公平、可重复评估性。

LM Arena 模型基准测试平台由加州大学伯克利分校 SkyLab 的研究人员创建。有别于其他评测集,它采用的是众包的投票方式。在该平台上,用户可以向两个匿名的 AI 对话助手提出任何问题,投票选出认为更优的答案,以此评选得到最佳的大模型。

在关于 Llama 4 的回应中,LM Arena 提到,初步分析显示,风格和模型回应的语气是影响排名的重要因素,正在进行更深入的分析,表情符号的使用或许也会产生影响。一位国内大厂大模型从业者告诉蓝鲸新闻,用户在评测时,会偏向于选择回答更长的、活泼的、会夸人的模型。

根据 LM Arena 公布的评选过程不难发现,Llama 4 Maverick 实验版在回答时,篇幅要显著长于其他模型,语气更贴近真人对话,还会积极使用表情符号。但有使用者发现,当询问同样的问题时,用于 LM Arena 测试的实验版和部署在其他平台上的版本所生成的回复风格存在较大出入。

图片来源:Llama 4 Maverick 实验版生成的回复

北京理工大学研究语言模型评测与推理方向的博士生袁沛文对蓝鲸新闻表示,通过 LM Arena 所采用的众包形式,尽管大众的提问足够有泛化性,是模型训练时不可知的,但依然存在"刷榜"风险。LM Arena 平台主打盲测,但可以借助各种隐蔽的方式实现去匿名化,例如直接询问它是哪个模型、通过一些后门特征来判别模型,或通过水印技术检测出自家模型。在去匿名化之后,大模型厂商就可以通过海量 IP 来为自己的模型刷票。

除了众包投票外,业内也会采用其他的大模型评测方式,但当下都难以做到完全的客观、全面。据袁沛文介绍,最为广泛采用的评测形式是大模型 Benchmark(基准测试),即人类专家围绕某项任务来出题,让模型进行回答,看是否与人类期望相同。由于模型从互联网平台上获取训练语料,难免会掺杂一些基准测试。负责任的开发者会主动从训练集中过滤这部分测试集,也有人可能会采取相反的做法,甚至可能在后训练阶段让模型在一些主流基准测试上做强化,使其测试表现明显虚高,"就像训练时背过了题目和答案"。

此前 Meta 首席 AI 科学家、图灵奖得主杨立昆还参与发起了一项评测榜单 LiveBench,被称作"最难作弊"的榜单。LiveBench 主打提供具有挑战性、无污染的基准测试,每月对问题进行更新。袁沛文指出,虽然这能避免模型提前背题,但一个问题在于是否总能收集到足够多的数据实现更新。实际上,LiveBench 的更新频率也越来越慢,除本月的更新外,上一次更新还要追溯到五个月前。此外,一些垂类评测领域也无法被覆盖,难以知道模型在具体业务场景上的能力表现。

"不难发现,现有的范式都没法从根本上同时满足两个评测领域的核心愿景:一是可信,没有办法刷榜;二是可扩展,任何评测需求、能力、场景都能被满足。"袁沛文表示。

面对"刷榜"质疑风波,Meta 副总裁兼 GenAI 负责人 Ahmad Al-Dahle 在社交媒体上否认了在测试集上进行模型训练的说法,"我们绝不会这么做"。据其说法,用户感知到的质量差异是由于稳定性还没有完全调整到位。

抛开备受争议的 LM Arena 测试,Meta 公布的结果显示,Llama 4 Maverick 在部分基准测试上表现优于 GPT-4o、Gemini 2.0 Flash、DeepSeek-V3 等模型,但不及更为领先的 GPT-4.5、Claude 3.7 Sonnet、Gemini 2.5 Pro 等。尚未发布的 Llama 4 Behemoth 会在以 STEM 为重点的基准测试上对标这些顶尖模型。此外,目前 Meta 公布的模型中还没有类似 OpenAI o1、DeepSeek-R1 的推理模型。

自 DeepSeek 年初引发海内外热议以来,对此前在开源领域占据领先的 Meta 同样造成巨大冲击。据媒体此前报道,Meta 为此组建了多个专门的研究小组,对 DeepSeek 进行分析并希望借此改进 Llama 模型。

Meta 表示,全新的 Llama 4 模型是其首批使用 MoE(混合专家)架构的模型。DeepSeek-V3、阿里 Qwen2.5-Max 等模型也是基于 MoE 架构,在处理单个 token 时只激活模型中的部分参数,以实现更高的计算效率。

硅谷科技媒体 The Information 引述知情人士说法称,在过去一年多的时间里,Meta 的研究人员一直在激烈地争论,究竟要将 Llama 4 变成 MoE 模型还是延续一直采用的 Dense 模型。对 Meta 来说,做出改变技术方案的决定并不容易。