西风明敏发自凹非寺

量子位公众号 QbitAI

深夜重磅!阿里发布并开源首个端到端全模态大模型——

通义千问 Qwen2.5-Omni-7B,来了。

仅靠一个一体式模型,就能搞定文本、音频、图像、视频全模态,并实时生成文本和自然语音。

堪称 7B 模型的全能冠军。

你的 iPhone 搭载的很可能就是它!

现在打开 Qwen Chat,就能直接和它实时进行视频或语音交互:

话不多说,先来看一波能力展示。

在大街上同它视频通话,它能正确识别周围环境,按照你的需求为你推荐餐馆:

视频链接:https://mp.weixin.qq.com/s/VkJP89bpgZaxaKz-1wav9A

走进厨房,它又化身“智能菜谱”,一步步指导你变成大厨:

视频链接:https://mp.weixin.qq.com/s/VkJP89bpgZaxaKz-1wav9A

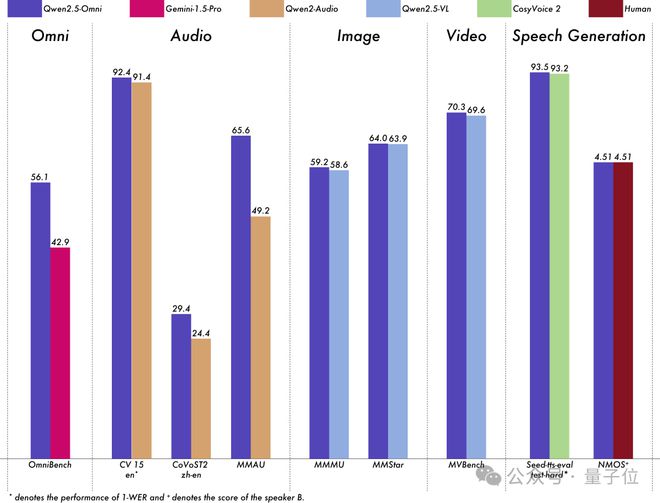

在多模态任务 OmniBench 评测中,Qwen2.5-Omni 表现刷新记录拿下新 SOTA,远超谷歌 Gemini-1.5-Pro 等同类模型。

在单模态的语音识别、翻译、音频理解、图像推理、视频理解、语音生成任务中,Qwen2.5-Omni 的全维度表现也都优于类似大小的单模态模型以及闭源模型。

在 seed-tts-eval 语音生成基准中,Qwen2.5-Omni 展现出与人类水平相当的语音合成能力。

这意味着 Qwen2.5-Omni-7B 能很好地和世界进行实时交互,甚至能轻松识别音视频情绪。

再来敲重点:

模型非常轻量,手机等终端都可轻松部署运行,且开源用的是宽松的 Apache2.0 协议,开发者、企业现在都可免费在魔搭社区或 Hugging Face 下载商用

Qwen2.5-Omni-7B 一开源,网友直呼这才是真正的 OpenAI(doge)。

网友纷纷表示可以直接拿来装到智能眼镜上了:

这可能是智能眼镜的完美模型。

7B 模型的新纪录!

目前,在 Qwen Chat 上即可体验该模型支持的 AI 语音和视频通话功能。

更多实例,一起来看~

实测效果惊艳

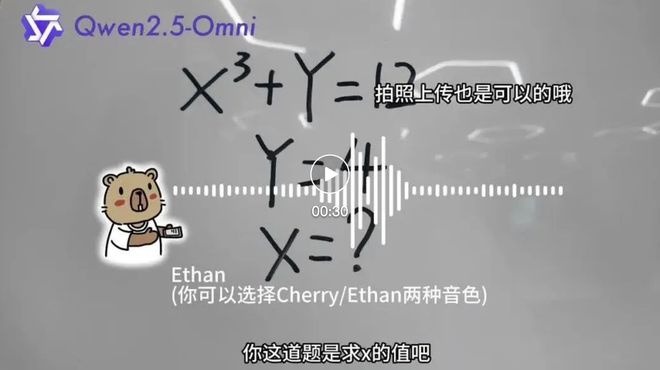

首先,Qwen2.5-Omni-7B 能胜任免费的数学家教。

它能像人类老师一样,看到题目、听懂问题,并且一步一步耐心讲解。

视频链接:https://mp.weixin.qq.com/s/VkJP89bpgZaxaKz-1wav9A

更复杂的论文它也看得懂。

只需共享屏幕,然后将论文从上至下滑动,“给它看一遍”。

它就能通俗解释论文内容。

比如 PPT、网页资料等,也能找它做讲解。

而且它还有一定艺术见解,比如可以陪着你画画,然后给出指导建议。

或者听你演奏的音乐,给出更好的改进建议。

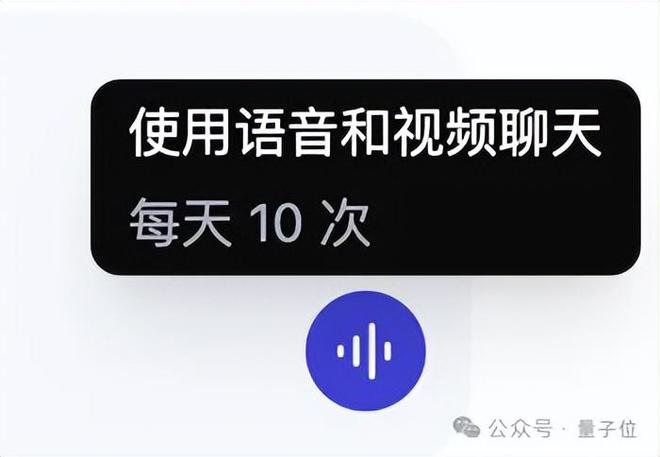

我们还进行了一手实测,在 Qwen Chat 上每天可使用语音和视频聊天 10 次。

实测中,模型能很好地理解商品界面和优惠政策。

响应速度也很快,并且会引导人类继续问下去、很有耐心。

需要注意的是,当前视频通话还只是 Beta 测试版,每次通话限时 3 分钟。

视频链接:https://mp.weixin.qq.com/s/VkJP89bpgZaxaKz-1wav9A

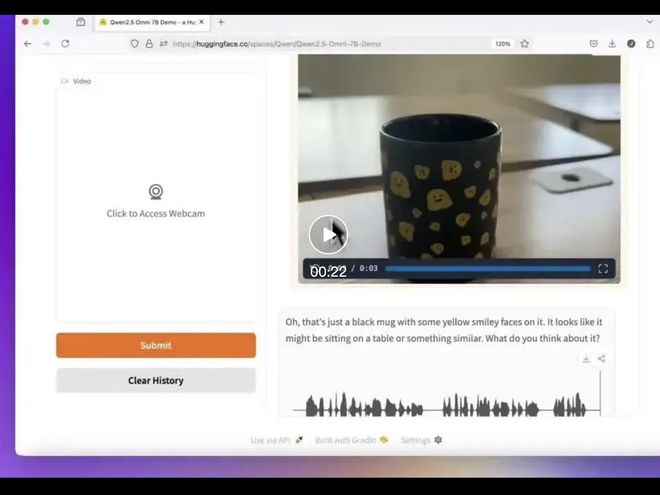

Hugging Face 的产品负责人 Jeff Boudier 也第一时间上手试玩。

模型的英文能力一样出众,而且它不仅回答看到了杯子,还细致描述了杯子上的笑脸花纹。

视频链接:https://mp.weixin.qq.com/s/VkJP89bpgZaxaKz-1wav9A

首创 Thinker-Talker 双核架构

目前官方已放出 Qwen2.5-Omni 技术 Blog 和论文。

Qwen2.5-Omni 采用通义团队首创的全新架构——Thinker-Talker 双核架构

其中,Thinker 就像“大脑”,负责处理和理解来自文本、音频、视频等多模态的输入信息,生成高层语义表征以及对应的文本内容。

Talker 则更像“嘴巴”,以流式的方式接收由 Thinker 实时输出的语义表征与文本,并流畅地合成离散语音 tokens。

具体来说,Thinker 基于 Transformer 解码器架构,融合音频/图像编码器进行特征提取。

而 Talker 采用双轨自回归 Transformer 解码器设计,在训练和推理过程中直接接收来自 Thinker 的高维表征,并共享 Thinker 的全部历史上下文信息。因此,整个架构作为一个紧密结合的单一模型运行,支持端到端的训练和推理。

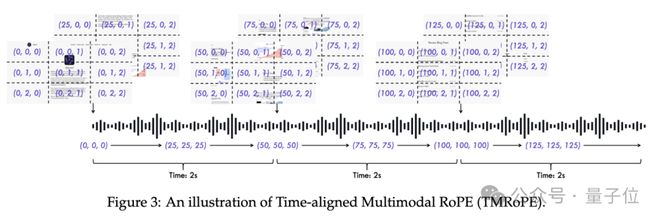

与此同时,团队还提出了一种新的位置编码算法 TMRoPE(Time-aligned Multimodal RoPE)以及 Position Embedding(位置嵌入)融合音视频技术

TMRoPE 编码多模态输入的三维位置信息,即多模态旋转位置嵌入(M-RoPE),并结合绝对时间位置,通过将原始旋转嵌入分解为时间、高度和宽度三个部分实现。

另外值得一提的是,从技术层面来看,Qwen2.5-Omni 和一般的视频/语音理解模型以及其相应的视频/语音对话的 AI 功能,也有本质性区别。

在传统语音理解大模型的人机交互场景里,一般运用 ASR(Automatic Speech Recognition,自动语音识别)技术,把人类语音转换为文字文本,随后将其交给大语言模型处理,最终生成的内容借助 TTS(Text-to-Speech,语音合成)技术转化为语音反馈给用户。

而视频理解模型是基于图片、视频进行大模型理解,并以文字形式输出反馈。

这两种模型均属于相互独立的单链路模型。在一些 AI 应用中,甚至会串联多个模型来实现类似功能,如此一来,链路变得更长,效率大打折扣。

Qwen2.5-Omni-7B 的特点在于,它原生支持视频、图片、语音、文字等多模态输入,并能原生生成语音及文字等多模态输出

也就是说,一个模型就能通过“看”、“听”、“阅读”等多种方式来综合思考。

所以 Qwen2.5-Omni 得以在一系列同等规模的单模态模型权威基准测试中,拿下最强全模态性能,在语音理解、图片理解、视频理解、语音生成等领域的测评分数,均领先于专门的音频(Audio)或视觉语言(VL)模型。

抢先看到 Apple Intelligence?

一个月前,阿里公开确认与苹果合作,宣布通义千问将为国行 iPhone 用户提供 AI 功能,此消息一经披露,便在科技圈引发热议。

而这次 Qwen2.5-Omni 开源,就是奔着端侧部署来的,7B 尺寸使其具备直接嵌入手机的可行性,仿佛提前看到了 Apple Intelligence,让大家看到多模态大模型上手机都能有哪些效果。

不只是苹果,据量子位了解,这种端侧部署能力已吸引超 90% 国产手机品牌接入通义千问,包括 OPPO、vivo、荣耀、传音等,还有众多汽车品牌、AI 硬件产品选择与之携手。

为啥都选通义千问?

梳理通义千问的最新发展动态,答案便不难理解。

首先,通义千问 Qwen 目前已稳居全球最大 AI 大模型族群。

仅在最近一个月的时间里,就接连推出了一系列具有竞争力的模型:推理模型 Max 旗舰版 QwQ-Max-Preview、视频生成模型 Wan 2.1、推理模型 QwQ-32B、视觉语言模型 Qwen2.5-VL-32B-Instruct……

实际上,2023 年至今,阿里通义团队已累计开源 200 多款模型,涵盖从 0.5B 到 110B 全尺寸范围,模型类型覆盖文本生成、视觉理解与生成、语音理解与生成、文生图及视频模型等全模态领域,应用场景也极为丰富。

在海内外开源社区中,通义千问 Qwen 衍生模型数量更是一路飙升,现已超过 10 万,超越 Llama 系列。

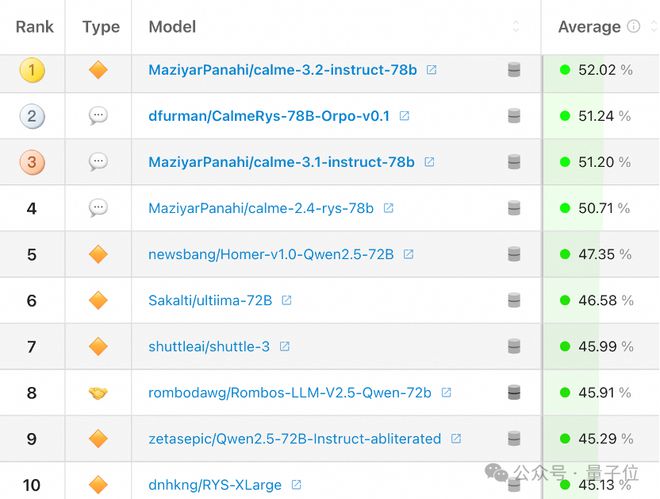

根据 Hugging Face 在 2 月 10 日发布的最新全球开源大模型榜单,排名前十的开源大模型无一例外,全部是基于通义千问 Qwen 开源模型二创的变体模型。

其次,阿里巴巴通过开源等一系列积极举措,成功构建起一个丰富且活跃的大模型生态。

阿里不仅将开源进行到底,更向大模型公司提供了全方位的服务支持,其中包括算力资源以及开发工具等,阿里云已成为中国大模型领域的公共 AI 算力底座。

截至 2025 年 2 月中旬,阿里魔搭社区 ModelScope 的模型总量已超 4 万个,服务超 1000 万开发者。

那么通义千问 Qwen 团队下一步要干啥?

期待听到您的反馈,并看到您使用 Qwen2.5-Omni 开发的创新应用。

在不久的将来,将着力增强模型对语音指令的遵循能力,并提升音视频协同理解能力。还将持续拓展多模态能力边界,发展全面的通用模型。

感兴趣的友友不如一起来上手试试吧~

Qwen Chat:https://chat.qwenlm.ai

Hugging Face:https://huggingface.co/Qwen/Qwen2.5-Omni-7B

ModelScope:https://modelscope.cn/models/Qwen/Qwen2.5-Omni-7B

DashScope:https://help.aliyun.com/zh/model-studio/user-guide/qwen-omni

GitHub:https://github.com/QwenLM/Qwen2.5-Omni

Demo 体验:https://modelscope.cn/studios/Qwen/Qwen2.5-Omni-Demo