新智元报道

编辑:桃子定慧

AI 不但能写论文,还能自主进行科研协作,让智能体之间不再是「孤岛」。约翰霍普金斯与 ETH Zurich 联合推出了自主科研智能体框架 AgentRxiv。该框架允许智能体相互上传和检索研究成果,自动积累与迭代已有进展,显著提高研究效率。

试想一下,AI 智能体某天帮你自主研究、查文献时,或许每个人科研产出直接起飞。

最近,Sakana AI 首篇由 AI 生成的论文,正式通过了 ICLR 2025 同行评审。

但问题来了,现在的 AI 智能体都在各自为战,无法协作和传承既有的研究成果。

为此,霍普金斯联手 ETH Zurich 研究人员重磅推出 AgentRxiv,一个专为自主研究智能体设计的框架。

它的诞生,就为了让智能体上传、检索,并相互借鉴研究成果。

论文地址:https://agentrxiv.github.io/resources/agentrxiv.pdf

简单来说,AgentRxiv 就像是一个「预印本服务器」,不仅允许研究者设定方向,让智能体持续产出论文。

最重要的是,它还能确保每篇新作都建立在以往研究基础之上,实现真正迭代式进步。

经过测试,在数学推理任务中,基于 AgentRxiv 的智能体在开发全新推理技术时,会参考前人研究报告。

gpt-4o mini 准确率从 70.2% 提升至 78.2%,相较基线和思维链分别飙升 11.4%、9.7%。

此外,AI 智能体在发现最佳算法(SDA)的多项基准测试中,SDA 平均提升 3.3% 准确性。

更值得一提的是,在三个独立实验室通过 AgentRxiv 共享预印本并行实验中,最优方法准确率高达 79.8%,相较基线提升 13.7%。

比传统的序列实验,这种协作模式更快速达成关键里程碑,从侧面印证了 AgentRxiv 在加速研究进程中巨大潜力。

AgentRxiv 让智能体从协作中受益

现有的研究框架往往独立运行,生成的研究成果如同一个个「孤岛」,智能体之间被完全「隔离」。 这种隔离限制了科学发现的累积进展和泛化。 在科学研究中,研究成果通常是站在「巨人的肩膀」上基于前人的工作来实现的。 为了让智能体也能从协作共享中受益,需要一种结构化的机制来打通这些「孤岛」。

智能体实验室工作流程,上图图展示了智能体实验室的三个阶段:文献回顾、实验和报告撰写。

人类研究员与 AI 智能体(例如博士、博士后)及专门工具(mle-solver、paper-solver)合作,将任务自动化并产出高质量的研究成果。

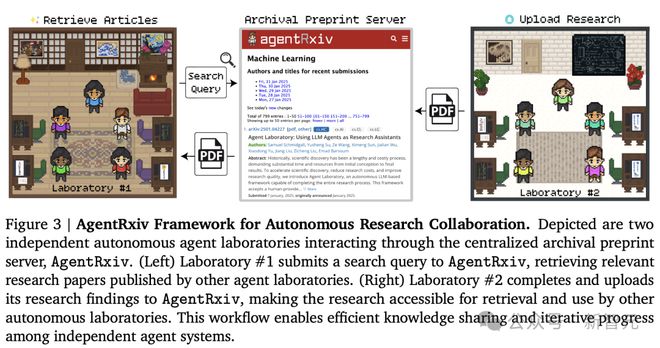

上图中展示了两个独立的自主智能体实验室通过 AgentRxiv 进行互动过程。

左侧的实验室提交搜索请求,从 AgentRxiv 检索出相关研究论文;

右侧实验室完成实验后将研究成果上传至 AgentRxiv,供其他实验室查阅。

发现推理策略

第一个目标是验证:智能体是否能基于自身过往研究不断优化成果。

首先使用 o3-mini(medium)作为 LLM 后端能力,运行智能体系统产出了N=40 篇论文。

在文献综述阶段,智能体可以同时访问 AgentRxiv 上的 5 篇论文,和 arXiv 上的 5 篇论文。

然后设定一个研究方向:「通过推理与提示工程提升在 MATH-500 上的准确率」,实验中使用的是 OpenAI 的 gpt-4o mini 模型。

从图中可以看出,每篇新论文的产生都带来了准确率的稳步提升。

一开始,gpt-4o mini 的基准表现为 70.2%。通过一些早期策略,带来小幅提升,达到了 71.4%。

随着推理策略不断引入,最终 SDA 策略将准确率提升到了最高的 78.2%。

泛化能力评估:算法能否迁移

进一步评估 SDA 策略是否能在其他数据集上展现类似效果。

在 GPQA(生物/化学/物理研究问答)、MMLU-Pro(跨学科推理)和 MedQA(美国医学执照考试)这三个基准上,SDA 均带来了显著提升:

-

GPQA:从 36.4% 提升到 38.9%(+6.8%);

-

MMLU-Pro:从 63.1% 提升到 70.8%(+12.2%);

-

MedQA:从 74.9% 提升到 81.6%(+8.9%);

三项基准平均提升 9.3%,与 MATH-500 上的 +11.4% 表现接近,说明 SDA 拥有较强的泛化能力。

研究人员还测试了 SDA 在不同语言模型上的表现,包括:

-

Gemini-1.5 Pro;

-

Gemini-2.0 Flash;

-

DeepSeek-v3;

-

gpt-4o;

-

gpt-4o mini。

结果显示,SDA 在所有模型上都带来了平均 +3.3% 的性能提升,尤其是在基础表现较差的模型上效果更明显(如 gpt-4o mini 提升 5.9%)。

并行智能体实验室的协作执行

接下来探索多个自主实验室并行运行、并借助 AgentRxiv 实现研究成果共享的效果。 研究人员初始化了三个配置相同、研究目标一致的 Agent Laboratory 系统,并行运行。 每个实验室独立完成文献综述、实验设计与论文撰写,同时通过 AgentRxiv 异步访问其他实验室发布的论文。

一旦某个实验室上传了新的研究成果,其他实验室即可即时获取,并在后续实验中加以利用。

某个实验室在性能上有所突破时,相关论文就会上传到 AgentRxiv,供其他实验室查阅、评估和借鉴。

这种并行设置允许多个研究方向同时推进,有望加快发现的速度。

在并行设置下,早期里程碑如达到 76.2% 的准确率仅需 7 篇论文,而在顺序设置下则需要 23 篇论文。

并行设计中表现最好的算法比最佳的顺序算法提高了 1.6%,并且并行实验的整体平均准确率比顺序运行高出 2.4%。

智能体的发现是否是真正的「创新」

尽管已有研究表明 LLM 能提出创新性的研究想法。 但也有研究指出这些系统存在高比例的「抄袭」问题(最高达 24%)。 然而,AI 完全生成的研究成果已经开始被正式学术会议接收。 虽然会议收录不能完全证明内容新颖,但至少说明这些成果足以「看起来像新发现」。 对上述表现最好的论文摘要进行了 3 个不同查重系统的检测,结果均未发现抄袭痕迹。 研究人员还对这些论文进行人工检查,发现高表现算法确实包含一定创新,但很多是对已有技术的「变种」或「组合」,而非完全原创。 比如上述智能体实验室在开发 SDA 时,确实参考了许多相关研究。 这也表明:虽然 SDA 在实现与整合上具备一定新意,但是否构成「实质性原创」,在快速发展的领域中难以一锤定音。 因此未来仍需进行大规模的系统性研究。

作者介绍

Samuel Schmidgall

Samuel Schmidgall 是约翰霍普金斯大学电子与计算机工程系的二年级博士生,同时也是 Google Deepmind 医疗 AI 团队的研究员。

Samuel Schmidgall 之前在 2024 年夏天是斯坦福大学医疗 AI 的实习生,在 2024 年秋天是 AMD Gen AI 团队的实习生。

Michael Moor

Michael Moor 是一名医学博士和哲学博士,研究领域是医疗保健领域的机器学习。

自 2024 年末起,被任命为位于巴塞尔的苏黎世联邦理工学院(D-BSSE)的医学人工智能方向的终身教职助理教授。

在此之前,Michael Moor 在斯坦福大学计算机科学系与 Jure Leskovec 教授一起做了博士后研究。

研究重点是开发和评估大规模医疗基础模型,最终目标是解锁适用于医疗 AI 的通用模型。

参考资料: