梦晨发自凹非寺

量子位公众号 QbitAI

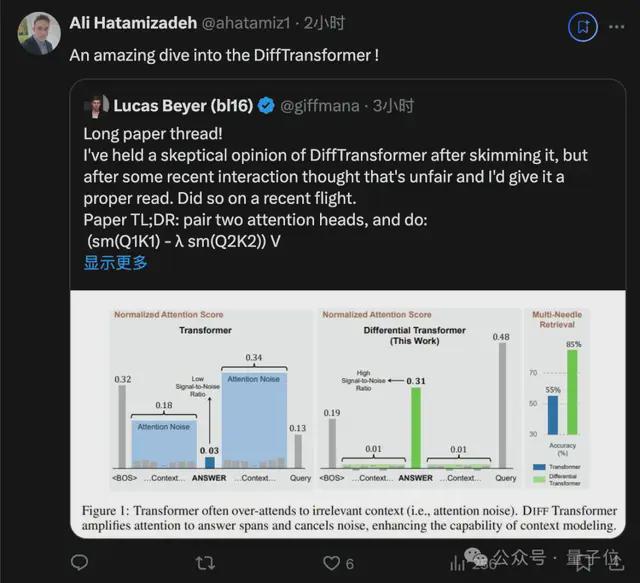

ViT 核心作者 Lucas Beyer,长文分析了一篇改进 Transformer 架构的论文,引起推荐围观。

他前不久从谷歌跳槽到 OpenAI,这次是在飞机上阅读论文并写下了分析。

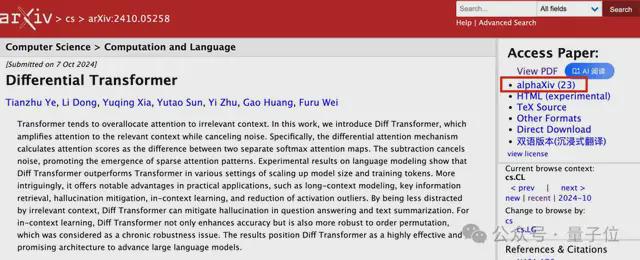

这篇论文被他简写为 DiffTranformer,不过不是 Sora 底层架构的那个 Diffusion Transformer,而是不久前来自微软的Differencial Transformer。

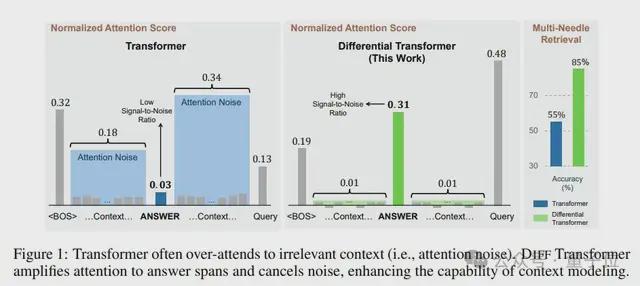

论文中介绍,整体思路类似差分放大电路或降噪耳机,用两个信号的差值来滤除共模噪声,解决 Transformer 模型信噪比低的问题。

这篇论文发布时引起大量关注,但也面对一些质疑,在弹幕版 alphaXiv 上作者与读者进行了很多讨论。

Beyer 起初也对这篇文章持保留态度,觉得“难道 MHA 中的两个注意力头不能学习到这些吗?”。

但经过近期和同行的一些互动,觉得不应该轻易下定论,重新看了一遍论文后,他改变了看法

我的最初印象被团队的实验彻底打破了,他们的实验非常公平和谨慎。

此外还有一个彩蛋:

大佬通常会用坐飞机的时间来打 4 把 Dota 2 游戏快速模式。

现在写这个帖子也不能当论文评审工作写进简历,是纯纯的贡献个人时间了,以后也不会常写。

总之先给大佬点赞。

大佬解读热点论文

Beyer 评价这篇论文的核心创新非常simple 和 nice,可以用一句话概括。

将两个注意力头配对,然后执行(softmax (Q1K1) - λ*softmax (Q2K2)) V,其中λ是一个可学习的标量。

他认为这项研究的动机非常充分:随着上下文变长,(微小的)对不相关 token 的注意力之和可能超过对少数相关 token 的注意力,从而淹没它们。

这一洞见表明,随着输入长度的增加,经典 Transformer 可能越来越难以捕捉到关键信息。DIFF Transformer 试图解决这一问题。

但他仍不确定对于训练充分的模型来说这是个多大的问题,希望在 DIFF Transformer 论文中有一些关于 attention 分布/熵的图表,以实际证明这个插图的合理性。

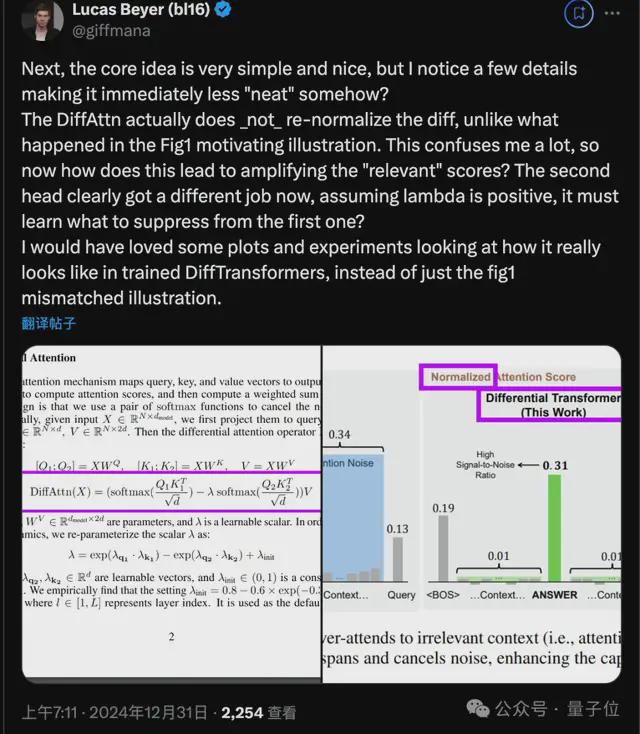

接下来,他指出了几个容易被忽视的细节:

- 与 Figure1 不同,DiffAttn 实际上并没有对差值重新归一化。那么它究竟如何放大”相关”的分数呢?

Beyer 建议论文中能提供更多实际训练的 DIFF Transformer 的分析图表。

- λ的计算相当复杂,涉及两个可学习的指数函数之差,加上一些基线λ_init,在早期的层是 0.1,后面又是 0.8。

Beyer 认为λ不一定需要是正值,并建议提供更多对可学习λ参数的分析。

- 每个注意力头的输出都经过了层归一化并乘以(1-λ_init),然后再 concat 并乘以 WO,这里也需要更多图表来证明。

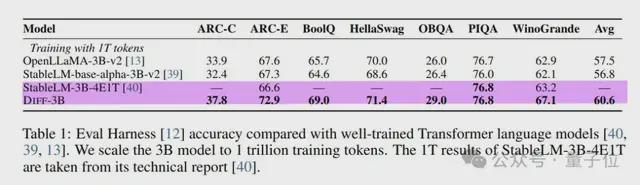

接下来看论文中大量的实验。研究者基本上分叉了了 StableLM-3B-4E1T,称之为 Diff-3B,作为基线模型进行比较。

可惜的是,基线模型只在其中 3 个数据集上报告了结果,其中 2 个 Diff-3B 的表现都相当好。

Beyer 怀疑这个 StableLM-3B 是否真的是一个强基线。

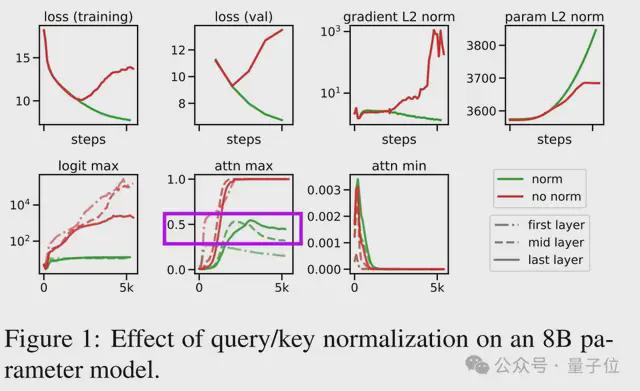

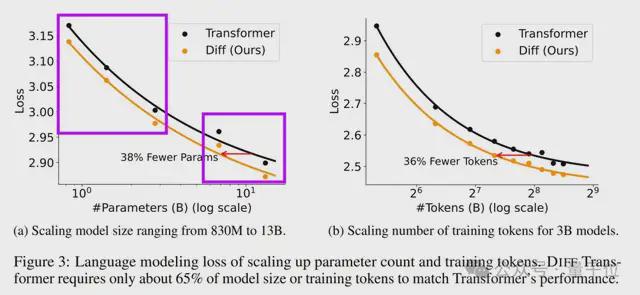

在参数量和 token 数的缩放曲线上,DIFF Transformer 乍一看很有前景。但仔细观察后,Beyer 提出了两点质疑:

- 缩放曲线明显分为两组,在它们之间画一条线有点牵强。查看附录可知,研究者为较大的两个模型降低了学习率。这是否意味着他们遇到了不稳定性问题?

- 每次实验只用了 10B 个 token 训练,这个数量非常小。Beyer 理解其中的计算资源限制,但仍然感到有点不安。

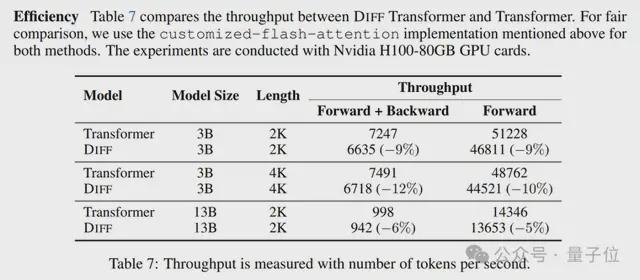

这些实验表明,在相同大小的情况下,DIFF Transformer 性能会更好一些,并且训练时间相同。

然而,它的的推理速度也会慢一些(慢5-10%)。

Beyer 提出最好能看到以计算量或实际时间为横轴的缩放曲线。

在长文本评测和对输入样本顺序的鲁棒性方面,DIFF Transformer 表现出了明显的优势。

特别是在上下文学习的鲁棒性实验中,DIFF Transformer 在不同的样本排列顺序下,性能方差远小于经典 Transformer。

这表明它更不容易被输入的细微变化扰乱,而经典 Transformer 容易受到样本顺序的影响,在最好和最坏情况下表现相差很大。

总的来说,Beyer 对这篇论文的看法有所改观:

研究者的实验非常全面和谨慎,的确展现了 DIFF Transformer 比单纯的”两个注意力头相减”更多的潜力。

这项工作展现了一些有前景的火花。它在其他人的训练任务中能否很好地复现、或带来帮助,还有待进一步观察。

Lucas Beyer 是谁

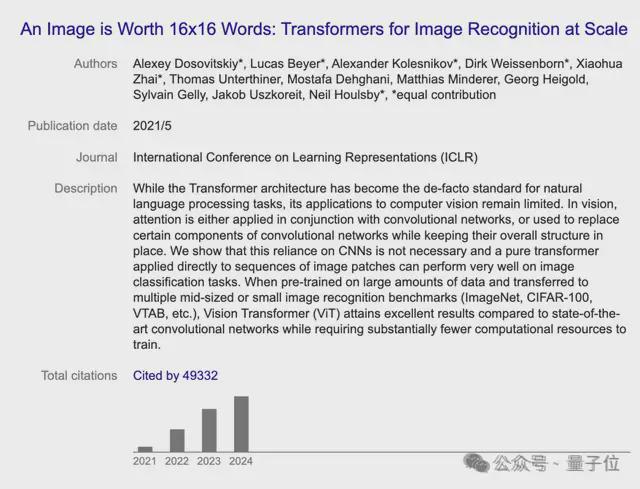

12 月初,Lucas Beyer 与 Xiaohua Zhai、Alexander Kolesnikov 集体从谷歌被挖到 OpenAI。

他们曾共同提出 Vision Transformer,开创了 Transformer 在 CV 领域应用的先河。

据他个人官网中介绍,他在比利时长大,曾梦想制作电子游戏以及从事 AI 研究。

他在德国亚琛工业大学学习机械工程,并在那里获得了机器人感知和计算机视觉博士学位,2018 年加入谷歌。

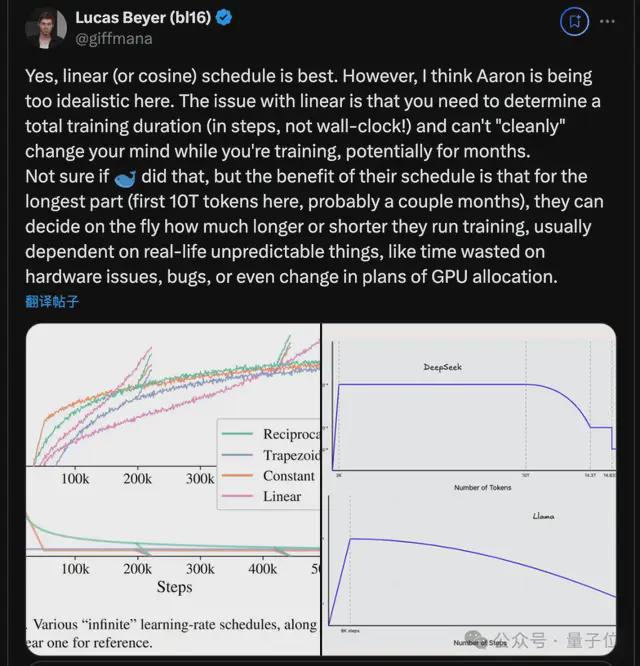

除了这次长文分析 DIFF Transformer 之外,他还经常对新研究发表一些短的评论,比如最近火爆的 DeepSeek v3,他也提出自己的建议。

总之是一位非常值得关注的学者。

DIFF Transformer 论文:

https://arxiv.org/abs/2410.05258

参考链接: