新智元报道

编辑:编辑部 HYZ

英伟达的圣诞大礼包曝光,最强 B300、GB300 算力和显存直接提高 50%,模型推理训练性能史诗级提升,同时还打破了利润率下降的魔咒。

多亏了老黄,圣诞节如期而至。

尽管 Blackwell GPU 多次因硅片、封装和底板问题而推迟发布,但这并不能阻挡他们前进的脚步。

距离 GB200 和 B200 的发布才刚刚过去几个月,英伟达便推出了全新一代的 AI GPU——GB300 和 B300。

更为有趣的是,这次看似普通的更新背后,实则内含玄机。其中最为突出的,便是模型的推理和训练性能得到了大幅增强。

而随着 B300 的推出,整个供应链正在进行重组和转型,赢家将从中获益(获得礼物),而输家则处境不妙(收到煤炭)。

这正是英伟达送给所有超大规模云计算供应商、特定供应链合作伙伴、内存供应商以及投资者的特别「圣诞礼物」

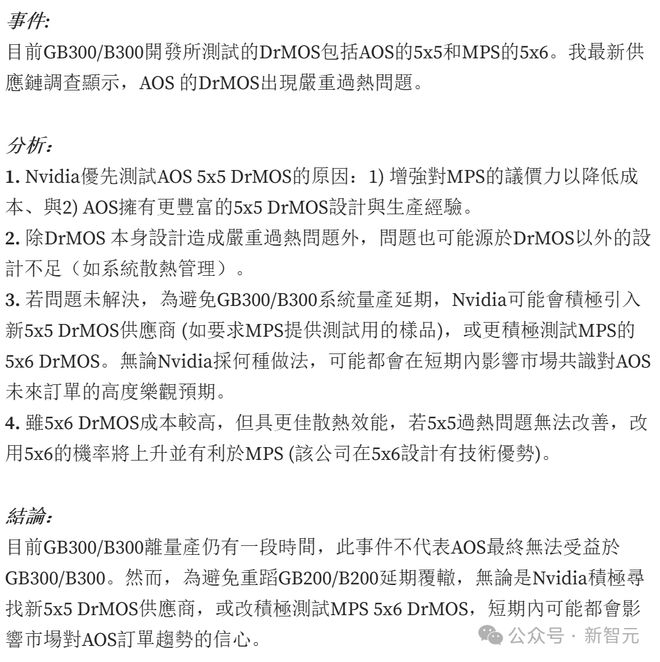

不过就在上周,天风国际分析师郭明錤却在研报中曝出,B300/GB300 的 DrMOS 存在严重的过热问题!

而这,很可能会影响 B300/GB300 的量产进度。

具体分析如下——

这已经不是 Blackwell 第一次被曝出存在设计问题了。

B300 和 GB300:绝不仅是一次小升级

根据 SemiAnalysis 的最新爆料,B300 GPU 对计算芯片的设计进行了优化,并采用了全新的 TSMC 4NP 工艺节点进行流片。

相比于 B200,其性能的提升主要在以下两个方面:

1. 算力

-

FLOPS 性能提升 50%

-

功耗增加 200W(GB300 和 B300 HGX 的 TDP 分别达到 1.4KW 和 1.2KW;前代则为 1.2KW 和 1KW)

-

架构改进和系统级增强,例如 CPU 和 GPU 之间的动态功率分配(power sloshing)

2. 内存

-

HBM 容量增加 50%,从 192GB 提升至 288GB

-

堆叠方案从 8 层 HBM3E 升级为 12 层

-

针脚速率保持不变,带宽仍为 8TB/s

专为「推理模型」优化

序列长度的增加,导致 KV Cache 也随之扩大,从而限制了关键批处理大小和延迟。

因此,显存的改进对于 OpenAI o3 这类大模型的训练和推理至关重要。

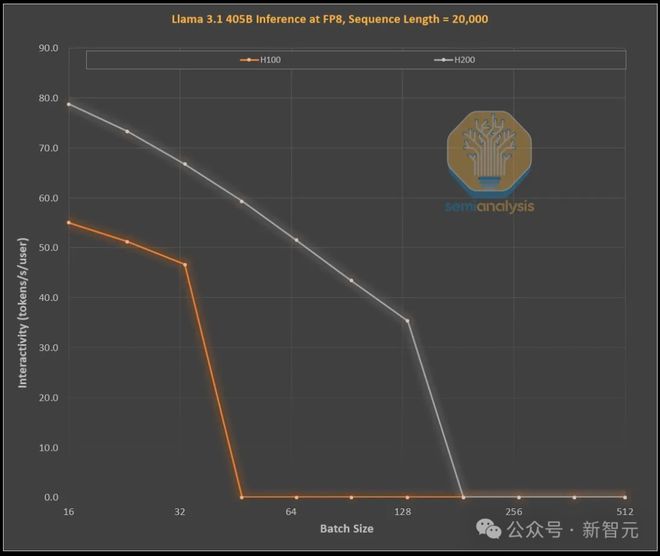

下图展示了英伟达 H100 和 H200 在处理1,000 个输入 token 和 19,000 个输出 token 时的效能提升,这与 OpenAI 的 o1 和 o3 模型中的思维链(CoT)模式相似。

H100 和 H200 的 Roofline 模拟,通过 FP8 精度的 Llama 405B 模型完成。

H100 到 H200 的升级,主要在于更大、更快的显存:

-

更高的带宽使交互性能普遍提升了 43%(H200 为 4.8TB/s,而 H100 为 3.35TB/s)

-

更大的批处理规模,使每秒 token 生成量提升了 3 倍,进而使成本也降低了约 3 倍

而对运营商而言,这 H100 和 H200 之间的性能与经济差异,远远超过技术参数的数字那么简单。

首先,此前的推理模型时常因请求响应时间长而影响体验,而现在有了更快的推理速度后,用户的使用意愿和付费倾向都将显著提高。

其次,成本降低 3 倍的效益,可是极为可观的。仅通过中期显存升级,硬件就能实现 3 倍性能提升,这种突破性进展远远超过了摩尔定律、黄氏定律或任何已知的硬件进步速度。

最后,性能最顶尖、具有显著差异化优势的模型,能因此获得更高溢价。

SOTA 模型的毛利率已经超过 70%,而面临开源竞争的次级模型利润率仅有 20% 以下。推理模型可突破单一思维链限制,通过扩展搜索功能提升性能(如 o1 Pro 和 o3),从而使模型更智能地解决问题,提高 GPU 收益。

当然,英伟达并非唯一能提供大容量显存的厂商。

ASIC 和 AMD 都具备这样的能力。而 AMD 更是凭借更大的显存容量(MI300X:192GB、MI325X:256GB、MI350X:288GB)占据了优势地位。

不过,老黄手里还有一张「绝对王牌」——NVLink。

NVL72 在推理领域的核心优势在于,它能让 72 个 GPU 以超低延迟协同工作、共享显存。

而这也是全球唯一具备全连接交换(all-to-all switched connectivity)和全规约运算(all reduce)能力的加速器系统。

英伟达的 GB200 NVL72 和 GB300 NVL72,对以下这些关键能力的实现极其重要——

-

更高交互性,实现更低思维链延迟

-

72 个 GPU 分散 KV Cache,支持更长思维链,提升智能水平

-

相比传统 8 GPU 服务器,具备更优批处理扩展性

-

支持更多样本并行搜索,提升准确性和模型性能

总体而言,NVL72 可以在经济效益上实现 10 倍以上提升,尤其是在长推理链场景中。

而且,NVL72 还是目前唯一能在高批处理下,将推理长度扩展至 10 万以上 token 的解决方案。

供应链重构

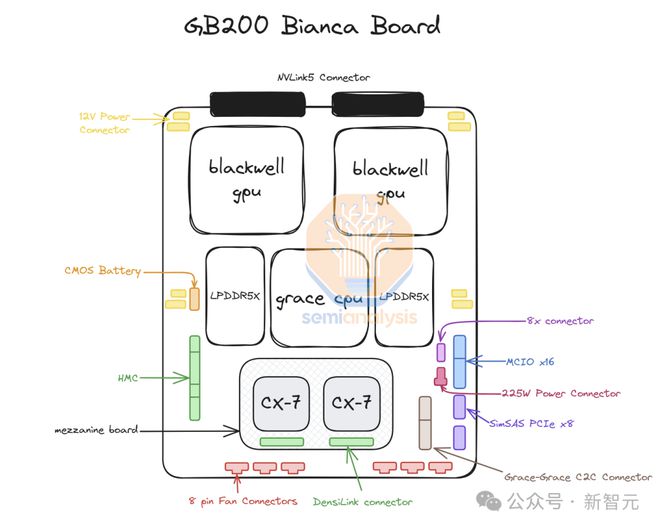

此前 GB200 时期,英伟达提供完整的 Bianca 主板(包含 Blackwell GPU、Grace CPU、512GB LPDDR5X 内存以及集成在同一 PCB 上的电压调节模块 VRM),同时还提供交换机托盘和铜质背板。

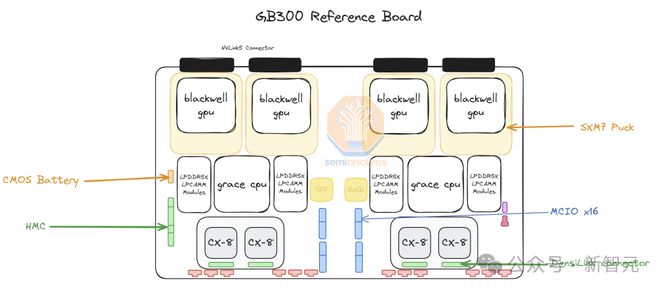

但随着 GB300 的推出,供应链的结构和产品内容,将发生重大调整。

在新方案 GB300 中行,英伟达只提供三个核心组件的供应:

-

搭载在「SXM Puck」模块上的 B300

-

BGA 封装的 Grace CPU

-

由美国初创企业 Axiado 提供的基板管理控制器(HMC),取代了原有的 Aspeed 方案

终端客户将需要直接采购计算板上的其他组件。同时,第二级内存方案,从焊接式 LPDDR5X 改为可更换的 LPCAMM 模块,主要由美光供应。交换机托盘和铜质背板仍由英伟达全权负责。

相比此前仅有纬创和富士康工业互联网(FII)能够制造 Bianca 计算板的局面,SXM Puck 方案打破了原有的市场格局。

它的采用为更多 OEM 和 ODM 厂商参与计算托盘制造创造了机会:

-

纬创在 ODM 领域受影响最大,Bianca 主板份额显著下降

-

富士康工业互联网通过独家生产 SXM Puck 及其插座,抵消了 Bianca 主板业务的损失

-

英伟达正在寻求 Puck 和插座的其他供应商,但目前尚未确定新订单

其次,是 VRM 供应链。

尽管 SXM Puck 上仍保留部分 VRM 组件,但主要的板载 VRM 将由超大规模数据中心运营商和 OEM 直接从供应商采购:

-

Monolithic Power Systems 的市场份额将因商业模式转变而下降

-

市场格局重塑为新供应商创造了更多的机会

第三,英伟达在互联技术也取得了突破。

GB300 平台搭载了 800G ConnectX-8 网络接口卡,可在 InfiniBand 和以太网上提供双倍的扩展带宽。

相较于上一代 ConnectX-7,ConnectX-8 具有多项显著优势:

-

带宽提升 100%

-

PCIe 通道数从 32 增至 48,支持空冷 MGX B300A 等创新性架构设计

-

原生支持 SpectrumX,无需借助效率较低的 Bluefield 3 DPU(此前 400G 产品的方案)

对超算中心的影响

在 2024 年第三季度,受 GB200 和 GB300 发布延迟影响,大量订单转向了英伟达价格更高的新一代 GPU。

截至上周,所有超算中心均已决定采用 GB300 方案。这一决策基于两个因素:

-

GB300 提供更高的 FLOPS 算力和更大的显存容量

-

客户拥有更多系统定制自主权

此前,由于上市时间压力以及机架、散热和供电密度的重大调整,超算中心此前难以对 GB200 服务器进行深度定制。

这迫使 Meta 完全放弃了同时向博通和英伟达采购网络接口卡的计划,转而完全依赖英伟达。类似地,谷歌也放弃了自研网络接口卡方案,转而采用英伟达的解决方案。

对于那些一向精于优化从处理器到网络设备,甚至到螺丝和钣金等各个环节成本的超算中心数千人研发团队来说,为其带去了极大的困扰。

另外,亚马逊的案例最具代表性。他们选择了一个次优配置,导致总拥有成本(TCO)超过了参考设计。

由于使用 PCIe 交换机和需要风冷的低效 200G 弹性网络适配器,亚马逊无法像 Meta、谷歌、微软、甲骨文、xAI 和 Coreweave 那样部署 NVL72 机架。

受限于其内部网卡方案,亚马逊被迫采用 NVL36 架构,却因更高的背板和交换机成本推高了每个 GPU 的支出。

总体而言,因定制化受限,导致亚马逊的配置方案并不理想。

GB300 的推出,为超算中提供了更大自主权,比如可以自主定制主板、散热系统等。

这使得亚马逊能够开发自己的定制主板,将此前需要风冷的组件(如 Astera Labs PCIe 交换机)整合进水冷系统。

随着更多组件采用水冷设计,加上 K2V6 400G 网卡将在 2025 年第三季度实现规模化量产,亚马逊有望重返 NVL72 架构,显著提升 TCO 效率。

然而这也带来了一个显著挑战:超算中心需要投入更多资源进行设计、验证和确认工作。

这无疑是超算中心面临的最复杂系统设计项目(除谷歌 TPU 外)。部分超算中心能够快速完成设计,但设计团队较慢的机构则明显落后。

尽管市场传闻有公司取消订单,但 SemiAnalysis 观察到由于设计进度较慢,微软可能是最晚部署 GB300 的机构之一,他们在第四季度仍在采购 GB200。

随着部分组件从英伟达转移到原始设计制造商(ODM),客户的总采购成本出现较大差异。

这不仅影响了 ODM 的收入,更重要的是导致英伟达全年的毛利率产生波动。下面将更详细分析这些变动对英伟达利润产生的影响。

值得一提的是,三星在未来至少 9 个月内,都无法进入 GB200 或 GB300 的供应链。

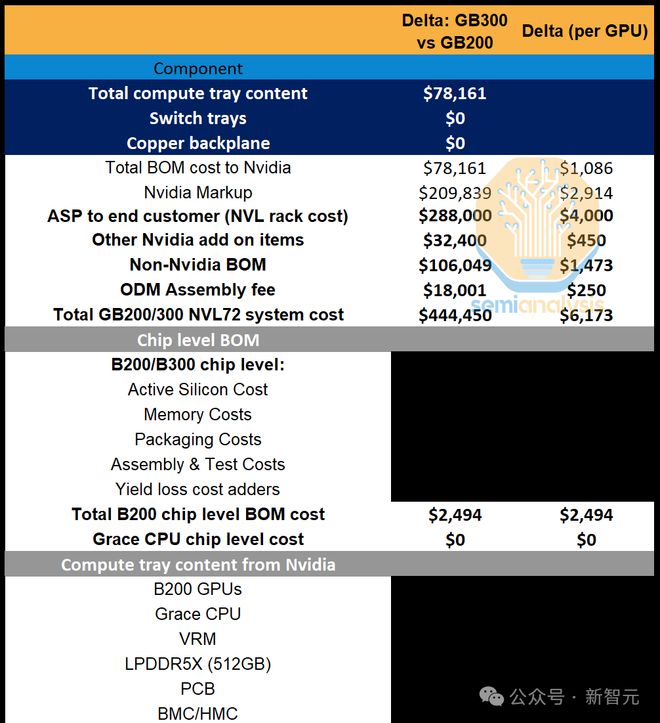

对英伟达利润的影响

怀着「圣诞精神」的英伟达,在新的定价策略上也颇有看点——这将直接影响 Blackwell 系列的利润。

随着显存方案从 SK 海力士和美光的 8 层 HBM3E 堆栈升级至 12 层 HBM3E 堆栈,显存容量获得了显著提升。

这一升级,直接导致英伟达芯片级物料清单(BOM)成本增加约2,500 美元。

成本的增加主要来自——

-

更高的容量

-

堆栈层数增加带来的每 GB 显存溢价

-

封装良率下降带来的额外成本

第三点也反映出高带宽显存(HBM)在物料成本中的主导地位(随着推理模型对显存容量和带宽需求增加,这一趋势将持续加强)。

总体而言,GB300 的平均售价较 GB200 提高约4,000 美元,其中 HBM 成本增加约2,500 美元,而增量利润率不足 40%,而 GB200 整体的利润率维持在 70% 的中低水平。

然而,由于前述内容变化,英伟达减少了整体供应内容,转由超算中心自行采购,由此,英伟达实现了成本平衡。

首先,英伟达不再提供每个 Grace CPU 配套的 512GB LPDDR5X 内存,这抵消了大部分额外的 HBM 成本支出。

其次,PCB 的成本节省最为显著。

综合各项因素,在平均销售价格提升4,000 美元的同时,英伟达的物料成本仅增加略超1,000 美元。

GB300 相对于 GB200 的增量毛利率达到 73%,这意味着在良率保持稳定的情况下,该产品的利润水平基本持平。

这一结果虽然看似平常,但值得注意的是,HBM 升级周期通常会导致利润率下降(例如 H200、MI325X 的情况),而这次这一惯例被打破了。

此外,随着各项工程技术问题的逐步解决,良率将会提升,在度过 Blackwell 初期的产能爬升期后,利润率预计会在年内逐步改善。

参考资料: