新智元报道

编辑:LRST 好困

基于虚幻引擎5,清华大学构建了一个真实、动态、开放的具身智能平台 EmbodiedCity,用于评估和研究具身智能在复杂城市场景中的应用;该平台提供在线接入和离线运行两种使用方式,支持多模态场景理解、问答、对话、导航和任务规划等一系列具身智能任务。

具身智能被视为当前人工智能领域最具潜力的方向之一,重点关注智能体感知、学习和与环境动态交互的能力。

近年来,具身智能发展迅猛,在多个领域取得突破进展。然而,当前大多数具身智能研究聚焦于有限环境如室内场景中,针对城市级别开放真实世界场景的探索较为匮乏,急需构建相应的模拟平台和基准测试集。

近日,清华大学城市科学与计算研究中心开放发布基于虚幻引擎 5 的城市具身智能模拟环境 EmbodiedCity,基于真实城市开放场景打造 3D 城市环境,并进一步针对不同维度和水平的开放空间具身智能能力,构建相应的任务集和数据集,可支撑真实开放空间具身智能的多类研究任务。

官方网站:https://embodied-city.fiblab.net/

开发文档:https://github.com/tsinghua-fib-lab/EmbodiedCity

该平台提供离线运行和在线接入两种方式,既可以下载在不同操作系统本地环境运行,也可以访问智能体在线平台,基于 Python SDK 调用开发智能体,在平台网页直接编程使用。

EmbodiedCity 模拟环境

EmbodiedCity 以北京市国贸区域的真实道路和建筑布局为基础,结合人流和车流的真实数据与模拟算法,基于虚幻引擎5(Unreal Engine 5)构建了一个真实、动态、开放的城市具身环境。

环境中主要包含以下元素:

(1)街道:机动车/非机动车道、十字路口、交通信号灯和人行道,街道布局合理多样。

(2)建筑物:办公楼、购物中心、住宅小区等,细粒度建模还原真实建筑。

(3)其他元素:长椅、路灯、植被以及动态的车辆和行人,城市场景充满活力。

城市具身智能任务基准测试集

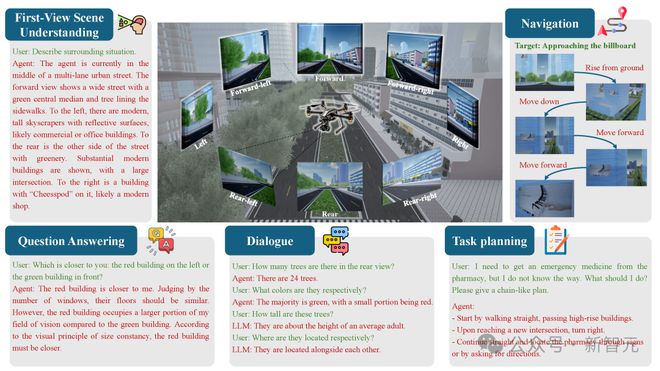

为充分探索开放环境具身智能体的感知、推理和决策能力,EmbodiedCity 构建了一系列评测任务,既包括代表性的具身任务,涵盖行人模拟、车流模拟、场景理解、问答、对话、导航和规划,也支撑传统的感知、预测、决策等任务。

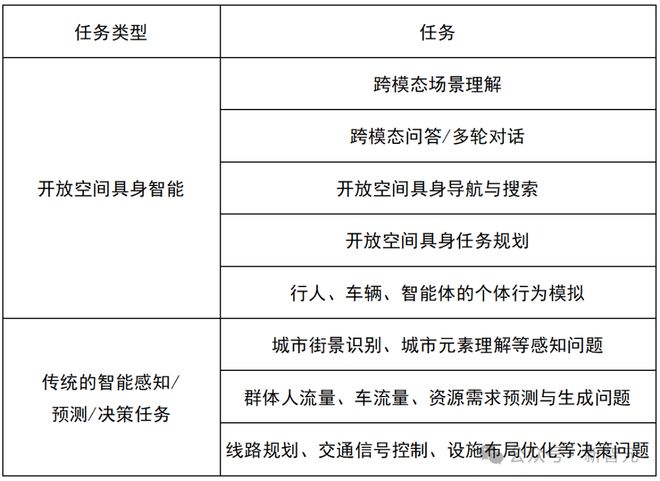

其中,针对开放空间具身智能构建的任务集如下:

1. 跨模态场景理解:智能体观察环境元素并给出准确描述,通过在同一位置从不同角度观察,生成一组 RGB 图像作为输入,得到相应的文本描述。

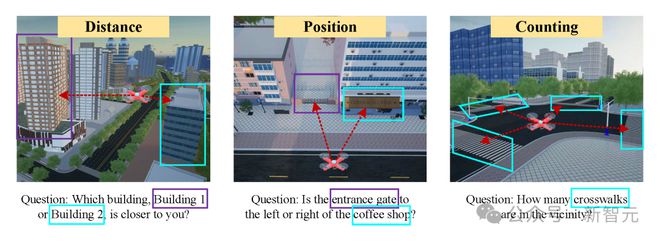

2. 跨模态问答:在具身场景理解的基础上,智能体接收有关环境语义和空间信息的自然语言问询,例如,「场景中有多少个建筑?」以及「在当前视角下A建筑是否在B建筑的左边?」输入包括第一视角的 RGB 图像和有关环境的问题,对问题进行直接文本回答。

3. 多轮对话:具身对话涉及智能体与用户之间的持续互动,需要维持上下文和理解对话流。例如,「后方中有多少棵树?-> 它们分别是什么颜色的?」任务的输入包括具身观察和多轮查询,得到多轮响应。

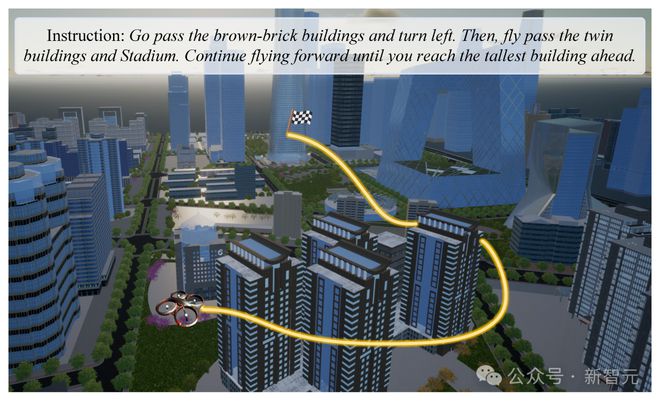

4. 具身导航/搜索:智能体根据自然语言指令在环境中进行具身导航,输入结合了视觉感知和自然语言指令,以引导智能体通过复杂环境进行实时感知、推理、决策。任务输出是环境中的行动序列。

5. 任务规划:智能体需要能够将复杂且长期的具身任务目标拆分为多个子任务,例如,「我需要去便利店购物,但我不知道怎么走,应该怎么做?」输入包括第一视角的观察和自然语言描述的任务目标,输出是智能体所规划、拆解的一系列子任务。

6. 个体行为模拟:对于行人、车辆、无人机等不同类型的智能体,需要基于第一视角的观察和当前任务规划,生成与真实个体类似、符合真实个体规律和模式的行为与动作,该任务依赖于上述任务所体现的开放世界中的感知、规划、决策等具身智能能力。

平台使用方法

EmbodiedCity 同时提供在线使用和离线运行两种智能体部署方式。

1. 在线使用

用户可以通过在平台官方网站(embodied-city.fiblab.net)申请 API Key,获得授权后即可控制接管已经实时在线部署的智能体。在线平台提供键盘控制和指令控制等多种智能体操作方式,用户可以在网页以第一视角游览城市环境。平台还提供了完善的智能体控制 Python SDK 以供调用开发,用户可以在平台网页直接编程使用。

2. 离线运行

用户可以下载离线模拟环境,在本地部署后进行智能体的训练和测试,平台提供适用于 Windows、Linux、macOS 等不同类型操作系统的相应版本,方便模拟环境的快速部署和测试。

参考资料: