新智元报道

编辑:编辑部

今天,KDD 2024 大奖结果新鲜出炉!华人学者收获颇丰,浙大校友 Jundong Li 获新星奖,博士论文奖的冠亚军均有华人学者上榜。

KDD 2024 大奖揭晓!

今年的 KDD 大会是第 30 届,在西班牙巴塞罗那隆重举办。今天,KDD 2024 宣布了今年六大奖项的获奖者,分别是研究创新奖、服务奖、新星奖、时间检验研究奖、时间检验应用科学奖和学位论文奖。

ACM SIGKDD 会议始于 1989 年,作为 AI 领域的顶会,是数据挖掘领域历史最悠久、规模最大的国际顶级学术会议,也是首个引入大数据、数据科学、预测分析等概念的会议。

35 年以来,KDD 设立奖项表彰那些在数据科学、大数据分析、机器学习以及计算机科学领域做出杰出贡献的研究人员。

时间检验奖颁给了两个类别的两篇论文,分别是 2014 年发表的 DeepWalk,以及 2013 年 MSRA 关于空气质量数据的研究。

此外,来自弗吉尼亚大学的华人学者孟瑜和北大校友 Ziniu Hu 分别获得博士论文奖的冠亚军,浙大校友 Jundong Li 获颁「新星奖」。

一起来详细了解一下每项大奖的获得者吧~

研究创新奖

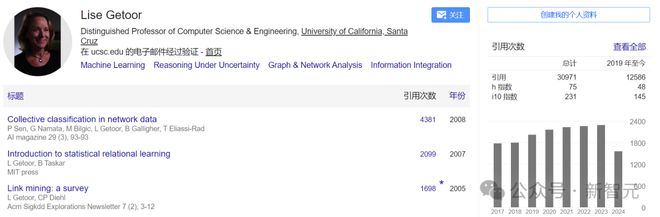

KDD 研究创新奖是知识发现和数据挖掘领域技术卓越的最高荣誉,此次奖项授予给 Lise Getoor。

Lise Getoor 教授在斯坦福大学获得本科学士学位,在加州大学伯克利分校获得硕士学位,在加州大学圣巴巴拉分校获得博士学位。

Getoor 拥有多项最佳论文奖、一项 NSF 职业奖,并且是人工智能促进协会(AAAI) 院士。作为加州大学圣巴巴拉分校计算机科学系杰出校友, 她被选为 2018 至 2019 年加州大学圣克鲁斯分校教师研究讲座教授,这是给予加州大学教师的最高认可之一。

为了表彰 Getoor 教授在不确定性机器学习和推理领域的贡献,她于 2021 年被任命为 IEEE 院士。2022 年 10 月,Getoor 当选美国科学促进会(AAAS)院士。2024 年,她被任命为美国艺术与科学学院(AAA&S)院士。Lise Getoor 还担任过《机器学习杂志》的行动编辑、JAIR 副主编 TKDD 副主编。

Lise Getoor 是加州大学圣克鲁兹分校计算机科学系特聘教授、数据科学研究中心主任,学术成就斐然,在学术期刊和会议论文集上发表了许多高引用的论文,在谷歌学术上显示论文引用量达 30971 次。

Getoot 的研究主要关注不确定性中的机器学习和推理,此外也从事数据管理、可视化分析和社交网络分析等方面的工作,在图数据和网络数据的机器学习和概率建模方面拥有丰富的经验。

新星奖

新星奖从 2020 年起设立,该奖项的设立是为了表彰 KDD 社区中在博士毕业 5 年内取得卓越成就的学者,今年新星奖授予 Jundong Li。

Jundong Li 现任弗吉尼亚大学 ECE 系、CS 系和数据科学学院助理教授。

Li 本科毕业于浙江大学软件工程系,硕士毕业于加拿大阿尔伯塔大学,2019 年从亚利桑那州立大学博士毕业,师从 Huan Li。

他的研究兴趣主要包括图机器学习、可信和安全机器学习、LLM 的模型编辑、知识增强和上下文学习,以及 AI/ML+X等领域。

时间检验奖

时间检验奖是为了表彰已发表数十年的杰出 KDD 论文。

本届时间检验奖分为两类:研究类和应用数据科学类。

研究类

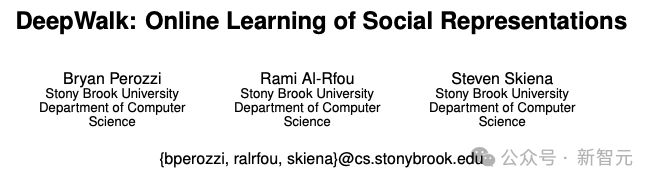

来自纽约石溪大学三位研究者获得了时间检验奖。这篇论文发表于 2014 年,在 Google Scholar 上的引用量是 11426 次,这篇论文也曾被收录进第 20 届 KDD 论文集。

论文提出的 DeepWalk 是一种学习网络节点潜在表示的新方法,这些潜在表示在连续向量空间中对社会关系进行编码,从而方便在统计模型中使用,为推进 GNN 研究奠定了基础。

DeepWalk: online learning of social representations

作者:Brian Perozzi, Rami Al-Rfou, Steven Skiena

机构:纽约石溪大学

论文地址:https://arxiv.org/abs/1403.6652

DeepWalk 涵盖了语言建模和无监督特征学习(或深度学习)领域从词序列到图的最新进展。在随机游走(random walk)过程中,将每一次行走轨迹视为句子的等价来学习潜在表示,将其截断后获得局部信息。

DeepWalk 在 BlogCatalog、Flickr 和 YouTube 等平台的多标签网络分类任务中学习潜在表示,之后的实验结果表明,在信息丢失的情况下,其性能依旧保持远超基准线的水平。

在一些实验中,DeepWalk 优于所有基线方法,同时使用的训练数据少 60%。

由于 DeepWalk 是一种可扩展的在线学习算法,因此适合广泛的现实应用,例如网络分类和异常检测等等。

应用数据科学

U-Air: when urban air quality inference meets big data

作者:Yu Zheng, Furui Liu, Hsun-Ping Hsieh

机构:微软亚洲研究院

另一篇时间检验奖颁给了来自微软亚洲研究院的论文,发表于 2013 年,谷歌学术上被引用次数为 1098。

论文一作郑宇是 IEEE Fellow、ACM 杰出科学家,现任京东副总裁和京东科技首席数据科学家。

论文地址:https://dl.acm.org/doi/10.1145/2487575.2488188

论文提出用大数据模型监测城市空气质量,根据现有监测站报告的(历史和实时)空气质量数据以及城市中的各种数据源,例如气象、交通流量、人员流动性、道路网络结构和 POI 推断出整个城市实时的空气质量信息,克服了以往的空气质量监测站无法显示实时数据并且受到气象和交通状况限制的问题。

论文提出了一种基于协同训练框架的半监督学习方法,该框架由两个独立的分类器组成:一种是基于人工神经网络(ANN)的空间分类器,以空间相关特征(例如 POI 密度和高速公路的长度)作为输入,对不同地点的空气质量之间的空间相关性进行建模。

另一种是基于线性链条件随机场(CRF)的时间分类器,涉及时间相关的特征(例如交通和气象)来对某个位置的空气质量进行建模。

论文获取了北京和上海的五个真实数据源并进行了广泛的实验,实验结果显示出相对于四类基线的优势:包括线性/高斯插值、经典分散模型、决策树和 CRF 以及 ANN。

学位论文奖

Efficient and Effective Learning of Text Representations

作者:Yu Meng

机构:伊利诺伊大学厄巴纳-香槟分校

论文地址:https://www.ideals.illinois.edu/items/129146

由于大模型的预训练和微调需要使用大量文本数据,且模型的扩展涉及成百上千亿参数,因此 LLM 成本相当昂贵。这篇博士论文重点关注如何使用高效且有效的方法学习文本表示,包括以下几个子问题:

- 利用球面空间(spherical space)进行文本表示学习:传统上,对表示空间的选择通常是欧几里得空间,但非欧的球面空间更能通过方向相似性捕捉相关语义,论文主要就讨论了一种利用球面空间进行文本表示的自监督方法

- 基于球面文本表示空间发掘话题结构;

- 利用 LLM 为自然语言理解任务生成数据,减少对人工标注数据的需求

本文作者 Yu Meng 的本科、硕士和博士均毕业于 UIUC,曾在普林斯顿 NLP 小组担任访问研究员,与陈丹琦合作,在谷歌、微软、Meta 等公司均有实习经历,今年加入弗吉尼亚大学 CS 系担任助理教授。

亚军

Make Knowledge Computable: Towards Differentiable Neural-Symbolic AI

作者:Ziniu Hu

机构:加州大学洛杉矶分校

论文地址:https://escholarship.org/uc/item/3ft4t0nj

深度学习方法可以记忆大量世界知识,但对其进行符号推理时仍然存在局限性;而符号人工智能擅长解决推理任务,但适应新知识的效率较低。之前连接这两个领域的工作主要集中在构建基于解析的系统(parsing-based systems),这需要大量带注释的中间步骤标签并且难以扩展。

论文讨论了神经(neural)人工智能系统和符号(symbolic)人工智能系统的交叉点。这项研究的最终目标是使神经模型能够以可微分的方式与符号推理模块交互,并在没有中间标签的情况下端到端地训练神经符号模型( Neural-Symbolic model),研究的具体工作包括:

- 设计新颖的推理模块:可微分的、能进行符号推理的神经模块,包括知识图谱推理和复杂的逻辑推理

- 通过自我监督学习:通过结构和符号知识库的自我监督来训练神经模型,无需额外标注

- 跨领域泛化:神经符号系统的模块化设计本质上有助于更好地泛化到分布外、词库外、跨语言和跨类型的样本

将这些部分放在一起,最终目标是构建具有推理能力的端到端神经符号系统,将 AI 推进到真正的人类智能。

Ziniu Hu 本科毕业于北京大学计算机科学系,博士毕业于加州大学洛杉矶分校,并在加州理工学院完成了博士后工作。他曾在 DeepMind 担任访问研究员,并获得过亚马逊博士奖学金、商汤科技奖学金和百度奖学金。

Artificial Intelligence for Data-centric Surveillance and Forecasting of Epidemics

作者:Alexander Rodriguez

机构:佐治亚理工学院

论文地址:https://repository.gatech.edu/entities/publication/aa292b79-26bb-4aec-a3f3-0fd87911ff74/full

流行病的监测和预测是政府官员、企业和公众决策和规划的重要工具,但在许多方面,我们对流行病如何传播的理解仍处于起步阶段,其挑战性源于各种复杂的动态,例如流动模式、政策合规性,甚至数据收集程序的变化。

由于最近的研究收集和处理了新来源的数据,许多变量的细粒度数据变得越来越可用。然而,传统方法依然很难利用这些数据集。另外,流行病学中的人工智能方法也面临着数据稀疏、分布变化和数据质量差异的挑战。人工智能还缺乏对流行病动态的了解,这可能会导致不切实际的预测。

本文提出了几个框架来应对这些挑战,并转向更加以数据为中心的方法。具体来说,我们利用多个例子来展示,将 AI 领域中数据驱动的可表达性引入流行病学,可以使流行病的监测和预测更加灵敏和精确。

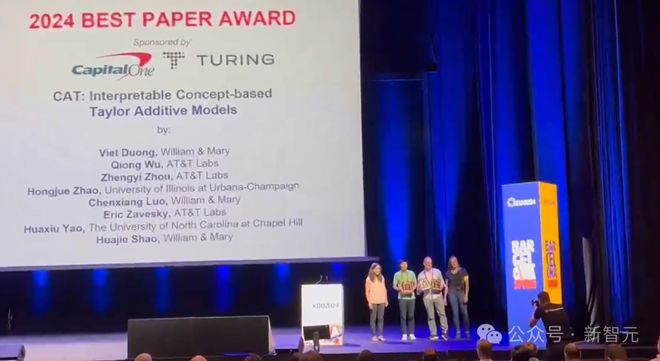

最佳论文奖

研究类

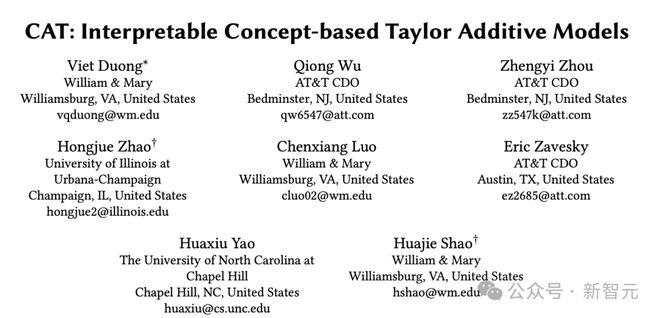

CAT: Interpretable Concept-based Taylor Additive Models

作者:Viet Duong, Qiong Wu, Zhengyi Zhou, Hongjue Zhao, Chenxiang Luo, Eric Zavesky, Huaxiu Yao, Huajie Shao

机构:威廉玛丽学院、AT&T、UIUC、北卡罗来纳大学教堂山分校

论文地址:https://arxiv.org/abs/2406.17931

广义相加模型(GAM)采用神经网络单独学习每个特征的非线性函数,然后通过线性模型组合进行最终预测。尽管 GAM 可以在特征层面解释深度神经网络 (DNN),但需要大量模型参数,并且容易过度拟合,因此难以训练和扩展。

此外,在具有许多特征的现实数据集中,基于特征方法的可解释性会降低。为了解决这些问题,最近的研究已转向基于概念的可解释方法,试图将概念学习集成为预测前的中间步骤,并用人类可理解的概念来解释预测。然而,这种方法需要领域专家进行大量的概念标注工作。

为了解决以上问题,论文提出了一种可解释的基于概念的泰勒相加模型 CAT(Concept-bAsed Taylor additive models),不需要领域专家标注概念或价值观,只需要用户将输入特征进行大致分组,就可以通过查看元数据进行解释。

具体来说,CAT 首先将每组输入特征编码为一维的高层次概念表示,然后将其输入到新提出的「白盒」泰勒神经网络(TaylorNet)中。TaylorNet 旨在使用多项式学习输入和输出之间的非线性关系。多个基准的评估结果表明,CAT 的性能可与基线相当甚至优于基线,同时减少对大量模型参数的需求。重要的是,它可以通过人类能理解的高级概念来解释模型预测。

应用数据科学

LiGNN: Graph Neural Networks at LinkedIn

作者:Fedor Borisyuk, Shihai He, Yunbo Ouyang, Morteza Ramezani, Peng Du, Xiaochen Hou, Chengming Jiang, Nitin Pasumarthy, Priya Bannur, Birjodh Tiwana, Ping Liu, Siddharth Dangi, Daqi Sun, Zhoutao Pei, Xiao Shi, Sirou Zhu, Kay Shen, Kuang-Hsuan Lee, David Stein, Baolei Li, Haichao Wei, Amol Ghoting, Souvik Ghosh

机构:LinkedIn

论文地址:https://arxiv.org/abs/2402.11139

论文提出了 LiGNN,一种大规模图神经网络(GNN)框架,并且提出了一系列针对 GNN 表示学习质量的算法改进,包括具有长期损失的时态图架构,以及通过图的致密化(graph densification)、ID 嵌入和多跳邻居采样(multi-hop neighbor sampling)的有效冷启动解决方案。

论文解释了如何通过邻居的自适应采样、训练数据批的分组和切片、专门的共享内存队列和局部梯度优化,在 LinkedIn 图上进行了 7x 加速的大规模训练。

这项技术在具体应用中使职位申请回复率大约相对提高了1%,广告点击率提升了2%,Feed 参与的每日活跃用户数提升了 0.5%,会话数量提升了 0.2%,每周活跃用户数提升了 0.1%。

应用数据科学类(亚军)

Nested Fusion: A Method for Learning High Resolution Latent Structure of Multi-Scale Measurement Data on Mars

作者:Austin Wright, Duen Chau, Scott Davidoff

机构:佐治亚理工学院、加州理工学院

论文地址:https://dl.acm.org/doi/10.1145/3637528.3671596

毅力号火星探测器代表了火星测量规模的代际变化,但分辨率的提高给探索性数据分析技术(EDA)带来了新的挑战。

火星车上的多个不同仪器分别测量某种特定属性,因此需要分析底层的现象如何影响多个仪器的测量,这对理解全貌非常重要。此外,每种仪器都有独特的分辨率,将不同分辨率的数据放在一起进行映射、分析也是复杂的工作。

论文引入了 Nested Fusion 方法,将不同分辨率的任意层级的数据集组合在一起,并以尽可能高的分辨率产生潜在分布,对不同测量和尺度之间的复杂相互关系进行编码。

这种方法对于大型数据集非常高效,甚至可以对未见数据进行推理,并且优于现有的对真实火星漫游器数据进行降维和潜在分析的方法。

Nested Fusion 已在 NASA 喷气推进实验室 (JPL) 的火星科学团队中部署使用,并通过多轮研究和设计,极大地增强了科学家的探索性分析工作流程。

最佳学生论文

研究类

Dataset Regeneration for Sequential Recommendation

作者:Mingjia Yin, Hao Wang, Wei Guo, Yong Liu, Suojuan Zhang, Sirui Zhao, Defu Lian, Enhong Chen

机构:中国科技大学、认知智能全国重点实验室、华为新加坡研究中心

论文地址:https://arxiv.org/abs/2405.17795

顺序推荐器(sequential recommender,SR)是现代推荐系统的重要组成部分,旨在捕获用户偏好的演变过程。

之前的研究为增强 SR 系统的能力做出了许多努力,这些方法通常遵循以模型为中心的范式,基于固定数据集开发模型。然而,这种方法常常忽视数据中潜在的质量问题和固有缺陷。

本文提出了一种新颖的以数据为中心的范式,使用一种「模型无关」(model-agnostic)的数据集再生框架来开发理想的训练数据集。该框架被称为 DR4SR,重新生成的数据集对不同架构的模型具有卓越的泛化性能。

此外,论文还引入了 DR4SR+ 框架,包含一个有模型感知(model-aware)的数据集个性化工具,可以专门针对目标模型定制数据集。实验中,将 DR4SR 系列框架与各种以模型为中心的方法集成,在 4 个流行数据集上看到了显著的性能改进。此外,文章还进行了深入分析,探索以数据为中心的范式的潜力并提供有价值的见解。

服务奖

KDD 服务奖是该领域对学者们进行专业服务的最高认可,比如专业协会和会议的运营、学生和专业人士的教育、研发活动的资助等。本届服务奖授予给 Faisal Farooq。

Faisal Farooq 是现任 Pinterest 高级工程总监和 ACM KDD 的主席,在构建机器学习(包括深度学习)产品方面拥有 10 年以上的领导经验。

他拥有 20 多项专利,发表了 40 多篇论文,在 NIPS、ICML、KDD、ICPR 组织了多次会议,担任过 2018 年 KDD 会议主席。

参考资料: