智东西

作者 ZeR0

编辑漠影

智东西 6 月 28 日报道,昨晚,谷歌在I/O Connect 大会上放大招,公布其新一代最强开源模型——Gemma 2。

Gemma 2 有 90 亿(9B)和 270 亿(27B)两种参数规模可用。27B 模型训练了 13T tokens,9B 是 8T tokens,都拥有 8192 上下文窗口,可在 Google AI Studio 中使用。26 亿参数(2.6B)模型将很快发布,小到可以在手机本地运行。

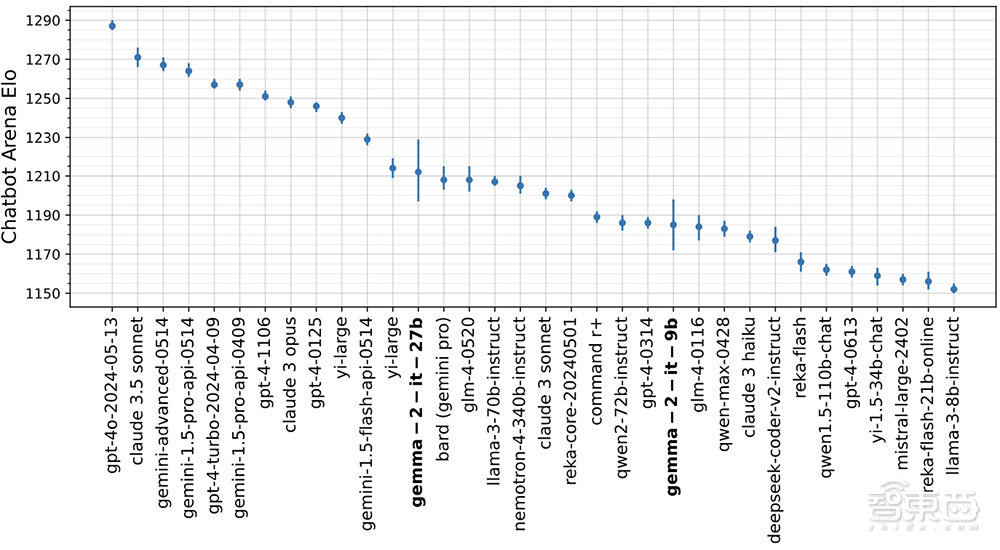

在盲测大语言模型竞技场 LMSYS Chatbot Arena 中,270 亿参数的 Gemma 2 指令微调模型击败了拥有 700 亿参数的 Llama 3,并超过 Nemotron 4 340B、Claude 3 Sonnet、Command R+、Qwen 72B 等模型,在所有开源权重的模型中位列第一;9B 模型则是当前 15B 以下参数的模型中成绩最好的。

谷歌在今年早些时候推出轻量级先进开源模型 Gemma,只有 2B 和 7B 参数版本,下载量超过 1000 万次。Gemma 2 涵盖从 20 亿到 270 亿参数,比第一代性能更高、推理效率更高,并且显著改进安全性。这是该系列模型迈出的一大步。

270 亿参数的 Gemma 2 提供了与两倍以上参数的模型竞争的替代方案,提供了直到去年 12 月才可能实现的性能,而且可以在单个英伟达 A100/H100 Tensor Core GPU 或 TPU 主机上以全精度高效运行推理,大大降低了部署成本。

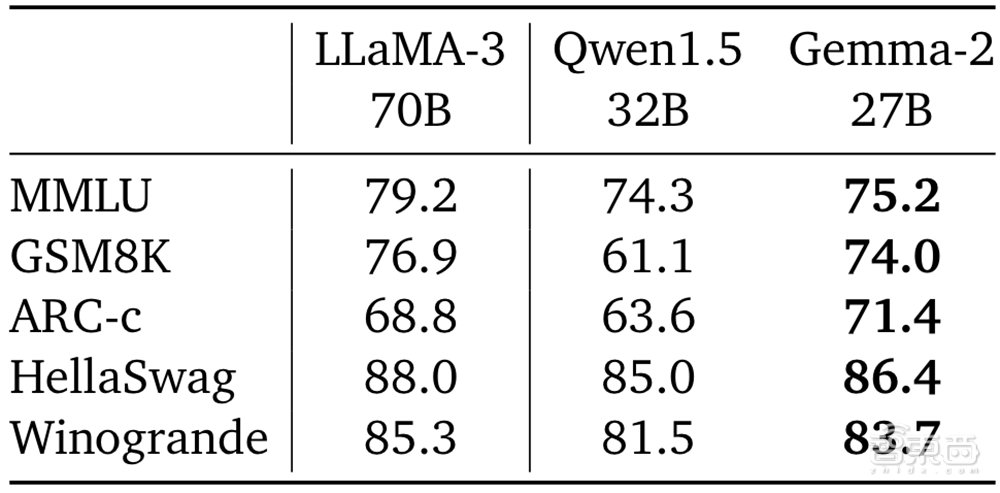

在 Hugging Face 的基准上,谷歌将 Gemma 2 27B 与具有类似尺寸的 Qwen1.5 32B 进行了比较,还报告了 Llama 3 70B 的性能。Gemma 2 27B 的尺寸只有 Llama 3 70B 的40%,训练数据少到 Llama 3 70B 的2/3。结果显示,Gemma 2 27B 优于 Qwen1.5 32B,比 Llama 3 70B 低几个百分点。

一、重新设计架构,Gemma 2 有三大特点

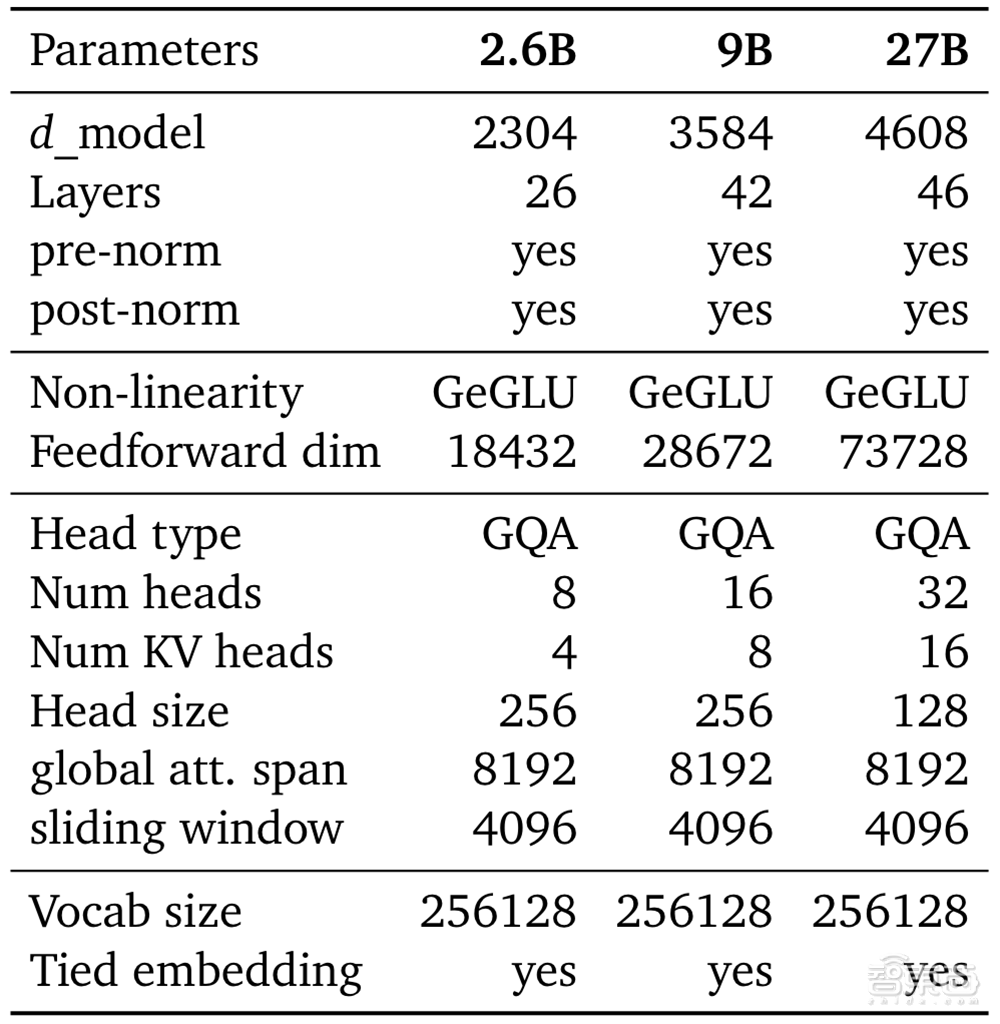

Gemma 2 的技术报告共 15 页,介绍了其架构的多项技术改进,包括交替使用局部-全局注意力机制和分组查询注意力,还使用知识蒸馏而不是下一个 token 预测来帮助训练较小的 2B 和 9B 模型。

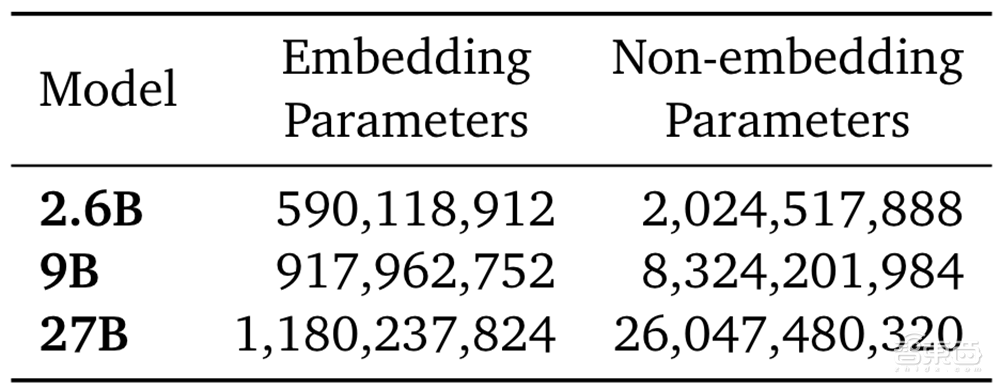

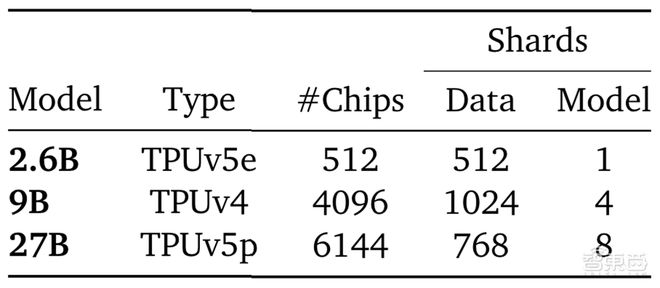

▲Gemma 模型的参数量

2. 6B 模型在一个 TPUv5e 集群的 2x16x16 配置上训练,总共用了 512 张芯片。9B 模型在 TPUv4 集群的 8x16x32 配置上训练,总共 4096 张芯片。27B 模型在 TPUv5p 集群的 8x24x32 配置上训练,总共用了 6144 张芯片。

▲用切分训练基础设施

针对更高的性能和推理效率,谷歌在重新设计的架构上构建了 Gemma 2。该模型采用与 Gemma 1.1 相似的算法配方,但用了更多的 teacher 监督并执行了模型合并。在编程、数学、推理、安全等能力上,Gemma 2 都比 1.1 版本提升显著。

▲主要模型参数及设计选择的概述

结果,Gemma 2 模型在其规模上提供了最佳性能,甚至提供了与大2-3 倍的模型竞争的替代方案。以下是其突出的特点:

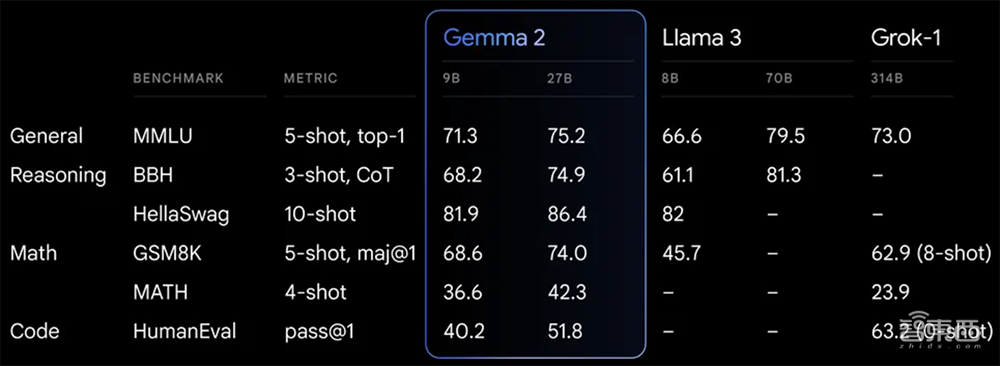

(1)卓越性能:Gemma 2 27B 在其同类大小中提供了最佳性能,甚至提供了与两倍以上大小的模型竞争的替代方案。Gemma 2 9B 模型也提供了领先的性能,超过了 Llama 3 8B 和其他同类大小的开源模型。

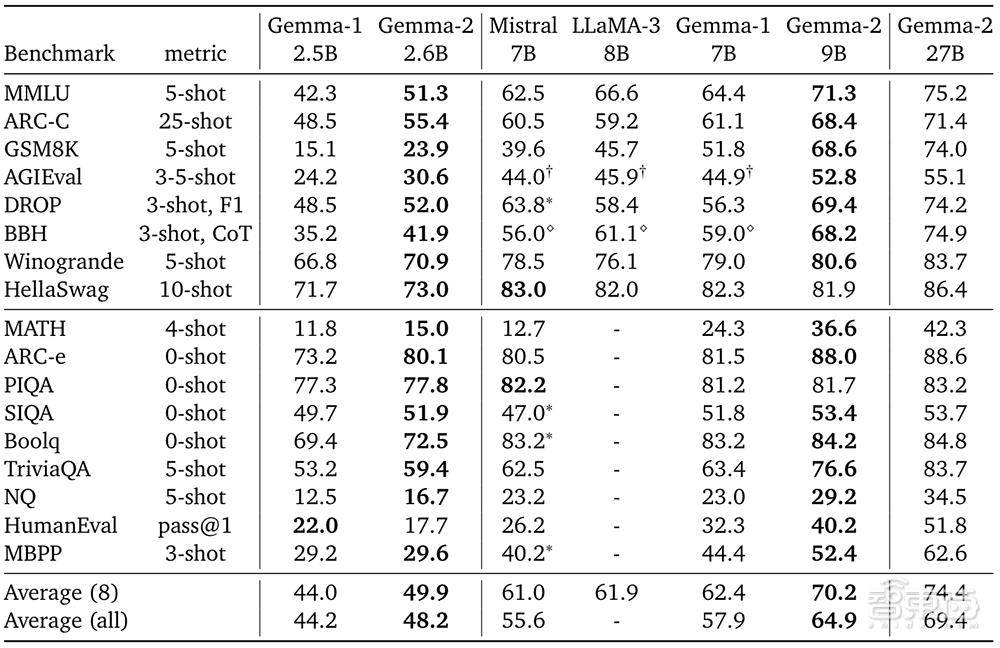

谷歌在各种基准上比较 2.6B、9B 及 27B 模型,报告了可以与 Llama 3 进行比较的 8 个基准测试的平均性能,以及所有基准测试的平均性能。Llama 3 8B 的数据来自 HuggingFace leaderboard 或其博客。

在 MMLU 上,9B 模型得分为 71.3,27B 模型为 75.2;在 AGIEval 上,9B 模型得分 52.8,27B 模型得分 55.1;在 HumanEval 上,9B 模型得分 40.2,27B 模型得分 51.8。

(2)无与伦比的效率和成本节省:Gemma 2 27B 模型设计用于在单个谷歌云 TPU 主机、英伟达 A100 80GB Tensor Core GPU 或 H100 Tensor Core GPU 上高效运行全精度推理,在保持高性能的同时显著降低成本。这使得 AI 部署更加易于访问和经济实惠。

(3)跨硬件的快速推理:Gemma 2 经过优化,可以在各种硬件上以令人难以置信的速度运行,硬件从功能强大的游戏笔记本电脑和高端台式机到基于云的设置。在 Google AI Studio 中以全精度试用 Gemma 2,在 CPU 上使用 Gemma.cpp 的量化版本解锁本地性能,或在家用计算机上通过 Hugging Face Transformers 在英伟达 RTX 或 GeForce RTX 上试用。

二、支持商业化,兼容广泛框架,方便部署

Gemma 2 为开发者和研究人员构建,其设计更容易集成到工作流程中:

(1)开放且可访问:与原始 Gemma 模型一样,Gemma 2 也是根据谷歌具有商业友好的 Gemma 许可发布的,允许开发人员和研究人员分享和商业化他们的创新。

(2)广泛的框架兼容性:Gemma 2 兼容主要的 AI 框架,如 Hugging Face Transformers,以及通过原生 Keras 3.0、vLLM、Gemma.cpp、Llama.cpp 和 Ollama 的 JAX、PyTorch 和 TensorFlow。此外,Gemma 优化了英伟达 TensorRT-LLM 以在英伟达加速基础设施上运行或作为英伟达 NIM 推理微服务运行。用户可以使用 Keras 和 Hugging Face 进行微调。谷歌正在积极努力实现更多参数高效的微调选项。

(3)轻松部署:从下个月开始,谷歌云客户将能轻松在 Vertex AI 上部署和管理 Gemma 2。

新的 Gemma Cookbook 是一个包含实用示例和指南的集合,引导用户构建自己的应用程序并为特定任务微调 Gemma 2 模型。

三、提供负责任的 AI 开发资源,严格测试评估模型安全性在负责任的 AI 开发方面,谷歌提供负责任地构建和部署 AI 所需的资源,包括负责任的生成式 AI 工具包。最近开源的 LLM Comparator 帮助开发者和研究人员深入评估语言模型。

即日起,用户可使用配套的 Python 库与自己的模型和数据进行比较评估,并在应用程序中可视化结果。此外,谷歌正在积极致力于开源文本水印技术 SynthID,用于 Gemma 模型。

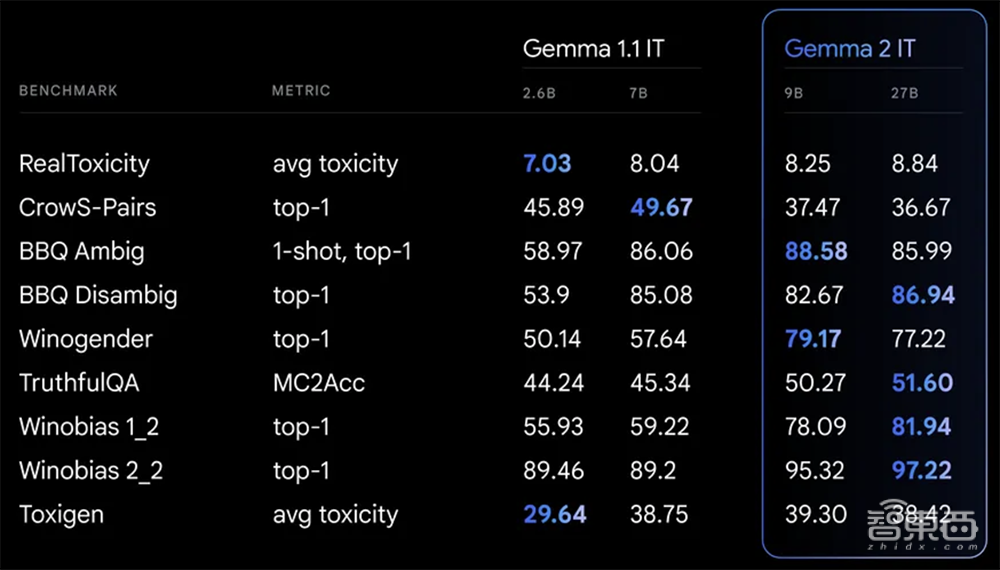

在训练 Gemma 2 时,谷歌遵循内部安全流程,过滤了训练前的数据,并针对一套全面的指标进行了严格的测试和评估,以识别和减轻潜在的偏见和风险。谷歌在与安全性和代表性危害相关的大量公共基准上公布了其结果。

▲Gemma 2 IT 模型和 Gemma 1.1 IT 模型的安全学术基准结果

结语:大模型研发趋于实用主义

谷歌 Gemma 2 的研究进展反映了当前大模型研究趋势,即探索用更轻量级的、更实用的模型来实现更强的性能,并确保易部署,以更好地满足不同的用户需求。

谷歌为开发者和研究人员提供了使用这些模型的多种途径。Gemma 2 现可在 Google AI Studio 中使用,可在没有硬件要求的情况下测试其 270 亿参数的全部性能,也可以从 Kaggle 和 Hugging Face Models 下载 Gemma 2 的模型权重,Vertex AI Model Garden 即将推出。

通过 Gemma 2,谷歌证明了蒸馏是训练此类模型的有效方法,基于输出概率的训练能够比纯粹的下一个 token 预测产生更多的效果。模型仍存在局限性,需要未来研究来持续优化事实性、对抗性攻击的鲁棒性以及推理和一致性。

为支持研究和开发,Gemma 2 还可通过 Kaggle 免费获得,或通过 Colab 笔记本的免费层获得。首次使用谷歌云服务的用户可能有资格获得 300 美元的积分。学术研究人员可以申请 Gemma 2 学术研究计划,以获得谷歌云积分,加速对 Gemma 2 的研究。申请截止日期为 8 月 9 日。

来源:谷歌 DeepMind