新智元报道

编辑:编辑部

时隔 3 年,清华团队的研究再次登上 Nature 封面。刚刚,世界首个类脑互补视觉芯片 Tianmouc 重磅发布,灵感来源于人类视觉系统。它能以极低带宽和功耗采集图像信息,突破了传统的视觉感知挑战,自如应对开放世界中极端场景难题。

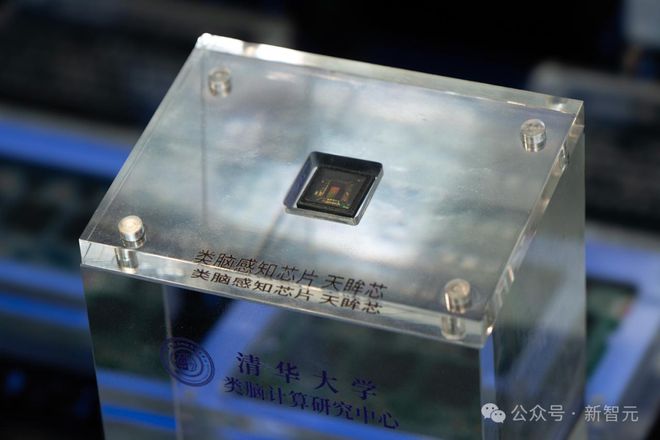

就在刚刚,清华团队发布世界首款类脑互补视觉芯片——「天眸芯」。

这是一种基于视觉原语的互补双通路类脑视觉感知新范式,标志着我国在类脑计算和类脑感知两个重要方向,取得的重大突破!

研究《面向开放世界感知具有互补通路的视觉芯片》(A Vision Chip with Complementary Pathways for Open-world Sensing)一经发布,即登上 Nature 封面。

团队由清华大学施路平教授领衔,依托清华精密仪器系的类脑计算研究中心。

论文地址:https://www.nature.com/articles/s41586-024-07358-4

而且,这已经是该团队第二次登上 Nature 杂志封面了。上一次登上 Nature 的,是异构融合类脑计算「天机芯」。

「天眸芯」的成功研制,意味着智能感知芯片领域的一个重大突破。

它不仅为智能革命的发展提供了强大的技术支持,还为自动驾驶、具身智能等重要应用,开辟了新的道路。

「天眸芯」的重大意义,在于它突破了视觉感知的瓶颈。

在复杂多变、不可预测的环境中,实现高效、精确、鲁棒的视觉感知,挑战非常间艰巨。传统的视觉感知芯片因为「功耗墙」「带宽墙」,应对极端场景时往往会失真、失效、高延迟。

而施路平教授团队提出的新范式,借鉴了人类视觉系统的基本原理,形成了两条优势互补、信息完备的视觉感知通路。

而「天眸芯」,在极低的带宽(相对传统高速成像技术降低 90%)和功耗代价下,只需单个芯片即可实现每秒 10000 帧的高速、10bit 的高精度、130dB 的高动态范围的视觉信息采集!

结合团队在「天机芯」、类脑软件工具链、类脑机器人等方面已有的落地技术积累,从此类脑智能生态将进一步完善,有力推动人工通用智能的发展。

「人类视觉系统」启发全新范式

随着 AI 加速发展,无人驾驶、具身智能等「无人系统」在现实中的应用更加广泛,并引领着新一轮科技产业革命。

在这些智能系统中,视觉感知作为获取信息的核心途径,发挥着至关重要的作用。

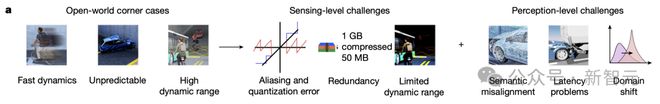

就以自动驾驶举例,在真实的开放世界中,系统不仅需要处理庞大的数据,还需要应对各种极端事件。

比如,恶劣天气环境、驾驶中突发的危险,夜间强闪光干扰等各种长尾问题,为 AI 系统带来了极大的挑战。

这时,如果采用传统的视觉感知芯片,会受到「功耗墙」和「带宽墙」的限制,无法同时应对以上驾驶中出现的边缘情况。

更进一步说,传统视觉芯片在面对这些场景时,往往会出现失真、失效或高延迟的问题,严重影响了系统的稳定性和安全性。

为了克服这些挑战,清华团队聚焦类脑视觉感知芯片技术,提出了一种全新的范式——基于视觉原语的互补双通路类脑视觉感知范式。

这一范式借鉴了人类视觉系统(HVS)的基本原理。因为与现有的图像传感器相比,HVS 在开放世界中更具优势。

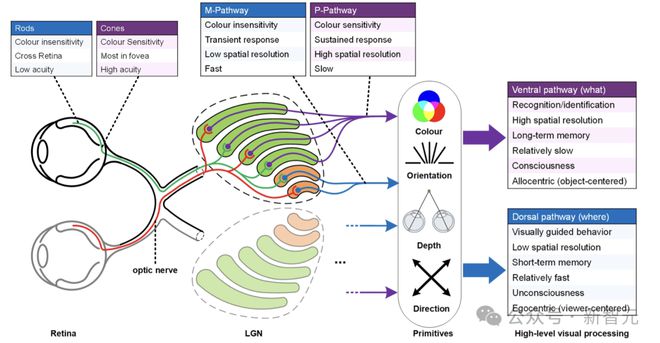

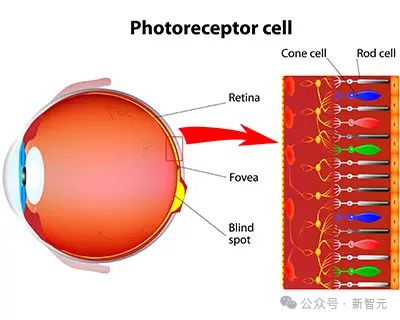

人类视觉系统(HVS)的互补性。视网膜由杆状细胞和锥状细胞组成,它们以相反的方式运作以扩大感知范围。在下一个层——外膝体(LGN)中,M通路和P通路以互补的方式编码信息。LGN 输出的信息由在初级视觉皮层 V1 被重新组织成一系列视觉原语,包括颜色、方向、深度和运动方向等。最后,这些「视觉原语」被分别传输到腹侧通路和背侧通路,以促进物体识别和视觉引导行为

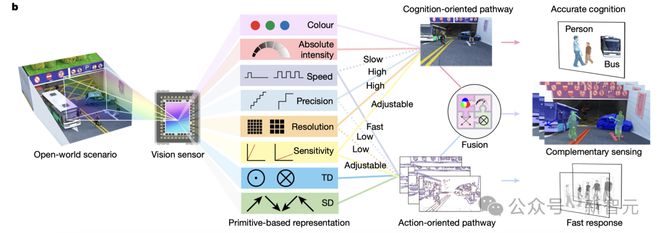

具体讲,新范式包括了「基于视觉原语的表征」,以及「两条互补视觉通路」(CVP)。

在这一范式中,借鉴人视觉系统中的视觉原语的概念,它将开放世界的视觉信息拆解为「视觉原语」。这些视觉原语各自描述了视觉信息的一种基本要素。

然后通过有机组合这些原语,借鉴人视觉系统的特征,形成两条优势互补、信息完备的视觉感知通路,如下图所示。

其中,视觉原语包括但不仅限于颜色、数据精度、灵敏度、空间分辨率、速度、绝对强度、空间差(SD)和时间差(TD)。

CVP 包括两条不同的通路:认知导向通路(COP)和行动导向通路(AOP)。与 HVS 中的腹侧通路(Ventral stream)和背侧通路(Dorsal stream)相类似。

「认知导向通路」使用颜色、强度、高空间分辨率和高精度等视觉原语,来实现精确认知,最大限度地减少空间混叠和量化误差。

相比之下,「行动导向通路」使用 SD、TD、速度等视觉原语,来实现鲁棒、高稀疏的快速反应,从而解决数据冗余和延迟问题。

这两种方法在构建正常情况,以及边缘情况的表征时相互补充,从而实现了高动态范围,并缓解了语义错位和分布外物体检测问题。

首款类脑互补视觉芯片诞生

互补视觉芯片设计

基于这个范式,清华团队设计出世界第一款名为「天眸芯」(Tianmouc)的类脑互补视觉芯片。

那么,这款芯片的设计架构是怎样的?

使用传统图像传感器架构实现互补传感范式,将面临诸多挑战。

首先,设计像素阵列时,需确保其能够在同一焦平面(focal plane)上,同时进行光电信息转换。

此外,两条读出路径的架构,必须包含能够处理不同数据分布和模态的异构模块。

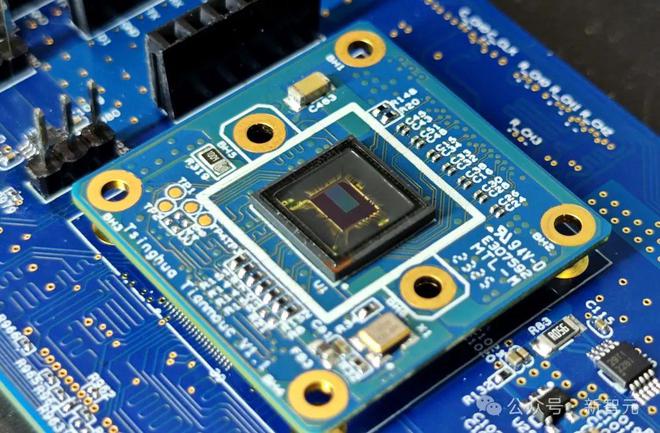

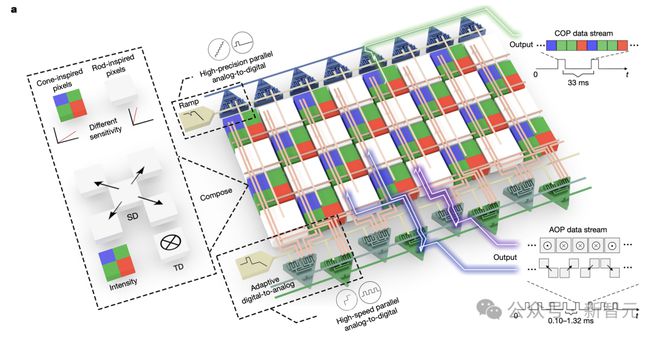

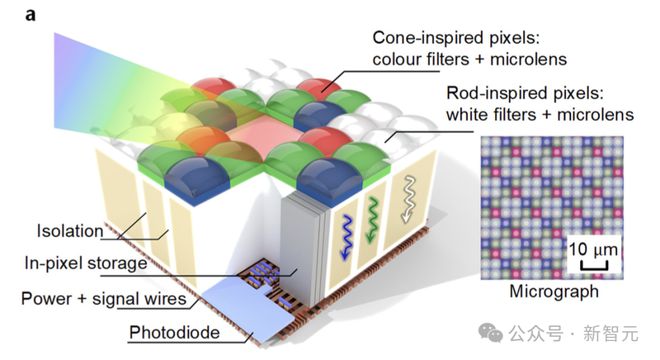

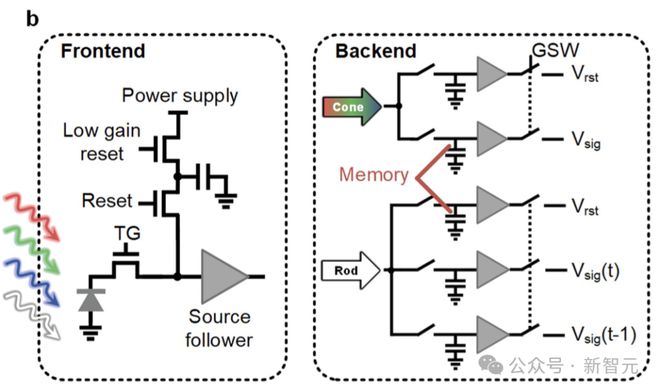

如上图a所示,「天眸芯」采用 90 纳米背照式 CMOS(Back-illuminated sensor)技术制造,包含了两个核心部分:

一是,用于将光学信息转换为电信号的混合像素阵列;另一个是,用于构建两个 CVP 的并行和异构读出架构。

背照式混合像素阵列的像素结构示意图

受感光细胞(photoreceptor cell)启发,混合像素阵列由锥体启发,以及杆体启发的像素组成,具有不同的特性,如颜色、响应模式、分辨率和灵敏度。

这些像素可以将视觉信息,解析为特定的颜色(红、绿、蓝),以及白色光谱,以作为颜色对立视觉原语。

它们还可以通过,高或低的电荷到电压转换增益,调整为四种不同的灵敏度,从而利用高增益模式的低噪声和低增益模式的高饱和容量,以实现高动态范围。

受锥体启发的像素,设计为 4 微米精细间距,用于绝对强度感应。

视锥细胞和视杆细胞的像素示意图

而视杆细胞启发的像素则有两个较大的感受野,分别为 8 微米和 16 微米,用于感应 TD 和 SD。

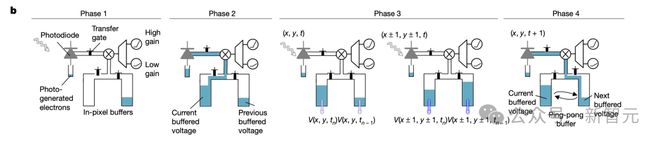

时空连续像素架构,通过使用高密度像素内存,进而实现 TD 和 SD 计算。

具体而言,视杆细胞启发的像素以乒乓操作(ping-pong behaviour)缓冲历史电压信号,以便在 AOP 读出中连续计算 TD。

对于跨块的视杆细胞启发像素中相同的内存,可以重新组织以计算 SD,如下图b中的操作阶段所示。

总而言之,完整的混合像素阵列包括 320×320 个视锥细胞启发像素和 160×160 个视杆细胞启发像素。

此外,沿两条路径传输的电信号会表现出不同的特性,包括数据分布和稀疏性的差异。

这就要求,采用不同方法以适当速度和精度,将信号编码为数字数据。

为了解决这一挑战,「天眸芯」便采用了并行和异构读出架构。

对于认知导向通路(COP),绝对强度信号到密集矩阵的准确转换至关重要。这是通过单斜率模数(single-slope analog-to-digital)架构实现的。

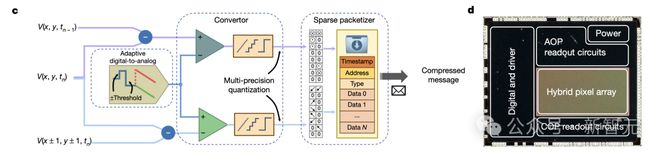

相比之下,行动导向通路(AOP)需要,对具有对称拉普拉斯分布和稀疏性特征的「时空差异信号」快速编码。

因此,研究人员特意采用了专门的读出架构(如下图c)。

其中,可编程阈值滤波器用于最小化计算的 TD 和 SD 信号中的冗余和噪声,同时保留关键信息。

随后,这些信号使用具有可配置精度的,快速极性自适应「数模转换器」进行量化。

此外,数据打包器用于实现稀疏可变精度 TD 和 SD 信号的无损压缩,并采用统一协议(如图d所示——显示了「天眸芯」整体布局的光学显微照片)。

这种方法提供了自适应能力,以减少带宽并进一步提高 AOP 的操作速度。

「天眸芯」测试结果

研究者对「天眸芯」的性能指标,包括量子效率、动态范围、响应速度、功耗和带宽等,进行了全面评估。

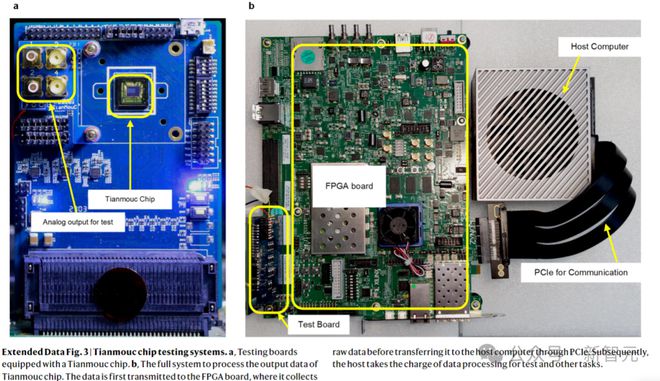

a.配备芯片的测试板;b.处理芯片输出数据的完整系统

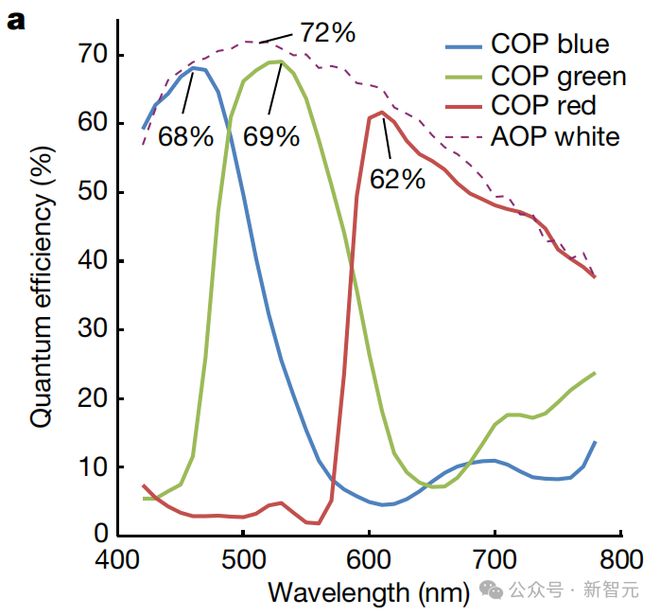

在 COP 和 AOP 中,它都表现出高量子效率,在 530nm 时 AOP 达到最大 72%,COP 达到最大 69%。

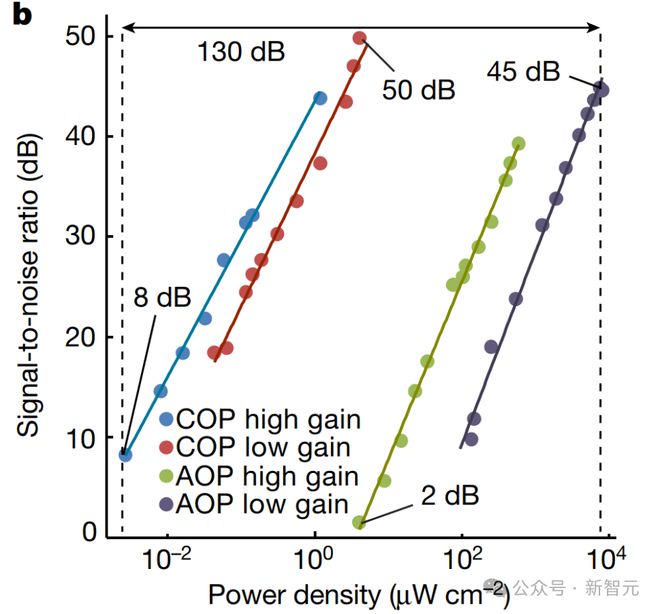

通过结合互补的 COP 和 AOP 中不同增益模式的动态范围,它实现了高动态范围。

测试芯片特征的实验装置如下。

a.基于 EMVA1288 的芯片评估实验装置;b.光学装置的照片;c.芯片评估系统,包括芯片测试板、FPGA 板、主机、高速 ADC 采集卡;d.动态范围测量的光学装置;e.用于动态范围测量的光学装置照片

如上图b所示,通过检测最低功率密度 2.71×10^−3 μW/cm^2,和最高功率密度 8.04×10^3 μW/cm^2,总动态范围达到 130dB,这就符合了一个公认的标准。

而「天眸芯」的互补路径,实现了高空间分辨率和精度。

并且,它在不可预测的环境中具有高鲁棒性。

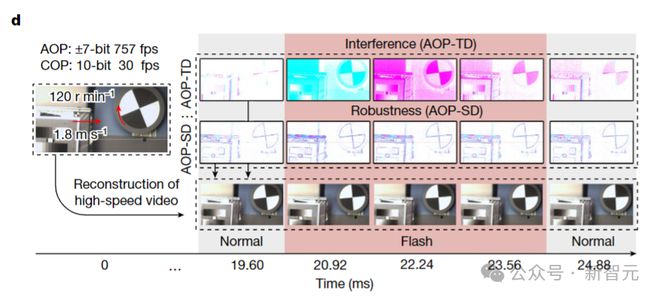

为了消除 AOP 引起的空间混叠和量化误差,「天眸芯」互补地使用了空间分辨率和精度。

可以看到,尽管上图c中由 AOP-SD 捕获的标准西门子星图,可能因其低分辨率而显得失真,但 COP 准确地记录了它。

如上图d所示,在一个有水平快速移动和旋转物体以及变化光照条件的场景中,一道突然的闪光扰乱了 AOP-TD,但 AOP-SD 不受影响。

通过结合 COP 图像与 AOP-TD 和 AOP-SD,逐帧重建高速视频可以恢复高速运动。

使用 AOP,「天眸芯」展示出了快速的响应,可重新配置的速度范围从 757fps 到 10,000fps,精度从±7bit 到±1bit。

这就补充了 COP 的相对较慢速度,保持了 30fps 和 10bit 分辨率的持续响应。

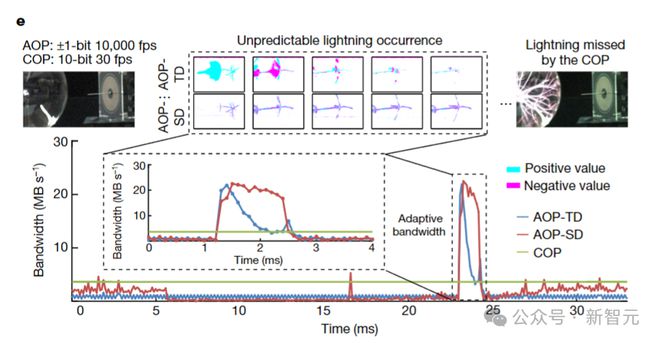

评估「天眸芯」的高速能力,可以通过瞬态闪电测试来完成。

如下图e所示,「天眸芯」能够在 50mV 阈值水平下,以±1bit 的精度,在 10,000fps 下捕捉快速闪电。

值得注意的是,由于高度的稀疏性,AOP 在瞬态现象期间的峰值带宽消耗仅约 50MB/s,相比于具有相同时空分辨率和精度的传统相机(640×320×10,000×2)减少了 90%。

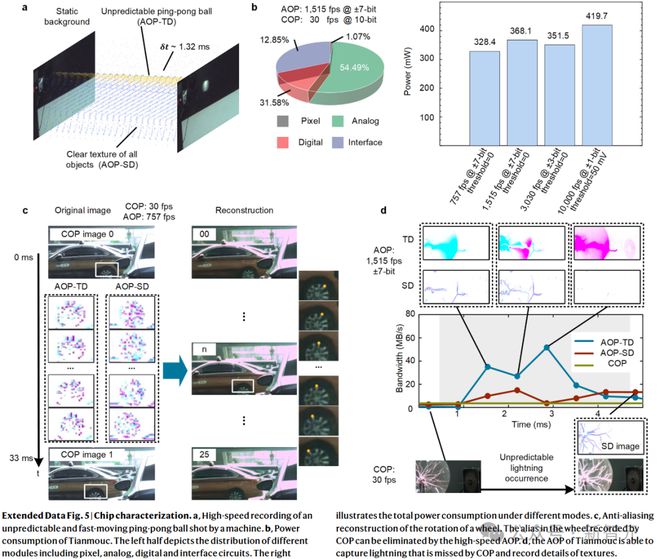

下图中,是更多芯片高速响应和时间抗锯齿的演示。

a.高速记录机器击出的、不可预测、快速移动的乒乓球;b.芯片的功能,左半部分是不同模块的分布,包括像素、模拟、数字和接口电路,展示了不同模式下的总功耗;c.车轮旋转的坑锯齿重建;d.芯片的 AOP 能够捕获 COP 错过的闪电,并记录纹理细节

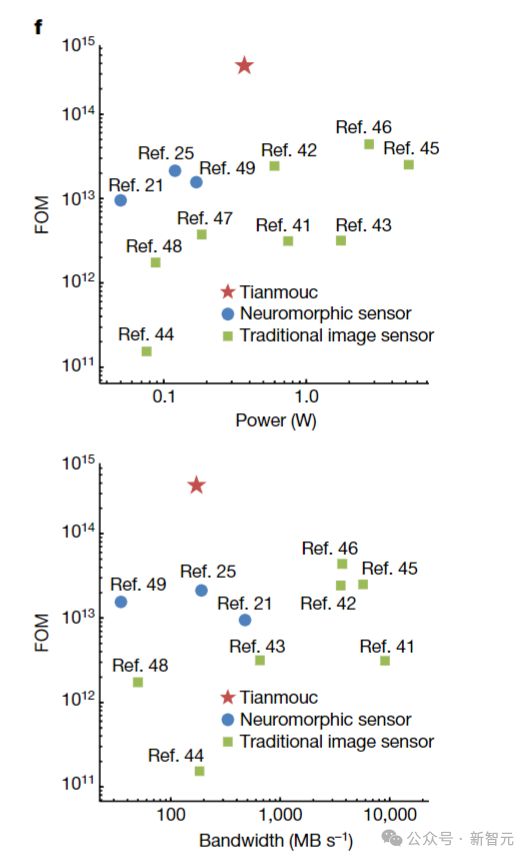

为了评估「天眸芯」的整体性能,研究者使用了一个综合的优值(FOM)。

这个 FOM 包含了用于开放世界传感的关键性能指标,将最大采样率(Rmax)和动态范围整合到一个统一的指标中(Rmax × 动态范围)。

在下图f中,FOM 分别对比了各种传感器的功耗和带宽。

「天眸芯」的功耗根据操作模式变化,在典型模式下(±7 位,1,515fps 无阈值)平均为 368mW。

可以看到,「天眸芯」达到了先进的 FOM,超越了现有的神经形态传感器和传统图像传感器,同时仍能保持低功耗和低带宽消耗。

在开放世界中的性能

所以,「天眸芯」在开放世界中的性能是怎样的?

它的互补传感范式,提供了广泛的设计可能性,并为感知算法提供了卓越的数据源。

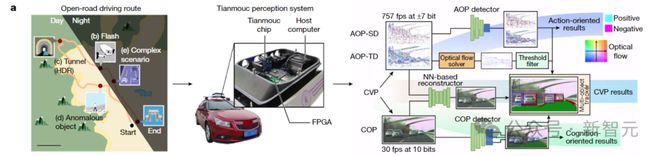

为了评估它在开放世界场景中的表现,研究者开发了一种集成了「天眸芯」的汽车驾驶感知系统。

对于「天眸芯」的评估,是在开放道路上进行的。

因此,测试中会涉及各种边缘情况,包括闪光干扰、高动态范围场景、领域转移问题(异常物体)和包含多个边缘情况的复杂场景。

并且,为了充分利用「天眸芯」架构的优势,研究者特意设计了一种多路径算法,专门用于利用 AOP 和 COP 的互补特性。

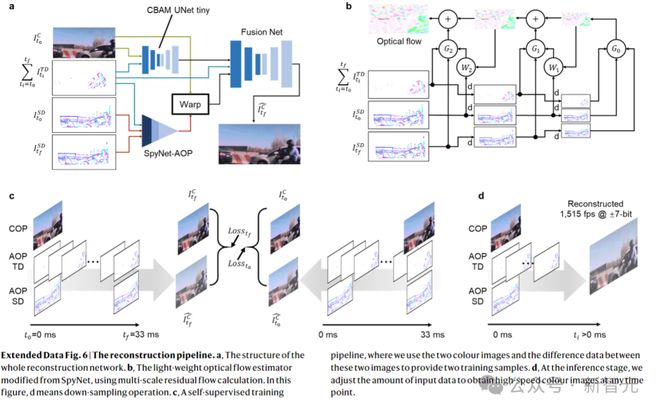

重建管线 a. 整个重建网络的结构 b. 从 SpyNet 修改的轻量级光流估计器,使用多尺度残差流计算 c. 自监督训练管线,使用两个彩色图像和这两个图像之间的差异数据来提供两个训练样本 d. 在推理阶段,调整输入数据量以获得任意时间点的高速彩色图像

在传感层面,原始信息的完整性让它能够重建原始场景,并适应极端光照条件。

同时在感知层面,AOP 提供了对变化、纹理和运动的即时感知,而 COP 提供了精细的语义细节。通过同步这些结果,就实现了对场景的全面理解。

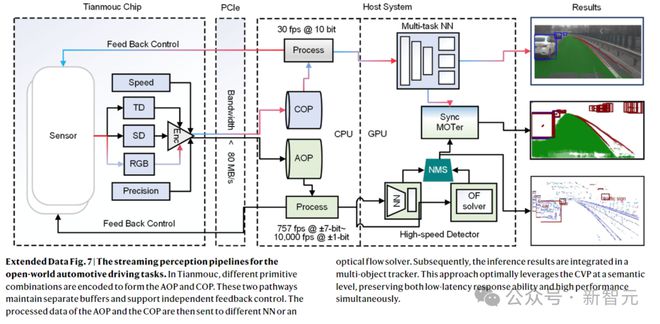

用于开放世界汽车驾驶任务的流感知管线

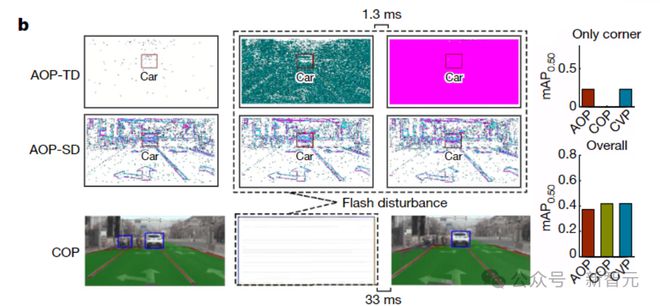

下图b显示了第一个场景。在这个场景中,涉及了突然闪光的传感能力,这种闪光会导致照明快速变化,从而可能影响传感器的鲁棒性。

而「天眸芯」,对此类闪光表现出了非凡的适应能力,而且在正常情况下,它也能保持高感知性能。

对于实时的高动态范围感知,两条路径的互补灵敏度,能使「天眸芯」在不牺牲速度的情况下,感知高亮度对比。

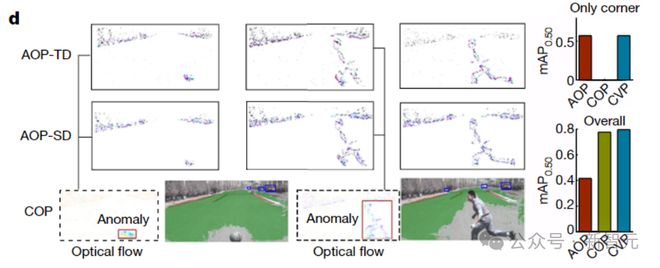

在感知层面,异常检测能力可以通过 AOP 上的异常光流检测器得到补充。

其中,AOP-TD 和 AOP-SD 的协作,能够精确计算出运动方向和速度,从而识别出异常。

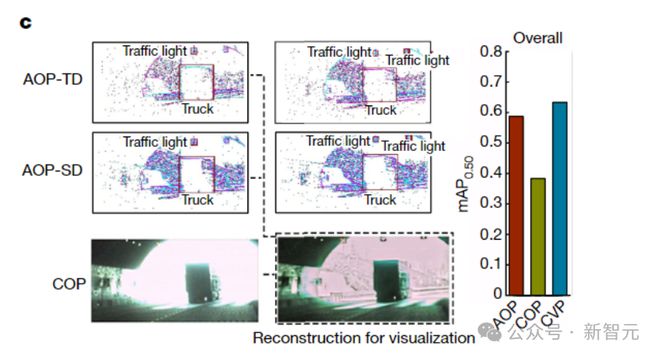

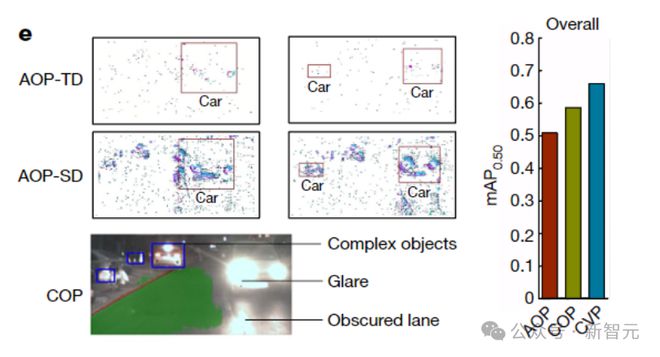

而在下图e中,展示了一个相当复杂的场景。

这个场景中有昏暗的自然光照、混乱的交通环境,甚至是来自人造光的突然干扰。

这就需要在采样速度、分辨率和动态范围方面,具备多样的传感能力。

好在,CVP 上的算法提供了互补和多样的结果,为这些场景中的进一步决策,提供了充足的空间。

下面的柱状图显示,相比仅使用单一路径,CVP 在测试的所有案例中,都表现出了更优越的性能。

尤其值得注意的是,它是在不到 80MB/s和平均功耗为 328mW 的情况下,达到这种性能的!

实验表明,「天眸芯」能够高效适应极端光照环境,并提供领域不变的多层次感知能力。

总之,「天眸芯」与传统的传感范式不同,清华施教授团队的新方法,克服了同质表征造成的低效率,可以适应开放世界中的各种极端情况。

在极端环境中,比如经过隧道,闪光灯干扰,以及汽车前方有人走过,依然能保持快速和鲁棒的响应。

这种视觉感知的突破,将为自动驾驶、具身智能等重要应用,翻开全新的篇章。

参考资料: