文脑极体

最近 AI 领域备受瞩目的新闻中,OpenAI 和谷歌的新品发布会,无疑占据了最多的头条。

我们团队当然也不例外,不仅第一时间观看了两家公司的发布会,还亲身上手体验了号称“颠覆世界”“世界又科幻了”的 GPT-4o。

一句话总结:OpenAI 发布会,失望;谷歌发布会,无聊。

并不是我们要故作惊人之语。实际上,AI 业内专业人士普遍都有类似的看法。

一些国内从事 AI 工程化项目的人表示,“不关心,因为又用不到”。而 AI 科学家和专家也有不少人直言,“看着看着睡着了,谷歌几乎所有的东西都是对标和追赶,没有太多的新鲜感”。

又又又一次在与 OpenAI 的较量中处于下风,一个只有谷歌受伤的世界达成了。

尽管两大 AI 巨头的新技术方向,仍然值得关注,但可以明确的是,随着大型 AI 模型的产业化进程不断深入,国内外参与者也越来越冷静,更加专注于自身的 AI 策略与节奏。

有人将这两场发布会比作是一场斗地主游戏,OpenAI 打出一对二,谷歌就跟四个王。那么,这一次较量的核心——多模态大模型,国内 AI 行业是否要跟进呢?如果要跟进,又该提前考量到哪些问题呢?

每一次新产品问世,如果只跟着新闻“震惊”是很难进步的。不妨和我们一起,认真给 GPT-4o 算笔账。

全能模型究竟“惊艳”在哪里?

谷歌反击 OpenAI 的发布会,被称为“腹泻式更新”,一口气推出了十来款新品及升级。之所以让人看到睡着,是因为大家已经在前一天被 GPT-4o“惊艳”过了。

而这次谷歌开发者大会上所演示的其他产品,OpenAI 早都发布过。对标 GPT-4o 的 Gemini Astra,表现又略逊一筹,也难怪大家兴趣缺缺。显然,这是一次针对谷歌的精准狙击。此前,谷歌已经对外放出了语音助手 demo 演示的预热视频,而 GPT-4o 最让人惊艳的地方就是“天花板级别”的人机自然语音交互。

那么,OpenAI 机关算尽、谷歌有备而来的多模态大模型,究竟有什么神奇之处?

GPT-4o 中的“o”代表“omni”,意为“全能”,以此为版本号,凸显了 GPT-4o 的多功能特性,可以从三个方面理解:

1. 多模态。

GPT-4o 接受文本、音频和图像的任意组合作为输入,实时对音频、视觉和文本进行推理,生成相应的输出。相比 ChatGPT 的文生文、文生图,Sora 的文生视频等,GPT-4o 是一个原生多模态的融合体。这一点,谷歌的 Gemini Astra 也能实现,支持多模态的推理。在演示视频中,谷歌的智能助手可以理解手机摄像头拍摄的世界(视频、图像),并用文字详细地讲述出来。

当然,多模态大模型并不是什么新鲜事物。不只这俩 AI 巨头,国内在多模态大模型领域也有一些研究和开发。此前就有浙大校友开源了多模态大模型 LLaVA,对标 OpenAI 的 GPT-4V。既然多模态大模型并不稀奇,那 GPT-4o 凭啥“惊艳”?答案就在第二点。

2. 低时延。

GPT-4o 是一个端到端、全链路贯穿的多模态大模型。

此前,语音产品一般由三个独立模型组成:SLM1 将音频转录为文本——LLM 将文本输出为文本——SLM2 将生成文本转换为音频。每一步的网络延迟叠加起来,结果就是 AI 推理速度跟不上人嘴巴说话的速度。大家可能都有过类似的经历,自己都说完了,AI 大模型还没识别完全,互动总被打断,有时还会丢失很多信息,连基本的文字都听不清,更别说从笑声、停顿、叹气等因素中分析出人的情绪了,人当然也就没有了说下去的兴致。

而 GPT-4o 的端到端,就是省去了中间的处理步骤,由同一个神经网络来接受并处理来自不同模态(如文本、视觉和音频)的输入数据,并直接输出结果。这样就可以将语音交互的响应时延,控制在 232 毫秒以内,体感上比人类回应还要迅速。

OpenAI 演示完 GPT-4o,大家纷纷表示,科幻电影中《Her》跟机器谈情说爱的未来就要实现了。不过,谷歌并不这样想。

(截图自奥特曼的社交媒体)

在晚一天的谷歌发布会上,谷歌 Gemini 1.5 Flash 的响应其实也很快速,同样能几乎没有延迟地跟人类流畅互动,但还是比 GPT-4o 要长一些。不过谷歌声称,自己的两段演示视频均为“单次拍摄、实时录制完成”。

我们猜测,这是在暗示OpenAI 又在“贷款领先”了,GPT-4o 实际可能无法很快真的落地,毕竟 OpenAI 搞误导性营销是有前科的,Sora 就曾爆出,拿艺术家编辑过的视频当原视频宣传,演示效果并非完全由 AI 生成。

展示效果是真是假,有待时间验证,不过 OpenAI 和谷歌在端到端方面的工作,证明了人机语音交互的超低时延是可以实现的,达到媲美人类交流的水平。而这,就为语音交互的多场景应用,打下了新的技术根基。

3. 多场景。

大家应该都还记得,ChatGPT 问世时举世震惊的效果。大语言模型的强大理解能力和泛化性,可以促成 NLP 在多种文本任务上带来颠覆式的影响,而这类任务几乎遍布在各行各业。

再看 GPT-4o,多模态大模型在音视频理解方面尤其出色,也是一个非常泛在的通用型技术。而毫不夸张地说,GPT-4o 将语音交互体验做到了“天花板级别”,这几乎可以给语音场景都带来改变。

比如 OpenAI 所展示的辅导孩子数学题,可以替代家长辅导作业,让家家都过上和谐的日子;《Her》电影中跟智能语音机器人谈恋爱的场景,可以让人人都拥有自己的网络恋爱/在线情感抚慰师。延展开来,此前曾被嘲笑“人工智障”的手机语音助手,银行、电信等行业的客服机器人,缺乏充足师资力量的偏远学校,游戏里跟玩家互动的 NPC 纸片人,以及能识别用户情绪的精准营销……

凡有人声处,皆可咏 AI,正随着端到端多模态大模型的进化与落地,让更自然、更逼真、富有感情的人机交互成为可能。

从这个角度说,GPT-4o 所代表的技术前瞻性,确实配得上“全能o”这个词。既然如此,为什么说只有谷歌一家受伤了呢?

不慌不忙,只有谷歌受伤的世界达成了

OpenAI 一有新品发布,国内大众的期待与紧张情绪便如同谷歌的皮猜(Sundar Pichai)一样高涨,这几乎已经是惯例了。

预判国内观众的预判,很多中文媒体也在 OpenAI 春季新品发布会刚发完的早晨,就炮制了一系列“颠覆世界”“炸裂登场”的新闻。有人说它要革谷歌的命,革 Siri 的命,革同传的命,革心理咨询师、情感辅导、私人教练等 1V1 咨询的命……

或许还有不明真相的群众信以为真,而谷歌也确实进行了反击,但国内 AI 业内人士大多呵呵一笑。这可能是第一次,面对 OpenAI 的进攻,只有谷歌受伤的世界达成了。

为什么国内 AI 从业者普遍对 GPT-4o 及对标 GPT-4o 的 Gemini Astra,反应平平,甚至看发布会都能睡着?

首要原因,当然是新产品不达预期。

许多人原本满怀期待地等 OpenAI 放出 GPT-5,就算没有,也得是跟 Sora 一样惊艳的东西,但 GPT-4o 更多的是在现有技术框架内的一次迭代升级。而谷歌此前发布的 Gemini 也有多模态能力。可以说,双方虽然都在多模态处理方面,做出了改进和增强,但并没有实现根本性的技术飞跃。所以有人说,大家期待的是一个“核弹”,而 OpenAI 这次拿出的是一个“摔炮”。

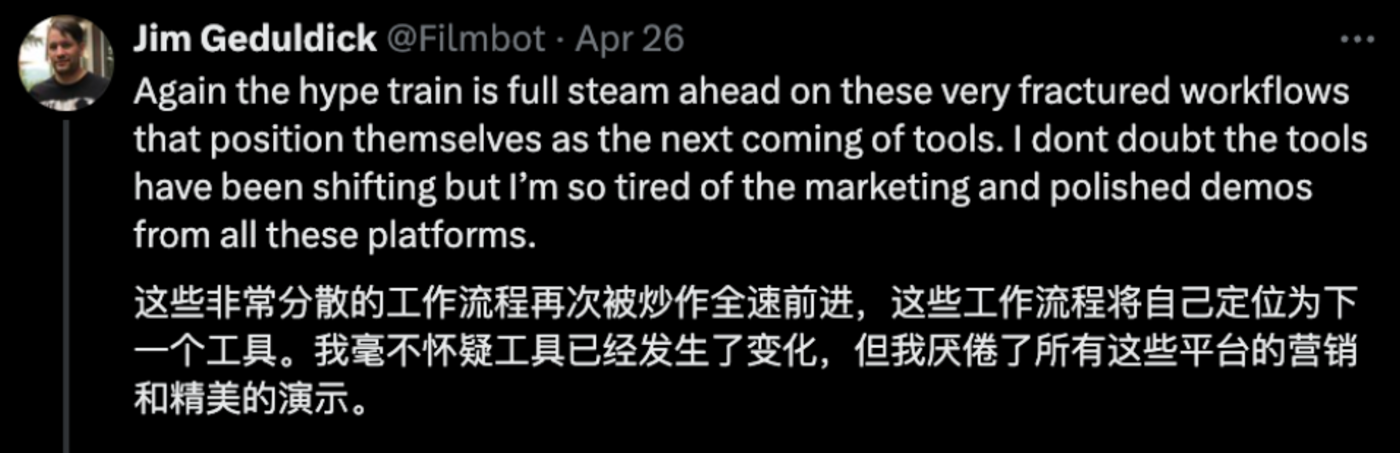

另一个原因,是 OpenAI“狼来了”玩太多次了。

OpenAI 会营销是共识,有不少人都在 Sora 翻车之后表示,“厌倦了 OpenAI 的精美 Demo 营销”。投资人朱啸虎 OpenAI CEO Sam Altman 奥特曼每次都把 PR 宣传时间点拿捏得很准,显示自己这波在“大气层”,但几个月之后都没有开放给公众使用。

越来越多人认识到这一点,也对 OpenAI 的“demo 发布会”变得不信任、不耐烦了。

(截图自社交媒体,网友对 OpenAI 的评论)

当然,最关键的还是,经过一年多的大模型落地实践,国內 AI 产业链上下游可能都对 OpenAI 和大模型“祛魅”了。

这就像打牌,面对别人摆下的龙门阵,刚刚坐上牌桌,对游戏规则和策略不够熟悉,自然要先观察和模仿对方的策略,赶紧先把大语言模型搞出来,也会下意识地听取围观群众的建议。明明自己才是干 AI 的,但一听媒体分析师或网友说“落后了”,立马焦虑,忙着对标 ChatGPT、对标 GPT-4,又容易“翻车”引发舆论危机。刚上牌桌,进退失据,亦步亦趋跟进 OpenAI 是难免的。

但一年多时间过去,很多真正做大模型和产业落地的人与企业,或许还没彻底弄清楚中国大模型产业化、商业化应该怎么做,但一个共识很清楚——像 OpenAI、谷歌那样做不行。最简单的,GPT-4o 能第一时间拿到英伟达最先进的显卡,这就是国内厂商很难拥有的资源。

此外,ToB 领域对模型可控性的要求、私有化部署的需求等,国内企业的智能化要从数据清洗、知识库等基础工作开始,而不是直接调用最先进模型的 API……

这些问题,导致国內 AI 产业界对追赶 OpenAI“炸裂新品”的兴趣,越来越小,找到了自己做大模型的节奏和策略。

这些背景综合起来,导致只有紧跟在 OpenAI 身后苦苦追赶的谷歌,被 GPT-4o 伤得最深。

多模态大模型的收益比到底怎么样?

当然,不再一味追着 OpenAI 的节奏疲于奔命,并不意味着 OpenAI 和谷歌都在发力的技术方向,就不重要了,就可以不关心了。

只不过,在盯紧趋势的基础上,还得统筹牌局,算好收益比,究竟何时出牌、什么出牌顺序,对大模型商业化的潜在收益风险比是最高的。

那么,GPT-4o 及 Gemini Astra 这类端到端多模态大模型,对企业的潜在收益与风险,究竟如何呢?

先说收益。

目前来看,与丰富的软硬件生态相结合,能够更快落地、价值最大化。

比如谷歌 Gemini Astra 尽管在理解能力、时延上不及 GPT-4o,但谷歌凭借强大应用生态的支持,让跨模态理解生成,有了用武之地,股价也有所上涨。

硬件方面,谷歌 Gemini 的多模态能力与 XR 眼镜整合,让商业化遇阻的“谷歌眼镜”再次回魂重塑;

软件方面,GPT-4o 被传将与苹果绑定,加速 IOS 的 AI 化进程。而谷歌则将多模态能力融入搜索,用户可以通过语音、图片等与搜索引擎交互,支持搜索视频内容。

(截图自社交媒体,网友对 GPT-4o 的评论)

不过,这些都是展望。在实际落地、与软硬件结合的过程中,AI 公司可能会输掉一些筹码,潜在风险包括:

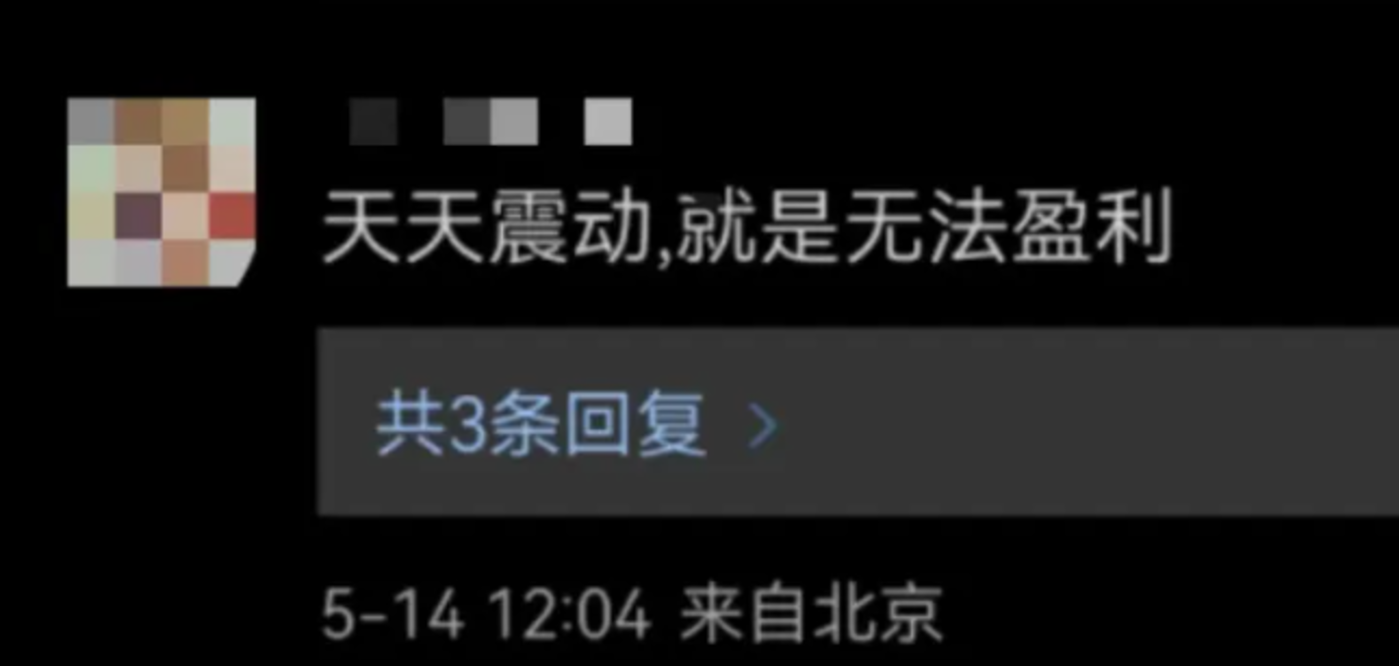

长期亏损。就连 OpenAI 都遭遇了流量危机,开始通过免费换用户规模,这意味着在算力、人员等方面的长期投入。AGI 是一个长期任务,可能需要十年、二十年的时间,如果在每一个阶段,不能成功实现规模商业化,想一把赌个大的,靠后期非线性增长来扭亏为盈,很有可能“大业未成而中道崩阻”。

同质化竞争。OpenAI 与谷歌的大模型竞争,撕咬得很紧,而技术领域想要彻底封闭是不可能的,这意味着底层模型能力很快会趋同,这时候用户会转变为价格敏感型,进入残酷的价格战。如果没有差异化的营收模式,一味跟进底层模型的绝对领先,利润会越来越微薄。

可能有人会说,还没做出国产版 GPT-4o 就惦记着商业化、赚钱,真的很庸俗。

必须得说明一下,从收益比最优的角度,决定怎么出牌,OpenAI 可算是熟手了。事实上,ChatGPT 的推出是为了用聊天机器人来抢到关注度,而 GPT-5 迟迟不推出,除了坊间猜测的能力不达预期之外,也有对发布时机的考量。奥特曼已经表达过多次,“GPT-5 很厉害,但我们还没有确定如何将这些产品推向市场”。

师夷“算账”以制夷,国內 AI 公司也得学会踩点市场节奏,做出更明智、收益比更高的商业策略,才能长期良性发展。网友大型“双标”要不得。

从国内 LLMtoB(面向B端市场的大模型)的一些实践经验来看,GPT-4o 在当下确实还存在一些阻碍落地的实际问题。

比如可控性,AIGC 生成的文本、图片,都比较容易进行内容控制,由其他模型或人类专家来把控内容质量与合规风险,超低时延的实时语音交互如何保障内容质量?如果在辅导作业、医生问诊、心理咨询等严肃场景中出现幻觉和胡说八道,甚至违法违规的内容,该怎么及时防范?

奥特曼在 GPT-4o 的技术博客中提到,该模型在网络安全等风险维度上都“不超过中等水平”,也就是说,目前只能实现中等及以下的安全能力。无论是C端用户,还是B端政企客户,谁放心将喜怒哀乐、私密信息都告诉多模态大模型?怎么打消用户的安全顾虑,还需要在数据源头、模型训练、规则机制设计、产品功能上都有充分细致地打磨。

更要问一句,创业公司和开发者的努力总是被新的模型能力覆盖掉,是不是来自 AI 大模型厂商的一种“背刺”?什么样的智能语音产业生态,才能吸引他们来用?

这些落地问题不解决,所谓的《Her》一般的科幻未来,就只能一直存在于 OpenAI 的 demo 中了。

从实际情况来说,跟上技术路线并不算真难题。算好收益比,搞清楚自己和对手手里的牌面,以及多模态大模型的商业牌局,才是更难也更紧迫的问题。

GPT-4o 这一波,国内 AI 企业不用急着再上牌桌。