明敏发自凹非寺

量子位公众号 QbitAI

现在 AI 圈确实到了拼手速的时候啊。

这不,Meta 的 SAM 刚刚推出几天,就有国内程序猿来了波 buff 叠加,把目标检测、分割、生成几大视觉 AI 功能 all in one!

比如基于 Stable Diffusion 和 SAM,就能让照片中的椅子无缝换成沙发:

换装、换发色也是 so easy:

项目一经发布就让不少人惊呼:手速也太快了吧!

还有人表示:我和新垣结衣的新结婚照有了。

如上就是 Gounded-SAM 带来的效果,项目在 GitHub 上已揽星 1.8k。

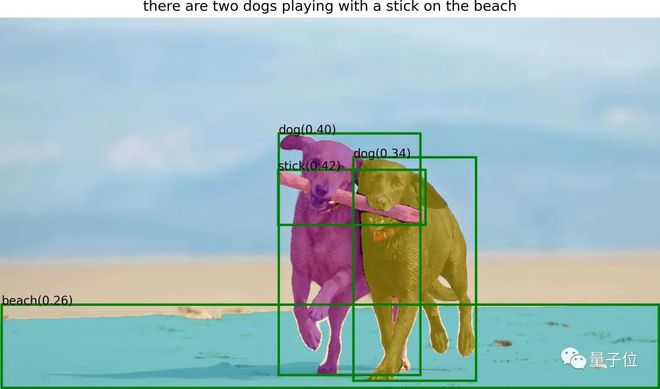

简单来说,这就是一个 zero-shot 视觉应用,只需要输入图片,就能自动化检测和分割图像。

该研究来自 IDEA 研究院(粤港澳大湾区数字经济研究院),创始人兼理事长为沈向洋。

无需额外训练

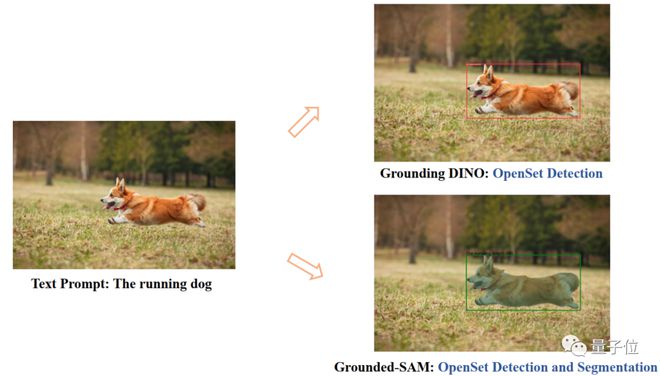

Grounded SAM 主要由 Grounding DINO 和 SAM 两个模型组成。

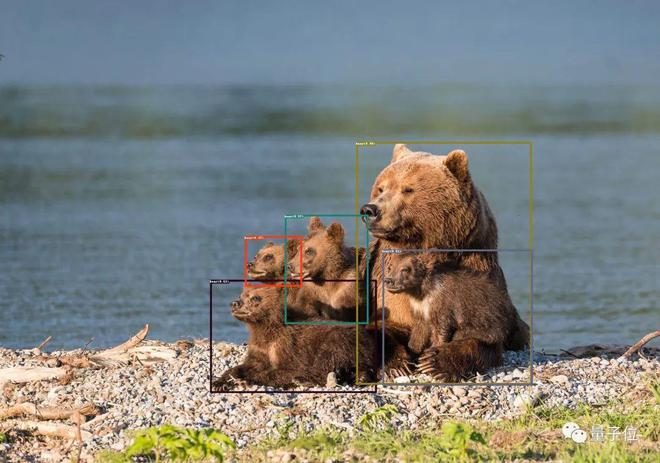

其中 SAM(Segment Anything)是 4 天前 Meta 刚刚推出的零样本分割模型。

它可以为图像/视频中的任何物体生成 mask,包括训练过程中没出现过的物体和图像。

通过让 SAM 对于任何提示都返回有效的 mask, 能够让模型在即使提示是模糊的或者指向多个对象的情况下,输出也应该是所有可能中一个合理的 mask。这一任务用于预训练模型并通过提示解决一般的下游分割任务。

模型框架主要由一个图像编码器、一个提示编码器和一个快速 mask 解码器组成。在计算图像嵌入后,SAM 能够在 50 毫秒内根据 web 中的任何提示生成一个分割。

Grounding DINO 是该研究团队已有的成果。

这是一个零样本检测模型,能够生成带有文字描述的物体 box 和标签。

二者结合后,可以通过文本描述找到图片中的任意物体,然后通过 SAM 强大的分割能力,细粒度地分割出 mask.

在这些能力之上,他们还叠加了 Stable Diffusion 的能力,也就是开头所展示的可控图像生成。

值得一提的是,Stable Diffusion 此前也能够实现类似功能。只要涂抹掉想替换的图像元素,再输入文本提示就可以。

这一回,Grounded SAM 能够省去手动选区这个步骤,直接通过文本描述来控制。

另外结合 BLIP(Bootstrapping Language-Image Pre-training),生成图片标题、提取标签,再生成物体 box 和 mask。

目前,还有更多有趣的功能正在开发中。

比如人物方面的一些拓展:更换衣服、发色、肤色等。

具体食用方法也已在 GitHub 上给出。项目需要 Python 3.8 以上版本,pytorch 1.7 以上版本,torchvision 0.8 以上版本,并要安装相关依赖项。具体内容可看 GitHub 项目页。

该研究团队来自 IDEA 研究院(粤港澳大湾区数字经济研究院)。

公开消息显示,该研究院是一所面向人工智能、数字经济产业及前沿科技的国际化创新型研究机构,前微软亚研院首席科学家、前微软全球智行副总裁沈向洋博士担任创始人及理事长。

One More Thing

对于 Grounded SAM 的未来工作,团队有几点展望:

- 自动生成图像构成新数据集

- 具有分割预训练的强大基础模型

- 和(Chat-)GPT 合作

- 构成一个自动生成图像标签、box 和 mask 的 pipeline,并能生成新的图像。

值得一提的是,该项目的团队成员中,有不少都是知乎 AI 领域活跃的答主,这次也在知乎上自答了关于 Grounded SAM 的内容,感兴趣的童鞋可以去留言请教~

参考链接:

[1]https://zhuanlan.zhihu.com/p/620271321

[2]https://github.com/IDEA-Research/Grounded-Segment-Anything