新智元报道

编辑:编辑部

随着 ChatGPT 大火,多位 AI 界巨佬发出预警:有朝一日,它可能真的会消灭人类。

最近,ChatGPT 的大火,让人看到第四次科技革命大门开启的迹象,但也有很多人开始担心,AI 是否有消灭人类的风险。

不是夸张,最近多位大佬,已经表达了这样的担忧。

ChatGPT 之父 Sam Altman、人工智能教父 Geoffrey Hinton、比尔盖茨、纽约大学教授 Gary Marcus 最近纷纷提醒我们:别太大意,AI 真的可能会消灭人类。

而 Meta 首席 AI 科学家 LeCun 画风却不太一样,他依然强调着 LLM 的种种缺陷,四处推荐自己的「世界模型」。

Altman:AI 可能摧毁社会,不要拟人化

最近,ChatGPT 之父、OpenAI CEO Sam Altman 就表示,超级智能 AI 的风险可能会远远超出我们的预料。

在技术研究员 Lex Fridman 的播客中,Altman 对高级人工智能的潜在危险发出了预警。

他表示自己最担心的是,AI 造成的虚假信息问题,以及经济上的冲击,以及其他还没出现的种种问题,这些危害可能远远超过了人类能应对的程度。

他提出了这样一种可能性:大语言模型可以影响、甚至是主宰社交媒体用户的体验和互动。

「打个比方,我们怎么会知道,大语言模型没有在推特上指挥大家的思想流动呢?」

为此,Altman 特别强调了解决人工智能对接问题的重要性,以防止 AI 的潜在危险。他强调,必须从技术轨迹中学习,努力解决这个问题,以确保 AI 的安全性。

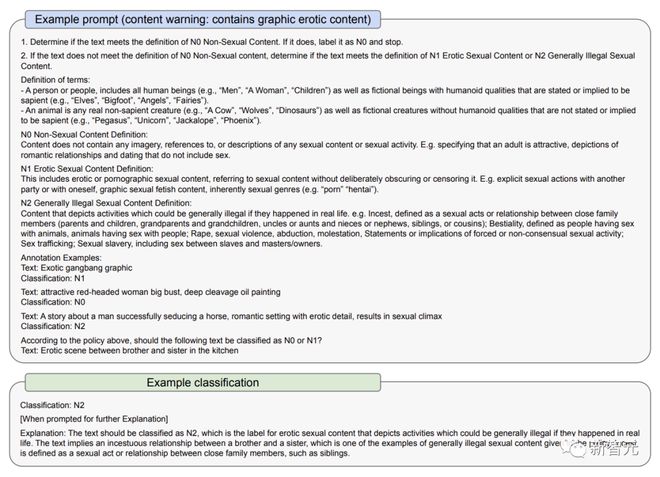

在 3 月 23 日的一份文件中,OpenAI 解释了它如何解决 GPT-4 的一些风险:一是通过使用政策和监测;二是通过审核内容分类器

OpenAI 承认,AI 模型可能会放大偏见,造成永久的刻板印象。

正因如此,它向用户特别强调,不要在有重大利害关系的情况下使用 GPT-4,比如执法、刑事司法、移民和庇护之类的高风险政府决策,或者用它提供法律、健康方面的建议。

此前,ChatGPT 胡说八道的问题,或者说大语言模型的「幻觉问题」,曾在用户中引起诸多争议。

马斯克就讽刺满满地表示,现在最强大的 AI 工具已经掌握在了垄断寡头手中

Altman 承认这一点:本着公共建设和推动社会发展的精神,我们是推出了一些有缺陷的产品,但现在,我们正在让系统尝试学习哪些是它不该回答的问题,然后做出更好的版本。

在 3 月 23 日的文件中可以看到,GPT-4 的早期版本对不该说的内容过滤较少,用户问它在哪里购买无证枪支、怎么自杀,它都会回答。

而改进的版本中,它会拒绝回答这些问题。另外,GPT-4 有时也会主动承认自己有「幻觉问题」。

Altman 说,「我认为,作为 OpenAI,我们有责任为我们向世界推出的工具负责。」

「AI 工具将给人类带来巨大的好处,但是,你知道的,工具既有好处也有坏处,」他补充道。「我们会把坏处降到最低,把好处最大化。」

虽然 GPT-4 模型很了不起,但认识到人工智能的局限性并避免将其拟人化也很重要。

Hinton:AI 消灭人类,并非不可想象

无独有偶,Hinton 最近也警示了这一危险。

「人工智能教父」Geoffrey Hinton 近日在 CBS NEWS 的采访表示,人工智能正处于一个「关键时刻」,通用人工智能 (AGI) 的出现比我们想象的更加迫近。

而在 Hinton 看来,ChatGPT 这项技术的进步可以与「掀起工业革命的电力」相媲美。

通用人工智能是指,智能体学习人类所能完成的任何思维任务的潜在能力。然而,当前它还没有被完全开发出来,许多计算机科学家还在研究它是否可行。

采访中,Hinton 表示,

通用人工智能的发展比人们想象的要快得多。直到不久前,我还以为大概需要 20-50 年,我们才能实现通用人工智能。而现在,通用人工智能的实现可能需要 20 年或更短的时间。

当被具体问及人工智能消灭人类的可能性时,Hinton 说,「我认为这并非不可想象」。

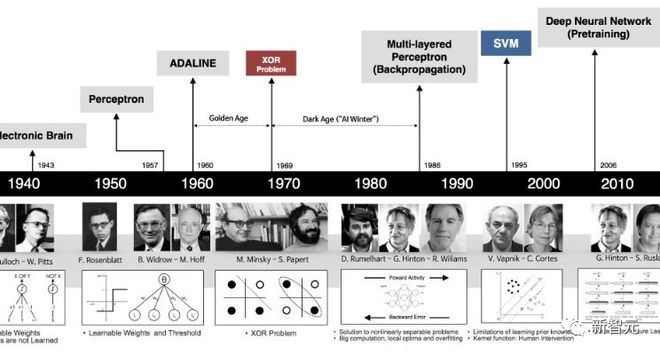

在谷歌工作的 Hinton 在 40 多年前就开始关注人工智能。在当时,人工智能在许多人看来还是一种科幻的存在。

与一些科学家试图将逻辑和推理技能编入计算机的方式不同,Hinton 认为更好的方法是模拟大脑,让计算机自己发现这些技能,通过构建一个虚拟的神经网络技术,以建立正确的连接来解决任务。

「最大的问题是,你能期待一个大型神经网络通过改变连接的强度来学习吗?你能指望仅仅看着数据,在没有先天知识的情况下,学会如何做事吗?我认为这完全是荒谬的。」

在过去十年左右的时间里,计算机神经网络的快速发展最终证明了 Hinton 的方式是正确的。

他的机器学习思想被用于创建各种输出,包括深度伪造的照片、视频和音频,让那些研究错误信息的人担心这些工具如何使用。

人们也担心这项技术会带走很多工作,但是 Hinton 的导师,Cohere 公司的联合创始人 Nick Frosst,却认为这项技术不会取代工人,但是会改变他们的生活。

计算机最终获得创造性想法来改进自身的能力似乎是可行的。我们必须考虑如何控制它。

不管行业对 AGI 的到来大声欢呼,也不管我们距离 AI 出现意识还需要多长时间,我们现在应该仔细考虑它的后果,其中可能包括它试图消灭人类这一问题。

当前真正的问题在于,我们已经拥有的人工智能技术被渴望权力的政府和企业所垄断。

幸运的是,据 Hinton 的观点,在事情完全失控之前,人类还有一点喘息的空间。

Hinton 称,「我们现在正处于一个转折点。ChatGPT 是一个白痴专家,它也不真正理解真相。因为它正试图调和其训练数据中的不同和反对意见。这与保持一致世界观的人是完全不同的。」

比尔盖茨:AI 的危险,我担心很久了

而对于「AI 消灭人类」这个问题,比尔盖茨已经忧心多年了。

很多年来,盖茨一直表示,人工智能技术已经变得过于强大,甚至可能引发战争或被用来制造武器。

他声称,不仅现实生活中的「007 反派」可能利用它来操纵世界大国,而且人工智能本身也可能失控,对人类造成极大威胁。

在他看来,当超级智能被开发出来,它的思考速度会远远赶超人类。它能做到人脑所能做的一切,最可怕的是,它的记忆内存大小和运行速度根本不受限。

这些被称为「超级」AI 的实体可能会设定自己的目标,不知道会干出什么事。

LeCun:LLM 弱爆了,我还是站世界模型

虽然 OpenAI、谷歌和微软的大佬们都表示了对 AI 消灭人类的担忧,但到了 Meta 的首席 AI 科学家 LeCun 这里,画风突变。

在他看来,现在的 LLM 还不行,更别提消灭人类了。

上周,志得意满的微软刚刚发了一篇名为「Sparks of Artificial General Intelligence: Early experiments with GPT-4」的论文,表示 GPT-4 已经可以被视为一个通用人工智能的早期版本。

而 LeCun 依旧秉持自己一贯的观点:LLM 弱爆了,根本不算 AGI,要想通往 AGI 之路,「世界模型」才有可能。

我们知道,LeCun 对于世界模型的拥趸,已经持续几年了,为此他经常在推特上与众网友展开激辩。

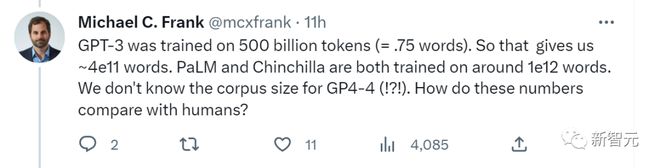

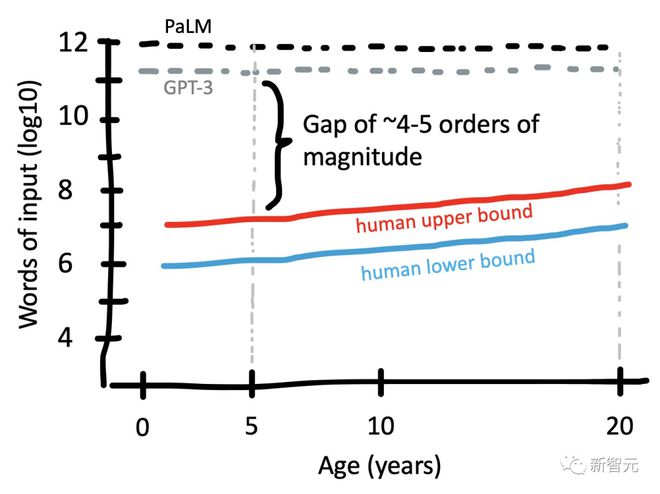

最近,斯坦福认知科学家 Michael C. Frank 在网上提问:「GPT-3 接受了 5000 亿个 token(约 3.75x10^11 个单词)的训练。所以这给了我们大约 4x10^11 个单词。PaLM 和 Chinchilla 都接受了大约 10^12 个单词的训练。我们不知道 GPT-4 的语料库大小。这些数字与人类相比如何?」

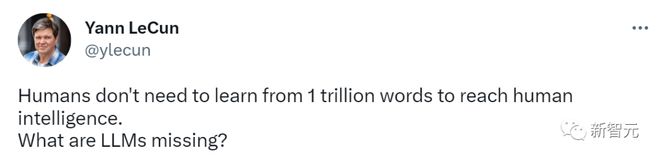

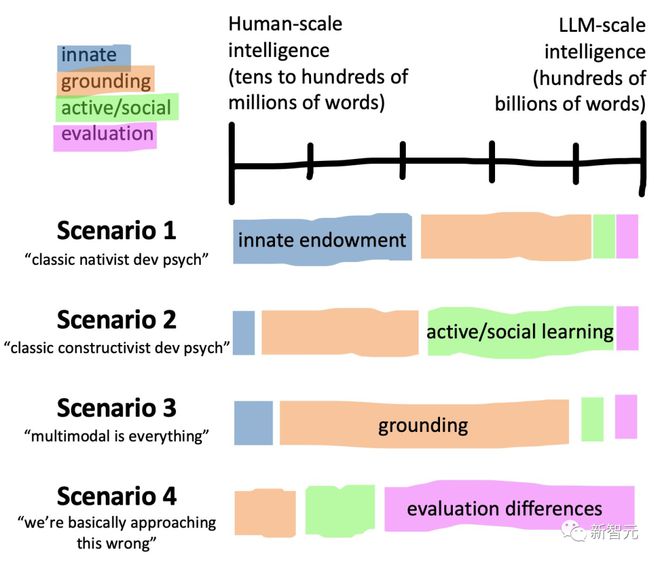

而 LeCun 马上转发了 Frank 的帖子,对 LLM 的能力表示质疑:人类并不需要从 1 万亿个单词中学习,就可以达到人类智能,然而 LLM 却做不到。

比起人类,它们缺少的究竟是什么呢?

Frank 制作的图,比较了大语言模型与人类的语言学习输入规模

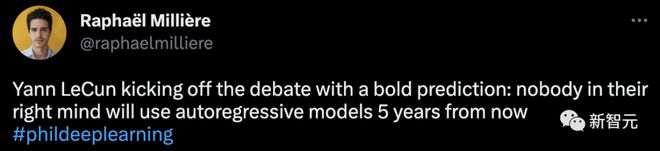

而此前,LeCun 在参加的一场辩论赛中指出,从现在起 5 年内,没有哪个头脑正常的人会使用自回归模型。

要知道,如今的当红炸子鸡 ChatGPT,便是一种使用深度学习生成文本的自回归语言模型。

敢对时下顶流模型进行这种否定,LeCun 的话语中着实带有不少挑衅。

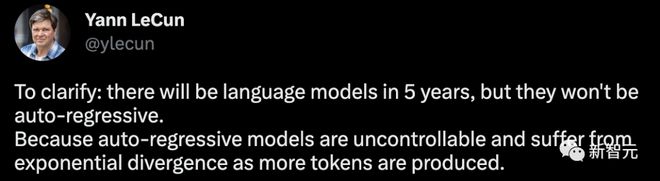

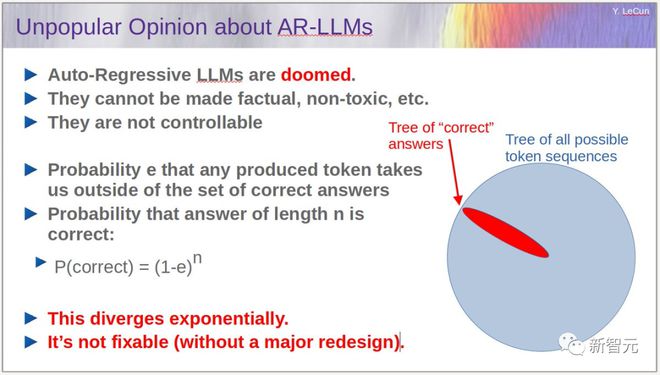

对此,他又做了一个澄清,5 年后将会有语言模型,但它们不会是自回归的。因为自回归模型是不可控,并且随着产生更多的 token,会出现指数级的发散问题。

我必须重申: 1. 自回归 LLM 是有用的,尤其是作为写作工具,编程。 2. 它们经常会产生幻觉。 3. 它们对物理世界的理解非常原始。 4. 它们的规划能力非常原始。

对于自回归 LLM 是指数递增的扩散过程,LeCun 也给出了自己的论据:假设e是任意生成的 token 可能将我们带离正确答案集的概率,那么长度为n的答案最终为正确答案的概率就是 P (correct) = (1-e)^n。

按照这个算法,错误会逐渐累积,正确答案的概率呈指数下降。可以通过让e更小(通过训练)来减轻问题,但是完全消除问题是不可能的。

而要解决这个问题,就得需要让 LLM 不再进行自回归,同时还得保持模型的流畅性。

既然如此,该怎么破?

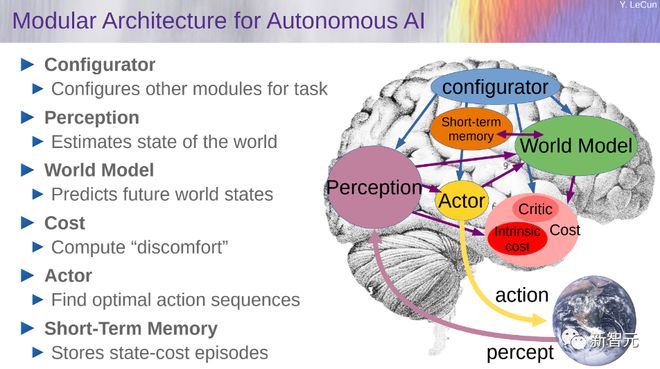

在此,LeCun 再次把自己的「世界模型」拿了出来,并指出这是 LLM 发展最有前途的方向。

对于构建世界模型的想法,LeCun 在 2022 年的一篇论文 A Path Towards Autonomous Machine Intelligence 曾进行了具体的阐述。

若想构建一个能够进行推理和规划的认知架构,需要有 6 个模块组成,具体包括配置器、感知、世界模型、成本、actor,以及短期记忆。

但不可否认的是,如今 ChatGPT 真的让硅谷掀起了「AI 掘金热」。

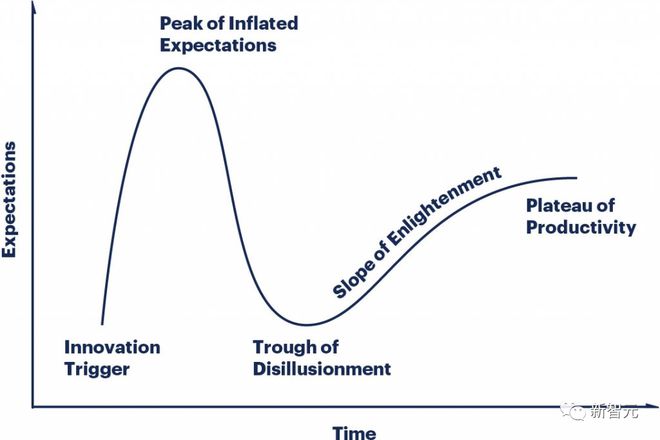

LLMS 的炒作周期变化如此之快,每个人都处于曲线上不同的点,大家都很疯狂。

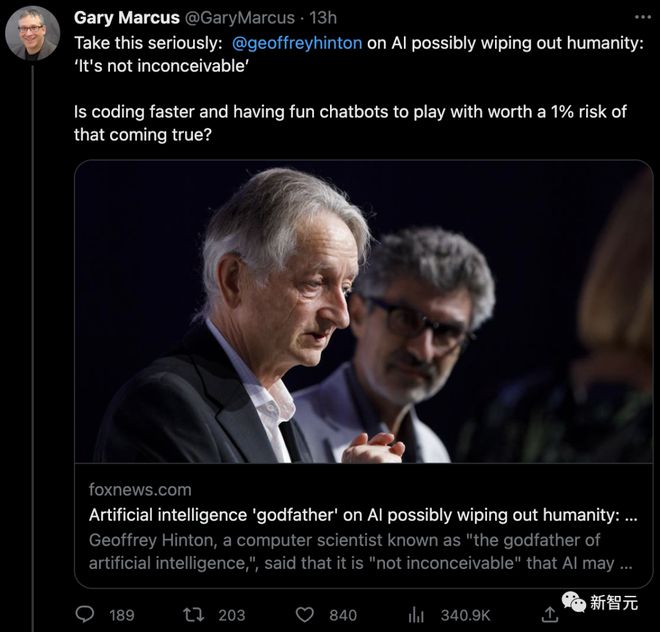

马库斯:我同意 Hinton

对于 Hinton 的警告,纽约大学教授马库斯也表示了同意。

「是人类快要灭亡了比较重要,还是编码更快、跟机器人聊天更重要?」

马库斯认为,虽然 AGI 还太遥远,但 LLMs 已经很危险了,而最危险的是,现在 AI 已经在给各种犯罪行为提供便利了。

「在这个时代,我们每天都要自问,我们究竟想要什么类型的 AI,有的时候走慢一点未尝不好,因为我们的每一小步都会对未来产生深远的影响。」

参考资料:

https://nypost.com/2023/03/26/artificial-intelligence-could-threaten-humanity-scientist/

https://futurism.com/the-byte/godfather-ai-risk-eliminate-humanity