新智元报道

编辑:Ellie 桃子

近期生成式 AI 大热,这为人类社会带来可观的机遇,但也伴随着巨大的风险。斯坦福 HAI 研究院发布对观点报告,带来对生成式 AI 的见解。

近日,李飞飞领导的斯坦福 HAI 研究院发布了关于「生成式 AI」的观点报告。

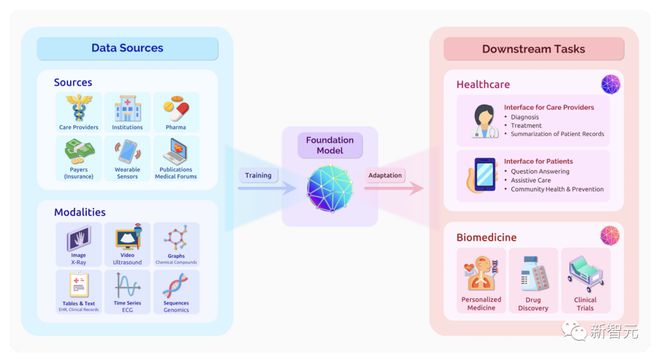

报告指出,当前大多数生成式人工智能都是由基础模型驱动的。

这些模型为我们的生活、社区以及社会带来的机会是巨大的,与此同时带来的风险也一样。

一方面,生成式 AI 可以让人类更有生产力和创造力。另一方面,它们可能会放大社会偏见,甚至破坏我们对信息的信任。

我们相信,跨学科的合作对于确保这些技术惠及我们所有人。以下是斯坦福大学的观点医学、科学、工程、人文学科和社会科学领域的领导人关于「生成式人工智能」如何影响其领域和我们世界的观点。

本文,我们选取了李飞飞和 Percy Liang 对当前生成式 AI 的见解。

完整观点报告请参见:

https://hai.stanford.edu/generative-ai-perspectives-stanford-hai

李飞飞:人工智能的伟大拐点

斯坦福 HAI 联合主任李飞飞发文:「人工智能的伟大拐点」。

人类大脑可以识别世界上的所有模式,并且据此构建模型或生成概念。几代人工智能科学家的梦想,就是将这种生成能力赋予机器,他们在生成模型算法开发这一领域做过很长时间的努力。

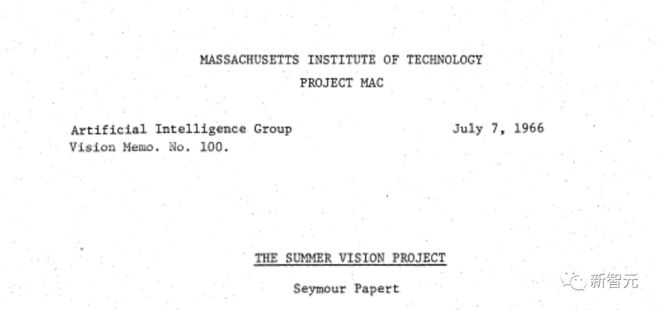

1966 年,麻省理工学院的研究人员发起了 「夏季视觉项目」(Summer Vision Project),旨在用技术有效搭建视觉系统的一个重要部分。这就是计算机视觉和图像生成领域研究的开端。

近期,得益于深度学习和大数据的密切关联,人们似乎已经到达了一个重要拐点,即将让机器具备生成语言、图像、音频等的能力。

尽管计算机视觉的灵感来源是打造能看到人类所能看到东西的 AI,但现在这一学科的目标远不限于此,未来要打造的 AI 应当看到人类所不能看到的东西。

如何使用生成式人工智能来增强人类的视觉呢?

比如,在美国医疗错误造成的死亡是一个令人担忧的问题。生成式 AI 可以协助医疗保健提供者看到潜在的问题。

如果错误产生于罕见情况,生成式 AI 可以创建模拟版本的类似数据,来进一步训练 AI 模型,或者是为医疗人员提供训。

在开始开发新的生成式工具之前,应当关注人们希望通过工具获得什么。

在近期的一个为机器人任务制定基准的项目中,研究团队在开始工作前进行了一次大规模的用户研究,询问人们如果由机器人来完成某些任务,他们会受益多少,使人受益最多的任务成为项目研究的重点。

为了抓住生成式人工智能创造的重大机遇,相关风险也需要合理评估。

Joy Buolamwini 领导了一项名为「性别阴影」的研究,发现 AI 经常在识别女性和有色人种时出现问题。类似这样对缺乏代表性群体的偏见,在生成式 AI 中还会继续出现。

判断一张图片是否是使用 AI 生成的,也是十分重要的能力。人类社会是建立在在对公民身份的信任之上,如果缺乏这种能力,我们的信任感就会降低。

机器生成能力方面的进展是非常令人振奋的,发掘人工智能看到人类无法看到的东西的潜力也是如此。

然而,我们需要警惕,这些能力可能扰乱我们的日常生活、我们所处的环境,破坏我们作为世界公民的角色。

Percy Liang:「新寒武纪时代:科学的兴奋、焦虑」

斯坦福大学人类中心人工智能研究所主任,计算机副教授 Percy Liang 发文「新寒武纪时代:科学的兴奋、焦虑」

在人类史上,创造新鲜事物总是很困难的,而且这种能力几乎只有专家才具备。

但随着近期基础模型的进步,人工智能的「寒武纪爆炸」正在发生,人工智能将可以创造任何东西,从视频到蛋白质再到代码。

这种能力降低了创造的门槛,但它也剥夺了我们辨认真实的能力。

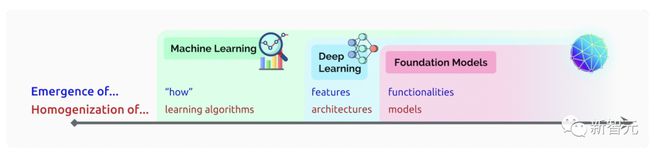

基于深度神经网络和自我监督学习而建立的基础模型已经存在有几十年了。然而,最近这些模型所能训练的庞大数据量使模型的能力突飞猛进。

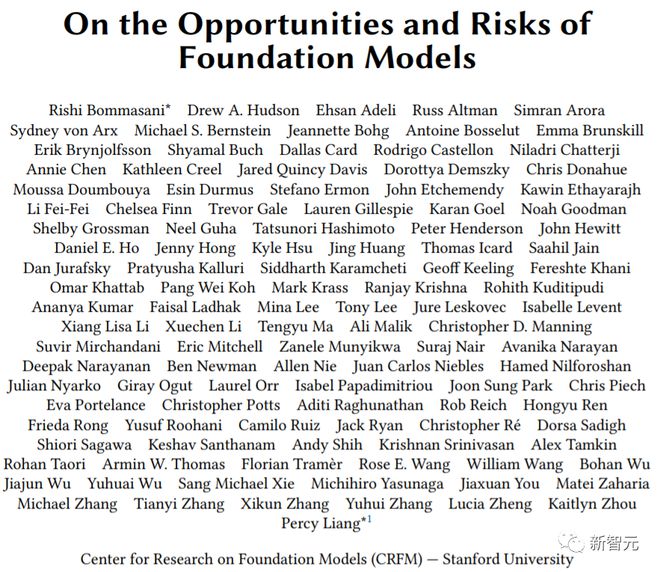

2021 年发布的一篇论文详细介绍了基础模型的机会和风险,这些新出现的能力会成为「科学界兴奋的来源」,也会导致「意料之外的后果」。

论文中还讨论了同质化问题。同样的几个模型被重复使用作为许多应用的基础,这样能使研究人员集中精力在一小部分模型上。但集中化也使这些模型成为单一的故障点,潜在的危害会影响到诸多下游应用。

对基础模型进行基准测试也是十分重要的,以便研究人员更好地了解其能力与缺陷,制定更合理的发展战略。

HELM(语言模型的整体评估)的开发就是为了这个目的。HELM 以准确性、稳健性、公平性等多种指标,对 30 多个著名的语言模型在一系列场景中的表现做出了评估。

新的模型、新的应用场景和新的评价指标还会出现,我们欢迎大家为 HELM 的发展添砖加瓦。

参考资料:

https://hai.stanford.edu/generative-ai-perspectives-stanford-hai