新智元报道

编辑:编辑部

2 月 20 日,复旦大学邱锡鹏团队推出中国版 ChatGPT「MOSS」。发布当晚,服务器被挤爆。2 月 21 日,复旦 MOSS 团队致歉,称模型还不成熟。

今天,MOSS 又火了。不仅登顶知乎热榜,收获近千万流量,还引来诸多媒体竞相报道。

不过,这次出圈的,不是陪刘培强流浪的 MOSS,而是复旦大学研发的中国版 ChatGPT。

国内首个对话式大型语言模型

ChatGPT 自发布以来,已经收获了全球巨大关注。尤其是在春节后,ChatGPT 突然走红,许多网友开始期待中国版聊天机器人的诞生。

现在,这个愿望得以实现。复旦大学自然语言处理实验室表示,国内第一个对话式大型语言模型「MOSS」已由邱锡鹏教授团队发布至公开平台,邀公众参与内测。

MOSS 可以执行一系列任务,如对话生成、编程、事实问答等。官网称,MOSS 为生成的语言模型打开所有技术路径,以理解人类意图并具有对话能力。

MOSS 的出现为国内学术界和业界提供了重要经验,并有助于进一步探索和应用大型语言模型。

团队负责人邱锡鹏表示:「尽管 MOSS 仍有很大的改进空间,但其推出证明,国内科研团队有能力在开发 ChatGPT 产品的道路上克服重要的技术挑战。」

据悉,MOSS 研发项目得到了上海人工智能实验室的大力支持。后期,该项目将会通过开源方式,和行业人士与社区分享。

开源代码,打造 MaaS 生态

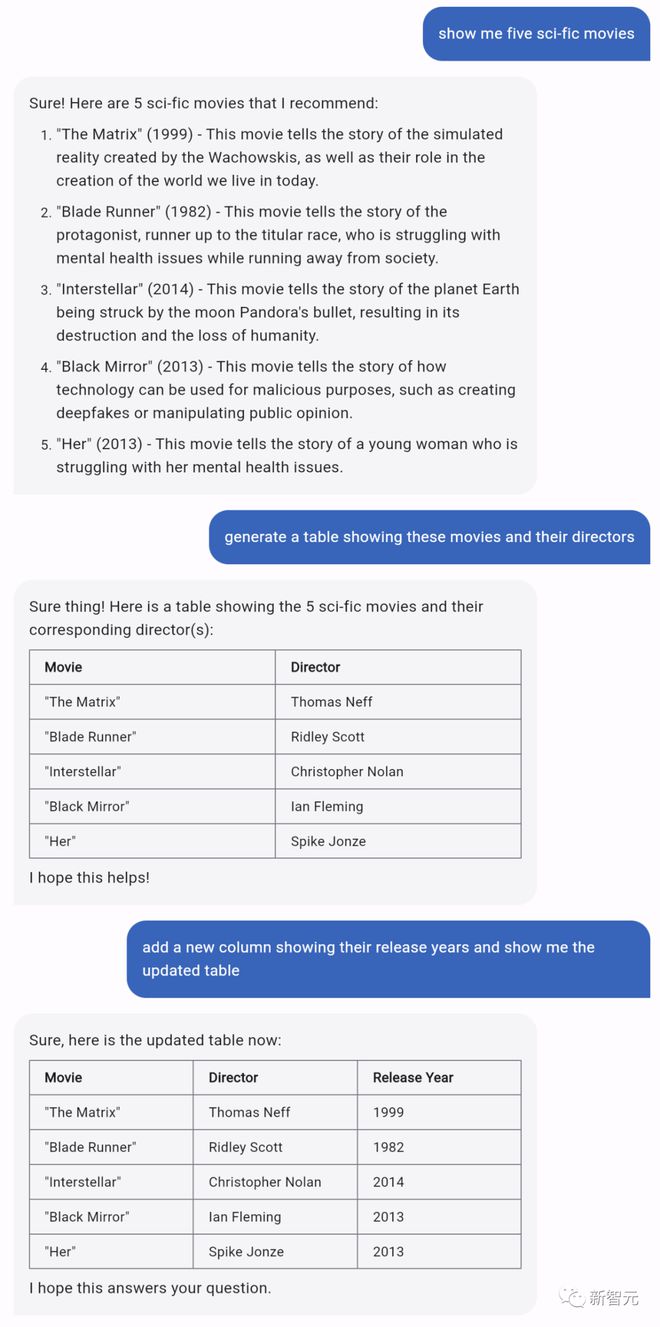

MOSS 的回答语言流畅、逻辑清晰且观点正确。科研团队在演示时,用英文输入多个指令,展示了 MOSS 多轮交互、表格生成、代码生成和解释能力。

「告诉我 5 部科幻电影。」「生成一张展示这 5 部电影和导演的表格。」「增加一列表格,显示这些电影上映的时间。」在这个包含表格生成的多轮交互中,MOSS 都顺利完成了任务。

然而,MOSS 与 ChatGPT 最大的不同,在于其开源属性。

由于 ChatGPT 并未开源,其技术解决方案的细节尚未披露,研究人员对此有很多猜测。一些专家认为,ChatGPT 是一个复杂的组合系统,无法通过单一的生成语言模型实现。

作为自然语言处理专家,邱锡鹏近年来一直致力于研究具有多任务学习能力的一般模型。为了探索 ChatGPT 的技术路线并获得 LLM 研究的一手经验,他带领团队加快了 MOSS 的开发。

MOSS 开发的基本步骤与 ChatGPT 相同,包括两个阶段:自然语言模型的基座训练和理解人类意图的对话能力训练。

在对话能力培训阶段,OpenAI 收集了至少数十万条人工指令,要求各行各业的专业标注员编写指令回复,然后将其输入模型库,以帮助 ChatGPT 逐步理解各种指令。

复旦团队采用不同的技术路线,通过允许 MOSS 与人类和其他对话模式互动,并在短时间内高效完成对话能力培训,从而显著提高学习效率和研发效率。

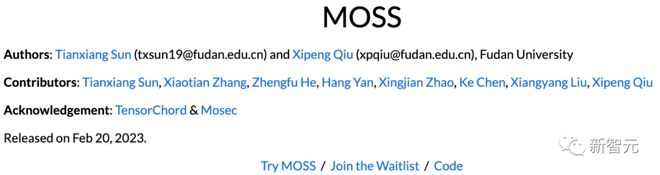

为了提高研发效率,MOSS 团队选择开源代码。对此,MOSS 模型的官方公告表示:

预训练大语言模型的研发门槛很高,需要大量算力、训练语料和人工标注。在我国产业界,只有大型机构才有实力开发大模型。 MOSS 开源后,可有效降低预训练语言模型的研发和应用门槛,让中小企业在其基础上开发出智能客服、智能家居、人工智能律师等各种垂直类产品。

推出伊始便开源代码,虽然可以提高数据收集和研发效率,但也不得不称为一个冒险的举动。然而,这也为未来企业的发展提供了一个新的思路:MaaS(基础模型服务)。

在未来,企业或许不需要在大模型领域「卷生卷死」,有了类似于 MOSS 的高质量 LLM,企业只需对已经完备的模型进行微调,就能获得所需的品质良好的垂类产品。

取名 MOSS,致敬《流浪地球》

随着 MOSS 的推出,互联网上出现了怀疑的声音:为什么要叫 MOSS?

面对「蹭热度」的质疑,MOSS 团队发公告予以澄清。公告称:尽管我们的对话模型和《流浪地球》中 MOSS 的能力不能相提并论,但就像过去 NLP 领域的其它优秀模型一样,作者们都希望使用自己喜欢的影视角色名称命名自己的模型,我们在训练完成第一代模型的时候,正值流浪地球 2 热映,片中 MOSS 给团队每个人都留下了深刻的印象,因此便使用了这样一个名称来指代我们的模型,以表示我们对最前沿 AI 模型的不懈追求。

事实上,用大 IP 给科研项目命名并不是什么新鲜事。ChatGPT 基础技术之一的 Transformer,其名称来源于大热电影《变形金刚》(Transformer)。

网友评价

MOSS 一上线,官网都快被挤爆了,小编也只能乖乖排队等内测资格啦。

体验地址:https://moss.fastnlp.top/

项目地址:https://txsun1997.github.io/blogs/moss.html

不过,根据网上记者的对话以及知乎答友们的评价,咱也能来仔细瞅瞅 MOSS 了。

文风很 AI,但未来可期

基于目前已知的信息,「段小草」对 Moss 的特点进行了总结:

1. 上下文的能力是有的,但不确定能保留多少,毕竟展示出来的上下文对话都不是太长;

2. 文风很 AI,不过生成的内容不算长。即使是分 1、2、3、4 点回答的时候,句子也比较短。ChatGPT 一般会生成更长的展开。

3. 文章中也专门展示了英文能力,但还不确定训练集中不同语言语料的效果。

4. 吸取 ChatGPT 和 NewBing 翻车的教训,在上线初期就套上了足够的道德枷锁。

最后,「段小草」表示:「希望能尽快体验到产品,也期待看到更多产业落地。」

MOSS 回答:

ChatGPT 回答:

回答地址:https://www.zhihu.com/question/585248111/answer/2903132579

给国内 AI 开了个好头

的确,MOSS 的发布对国内 AI 的发展肯定大有益处。

知友「极智视界」表示,在 AI 领域,技术源于美国而盛行于世界,例如框架类的 pytorch、tensorflow,目标检测算法 YOLO 以及造就 ChatGPT 的 transformer。我们「对标」国外的技术,虽然赶超美国可能做不到,但是「对标」的过程一定会让国内的 AI 有一个快速的发展。

回答地址:https://www.zhihu.com/question/585248111/answer/2903303710

「极智视界」还提到,国内首个类 ChatGPT 模型 MOSS 的发布既符合预期但也有些意外。

符合预期是因为近段时间以来也一直有国内版 ChatGPT 摩拳擦掌的消息,所以迟早都会来的;意外的是在当前这种强大的利益驱动下,研究机构居然还走到了大厂的前头。

但总的来说这是一个令业界比较振奋的消息,咱们终于可以用上咱们自己的 AI 问答系统了。

高校的重点还是理论探索

知友「卜寒兮」表示,想研发出类 ChatGPT 的产品,需要一个团队能撬动各个方面的资源,还要有过硬的技术做支撑。

以 ChatGPT 为例,单单想要研发出一个成规模的 LLM 模型,就需要以下四个方面:

-

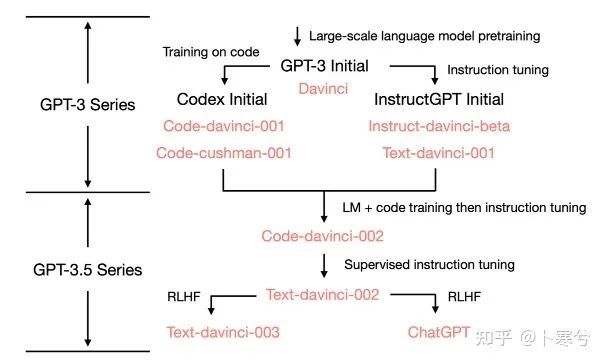

海量数据的语料库:ChatGPT 背后的模型的 GPT-3、GPT-3.5 系列,初代的 GPT-3 是 2020 年发布的,这个模型有 1750 亿个参数,训练它所使用的语料库包含 45TB 的数据、约 3000 亿个单词

-

大量的人力:毕竟 ChatGPT 成功的背后是时薪不到 2 美刀的血汗工厂

-

算力的支撑:训练 chatGPT 这样规模的 LLM 模型需要目前世界上最强大的 GPU 来满足算力要求而像 NVIDIA Tesla A100 这种最新的 AI 超级计算机芯片已经禁止对国内出售了。国内除了几家互联网大厂,很少有公司有实力能长期投入大量资金在算力上,更不要提校内的科研团队了,靠点科研经费可远远不够。

-

技术上的壁垒:GPT-3 的初代版本在 2020 年就出现了,而到 2022 年 11 月首次推出 ChatGPT 产品,这期间花了三四年的时间迭代不同的版本。这是一个长期的过程,意味着花大量的时间找到关键的训练 tricks,反复调参,在不同的训练集上反复训练、微调,并且还有找到合适的训练方法,才能迭代出一个优秀的版本

回答地址:https://www.zhihu.com/question/585248111/answer/2903161180

目前来看,还真的只有大公司才有能力做得出来。对于高校的科研团队,其优势在于技术和方法上的创新,所以还是要在这方面做更多功夫,为将来有一天该方向的发展做技术储备。

复旦 MOSS 团队:还不成熟

2 月 20 日,就在 MOSS 模型公布的当晚,不少测试的网友发现,MOSS 已经显示服务器流量过载,只能第二天再重试。

2 月 21 日,复旦团队在 MOSS 官网发布公告称:首先非常感谢大家的关注!MOSS 还是一个非常不成熟的模型,距离 ChatGPT 还有很长的路需要走。

我们一个学术研究的实验室无法做出和 ChatGPT 能力相近的模型,MOSS 只是想在百亿规模参数上探索和验证 ChatGPT 的技术路线,并且实现各种对话能力。 我们最初的想法只是想将 MOSS 进行内测,以便我们可以进一步优化,没有想到会引起这么大的关注,我们的计算资源不足以支持如此大的访问量,并且作为学术团队我们也没有相关的工程经验,给大家造成非常不好的体验和第一印象,在此向大家致以真诚的歉意。 在 MOSS 完成初步的验证之后,我们会将 MOSS 的经验、代码、模型参数开源出来供大家参考。中国版 ChatGPT 的诞生还需要中国全体 AI 从业者的努力,也更需要不断。和人交互以提高能力。

参考资料:

https://txsun1997.github.io/blogs/moss.html

https://www.zhihu.com/question/585248111

特别鸣谢:(授权转载)

「段小草」https://www.zhihu.com/question/585248111/answer/2903132579

「极智视界」https://www.zhihu.com/question/585248111/answer/2903303710

「卜寒兮」https://www.zhihu.com/question/585248111/answer/2903161180