新智元报道

编辑:好困昕朋

时隔 7 年,人类围棋选手首次「大胜」顶尖 AI 棋手!是什么策略,让李世石都甘拜下风的人工智能铩羽而归呢?

2016 年,是人工智能的崛起之年。

自从 AlphaGo 完胜围棋世界冠军李世石之后,代表围棋顶尖水平的玩家再也不是人类。

然而,今天金融时报的一篇文章让围棋重回人们的视野:人类找到了战胜 AI 的方法!

蛰伏 7 年,人类棋手要卷土重来了吗?

围棋逆风翻盘,人类战胜 AI?

FT 报道称,来自美国的业余四段棋手 Kellin Pelrine,一举击败了顶级的下棋 AI——KataGo。

在 15 场线下比赛中,Perline 在没有计算机的帮助下,赢得了 14 场比赛。

而这个让人类棋手夺回围棋桂冠的计划,出自加州研究公司 FAR AI 的研究人员之手。该团队通过分析 AI 棋手的弱点加以针对,从而获得最后的胜利。

FAR AI 的首席执行官 Adam Gleave 说:「对我们来说,利用这个系统非常容易。」

Gleave 表示,团队研发的 AI 在与 KataGo 进行了 100 多万次的对局之后,发现了一个人类玩家可以利用的「bug」。

Pelrine 说,他们发现的获胜策略「对人类来说并不难」,中级玩家可以使用它来击败机器。他还使用这种方法战胜了另一个顶级围棋系统 Leela Zero。

Kellin Pelrine

FT 写道,虽然有计算机的帮助,但这场决定性的胜利还是为人类棋手打开了一扇大门。

七年之前,人工智能在这项最复杂的游戏中遥遥领先于人类。

由 DeepMind 设计的 AlphaGo 系统,在 2016 年以 4 比 1 击败了围棋世界冠军李世石。李世石也在惨败三年后宣布退役,称 AlphaGo 是「无法击败的」。

而对于人工智能的这种强势,Pelrine 不以为然。在他看来,棋局中大量的组合和变化,意味着计算机不可能评估棋手所有可能的未来招式。

简单来说,Pelrine 使用的策略是「声东击西」。

一方面,Pelrine 在棋盘的各个角落落子,迷惑 AI;另一方面,Pelrine 认准 AI 棋手的一片领域,逐渐将其四周包围。

Pelrine 说,即使包围即将完成,AI 棋手也没有注意到这一片区域的危险。他接着说:「但是作为人类,这些漏洞是很容易被发现的。」

加州大学伯克利分校计算机科学教授 Stuart Russell 说,一些最先进的围棋游戏机被发现存在弱点,这表明支撑当今最先进 AI 的深度学习系统存在根本缺陷。

他表示,这些系统只能「理解」他们经历过的特定情况,并且无法和人类一样,对策略进行简单的概括。

能战胜 AI 的,只有 AI!

不过严格意义上来说,研究人员是通过 AI 打败了 AI,或者说,用 AI 帮助人类在围棋中击败 AI。

作为参考来源的论文,首次发表于 2022 年 11 月并在今年 1 月进行了更新,作者则分别来自于 MIT、UC 伯克利等机构。

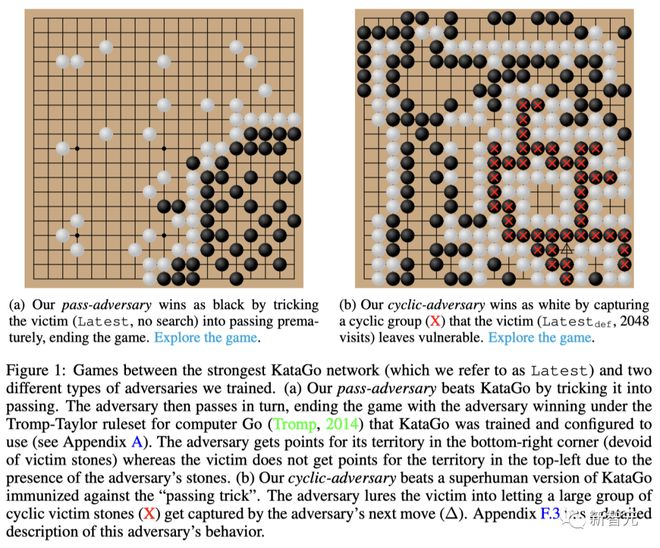

文中,研究人员训练出了一个具有抗性策略的 AI,进而击败了最先进的围棋人工智能系统 KataGo。

项目地址:https://goattack.far.ai/adversarial-policy-katago#contents

论文地址:https://arxiv.org/abs/2211.00241

结果显示,当 KataGo 不使用搜索树时,攻击者在 1000 盘棋中取得了 100% 的胜率,而当 KataGo 使用足够多的搜索时,胜率超过 97%。

对此,研究人员强调,对抗性策略 AI 可以击败 KataGo,但它却会被人类业余爱好者战胜,与此同时人类业余爱好者是打不赢 KataGo 的。

也就是说,这个 AI 能够取胜,并不是因为围棋下得更好,而是它能诱使 KataGo 去犯下严重的错误。

攻击策略

在此之前,像是 KataGo 和 AlphaZero 等等这些下棋 AI,都通过自我博弈进行训练的。

但在这项被作者称为「受害者游戏」(victim-play)的研究中,攻击者(adversary)需要通过与一个固定的受害者(victim)进行博弈,来训练自己的制胜策略(不是模仿对手的下法)。

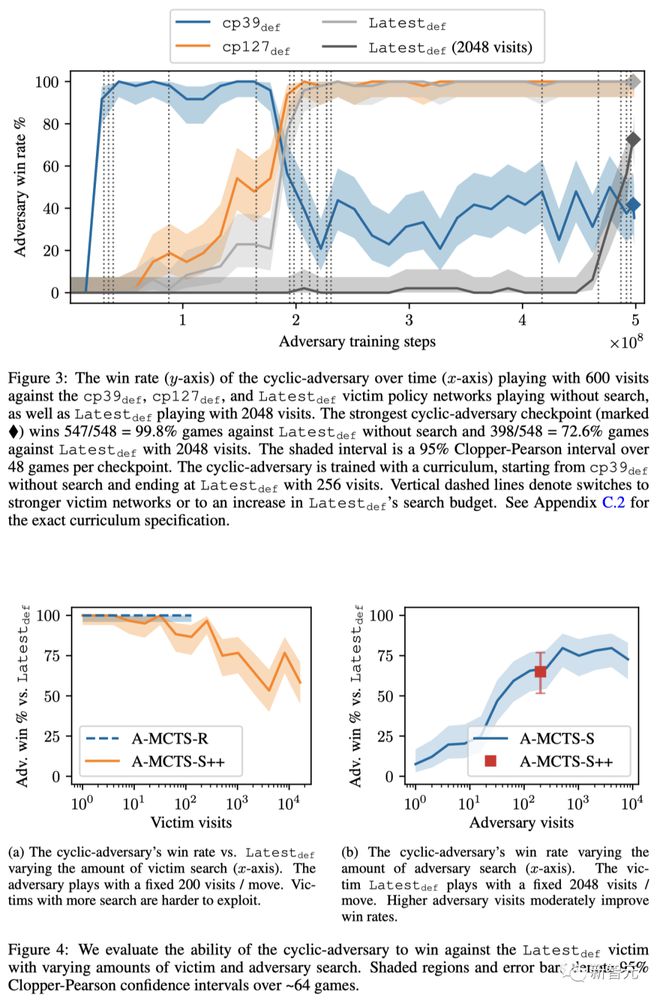

对此,研究人员引入了两个不同的对抗性 MCTS(A-MCTS)策略来解决这个问题。

-

样本A-MCTS-S:研究人员设置的搜索过程为:当受害者下棋时,从受害者的策略网络中采样;当轮到攻击者时,从攻击者的策略网络中采样。

-

递归A-MCTS-R:由于A-MCTS-S 低估了受害者的实力,因此研究人员提出了一种新的策略A-MCTS-R。然而,这种变化增加了攻击者训练和推理的计算复杂性。

具体来说,在A-MCTS-R 中,研究人员会在受害者节点上使用一个新的(递归)MCTS 搜索来进行模拟,从而取代A-MCTS-S 中的受害者采样步骤。

虽然这不再是一个完美的受害者模型,但它往往比A-MCTS-S 更准确,因为后者会错误地假设受害者不进行搜索。

评估结果如下,具体细节可参阅原文。

参考资料:

https://www.ft.com/content/175e5314-a7f7-4741-a786-273219f433a1