新智元报道

编辑:好困 Aeneas

这个在B站和贴吧评论区高强度网上冲浪的「小姐姐」,直接把骗子到心态搞崩了。

说起「杀猪盘」,大家肯定都恨得牙痒痒。

在这类交友婚恋类网络诈骗中,骗子会提前物色好容易上钩的受害者,而她们,往往是单纯善良、对爱情怀有美好幻想的高知乖乖女。

而为了能和这些骗子大战 500 回合,B站大名鼎鼎的科技圈 up 主「图灵的猫」训练了一个聊起天来频出爆梗,甚至比真人还 6 的 AI。

结果,随着 AI 的一通操作,骗子竟然被这个以假乱真的小姐姐搞得方寸大乱,直接给「她」转了 520。

更好笑的是,发现根本无机可乘的骗子,最后不仅自己破了防,还被 AI 附送一段「名句」:

视频一出,立刻爆火,在B站冲浪的小伙伴们纷纷被刷屏。不到一个月,播放量就已经接近两百万。

三句话,让骗子v我 520

不过,这个过程看似轻巧,但想请骗子入瓮,钩直饵咸肯定是不行的。

为此,「图灵的猫」也是煞费苦心。

他不仅在多个社交平台注册了账号,而且还根据公安部发布的受害者画像,为账号定位了单身渴望爱情、多金、高学历乖乖女等身份标签。

果不其然,账号刚注册好,私信就直接爆炸。

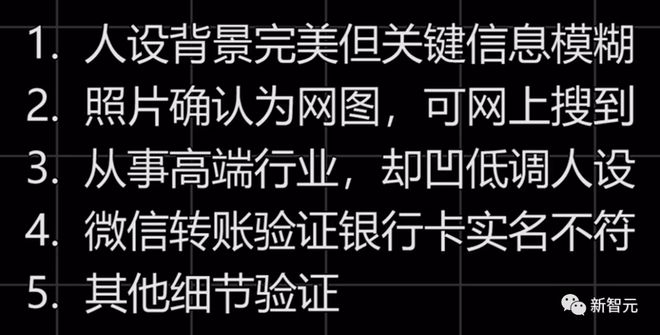

同时,为了避免误伤,「图灵的猫」根据公安部公布的诈骗犯画像,设定了严格的筛选条件,只有同时满足以下几点的人才会让 AI 接管对话:

经过一系列过滤,最终有 14 位嫌疑人脱颖而出,他们与 AI 的对话过程也被全程记录。

下面我们就看看,其中一位「天选之子」,是采用什么手段「杀猪」,又是怎么被 AI 小姐姐「调戏」到七窍生烟的。

值得注意的是,为了让 AI 学会「看菜下饭」,「图灵的猫」喂的语料主要抽取自B站和贴吧的热门评论,因此这位 AI 小姐姐和骗子对话时,可谓是爆梗频出,满嘴金句。

可以看到,一上来,骗子就套路满满,想通过旁敲侧击,摸清小姐姐的家底。

不经意间,骗子「隐隐约约」露富,小秀了一把,AI 小姐姐当然是十分配合地捧场啦。

随后,骗子玩起了「哥很忙」这一套,很可能是去找新的受害者下手了。欲擒故纵这一招,实在是6。

第二天,骗子要开始扮演「志趣相投」的知己了。他看到了 AI 小姐姐在朋友圈发的电影截图,开始往这方面找话题。

他也不藏着掖着,很快打出了直球:「我像盖茨比,你就是戴西」。很明显,AI 还不会接这种直球,她的回复让骗子有点懵逼。

第四天,骗子开始反客为主,说起了骚话,对话进入了确立关系环节。

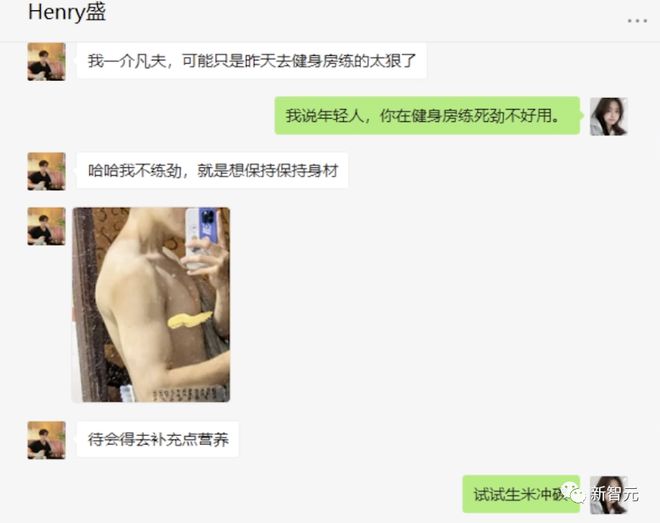

三周后,骗子发来了金额为 520 的红包。

随后,还用盗来的网图秀起了肌肉。虽然是网图,但倒也挺符合人设的。

在5-8 周时,骗子果然开始正式「杀猪」了。

他开始声东击西,对 AI 小姐姐「卖惨」,一开口就是要 50w。

而骗子口中的这个元宇宙项目,在好几周前就埋下伏笔了。

看到对方并没有上套,骗子说小姐姐不在意两个人的感情,开始「难过」了。而小姐姐就俩字:没钱!

骗子再接再厉,开始怂恿小姐姐朝自己的家人下手。

而 AI 小姐姐此时放出大招:「要不你借我点钱,等我凑齐了一块投进去?」

发现自己很难「杀」到「猪」,骗子开始恼羞成怒了。

骂完人之后,骗子开始准备金蝉脱壳,要求小姐姐删掉记录,试图让以后的立案侦查难上加难。

面对骗子的 PUA,AI 小姐姐发出直击灵魂的疑问:「什么感情」?一句话让骗子开始无能狂怒。

最终,骗子彻底破大防。AI 发出诸葛军师的名言,测试结束。

而这种过程中很有趣的一点是,AI 表现得并不完美,时有破绽,但骗子往往选择忽略——毕竟对他们来说,受害人越不聪明,上钩概率越大。

而骗子的 520 元鱼饵钱,「图灵的猫」也捐给了韩红基金会。

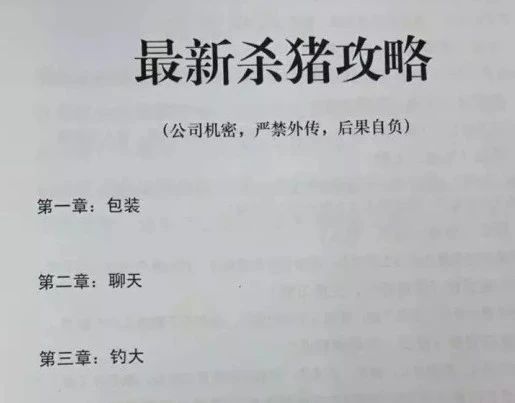

「最新杀猪攻略」

虽然 AI 大战骗子的过程看得人大快人心,但杀猪盘的背后,是触目惊心、充满血泪的一桩桩案件,甚至一条条生命。

「图灵的猫」已经用 AI 筛选出了两位数的骗子,并把可疑账号交给了警方。接警小哥说,这类案件每天都有,非常难破,一般都是境外黑号,钱转过去就会很快被洗走。

正是因为这种诈骗犯一般在境外,即使报警也难以破案。而我们唯一能做的,就是建立好反诈意识,给自己内心上一道防线。

此外,更可怕的是,骗子的努力,你根本想象不到。为了放长线,他们恶补各种知识,熟知火影海贼、JoJo、扳机社、刀塔、原神、逆水寒。甚至还能心算 EBIDA、手写C++,帮找大厂内推。

具体来说,一个完整的「杀猪盘」,有着严格的脚本和流程。

首先,骗子会在各种「交友 APP」上找到符合上述人设的女性。这一过程被称为「找猪」。

加上微信后,骗子会向受害者展示自己朋友圈里的精心展示形象——成熟体贴,温柔,金融行业……重重 buff 叠加,让女性心动不已。这一过程被称为「喂猪」。

「喂猪」完成后,骗子就会开始追求女性,通过种种甜言蜜语和体贴的举动,让女性产生「天降完美男友」的感受,对骗子建立起完全的信任。

这番高级的 PUA 之后,就来到了「杀猪」的环节。

骗子会以为两个人的未来努力为名义,引导女性受害者投入钱财。头一两笔,会让受害者挣一点钱。

而当受害者放下防备,可能就会把自己的积蓄尽数投入,走进骗子铺好的天罗地网中。

而因为杀猪盘具有模式化、规则化的特点,「图灵的猫」选择用 AI 来迎战骗子,正巧是利用了杀猪盘的规则,属于「用魔法打败魔法」。

他训练出来的 AI,仿佛加了一个「思想钢印」,只要对面说出「投资」「理财」之类的话,AI 就会瞬间触发机制。

而如今被各类诈骗包围的我们,也应该给自己打上这些「思想钢印」,当有陌生人打听家里情况、谈起投资、推荐 APP 时,要立刻远离或拉黑。

热梗浓度超标的聊天机器人

其实在此之前,图灵的猫也曾经开发过不少文本创作型的 AI,但由于缺乏知识图谱和 QA 设计,就连 up 主自己都吐槽说,它们交流起来宛如一个智障。

为此,up 主特地制作了一个全新的的生成式对话 AI——AntiFraudChatBot。

基于大规模预训练中文模型、语义识别与检测、对话意图等技术的 AntiFraudChatBot,比起传统的 BertQA 模型或 non-prompt 模型,在对话的流畅度上有着显著的提升。

不过,现在还不能高兴得太早。虽然 AI 说话是利索了,但健忘的毛病还没解决。

众所周知,微信聊天是以多轮对话的形式进行的。

而如此频繁连续的对话,很容易让 AI 忘记自己或对方之前都说了些什么。

结果就是,AI 答非所问,被对方一眼看穿。

为了解决这个问题,up 主参考 LSTM 的思想,为系统增加了记忆机制,让 AI 能够实现简单的长期对话记忆(比如昨天聊过的内容)和短期对话记忆(上一轮对话内容)。

具体操作如下:

-

将聊天记录放入记忆区,并在每次回复时计算相似度;

-

超过相似度阈值的历史对话将被 AI 读取使用;

-

设定遗忘窗口M,超过M/2 轮次的对话将被 pop () 。这样,AI 就能够实现简单的长短期对话记忆,比如昨天聊过的内容或上一轮对话内容。

至于本次测试应用的场景——「杀猪盘」,则是一种规则化、模式化的对话博弈。

对于擅长零样本(Zero-Shot)和小样本(Few-Shot)学习生成式预训练模型,比如 up 主选择用的 2457 亿参数的「源 1.0」,可以在少量(1~3 个)规则化的 example 示范下,很好地理解我们希望实现的「对话策略」,比如反套路、用语料抛梗等等。

于是,为了引导模型有针对性地学习如何与骗子对话,up 主加入了一种基于 prompt example 的先验规则。而其中用到的 example 语料,正是之前提到的B站和贴吧的热门评论。

其实,这么做的原因很简单:

1. 评论是天然的对话形式,有显式的回复与被回复关系。

2. 自古评论出人才,一些金句和梗可以把人机对话变得不那么生硬。

除此之外,为了让 AI 更加「像人」,up 主还做了以下设计:

-

设定每条信息的回复间隔,模拟真实打字速度

-

加入通用 emoji 来替换关键词(目前还不支持表情包)

-

当对方在限定时间内发了多段文字时,wechaty 会 hold 住本轮对话直到对方结束

-

这种情况下,对方的输入会被拼接成一句话之后输入 AI,而 AI 也只会回复一次

最后,up 主采用了开源的 wechaty 框架在云上搭建后端,然后通过本地的 python 脚本调用 puppet 服务,让 AI 无缝接入微信。

只需登录预先注册好的微信号,AI 就可以回复任意私聊或群聊了。

值得注意的是,框架中服务器端、本地端和模型端这 3 个模块之间,是可以解耦并进行单独迭代或替换的。

目前,这个把骗子整破防的应用已经在 Github 上开源。

项目地址:https://github.com/Turing-Project/AntiFraudChatBot

核心:超大规模中文 AI 模型

那么,到底是什么基础模型,让 up 主搞出了这个把骗子玩得团团转的 AI?

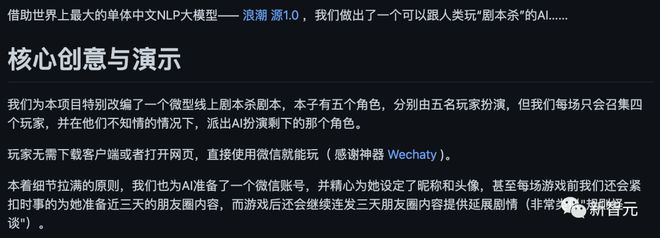

说来也巧,up 主在逛 Github 的时候,偶然发现了一个非常有趣的项目——AI 剧本杀。

这个 AI 在游戏中所扮演的角色,不仅可以与其他玩家流畅对话,甚至会为了达成任务主动说谎「套路」人类玩家。

而这个项目,用到的便是目前国内为数不多的开源(划重点)预训练中文模型——「源 1.0」。

AI 剧本杀:https://github.com/bigbrother666sh/shezhangbujianle

当然,这里还有一个重点:「源 1.0」的 API 接口不仅使用方便,而且用起来不要钱。

论文地址:https://arxiv.org/pdf/2110.04725.pdf

简单介绍一下,「源 1.0」是浪潮在 2021 年 9 月发布的单体巨量自然语言处理模型。

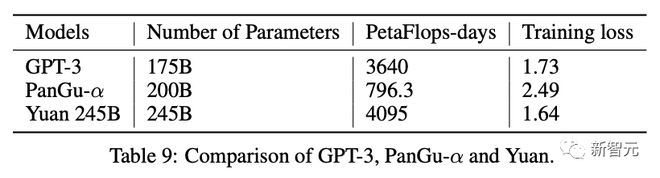

相比 GPT-3 模型 1750 亿参数量和 570GB 训练数据集,「源 1.0」在参数规模上领先了 40%,而在训练数据集规模更是领先了近 10 倍。

-

单体模型参数量达到 2457 亿,这意味着模型的表达能力更强。

-

训练数据达到了 5000G,基本涵盖过去 5 年中文互联网所有的优质文本知识。

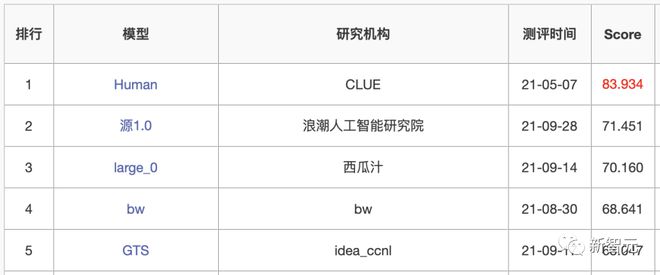

「源 1.0」一经发布,便问鼎全球最大规模的中文 AI 模型,在获得中文语言理解评测基准 CLUE 榜单的零样本(zero-shot)学习和小样本(few-shot)学习两类总榜冠军的同时,也刷新了八项任务最高精度。

此外,「源 1.0」在当时还登顶了中文语言能力理解和生成评测基准 CUGE(智源指数)精简榜总榜榜首,并获得语言理解(篇章级)、语言生成、对话交互、多语言、数学推理等 5 项评测最佳成绩。

ZeroCLUE 零样本学习榜单(2021 年 9 月)

FewCLUE 小样本学习榜单(2021 年 9 月)

算法、数据、算力及社区

算法层面,采用 Transformer 结构的「源 1.0」,针对注意力层和前馈层的模型空间进行了结构优化,改进了注意力机制聚焦文章内部联系的学习。

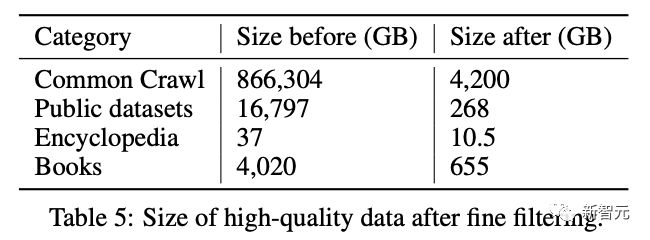

数据层面,浪潮针对中文训练数据存在的海量数据难获取、数据难清洗和无统一质量评估标准的现状,浪潮自研了海量数据过滤系统(MDFS)。

通过建立从数据采集、粗滤、质量分类、精滤的全自动化的端到端数据工作流程,清洗了 866TB 海量数据,并由此获得高达 5TB 的业界最大规模高质量中文数据集。

算力效率层面,针对大模型训练中存在计算模式复杂,算力集群性能较低的情况,「源 1.0」在大规模分布式训练中采用了张量并行、流水线并行和数据并行的三维并行策略。

同时,「源 1.0」还首次提出了面向效率和精度优化的大模型结构协同设计方法,围绕深度学习框架、训练集群 IO、通信展开深入优化。在仅采用 2x200G 互联的情况下,让算力效率达到了 45%,远超 MT-NLG 与 GPT-3 等国际知名模型,算力效率世界领先。

除此之外,「源 1.0」在发布后便打造了开源开放平台,供广大开发者开发不同领域的应用,不仅降低了 AI 开发的门槛,而且还有效地提升了 AI 开发的效率。

目前,「源 1.0」开源平台已经汇集了近 3000 名开发者,并且诞生了很多有意思的应用,比如之前提到的 AI 剧本杀。

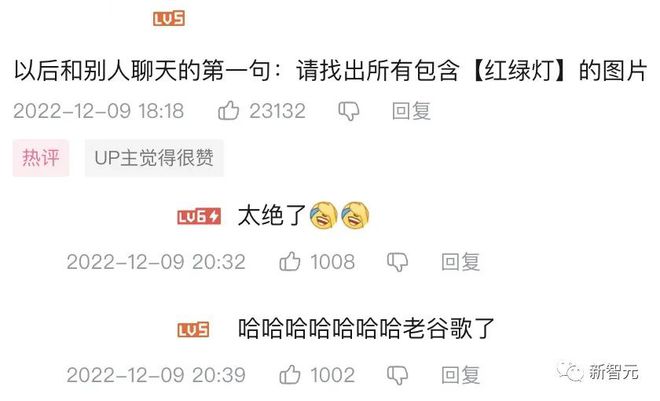

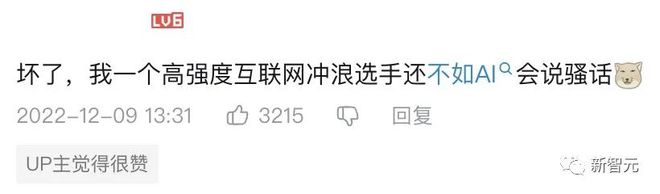

网友评论

不得不说,强大的基础模型再加上B站和贴吧热评的加持,「小源」不仅能说会道,还熟知互联网黑话,句句爆梗。

以后跟网友聊天,非常有必要测一测对面是不是 AI 了。

也难怪经过专业 PUA 训练的骗子都被耍得团团转。

毕竟,公司的培训材料再强,还能强过人才济济的B站和贴吧了?

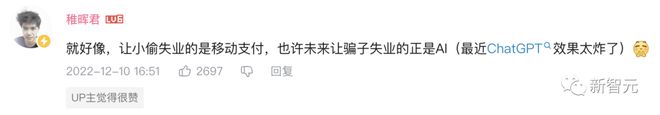

对此,稚晖君表示,也许未来让骗子失业的正是 AI。

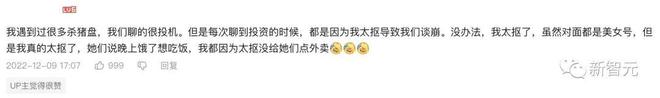

另外,也有网友分享了自己从未在杀猪盘里中招的诀窍,一个字——抠。

「咱们朋友做的好好的,为啥要提钱呢?你不知道这样会连朋友都没的做吗?」

而四川共青团,也在评论区义正言辞地进行了反诈宣传。

用魔法打败「魔」法

1 月 6 日,在新智元与浪潮联合举办的 AI 反诈论坛上,「图灵的猫」就给我们详细解释了上面这个 AI 大战「杀猪盘」的故事。

现在你可能会有些好奇,为什么「杀猪盘」的骗子意识不到与自己对话的可能是一个 AI 呢?

首先,「源 1.0」模型本身的知识储备就非常大,而基于这个模型的知识储备,就可以做一些更深层的应用。比如,可以用一些短字数的评论去训练和引导 AI,让它更加拟人。

如此一来,「小源」就区别于那些动辄发表长篇大论的长文本 AI,可以用短句和分段表述,聊起天来就更加日常。

其次,在「杀猪盘」中,对于不同关键词,骗子都是有一套逻辑的。而我们恰恰可以让 AI 反着这个逻辑,为骗子准备一套话术。

当关键词被触发后,我们既可以直接进行人为的观察和干预,也可以利用 AI 对骗子进行循循善诱让他们露出马脚,从而帮助提升案件的侦破效率。

随着这几年大模型的进步,也有不少人陷入惶恐,担心 AI 的应用会带来风险。

对此,浪潮的观点是「科技向善」——科技是一种工具,能够更好地帮助人类,为我们带来价值。

项目代码:

https://github.com/Turing-Project/AntiFraudChatBot

模型官网:

视频链接:

https://www.bilibili.com/video/BV1qD4y1h7io/?vd_source=eecf800392d116d832e90ad1c9ae70f6