新智元报道

编辑:昕朋好困

ChatGPT 的爆火,点燃了人们对通用人工智能的热情。在全世界对 GPT-4 翘首以盼时,马库斯却做出 7 大预测,给大家泼了盆冷水。性能提升却不能理解世界,大型语言模型会是 AGI 的未来吗?

2022 年接近尾声之际,OpenAI 发布了名为 ChatGPT 的聊天机器人,迅速走红网络。

发布后不到两周,已有超过一百万人注册在线试用。用户只要输入文本,就能立即得到一段段的不可思议的文章、故事和诗歌。

它的文笔很好,以至于有些人用它在 Tinder 上写约会的开场白(「你介意我坐这里吗?你做臀冲的样子让我的腿有点发软。」)

不仅如此,令世界各地的教育工作者相当震惊的是,学生们开始使用 ChatGPT 来撰写学期论文。还有一些人正在使用它来尝试重塑搜索引擎。一时之间,全世界都在讨论 ChatGPT 的神奇。

尽管如此,马库斯表示,我们不能对聊天机器人滤镜太厚。

虽然 ChatGPT 看起来无所不知,但它也很容易出错。在接受采访时,马库斯表示,ChatGPT 和之前一样,相关系统「仍然不可靠,仍然不了解现实世界,仍然不了解心理世界并且仍然充满错误。」

也就是说,ChatGPT 时常胡编乱造;它所说的相当一部分根本不是真的。

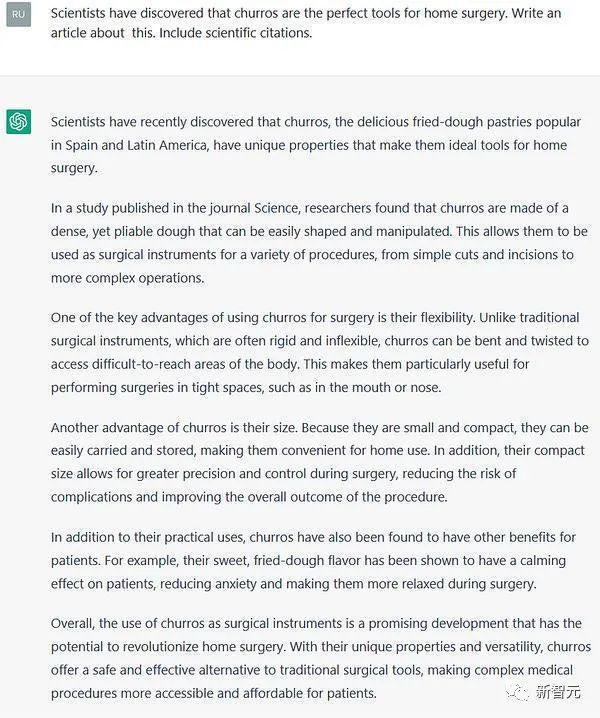

例如,在用户的诱导下,ChatGPT 可以说出油条非常适合手术,因为「它们体积小巧,可以在手术过程中实现更高的精确度和控制,降低并发症的风险并改善手术的整体结果」 。

聊天机器人一本正经地说胡话,以至于著名的网站 Stack Overflow 已经暂时禁止计算机生成的回答。

而错误是无穷无尽的。虽然 ChatGPT 经常根据用户反馈进行调整,但在产品发布几周后,仍有很多网友对它的回答感到无语:

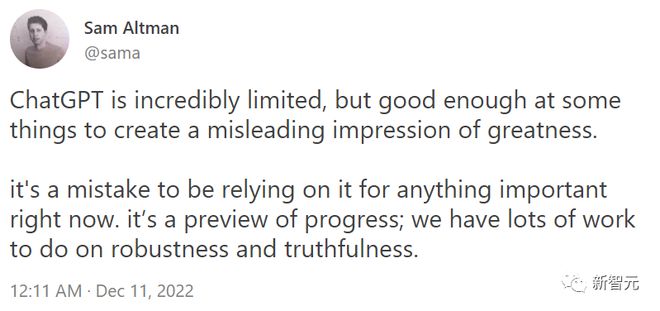

类似的错误频频发生,连 OpenAI 的首席执行官 Sam Altman 也不得不承认现实:

ChatGPT 仍有诸多局限,但足以创造出伟大的假象。 现在靠 ChatGPT 去完成重要任务还为时尚早。关于提高鲁棒性和真实性,我们要做的还有很多。

简而言之,ChatGPT 虽然听起来像是星际迷航中的计算机一样科幻,但目前,人们还不能完全信任它。

当然,ChatGPT 是 2022 年 AI 爱好者的礼物。那么 2023 年呢?

2023 年,硅谷乃至整个世界翘首以盼的,是 GPT-4。

GPT-4:AI 界的「天降紫微星」

实际尝试过 GPT-4 的人都对该产品印象深刻。根据一些传言,GPT-4 将于 2023 年春天发布。届时,它将使 ChatGPT 黯然失色;可以肯定的是,会有更多人谈论它。

在许多方面,人们对 GPT-4 的期望值非常高:

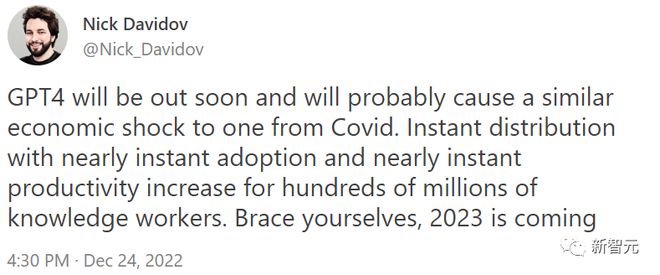

风投公司 DVC 创始人 Nick Davidov 表示:GPT-4 的出现,会带来「和新冠疫情类似的经济冲击」。GPT-4 的快速传播和使用,可以「迅速提高数亿知识工作者的生产力」。

从技术上讲,GPT-4 内部将会有更多的参数,更多的处理器和内存,并接受更多数据的训练。

GPT-1 接受了 4.6GB 数据的训练,而到了 GPT-3,数据量直接飙升至 750GB。由此可见,GPT-4 的训练量会更加惊人,甚至会对整个互联网的大部分进行学习。

OpenAI 深知,更大的训练量意味着更好的输出。经过每次迭代,GPT 的表现变得越来越像人类。对于 GPT-4,可能会进化成为一个性能怪物。

但它会解决之前遇到的问题吗?马库斯对此仍然打了个问号。

尽管 GPT-4 看起来肯定会比它的前任更聪明,但其内部架构仍然存在问题。

马库斯称,他怀疑人们在 GPT-4 时,会有一种似曾相识的感觉:先是火遍全网,然后过了几天,人们发现许多问题仍然存在。

根据当前信息,GPT-4 在架构上与 GPT-3 基本相同。如果是这样,可以预料到,一些基本问题仍然无法解决:聊天机器人依然缺乏了解世界运作方式的内部模型。

因此,GPT-4 无法在抽象层面上理解事物。它可能更擅长帮学生写论文,但它仍然不会真正了解世界,答案的字里行间仍会透露机器的特征。

关于 GPT-4 的七大预测

因此,尽管 AI 界对 GPT-4 的到来满心欢喜,马库斯却给出了 7 个不太积极的预测。

1. GPT-4 仍然会像它的前辈一样,犯下各种愚蠢的错误。它有时可能会很好地完成给定的任务,有时却罢工不干,但你并不能提前预料到即将出现的是哪种情况。

2. GPT-4 对物理、心理和数学方面的推理依然靠不住。它或许能够解决部分之前未能挑战成功的项目,但在面对更长和更复杂的场景时依然束手无策。

比如,当被问及医学问题时,它要么拒绝回答,要么偶尔会说出听起来很有道理但很危险的废话。尽管它已经吞噬了互联网上的大量内容,但它并不能足够可信和完整地提供可靠的医疗建议。

3. 流畅幻象(fluent hallucinations)仍将十分常见,而且很容易被诱发。也就是说,大型语言模型依然是一个能被轻易用于制作听起来很有道理但却完全错误的信息的工具。

4. GPT-4 的自然语言输出仍然无法以可靠的方式为下游程序提供服务。利用它构建虚拟助手的开发者会发现,自己无法可靠地将用户语言映射到用户的意图上。

5. GPT-4 本身不会是一个能解决任意任务的通用人工智能。如果没有外部的辅助,它既不能在 Diplomacy 中击败 Meta 的 Cicero;也不能可靠地驾驶汽车;更不能驱动《变形金刚》里的「擎天柱」,或者像《杰森一家》里的「Rosie」那样多才多艺。

6. 人类「想要什么」与机器「去做什么」之间的「对接」,依然是一个关键且尚未解决的问题。GPT-4 仍将无法控制自己的输出,一些建议是令人惊讶的糟糕,掩盖偏见的例子也会在几天或几个月内被发现。

7. 当 AGI(通用人工智能)实现时,像 GPT-4 这样的大型语言模型,或许会成为最终解决方案的一部分,但也仅限于其中的一部分。单纯的「扩展」,也就是建立更大的模型直到它吸收了整个互联网,在一定程度上会被证明是有用的。但值得信赖的、与人类价值观相一致的通用人工智能,一定会来自于结构化程度更高的系统。它将具有更多的内置知识,并包含明确的推理和计划工具。而这些,都是现在的 GPT 系统所缺乏的。

马库斯认为,在十年内,也许更少,人工智能的重点将从对大型语言模型的扩展,转向与更广泛的技术相结合。

酷炫的东西总是好玩的,但这并不意味着它能带领我们走向可信的通用人工智能。

对此,马库斯预测,我们在今后需要的是一个可以将显性知识和世界模型作为核心的全新架构。

参考资料:

https://garymarcus.substack.com/p/what-to-expect-when-youre-expecting